Die Welt des maschinellen Lernens hat in den letzten Jahren durch zahlreiche innovative Methoden einen erheblichen Fortschritt erlebt. Unter diesen ragt besonders der Bereich der probabilistischen Diffusionsmodelle hervor, die zunehmend als vielversprechende Technik zur Modellierung komplexer Datenverteilungen gelten. Tiny-Diffusion ist eine minimalistische Implementierung dieser Modelle für 2D-Datensätze, die mit ihrem schlanken Aufbau und zugänglichen Design neue Wege für Forschung und praktische Anwendungen öffnet. Probabilistische Diffusionsmodelle gehören zu den aufstrebenden Ansätzen, um Verteilungen von Daten durch schrittweise Rauschanreicherung und anschließende Rekonstruktion zu modellieren. Inspiriert von physikalischen Diffusionsprozessen, imitieren diese Modelle das Hinzufügen eines Rauschfaktors in mehreren kleinen Schritten – den sogenannten Forward Process – um eine Ausgangsverteilung sukzessive in eine definierte Rauschquelle umzuwandeln.

Die wahre Magie liegt im Reverse Process, welcher versucht, den Ursprung aus dem verrauschten Zustand wiederherzustellen und damit neue Datenpunkte nach dem zugrunde liegenden Muster zu generieren. Tiny-Diffusion bietet eine außergewöhnlich kompakte und leicht verständliche Implementierung solcher Diffusionsmodelle speziell für 2D-Datensätze. Der Fokus liegt auf einer klaren Struktur, die es Forschern, Entwicklern und Lehrenden ermöglicht, die Kernmechanismen probabilistischer Diffusion ohne unnötige Komplexität zu verstehen und zu nutzen. Dabei wurde PyTorch als Framework gewählt, was den Einstieg durch breite Verfügbarkeit und hohe Flexibilität erleichtert. Das Projekt beinhaltet eine zentrale Datei namens ddpm.

py, die die gesamte Trainingspipeline vom Einlesen der Trainingsdaten bis zur Modelloptimierung abdeckt. Ein wichtiger Bestandteil ist der Forward Process, in welchem Datenpunkte durch einen zeitlich abgestuften Rauschprozess schrittweise verändert werden. Dies wird durch eine definierte Anzahl von Zeitschritten geregelt, wobei der Grad des hinzugefügten Rauschens in jeder Phase variiert. Ziel ist es, die Datenverteilung so zu transformieren, dass sich am Ende ein einfaches Rauschmuster ergibt. Der Reverse Process nutzt ein neuronales Netzwerk, um aus dem verrauschten Input schrittweise die ursprüngliche Datenverteilung zu rekonstruieren.

Durch diesen Lernprozess kann das Modell neue Daten generieren, welche der Trainingsverteilung ähneln, wobei das Netzwerk die Muster und Strukturen der 2D-Punkte erfasst. Für das Training ist die Wahl geeigneter Hyperparameter entscheidend, da diese maßgeblich die Lernrate, Modellgröße oder auch die Anzahl der Zeitschritte im Diffusionsprozess beeinflussen. Tiny-Diffusion bietet darüber hinaus verschiedene Experimente und Abfragen, mittels derer die Auswirkungen verschiedener Parameterstudien nachvollziehbar gemacht werden. Beispielsweise zeigt die Analyse der Lernrate, wie sensibel das Modell gegenüber diesem Parameter reagiert. Ein zu niedriger oder zu hoher Wert führt schnell zu suboptimalem oder inkonsistentem Output, während ein gut abgestimmter Wert einen stabilen Lernprozess mit klaren Datenrekonstruktionen ermöglicht.

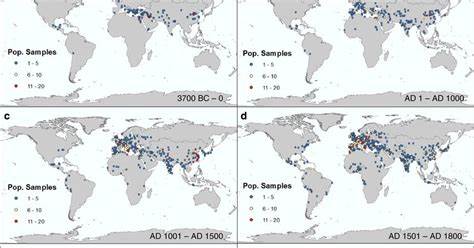

Ebenso beeinflusst die Länge des Diffusionsprozesses die Modellqualität: Ein längerer Prozess verleiht dem Modell besser differenzierte Ergebnisse, während ein zu kurzer Prozess zum Verlust wichtiger Datenpunkte führt. Die verwendeten Datensätze für Tiny-Diffusion sind auf 2D-Punktebasis ausgelegt, speziell das sogenannte „Dinodatensatz“ - eine Sammlung von zweidimensionalen Punkten, die eine Dinosaurierform nachbilden und ursprünglich aus der „Datasaurus Dozen“-Kollektion stammen. Obwohl der Ansatz für diese Art einfacher visueller Daten optimiert ist, gibt die Implementierung wertvolle Hinweise auf die Erweiterung zu komplexeren Datensätzen und höheren Dimensionen. Ein weiterer interessanter Aspekt in Tiny-Diffusion ist der Umgang mit Positionscodierung. Das Modell profitiert erheblich von einer entsprechenden Timestep-Embedding, das es erlaubt, die Zeitschrittinformation in die Vorhersagen einzubeziehen.

Dabei zeigt sich jedoch, dass die genaue Methode der Positionskodierung weniger entscheidend ist als deren generelle Präsenz, was Flexibilität bei der Modellgestaltung ermöglicht. Außerdem helfen sinusförmige Eingangs-Embeddings dabei, hochfrequente Funktionen besser zu erlernen, was in niedrigdimensionalen Problemräumen für eine präzise Abbildung der Daten essenziell ist. Neben der reinen Technik stellt Tiny-Diffusion durch seine Offenheit eine wertvolle Ressource für die Forschergemeinschaft dar. Der Quellcode ist frei auf GitHub verfügbar, wodurch Interessierte sowohl von bewährten Referenzen als auch von der Community-Unterstützung profitieren können. Zudem verweisen die Entwickler auf etablierte Implementierungen, wie jene von Jonathan Ho oder weiteren bekannten Diffusionsmodellen in TensorFlow und PyTorch, die als Inspiration dienten.

Ein besonderes Highlight ist die visuelle Aufbereitung der Projektergebnisse. Durch die Darstellung der Forward- und Reverse-Prozesse anhand der sich verändernden Punktwolken wird anschaulich, wie die Verteilung im Laufe der Diffusion manipuliert und wieder wiederhergestellt wird. Diese Visualisierungen erleichtern nicht nur das theoretische Verständnis, sondern fördern auch das experimentelle Arbeiten mit unterschiedlichen Hyperparametern, um die Modellperformance greifbar zu machen. Der Einsatz von Tiny-Diffusion ist unter anderem im akademischen Umfeld, bei der Lehre und als Einstieg für Entwickler interessant, die Diffusionsmodelle praktisch anwenden wollen, aber eine Überkomplexität scheuen. Die einfache Struktur erlaubt tiefere Einblicke, ohne durch umfangreiche Frameworks oder zusätzliche Funktionalitäten abzulenken.

Gleichzeitig bleibt die Offenheit bewahrt, sodass das Projekt durch Erweiterungen angepasst oder mit eigenen Daten angereichert werden kann. Mit dem steigenden Interesse an generativen Modellen und deren Bedeutung für KI-Anwendungen wie Bildsynthese, Datenaugmentation und Simulationen bietet Tiny-Diffusion einen kompakten, dennoch leistungsfähigen Einstiegspunkt in ein komplexes Forschungsfeld. Die minimalistische Architektur reflektiert die Grundprinzipien probabilistischer Diffusion und öffnet zugleich Türen für Weiterentwicklungen und Anpassungen an die Bedürfnisse unterschiedlichster Anwendungsszenarien. Zusammenfassend lässt sich sagen, dass Tiny-Diffusion exemplarisch zeigt, wie man theoretisch anspruchsvolle Konzepte auf einfache Weise erfahrbar macht. Es verbindet Lehrzwecke und Forschung mit einem offenen Zugang, der es ermöglicht, probabilistische Diffusionsmodelle zu verstehen, zu trainieren und zu evaluieren.

Die Konzentration auf 2D-Datensätze sollte nicht als Begrenzung, sondern als Ausgangspunkt betrachtet werden, der potenziell den Weg für komplexere Modelle ebnet. Im Zeitalter von KI und datengetriebenen Innovationen ist ein solches leicht zugängliches Werkzeug von unschätzbarem Wert, um die Grundlagen zu vermitteln und gleichzeitig praktisches Experimentieren zu fördern. Indem Tiny-Diffusion die Balance zwischen Einfachheit und Funktionalität findet, trägt es aktiv zur Verbreitung und Weiterentwicklung probabilistischer Diffusionsmethoden bei – einem Bereich, der mit hoher Wahrscheinlichkeit in naher Zukunft einen festen Platz in der KI-Forschung und Anwendung einnehmen wird.