Die Entwicklung künstlicher Intelligenz hat in den letzten Jahren enorme Fortschritte gemacht. Insbesondere große Sprachmodelle, auch Large Language Models (LLMs) genannt, haben Einzug in nahezu jeden Bereich der Softwareentwicklung gehalten. Sie sollen Prozesse beschleunigen, die Qualität des Codes verbessern und Entwickler in ihrer täglichen Arbeit unterstützen. Doch warum schwören einige Entwickler auf diese Helfer, während andere sie als unbrauchbar empfinden? Die Antwort liegt nicht allein in der Technologie selbst, sondern tief verborgen in der Art und Weise, wie Nutzer mit der KI interagieren – genauer gesagt, in sogenannten LLM Shibboleths. Der Begriff „Shibboleth“ stammt ursprünglich aus biblischen Erzählungen und bezeichnet eine Aussprache oder Ausdrucksweise, die eine Gruppe von einer anderen unterscheidet.

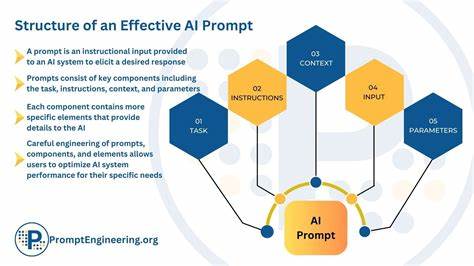

Übertragen auf den Kontext der KI und Programmierung beschreibt ein LLM Shibboleth die sprachlichen Feinheiten, die erfahrene Entwickler instinktiv verwenden und die das KI-Modell dazu veranlassen, qualitativ hochwertigere und relevantere Antworten zu liefern. Es geht dabei nicht nur um den Inhalt der Anfrage, sondern auch um die genaue Formulierung, die in gewisser Weise die „Expertensprache“ der jeweiligen Domäne widerspiegelt. LLM-Modelle werden mit Daten aus zahlreichen Quellen trainiert, darunter sowohl Anfragen von Einsteigern als auch von Experten. Die Herausforderung besteht darin, dass die Antworten des Modells stark vom Input abhängen. Anfänger stellen oft allgemeine oder ungenaue Fragen, was dazu führt, dass die KI ebenfalls vage oder basic Antworten gibt.

Im Gegensatz dazu liefern präzise formulierte Fragen von Experten oft tiefgehende, nuancierte und sofort umsetzbare Lösungen. Ein typisches Beispiel aus der Medizin zeigt dies eindrücklich: Eine unpräzise Frage wie „Was verursacht eine laufende Nase?“ führt oft zu allgemein gehaltenen Informationen oder sogar rechtlich abgesicherten Hinweisen, während der Begriff „differential diagnosis runny nose“ direkt in die Fachsprache eintaucht und eine viel detailliertere Antwort erzeugt. Im Bereich der Softwareentwicklung ist dies besonders relevant. Erfahrene Backend-Entwickler verwenden spezifische Begriffe wie „deleted_at“, „CRUD“, „migration“ oder „soft delete“. Diese Begriffe fungieren als Schlüsselwörter, die das Modell in eine Umgebung versetzen, in der es auf umfangreiche und hochwertige Trainingsdaten zurückgreifen kann, vor allem auf echten Code, Commit-Messages und Dokumentationen von erfahrenen Entwicklern.

Durch die Verwendung dieser Shibboleths wird die KI in die Lage versetzt, passende, saubere und wartbare Codevorschläge zu generieren. Für Anfänger in der Programmierung sieht die Realität oft anders aus. Wenn ihnen die passende Fachsprache fehlt, können ihre Anfragen ungenaue und wenig praktikable Antworten hervorrufen. Ein Beispiel ist die Frontend-Entwicklung: Eine unscharfe Frage wie „Wie kann ich den Aufruf von listX erst dann ausführen, wenn der Auth-Token vorhanden ist?“ kann zu einem chaotischen und schwer wartbaren Code führen, der Callback-Höllen erzeugt und oftmals weitere Fehler und Bugs inkludiert. Ohne eine solide Grundlage und Aufbau von Domänenwissen ist es schwer, die richtigen Fragen zu formulieren, die das Modell zu einer zielführenden Antwort bringen.

Diese Dynamik führt dazu, dass die Effektivität von KI-unterstützten Tools stark vom Erfahrungsniveau und der Fähigkeit abhängt, gezielt zu fragen. Die sogenannten LLM Shibboleths sind die verborgenen Sprachmuster, die Experten nahezu intuitiv nutzen, um maximale Qualität aus einem Modell herauszuholen. Sie sind gewissermaßen eine Eintrittskarte für den Zugang zu den besten und relevantesten Informationen und Erkenntnissen des AI-Systems. Ein weiteres Phänomen, das in diesem Zusammenhang auftaucht, ist das sogenannte Gell-Mann-Amnesie-Syndrom. Dabei bewerten Menschen die Informationen aus einer Domäne, in der sie Experten sind, häufig kritisch und skeptisch, doch in anderen Gebieten vertrauen sie den gleichen Quellen oder KI-Antworten unkritisch.

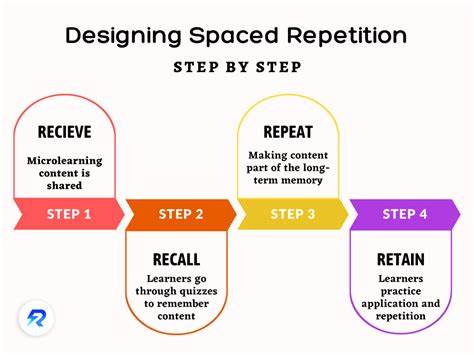

Interessanterweise erleben viele Entwickler eine ähnliche Erfahrung mit KI: In manchen Fachbereichen liefert das Modell sehr kompetente Erklärungen, doch in anderen Bereichen, selbst wenn die KI dafür trainiert ist, kann sie völlig fehlerhafte oder unlogische Rückmeldungen geben. Die nach außen hin eloquente und flüssige Textproduktion der KI wirkt wie eine autoritäre Stimme, die die menschliche Deferenz gegenüber scheinbarer Expertise auslöst – auch wenn die Antworten nicht immer korrekt sind. Für Entwickler, die KI als Codierungsassistenten nutzen wollen, gibt es bewährte Herangehensweisen, um die Herausforderungen zu meistern. Ein zentraler Aspekt ist dabei die Häufigkeit von Kontrollpunkten. Da die KI häufig fehlerhaften oder suboptimalen Code generiert, ist es wichtig, kleine, überschaubare Codeabschnitte zu erzeugen, die sofort getestet und validiert werden können.

Große Codeblöcke mit vielen Fehlern erschweren die Fehlersuche exponentiell. Mit gut fundierten Kenntnissen und dem richtigen Einsatz von Shibboleths kann man die Anzahl der Fehler deutlich reduzieren und die Interaktion mit der KI effektiver gestalten. Besonders für Anfänger gilt, dass sie mehr Zeit investieren sollten, um sich Grundlagenwissen anzueignen. Die Suche nach qualitativ hochwertiger menschlicher Dokumentation ist hierbei unerlässlich, denn KI-Systeme haben trotz ihrer Fähigkeiten weiterhin Defizite beim Erzeugen strukturell guter erklärender Dokumentationen. Zudem ist es sinnvoll, die KI darum zu bitten, Onboarding-Dokumente oder Zusammenfassungen zu generieren, um die Verständnislücken zu schließen.

Erfahrene Entwickler profitieren davon, wenn sie die Interaktion mit der KI als Zusammenarbeit mit einem Junior-Mitarbeiter verstehen. Eine klare strukturelle Vorgabe und ein gutes Beispiel beim Code-Design helfen der KI, besseren und konsistenteren Code zu generieren. Da LLMs ein ausgeprägtes Verständnis von Programmierstil und Refactoring-Methoden haben, können Entwickler gezielt Vorgaben machen, welchen Stil oder welche Architektur sie bevorzugen. Es ist wichtig, die Grenzen der KI zu erkennen und mit dem eigenen Wissen die Lücken zu schließen. Nicht jede Anweisung der KI sollte unreflektiert übernommen werden; vielmehr ist ein kritisches Verständnis und manuelles Nacharbeiten essenziell, um qualitativ hochwertige Software zu bekommen.

In Zukunft wird der menschliche Input besonders darin bestehen, große Codebasen strategisch zu organisieren und zu gestalten, während die KI vielfach routinemäßige Codierungsaufgaben übernimmt. Der Mix aus menschlicher Erfahrung und KI-Unterstützung wird den Entwicklungsprozess spürbar verändern. Während Backend-Experten dank präziser Sprache und fundiertem Wissen rasch funktionierenden Code erzeugen können, benötigen Entwickler auf anderen Ebenen - etwa im Frontend-Bereich - zunächst Zeit, um die passenden Shibboleths zu lernen und die KI gezielt anzuweisen. Es zeichnet sich ab, dass hohe Codequalität zunehmend von der Fähigkeit abhängt, gut zu prompten und die generierten Ergebnisse zu überprüfen, anstatt alle Details selbst zu schreiben. Insgesamt zeigen LLM Shibboleths auf, wie entscheidend die Qualität der Kommunikation zwischen Mensch und Maschine ist.

Die Beherrschung dieser sprachlichen Schlüssel ermöglicht es, das volle Potenzial von KI im Softwareentwicklungsprozess auszuschöpfen und die Zusammenarbeit produktiv und zufriedenstellend zu gestalten. Für angehende und erfahrene Entwickler ist es daher lohnend, sich intensiv mit den Eigenheiten ihres Fachjargons und der optimalen Formulierung von KI-Anfragen auseinanderzusetzen. So wird die künstliche Intelligenz vom bloßen Werkzeug zum echten Partner und Motor für Innovationen und Produktivität.