OpenAI hat in den letzten Jahren die Welt der Künstlichen Intelligenz maßgeblich geprägt und entwickelt stetig neue Modelle, die in ihrer Leistungsfähigkeit und Komplexität beeindruckend sind. Dennoch bleiben viele Aspekte rund um die Bezeichnungen, Trainingsmethoden und Inneren Strukturen der Modelle für Außenstehende oft unklar und verwirrend. Dies liegt vor allem daran, dass OpenAI seine Modelle nicht nur kontinuierlich verbessert, sondern auch zahlreiche Varianten und Versionen entwickelt, die aufeinander aufbauen und sich teilweise stark unterscheiden. Ein tiefer Blick in die Entwicklung der Modelle offenbart ein komplexes Geflecht von Basisversionen, verstärktem Training und Komprimierungen, die zusammenspielen, um leistungsfähige KI-Systeme zu schaffen. Zu Beginn steht bei OpenAI immer ein sogenanntes Basismodell.

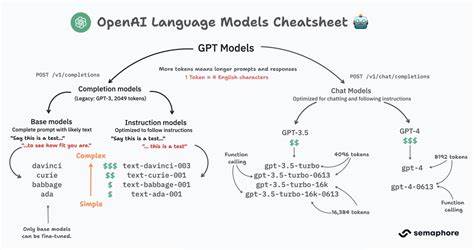

Diese Basisversionen sind Ergebnis eines intensiven Trainings auf umfangreichen Datensätzen aus dem Internet, bei dem das Modell lernt, den nächsten Textbaustein vorherzusagen. Beispiele für solche Basismodelle sind GPT-4o, GPT-4.1 und GPT-4.5. Diese Modelle unterscheiden sich vor allem in der Größe und dem Rechenaufwand, der für ihr Training eingesetzt wurde.

Ein größeres Modell mit mehr Trainingsressourcen kann in der Regel komplexere Zusammenhänge verstehen und präzisere Antworten liefern. Ab etwa 2023 begann OpenAI, neben dem klassischen Pre-Training, eine weiterführende Trainingsphase einzusetzen, die das sogenannte Reasoning-Training umfasst. Dabei wird das Modell mit einer Kombination aus Verstärkendem Lernen (Reinforcement Learning) und feinkörniger Anpassung auf hochwertigen, speziell ausgewählten Daten trainiert. Ziel dieses Trainings ist es, die Fähigkeiten der Modelle im Problemlösen, etwa in Bereichen wie Mathematik, Programmierung und Naturwissenschaften, deutlich zu verbessern. Die ersten Prototypen dieses Reasoning-Trainings wurden unter Bezeichnungen wie o1-preview und o1 bekannt.

Diese Modelle konnten gegenüber ihren Basismodellen signifikante Leistungssteigerungen vorzeigen. Eine weitere wichtige Technik, die OpenAI anwendet, ist die sogenannte Distillation. Hierbei wird ein großes, komplexes Modell genutzt, um ein kleineres Modell zu trainieren – dieses sogenannte Mini-Modell kann dann fast genauso gut performen wie sein großer Vorgänger, benötigt aber deutlich weniger Rechenressourcen. Die Mini-Modelle tragen Namen wie GPT-4o-mini, GPT-4.1-mini oder o1-mini und o3-mini, die jeweils kleinere Versionen ihrer Basismodell-Pendants mit unterschiedlichem Training und Feinschliff darstellen.

Das Zusammenspiel aus Basismodell, verstärktem Reasoning-Training und Distillation erklärt die Vielzahl der Bezeichnungen und Varianten, die OpenAI auf den Markt bringt – wobei die genauen Details von OpenAI weder transparent kommuniziert noch öffentlich zugänglich sind. Außenstehende können nur durch Beobachtung von Wissenstand, API-Kosten der Modelle und Benchmark-Ergebnissen Vermutungen anstellen. Denn ein größerer, komplexerer Modelltyp kostet typischerweise mehr, sodass sich eine grobe Einordnung anhand des Preises vornehmen lässt. Ein besonders interessantes Kapitel ist die Geschichte um die Modellreihe „o3“. Im Dezember 2024 veröffentlichte OpenAI erste Eindrücke eines besonders starken Modells namens o3, das auf großen Benchmark-Tests herausragende Werte erzielte.

Doch die finale Version, die im April 2025 erschien, unterscheidet sich maßgeblich in der Leistungsfähigkeit und dem damit verbundenen Rechenaufwand. Der ursprünglich prototypische o3 benötigte eine enorm hohe Rechenpower, die kommerziell nicht praktikabel war, weshalb OpenAI die Veröffentlichung vorerst zurückhielt und stattdessen die Reintegration der eingesetzten Technologien in GPT-5 plante. Einige Monate später erfolgte dann doch die Freigabe eines modifizierten, weniger rechenintensiven o3-Modells, das allerdings niedrigere Benchmark-Werte aufwies. Diese Verschiebung ist ein hervorragendes Beispiel dafür, wie flexibel und dynamisch OpenAI seine Modellpalette gestaltet. Dabei steht nicht immer eine eindeutige Absicht zur Verschleierung im Hintergrund, vielmehr spiegeln solche Entscheidungen die Herausforderungen wider, die Modelle sowohl technisch ausgereift als auch wirtschaftlich tragbar zu gestalten.

Ein weiterer spannender Aspekt der Entwicklung offenbart sich bei der Diskussion um GPT-5, das laut Expertenmeinungen vermutlich nicht einfach eine komplett neue Architektur ist, sondern eher eine Weiterentwicklung von GPT-4.5 oder einem ähnlich großen Basis-Modell mit zusätzlichen Post-Training-Schritten. Die sogenannte Post-Training-Phase ist ein aufwändiges Feintuning, das die Modelle dazu befähigt, komplexe Denkprozesse durch sogenannte reasoning tasks besser zu bewältigen. Wie genau das Trainingsbudget zwischen dem initialen Pre-Training und dem Post-Training aufgeteilt wird, ist eine der größten offenen Fragen und ein gut gehütetes Geheimnis. Schätzungen gehen davon aus, dass die Kosten im Milliardenbereich liegen und dass ein hoher Anteil des Trainingsaufwands in die Post-Training-Phase investiert wird.

Diese Herangehensweise könnte es ermöglichen, die Leistungsfähigkeit einer bereits umfangreichen Basis-Version noch einmal erheblich zu steigern, ohne dass zwangsläufig ein viel größeres Modell neu trainiert werden muss. Die Skalierungseffekte des Post-Trainings sind bisher nur schwer zu quantifizieren, denn es besteht Unsicherheit, wie stark sich Leistungsverbesserungen tatsächlich mit der Modellgröße multiplizieren lassen. Während größere Modelle generell eine bessere Grundlage bieten und deshalb mit zusätzlichem Post-Training überproportional profitieren könnten, gibt es auch theoretische Grenzen. So könnte die Qualität und Tiefe der Trainingsdaten selbst eine Obergrenze für Verbesserungen darstellen, die nicht allein durch mehr Rechenzeit oder zusätzliche Trainingseinheiten überwunden werden kann. Ein weiterer interessanter Gedanke ist, dass der bisher überwiegend auf Problemlösungen in Mathematik, Programmierung und Naturwissenschaften fokussierte Bereich des Post-Trainings noch nicht das volle Potenzial ausgeschöpft hat.

Möglicherweise eröffnet die gezielte Ausrichtung auf autonome Aufgaben, bei denen das Modell längerfristige und komplexe Prozesse eigenständig steuert – wie etwa die automatische Verwaltung großer Softwareprojekte oder die eigenständige Recherche und Erstellung von Inhalten – ganz neue Leistungsdimensionen. OpenAI steht damit vor der Herausforderung, nicht nur die technische Qualität und Leistungsfähigkeit ihrer Modelle kontinuierlich zu erhöhen, sondern dies auch mit Kosten, Skalierbarkeit und praktischer Einsatzfähigkeit in Einklang zu bringen. Die zukünftige Entwicklung wird stark davon abhängen, wie effektiv das Unternehmen mit immer größerem Trainingsbudget und neuer Hardware – beispielsweise den fortschrittlichen Nvidia-Chips – umgehen kann. Abseits der technischen Details wirft die aktuelle Entwicklung auch wichtige Fragen rund um Transparenz und öffentliche Kontrolle auf. Die Strukturen hinter der Entwicklung intelligenter KI-Systeme wie GPT-5 und der o-Serie bleiben größtenteils geheim, was Bedenken hinsichtlich der gesellschaftlichen Auswirkungen weckt.

Die Gefahr eines unkontrollierten Fortschritts, ohne öffentliche Einsicht oder regulatorisches Eingreifen, hat in Fachkreisen zu Forderungen nach mehr Offenheit und Schutzmechanismen geführt. Der Schutz von Whistleblowern wird als eine wichtige Maßnahme angesehen, um mögliche Risiken frühzeitig zu erkennen und mit Entscheidern und Gesellschaft kommunizieren zu können. Gleichzeitig wünschen sich Expert:innen eine stärkere Zusammenarbeit von Wissenschaft, Politik und Industrie, um Standards für Sicherheit, Transparenz und ethische Rahmenbedingungen rund um die Entwicklung von Künstlicher Intelligenz zu schaffen. Zusammenfassend lässt sich sagen, dass die Entwicklung der OpenAI-Modelle ein komplexes Zusammenspiel von Größe, Trainingsmethoden und wirtschaftlichen Überlegungen darstellt. Von den Basismodellen bis hin zu ausgefeilten Post-Training-Methoden zeigen sich beeindruckende Fortschritte und Herausforderungen zugleich.

Sprachmodelle wie GPT-5 könnten die nächste große Entwicklungsstufe markieren, vor allem durch eine geschickte Balance zwischen pre- und post-training, die neue Maßstäbe in der Leistungsfähigkeit setzen kann. Dennoch bleiben viele Details hinter einer Mauer der Geheimhaltung verborgen – was umso mehr Gründe liefert, die Debatte um Transparenz und verantwortungsbewusste KI-Entwicklung weiter voranzutreiben. Nur so kann die Gesellschaft sicherstellen, dass die Kraft dieser Technologien zum Wohle aller genutzt wird und nicht zu unkontrollierbaren Problemen führt.