Die Digitalisierung hat in den letzten Jahren die Art und Weise, wie wir kommunizieren, arbeiten und Unterhaltung konsumieren, grundlegend verändert. Besonders im Bereich der Videobearbeitung und Animation eröffnen neue Technologien immer mehr Möglichkeiten. Ein herausragendes Beispiel stellt die Kombination aus Wav2Lip und OpenVINO dar, welche das präzise Lippen-Synchronisieren von Videos auf ein neues Level hebt. Diese Entwicklung ist nicht nur für die Filmindustrie interessant, sondern auch für zahlreiche andere Anwendungsfelder wie virtuelle Assistenten, E-Learning, Gaming und digitale Influencer. Wav2Lip ist ein neuartiges Deep-Learning-Modell, das speziell darauf ausgelegt ist, Lippenbewegungen in Videoaufnahmen genau an Audiospuren anzupassen.

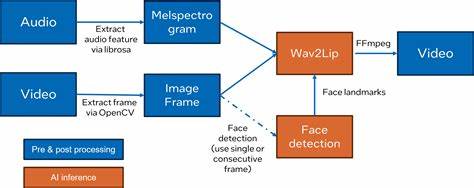

Die Technologie arbeitet mit nur einem vorhandenen Video und einer Audioaufnahme – unabhängig von der Sprachquelle oder vom Gesicht – und generiert daraus natürlich wirkende, präzise synchronisierte Lippenbewegungen. Im Gegensatz zu früheren Ansätzen, die oft auf starren Vorlagen oder begrenzten Datensätzen beruhten, nutzt Wav2Lip ein sogenanntes „Lip-Sync-Expert“-Modell in Kombination mit aufeinanderfolgenden Gesichtsframes, um besonders realistische Ergebnisse zu erzielen. Der technische Fortschritt von Wav2Lip bedeutet, dass nicht nur die Lippenbewegungen äußerst naturgetreu und flüssig animiert werden, sondern auch unterschiedliche Gesichtsausdrücke und Kopfbewegungen integriert werden können, ohne die Authentizität des Videos zu verlieren. Diese Fähigkeit ist besonders wertvoll in Szenarien, in denen originale Tonaufnahmen nachträglich verändert oder übersetzt werden sollen, beispielsweise bei der Synchronisation von Filmen, Serien und Werbevideos. Neben der beeindruckenden Modellarchitektur von Wav2Lip spielt die Optimierung dieses Prozesses eine entscheidende Rolle.

Hier kommt OpenVINO ins Spiel – eine von Intel entwickelte Open-Source-Plattform, die speziell auf die Beschleunigung von inferenzintensiven Modellen im Bereich des maschinellen Lernens ausgelegt ist. OpenVINO wandelt bestehende neuronale Netzmodelle in ein hardwareeffizientes Format um, das sowohl auf CPUs als auch auf spezialisierten Edge-Geräten optimale Leistung bringt. Dadurch wird die Ausführung von Wav2Lip nicht nur schneller, sondern auch ressourcenschonender. Die Integration von Wav2Lip mit OpenVINO erfolgt über die Konvertierung des ursprünglichen Modells in das Intermediate Representation-Format (IR), das als Zwischenschicht zur Verbesserung der Kompatibilität und Performance dient. Nach der Umwandlung kann die modellbasierte Pipeline erstellt und auf verschiedenen Geräten eingesetzt werden.

Das Ergebnis sind lippenbewegte Videos, die in Echtzeit oder beinahe in Echtzeit generiert werden können, selbst auf Systemen mit begrenzter Rechenleistung. Eine typische Anwendung für diese Technologie liegt in der Produktion von digitalem Content, wie zum Beispiel bei YouTube-Videos oder Podcasts, bei denen nachträglich eine verbesserte Lippenbewegung erzeugt wird, die perfekt zu den Videos passt. Ebenso profitieren die Bereiche der virtuellen Realität und Augmented Reality von einem verbesserten Lip-Syncing. Avatare und digitale Charaktere wirken dank präzise synchronisierter Mundbewegungen deutlich glaubwürdiger und können die Interaktion mit Nutzern auf eine authentischere Ebene heben. Darüber hinaus ermöglichen die Technologien von Wav2Lip und OpenVINO auch den Einsatz in der barrierefreien Kommunikation.

So können Hörgeschädigte von genauer synchronisierten Lippenbewegungen profitieren, die ihnen das Verstehen von gesprochener Sprache ohne akustische Unterstützung erleichtern. Durch die Echtzeitfähigkeit wird zudem der Einsatz in Videokonferenzen, im Kundenservice oder bei automatisierten Chatbots denkbar, um die Nutzererfahrung signifikant zu verbessern. Die Möglichkeiten gehen noch weiter: Im E-Learning können digitale Lehrer oder Trainer realistische Lippenbewegungen zeigen, die zur besseren Verständlichkeit und somit zu einem effektiveren Lernerlebnis beitragen. Ebenso eröffnen sich neue Perspektiven im Gaming-Sektor, wo Charaktere dank Wav2Lip noch lebensechter kommunizieren und Emotionen transportieren können. Das erhöht den Immersionseffekt und steigert die Spielerzufriedenheit erheblich.

Ein besonderes Merkmal von Wav2Lip ist die Fähigkeit, unabhängig von Sprache oder Dialekt zu arbeiten. Die Technologie benötigt nur das Audio als Grundlage, wodurch sie flexibel für globale Anwendungen eingesetzt werden kann. Auch wenn in einem Video die ursprüngliche Sprache nachträglich ersetzt wird, bleibt die Lippenbewegung naturgetreu erhalten, was die Qualität von synchronisierten Übersetzungen markant verbessert. Die Kombination mit OpenVINO stellt sicher, dass diese Modellanwendung nicht nur in High-End-Rechenzentren läuft, sondern auch auf Desktop-PCs, Laptops und sogar Embedded Devices. Dies macht den Zugang zur Technologie deutlich breiter und unterstützt Entwickler, Kreative und Unternehmen dabei, effiziente Lösungen zu implementieren, ohne teure Hardware investieren zu müssen.

Für Entwickler und Innovatoren bietet das bereitgestellte OpenVINO-Toolkit mit Beispielnotebooks, Hilfs-Skripten und einer umfassenden Anleitung eine hervorragende Grundlage zur schnellen Implementierung und Optimierung des Wav2Lip-Modells. Die Dokumentation unterstützt zudem dabei, die Modelle so zu konvertieren, dass sie auf verschiedensten Plattformen einsetzbar sind, und zeigt auf, wie interaktive Inferenz ermöglicht wird. Die Zukunft von Lippen-Synchronisation in Videos sieht dank dieser Entwicklungen vielversprechend aus. Die Forschung und Weiterentwicklung im Bereich künstlicher Intelligenz in Kombination mit optimierten Laufzeitumgebungen werden das Erstellen von Videoinhalten revolutionieren. Wer von authentischen, akkurat synchronisierten Lippenbewegungen in audiovisuellen Medien profitieren möchte, sollte diese Technologien beobachten und gegebenenfalls in ihre Workflows integrieren.

Zusammenfassend lässt sich sagen, dass Wav2Lip in Verbindung mit OpenVINO ein leistungsstarkes Werkzeugkit darstellt, das die Qualität von lippen-synchronisierten Videos maßgeblich steigert und gleichzeitig die nötige Rechenleistung effizient nutzt. Von der Entertainmentindustrie über Bildung bis zu barrierefreier Kommunikation eröffnet sich hier ein breites Spektrum an Anwendungen, die das Nutzererlebnis auf ein neues Level heben. Mit der fortschreitenden Digitalisierung wird die Bedeutung solcher innovativen Technologien weiter wachsen und sowohl Konsumenten als auch Produzenten von digitalen Inhalten nachhaltig beeinflussen. Die Kombination aus präziser künstlicher Intelligenz und optimierter Hardware-Nutzung macht die Zukunft des realistischen Lip-Syncings greifbar und realisierbar für jedermann.