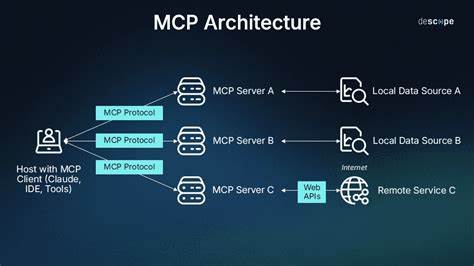

In der heutigen schnelllebigen Technologiewelt sind flexible und skalierbare Lösungen zur Ausführung von Code zunehmend gefragt. Eine innovative Möglichkeit, diese Anforderungen zu erfüllen, bieten Remote MCP Server, die sich perfekt für die serverlose Infrastruktur von Plattformen wie Vercel eignen. In Kombination mit moderner Cloudtechnologie erlauben sie es Entwicklern, komplexe Funktionen und Dienste ohne eigene Serverinfrastruktur auszuführen und dabei von hoher Sicherheit, geringem Wartungsaufwand und minimalen Kosten zu profitieren. Remote MCP Server sind im Wesentlichen spezialisierte Serverinstanzen, die das Multipurpose Control Protocol (MCP) verwenden. Dieses Protokoll ermöglicht es, Werkzeuge und Funktionen in einer standardisierten Weise bereitzustellen, deren Aufruf über natürliche Sprache möglich ist.

Dadurch lassen sich komplexe Aufgaben automatisieren und vielfältige Anwendungen entwickeln – von einfachen Echo-Tools über Zeitabfragen bis hin zu komplizierten Umgebungen mit neuronalen Netzen oder API-Verbindungen. Eine der populärsten Plattformen für die Umsetzung solcher Server ist Vercel. Ursprünglich für Frontend-Deployments bekannt, erweist sich Vercel als idealer Anbieter für serverlose Funktionen im Edge-Bereich. Auf dem dortigen Hobby-Tier können MCP-Server kostenlos betrieben werden, was insbesondere für kleinere Projekte, Prototypen und die Initialentwicklung von Anwendungen interessant ist. Der kostenlose Zugang mit großzügigen Limits, wie zum Beispiel 100 GB-Stunden Laufzeit und 100.

000 Aufrufen pro Monat, eröffnet vielfältige Möglichkeiten, ohne die finanziellen Ressourcen zu strapazieren. Ein Kernvorteil von Remote MCP Servern ist die sichere Ausführung von Code in einer isolierten, kurzlebigen Serverumgebung. Statt das lokale System potenziell unsicherem Code anzuvertrauen, der unnötig Risiken birgt, laufen alle Prozesse in kontrollierten Sandboxes. Nach jeder Anfrage wird die Umgebung zurückgesetzt, wodurch eine frische, sichere Instanz entsteht. Das Kontrastprogramm dazu wäre der direkte lokale Zugang, der bei missbräuchlicher Nutzung weitreichende Folgen haben kann.

Die Einrichtung eines solchen MCP-Servers gestaltet sich erstaunlich einfach. Über eine speziell entwickelte Adapterbibliothek lässt sich ein FastMCP-Server in eine Vercel-kompatible Funktion umwandeln. Nach nur einem Git-Push ist der Server betriebsbereit und reagiert innerhalb von wenigen Sekunden. Die Integration berücksichtigt den speziell zuständigen Umgang mit Sitzungszuständen und stellt komplexe APIs konsistent und performant zur Verfügung. Dadurch gelingt eine direkte Nutzung verschiedenster Tools über HTTP, gekoppelt mit nativer MCP-Unterstützung.

Die Werkzeuge, die ein Remote MCP Server bereitstellen kann, sind äußerst vielfältig. Einfache Beispiele sind Echo-Funktionen, die eine Eingabe unverändert zurückgeben, oder Zeitabfragen, die genaue Zeitstempel liefern. Diese Basisfunktionen demonstrieren die grundsätzliche Arbeitsweise und das Potenzial der Architektur. Erweiterbar sind die Systeme durch beliebige Python-Skripte, die komplexe Logik steuern können. Ein besonders interessantes Beispiel ist die Einbindung von externen APIs wie jener des National Weather Service in den USA.

Mit wenigen Zeilen Code lassen sich Wettervorhersagen abfragen, aufbereiten und ausgeben, was einen realen Nutzen schafft und die Möglichkeiten dieser Technologie eindrucksvoll unterstreicht. Eine große Stärke der Remote MCP-Architektur ist die standardisierte Interaktion mit großen Sprachmodellen (LLMs). Ob Claude von Anthropic, OpenAI’s GPT-Versionen oder Gemini von Google – alle können solche MCP-Server als Werkzeuge einbinden und somit ihre Funktionalität ohne tiefgreifendes manuelles Eingreifen erweitern. Dies ist besonders relevant für Entwickler, die Künstliche Intelligenz und natürliche Sprachverarbeitung mit realweltlichen Daten und Aktionen koppeln wollen. Das Zusammenspiel gelingt entweder direkt über URL-Konfigurationen in Clientanwendungen oder über speziell entwickelte Bridge-Scripts, die eine Proxy-Funktion zwischen lokalen und entfernten MCP-Servern übernehmen.

Der Sicherheitsaspekt bleibt allerdings ein wichtiges Thema. Die Ausführung beliebigen Codes birgt von Natur aus Risiken. Installationsskripte, die per Einzeiler über das Internet geladen werden, setzen auf Vertrauen in den Serverbetreiber. Potenzielle Angriffsvektoren reichen von bösartigem Codeeinschleusungen bis zu sogenannten Prompt-Injections, bei denen manipulierte Eingaben das Verhalten der KI oder der Tools ungewollt verändern können. Deshalb ist der Einsatz solcher Systeme aktuell eher für experimentelle oder wenig kritische Anwendungen geeignet.

Für den professionellen Betrieb empfehlen sich zusätzliche Sicherheitsmaßnahmen wie OAuth-Authentifizierung, Signierung von Anfragepaketen oder begrenzte Betriebszeiten und Zugriffsbeschränkungen. Auch wenn der kostenlose Einstieg bei Vercel sehr verführerisch ist, gilt es bedenken zu berücksichtigen. Plattformen, die mit großzügigen Gratisangeboten Nutzer anlocken, setzen häufig später Preise an, die selbst kleine Unternehmen schnell belasten können. Außerdem besteht die Gefahr einer Abhängigkeit von einem Anbieter. Alternativen wie AWS Lambda oder Google Cloud Functions bieten ähnliche Funktionalitäten, sind aber oft mit höherem Einrichtungsaufwand verbunden und sind selten komplett kostenfrei.

Trotz dieser Einschränkungen bietet die Kombination aus MCP, serverlosen Funktionen und modernen Cloud-Diensten eine zukunftsweisende Basis für die Entwicklung innovativer Applikationen. Automatisierung, Integration von KI und Echtzeit-Zugriff auf verschiedenste Datenquellen lassen sich so effizient realisieren. Die Tatsache, dass man heute von einem simplen Python-Skript zu einem voll funktionsfähigen, weltweit verteilten, skalierbaren MCP-Server gelangt, ist ein Meilenstein der Anwendungsentwicklung. Die Wichtigkeit von Remote MCP Servern zeigt sich darüber hinaus durch die Möglichkeit, bestehende Container von mächtigen Sprachmodellen zu erweitern, ohne dass jedes Modell selbst komplexe Werkzeuge implementieren muss. Stattdessen lagert man spezifische Funktionen aus und bindet sie dynamisch ein.

Das steigert nicht nur die Flexibilität, sondern ermöglicht auch eine schnelle Anpassung an neue Use Cases. Im Endeffekt zeigt die Technologie Remote MCP Server sowohl das Potenzial als auch die Herausforderungen moderner Cloud- und KI-getriebener Softwareentwicklung. Die Integration von natürlichsprachlichen Werkzeugaufrufen mit serverlosen Cloudfunktionen ist ein vielversprechender Schritt auf dem Weg zu intelligenten, flexiblen und wartungsarmen Systemen. Gleichzeitig gilt es, mit Augenmaß und bewusstem Risikomanagement an das Thema heranzugehen, um die Sicherheit und Zuverlässigkeit nicht zu kompromittieren. Für Entwickler, die Optionen suchen, ihre Anwendungen mit dynamischen, KI-integrierten Tools auszurüsten, stellt Remote MCP Server eine ideale Ausgangsbasis dar.

Die einfache Einrichtung dank Adapterbibliotheken, die Schnittstellen zu bekannten Programmiersprachen und die Verfügbarkeit von Cloudplattformen mit großzügigen kostenlosen Tarifen vereinen eine attraktive Kombination. Mit einer Community und Open-Source-Projekten, die die Entwicklung vorantreiben, bieten sich sowohl Anfänger als auch Profis lohnende Möglichkeiten, neue Wege der Programmierung und Automatisierung zu beschreiten. Das Gesamtbild dieser technischen Entwicklung ist zugleich faszinierend und ironisch: Um einfache Aufgaben wie Addition zweier Zahlen auszuführen, werden komplexe, weltweit verteilte Systeme in Gang gesetzt. Serverlose Edge-Funktionen auf 5nm-Halbleitern reagieren auf natürliche Sprache, orchestrieren Hypervisoren und koordinieren Milliarden von Rechenoperationen nur, um standardisierte Resultate zurückzugeben. Diese Kombination aus hochentwickelter Infrastruktur und simpler Aufgabe zeigt die überraschende Effizienz und zugleich das kuriose Paradox moderner IT.

Zusammenfassend lässt sich sagen, dass Remote MCP Server eine zukunftsträchtige Plattform für serverlose Ausführung, KI-Anbindung und flexible Softwareentwicklung bieten. Wer bereit ist, sich mit den Sicherheitsrisiken auseinanderzusetzen und die technischen Voraussetzungen erfüllt, kann von den zahlreichen Vorteilen profitieren. Egal, ob man einfache APIs betreibt, neuronale Netze integriert oder komplexe Multi-Tool-Systeme aufbaut – die Möglichkeiten sind vielfältig und gerade erst am Anfang ihrer Entwicklung. Für alle, die neugierig sind und selbst experimentieren möchten, stehen zahlreiche Ressourcen, inklusive Bibliotheken, Beispielprojekten und ausführlicher Dokumentation zur Verfügung. Die aktive Community sorgt für stetigen Austausch und Weiterentwicklung.

Das Gesamtpaket stellt heute schon eine lohnende Option dar, die sowohl Innovationsfreude als auch Pragmatismus vereint und maßgeblich zur Evolution der Softwarelandschaft beiträgt.