In der heutigen schnelllebigen Welt der Technologie bleibt der Drang, Software schneller, effizienter und fehlerfrei zu entwickeln, eines der wichtigsten Ziele zahlreicher Entwickler und Firmen. Doch die Realität sieht oft anders aus: Viele Projekte verzögern sich, Systeme werden komplexer, neue Tools führen trotz ihrer innovativen Versprechen nicht immer zu besseren Ergebnissen. Tatsächlich bedienen sich viele Entwickler konventioneller, oft als veraltet oder ineffizient geltender Praktiken, die zu langsamerer und weniger optimaler Software führen. Doch warum ist das so? Und könnte sich diese bewusste oder unbewusste Wahl als strategisch sinnvoll herausstellen? Ein genauer Blick auf die Mechanismen, Denkweisen und Herausforderungen der Softwareentwicklung liefert überraschende Antworten. Die Softwareentwicklung ist nicht nur reine Technik, sondern auch Psychologie, Kultur und Risikoabwägung.

Innovationen und neue Paradigmen locken mit großen Versprechen, sind aber stets mit Unsicherheiten verbunden. Ein Wechsel zu neuen Programmiersprachen wie funktionaler Programmierung, die auf immutablen Daten und reinen Funktionen setzt, mag modern und theoretisch elegant sein. Doch in der Praxis sehen viele Entwickler die Vorteile der Mutabilität – also variabler Zustände – als Sicherheit und Kontrolle an. Mutierbarer Zustand bedeutet, dass Funktionen nicht isoliert betrachtet werden, sondern stets im Kontext des gesamten Systems. Diese „globale Abhängigkeit“ mag alles andere als sauber oder elegant wirken, sorgt aber dafür, dass Entwickler sich ständig mit dem Gesamtbild auseinandersetzen müssen und so ein umfassendes Verständnis entwickeln.

Insbesondere in Teams oder großen Codebasen schafft das eine gemeinsame Basis – auch wenn sie mit Schwierigkeiten verbunden ist. Ein weiteres Beispiel für den Verzicht auf modernes Design findet sich in der Ablehnung von Event Sourcing. Dieses Prinzip, bei dem jede Zustandsänderung eines Systems als unveränderliches Ereignis aufgezeichnet wird, bietet theoretisch eine hervorragende Nachvollziehbarkeit, einfache Fehlerkorrektur und flexible Datenanalysen. Praktisch aber führt die Implementierung von Event Sourcing zu hoher Komplexität: Systeme, die auf Kafka, MongoDB und ähnlichen Technologien aufbauen, kämpfen mit Asynchronität, Herausforderungen bei der Konsistenz und großem operativen Aufwand. Deswegen halten viele Entwickler an klassischen Methoden fest: dem direkten Überschreiben und Verändern des Zustands innerhalb einer Datenbank.

Diese Herangehensweise existiert seit Jahrzehnten, ist gut dokumentiert und bietet aufgrund ihrer Verbreitung eine niedrige Fehlerquote sowie umfangreichen Support. Dabei wird die jahrzehntelange Erfahrung genutzt, die es erlaubt, bewährte Lösungen und Workarounds anzuwenden. Eines der größten Herausforderungen, die moderne Anwendungen beschäftigen, sind Datenbankschema-Migrationen – also das Ändern der Struktur gespeicherter Daten während des laufenden Betriebs. Viele Entwickler investieren enorme Zeit in aufwändige Strategien, um diese Änderungen ohne Ausfallzeiten zu ermöglichen. Das Rollen von Datenmodellen mit gleichzeitiger Unterstützung alter und neuer Strukturen, das Synchronisieren und die Sicherstellung der Datenintegrität wird penibel geplant und technisch ausgefeilt.

Auch wenn es Tools gibt, die eine scheinbare Instant-Migration ermöglichen, herrscht verbreitet Skepsis – zu gut klingen solche Lösungen, als dass sie ohne Kompromisse funktionieren könnten. Viel lieber greifen Teams auf bewährte Handgriffe zurück, die sich in der Praxis bewährt haben, auch wenn sie umständlich wirken. In puncto Datenhaltung schwören viele Entwickler auf global veränderbare Datenbanken. Wenn jemand globale veränderbare Variablen im Code als schlechter Stil ablehnt, wird das bei Datenbanken oft ignoriert oder ausgeblendet. Schließlich bieten Datenbanken Transaktionen, die die Integrität sichern und Abläufe strukturieren.

Trotzdem bleiben grundlegende Probleme bestehen: Das System hängt von gemeinsam genutzten, veränderbaren Zuständen ab, was den komplexen Zustand über mehrere Komponenten hinweg schwer nachvollziehbar und fehleranfällig macht. Dennoch ist es oft die praktikabelste Möglichkeit, komplexe Anwendungen mit vielen Nutzern und konstantem Datenzugriff zu realisieren. Ein weiterer Punkt, der häufig übersehen wird, ist das sogenannte „Zukunftssichermachen“ von Code. Entwickelnde Teams verbringen beträchtliche Zeit damit, Software so flexibel und modular wie möglich zu gestalten und dabei auf zukünftige Anforderungen zu planen. Während diese Herangehensweise tatsächlich den Aufwand für spätere Erweiterungen verringert, birgt sie auch das Risiko unnötiger Komplexität und Verzögerungen im Initialstadium.

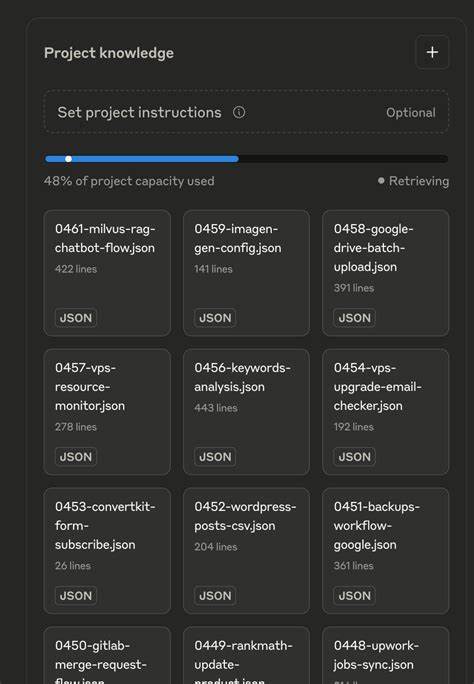

Doch viele sehen dies als besseren Weg, da spätere, umfassende Umbauten deutlich aufwändiger und teurer sein können. Mit zahlreichen Features wie Flags, Abstraktionen und Erweiterungspunkten auszustatten, gehört heute zum Standard, auch wenn die gegenwärtigen Anforderungen diese teilweise nicht einmal benötigen. Zugleich setzen Entwickler weiterhin auf Werkzeuge mit starren Datenmodellen, wie klassische relationale Datenbanken und Object-Relational Mappings (ORMs). Solche Technologien passen nicht immer perfekt zum Konzept der jeweiligen Anwendung, weshalb Teams oft mehrere Tools kombinieren müssen – beispielsweise eine Suchmaschine, ein Dokumenten- oder Graphdatenbank. Die Integration dieser Systeme bringt Herausforderungen mit sich und erzeugt technische Schuld, führt aber gleichzeitig zu einem gewissen Maß an Redundanz und Flexibilität, die in einzelnen Systemen schwer realisierbar wären.

Die vielgepriesene Vielfalt an spezialisierten Tools schafft auf diese Weise eine komplexe, aber beherrschbare Infrastruktur. Was macht es also aus, dass insbesondere erfahrene Entwickler oder größere Organisationen trotz der scheinbaren Nachteile an vermeintlich „schlechteren“ Methoden festhalten? Eine mögliche Antwort liefert der menschliche Umgang mit Risiko und Gewohnheit. Neue Technologien und Paradigmen bedeuten stets Lernkurven, Unsicherheiten und – potenziell schwere – Fehler im Betrieb. Gerade bei großen Systemen mit vielen Nutzern, strengen Service-Level-Agreements und hohen Kosten können auch kleine Fehler dramatische Folgen haben. Bekannte Muster und Werkzeuge hingegen sind gut erforscht, die Risiken kalkulierbar, Lösungen und Workarounds sind vorhanden – oft nur einen Klick entfernt, etwa in einschlägigen Foren wie StackOverflow.

Gerade dieses Sicherheitsgefühl ist für viele unumgänglich. Auf den ersten Blick klingt es paradox, bewusst schlechtere Software, langsamere Abläufe und komplexe Strukturen zu pflegen. Doch wenn man die Gesamtsituation betrachtet, wird klar: Es geht hier nicht um Ideale der Perfektion, sondern darum, eine pragmatische Balance zwischen Innovation und Verlässlichkeit, zwischen Fortschritt und Risiko zu finden. Es entsteht ein Ökosystem, das von bewährten Techniken lebt, aber offen für Verbesserungen bleibt – wenn auch häufig eher vorsichtig und kontrolliert. Es zeigt sich ebenfalls, wie wichtig das „Ökosystem“ von Entwicklerwerkzeugen, Community-Support und Erfahrungswerte wird.

Tools, die als „best practice“ gelten, verfügen meist über breite Gemeinschaften, umfangreiche Dokumentation und erprobte Lösungen für zahlreiche Probleme. Neue Ansätze dagegen leben oft in der Idee – in der Praxis fehlen Ressourcen, Erfahrungsberichte und Referenzprojekte. Dies wirkt stark entmutigend und favorisiert den Verbleib bei Bewährtem. Zudem ist nicht zu unterschätzen, wie emotionale Faktoren und soziale Dynamiken innerhalb von Entwicklerteams und Organisationen die Wahl der technischen Mittel beeinflussen. Der Wunsch nach Stabilität, das Bedürfnis nach effizienter Zusammenarbeit und das Hinauszögern unangenehmer Risiken wirken sich unmittelbar auf Entscheidungen aus.

Auch der institutionelle Kontext spielt eine Rolle: Unternehmen in regulierten Branchen, mit hohen Compliance-Auflagen oder langjährigen Kundenbeziehungen zeigen meist eine konservativere Haltung gegenüber disruptiven Technologien. Doch bedeutet das, dass Fortschritt und Innovation in der Softwareentwicklung chancenlos sind? Keineswegs. Es zeigt sich vielmehr, dass Innovationen oft schrittweise, inkrementell und mit Rücksicht auf bestehende Infrastrukturen umgesetzt werden. Die erfolgreichsten Technologien und Methoden sind jene, die sich in den Alltag von Entwicklern und den Betrieb großer Systeme nahtlos eingliedern lassen, ohne die Gesamtstabilität zu gefährden. Abschließend lässt sich festhalten, dass die bewusste Wahl von scheinbar schlechteren und langsameren Softwarelösungen keineswegs Ausdruck von Inkompetenz oder Reaktionärismus ist.

Vielmehr handelt es sich häufig um eine wohlüberlegte Strategie, um Risiken zu minimieren, das Gesamtverständnis des Systems zu stärken und den Entwicklungsaufwand kalkulierbar zu halten. Die Herausforderung für die Zukunft liegt darin, neue Konzepte so zu gestalten, dass sie diese Sicherheit vermitteln, aber gleichzeitig die Effizienz, Wartbarkeit und Qualität der Software spürbar erhöhen. Nur dann wird es gelingen, den idealen Mittelweg zwischen Stabilität und Innovation zu finden und Softwareentwicklung wirklich besser zu machen.