Die rasante Entwicklung der Künstlichen Intelligenz hat in den letzten Jahren zahlreiche Branchen revolutioniert, und das Finanzwesen bildet hierbei keine Ausnahme. Insbesondere Large Language Models, kurz LLMs, haben sich als äußerst vielversprechende Werkzeuge erwiesen, wenn es darum geht, komplexe Fragestellungen rund um Finanzdokumente zu verstehen und zu beantworten. Angesichts der Vielzahl an Finanzberichten, Vertragswerken und regulatorischen Texten stehen Unternehmen und Institutionen vor der Herausforderung, große Mengen an Informationen effizient und korrekt zu analysieren. Hier bieten LLMs eine neue Dimension der Automatisierung und Intelligenz, die tiefere Einblicke und schnellere Entscheidungen ermöglichen kann. Doch wie gut sind diese Modelle wirklich auf die spezifischen Anforderungen im Finanzbereich angepasst? Welchen Herausforderungen begegnen Entwickler und Anwender gleichermaßen? Und wie lässt sich die Leistungsfähigkeit dieser Modelle messen und optimieren? Die Idee eines Benchmarks für die Fragebeantwortung im Finanzdokumentenbereich gewinnt in diesem Kontext zunehmend an Bedeutung.

Ein Benchmark schafft die Grundlage für eine objektive, vergleichbare und reproduzierbare Bewertung von LLMs, sodass Stärken und Schwächen der Modelle klar identifizierbar werden. Anhand solcher standardisierter Tests kann nicht nur die Genauigkeit bei der Beantwortung von Fragen erhöht, sondern auch das Verständnis für finanzfachliche Nuancen gefördert werden. Finanzdokumente zeichnen sich durch ihre Komplexität, technische Terminologie und juristische Sorgfalt aus. Ein einfaches Sprachverständnis reicht hier nicht aus, um korrekte Antworten zu generieren. Vielmehr erfordert die Analyse eine multidimensionale Kompetenz, die es ermöglicht, Zahlen, Zusammenhänge und rechtliche Rahmenbedingungen adäquat zu interpretieren.

In der Praxis bedeutet dies, dass LLMs nicht nur reine Textinformationen erfassen, sondern auch Querverweise erkennen und logische Schlüsse ziehen müssen. Fehler oder Fehlinterpretationen können schwerwiegende Folgen haben – sei es in Form von falschen Investmententscheidungen, Verstößen gegen Compliance-Vorgaben oder Missverständnissen in Vertragsverhandlungen. Durch die Entwicklung und den Einsatz spezialisierter Benchmarks lassen sich solche Risiken minimieren und der Einsatz von LLMs im Finanzbereich deutlich sicherer gestalten. Gleichzeitig fördern solche Benchmarks die Innovation, da sie Forscher und Entwickler dazu anspornen, ihre Modelle gezielt auf finanzspezifische Herausforderungen anzupassen. Ein weiterer zentraler Aspekt bei der Bewertung von LLMs für Finanzdokumente ist die Transparenz und Nachvollziehbarkeit der Antworten.

In regulierten Umfeldern ist es essenziell, dass Entscheidungen und Antworten erklärbar sind, damit Verantwortliche diese begründen und im Zweifel überprüfen können. Dies stellt hohe Ansprüche an die Modellarchitektur und die eingesetzten Trainingsdaten. Die Qualität der Daten spielt eine wesentliche Rolle, denn nur auf fundierten und vielfältigen Datensätzen basierende Modelle können ein wirklich tiefgehendes Verständnis entwickeln. Zusätzlich zu klassischen Jahresberichten und Finanzanalysen werden vermehrt auch alternative Datenquellen berücksichtigt, um Modelle realistischer und robuster zu trainieren. Die Kombination aus natürlichen Sprachdaten, numerischen Informationen und juristischen Dokumenten schafft eine anspruchsvolle Trainingsumgebung, welche die LLMs für den praktischen Einsatz im Finanzsektor fit macht.

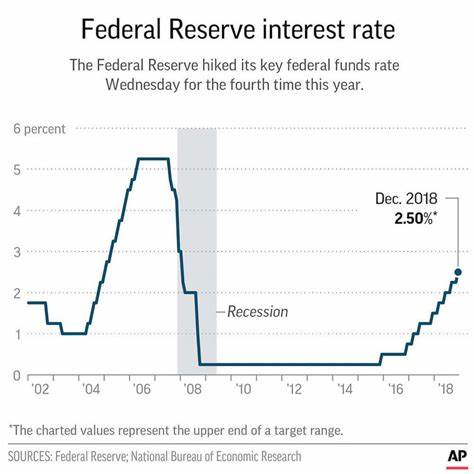

Darüber hinaus eröffnet die Integration moderner Technologien, wie beispielsweise Natural Language Understanding (NLU) und Named Entity Recognition (NER), neue Möglichkeiten, um Finanzdaten noch präziser zu erfassen und auszuwerten. In der Umsetzung eines Benchmarks für die Finanzdokumentenfragebeantwortung müssen darüber hinaus verschiedene Arten von Fragen berücksichtigt werden. Diese können von einfachen Faktenabfragen bis hin zu komplexen Interpretationen und Szenarien reichen, die mehrere Dokumente oder Jahreszahlen umfassen. Ein besonders herausfordernder Bereich ist die zeitliche Dynamik der Finanzwelt, da sich Zahlen und Rahmenbedingungen häufig ändern und dynamisch interpretiert werden müssen. Die Fähigkeit eines LLMs, diese Veränderungen zu erkennen und entsprechend zu handeln, ist ein entscheidendes Kriterium für seine Praxistauglichkeit.

Neben der Funktionalität steht auch die Effizienz und Skalierbarkeit der Modelle im Fokus. Finanzdatenbanken und Dokumentenarchive wachsen stetig, weshalb die automatisierte Verarbeitung in Echtzeit oder zumindest in sehr kurzer Zeit erfolgen muss. Leistungsstarke Rechenarchitekturen und optimierte Algorithmen stellen sicher, dass Antworten schnell bereitgestellt werden können, ohne Einbußen bei der Qualität hinzunehmen. Abschließend lässt sich festhalten, dass die Entwicklung und Etablierung eines LLM-Benchmarks für die Beantwortung von Finanzdokumenten ein entscheidender Schritt ist, um die Digitalisierung und Automatisierung im Finanzsektor voranzutreiben. Ein solcher Benchmark ermöglicht nicht nur eine objektive Bewertung, sondern auch eine zielgerichtete Weiterentwicklung der Modelle, die den komplexen Anforderungen der Finanzwelt gerecht werden.

Die Kombination aus technologischem Fortschritt, spezifischen Trainingsdaten und intelligenter Evaluierung wird die Art und Weise verändern, wie Finanzinformationen verarbeitet werden – mit positiven Auswirkungen sowohl für Unternehmen als auch für Endkunden. Somit stellt die Forschung an LLM-Benchmarks für Finanzdokumente eine spannende Schnittstelle von KI, Finance und Recht dar, die in den kommenden Jahren sicherlich weiter an Bedeutung gewinnen wird.