Die digitale Transformation und der kontinuierlich wachsende Bedarf an Cloud-basierten Lösungen stellen IT-Architekturen vor immense Herausforderungen. Sealos, eine innovative Cloud-Plattform, sah sich mit genau solch einer Herausforderung konfrontiert: Wie lässt sich eine Umgebung effektiv skalieren, die mittlerweile mehr als 2.000 Mandanten bedient, ohne dabei an Performance und Stabilität einzubüßen? Die Antwort lag im grundlegenden Wandel der eingesetzten Technologie – weg von Nginx hin zu Envoy als Kernkomponente des API-Gateways. Seit der Einführung von Sealos Cloud hat die Plattform ein beeindruckendes Wachstum erfährt und unterstützt inzwischen 87.000 registrierte Nutzer.

Jeder einzelne Anwender benötigt für seine Anwendungen dedizierte Zugangspunkte, wodurch das Routing-Management exponentiell komplexer wurde. Die Cluster mussten damit Millionen von Ingress-Einträgen handhaben, die eine robuste und leistungsfähige Lösung erforderten. Hier zeigte sich, dass der ursprünglich eingesetzte Nginx Ingress Gateway an seine Grenzen stieß. Nginx erfreut sich in vielen Kubernetes-Umgebungen großer Beliebtheit. Dennoch offenbarten sich im Betrieb von Sealos Cloud mehrere kritische Einschränkungen, die das Wachstum stark behinderten.

Änderungen an der Konfiguration führten zu Stabilitätsproblemen, insbesondere zu nicht vorhersehbaren Unterbrechungen während der Reload-Vorgänge. Diese temporären Verbindungsausfälle sind für Echtzeitanwendungen ein großes Problem, da aktive Verbindungen häufig abrupt beendet wurden. Zudem litt die Plattform unter einer langsamen Propagierung von Konfigurationsänderungen, was in Kombination mit hohem Ressourcenverbrauch auf lange Sicht zu Leistungseinbußen und sogar Speicherüberläufen (OOM) führte. Um die damaligen Schwierigkeiten zu überwinden, prüfte das Sealos-Team alternative Gateways. Ein Kandidat war APISIX, dessen Architektur grundsätzlich viele der Reload-Probleme von Nginx adressiert.

Trotz der soliden Kernfunktionen sah sich die Sealos Cloud jedoch mit instabilen Komponenten des APISIX Ingress Controllers konfrontiert. Diese führten mehrfach zu Abstürzen und beeinflussten die Produktionsumgebung negativ. Eine weitere Alternative bot der Cilium Gateway, welcher allerdings einen starken Fokus auf Load Balancer (LB) aus Public Cloud Services legt. Seine enge Kopplung an LB-Services widersprach den Anforderungen an eine flexible, private Infrastruktur, die Sealos anstrebt. Zu allem Überfluss beeinträchtigte die langsame Aktualisierung großer Routing-Tabellen die notwendige SLA von unter fünf Sekunden.

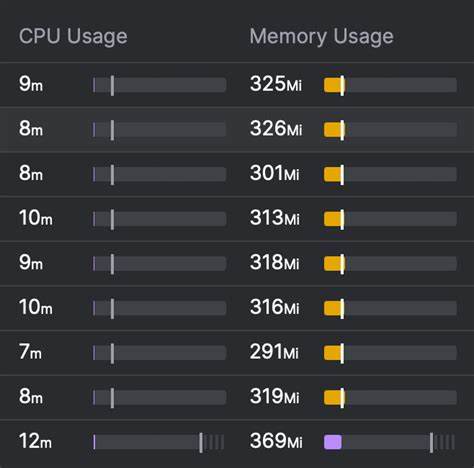

Damit scheiterte auch diese Option an den spezifischen Bedürfnissen der Plattform. Die Suche nach einem passenden Gateway führte zum Envoy Gateway, das dank seiner hochskalierbaren, cloudnativen Architektur großes Potenzial versprach. Zu Beginn standen zwar Herausforderungen wie Speicherlecks und fehlende Features auf der Roadmap, doch mit stetigen Upgrades und der engagierten Beteiligung der Community konnten diese Probleme überwunden werden. Envoy überzeugte insbesondere durch seine effiziente Nutzung von CPU und Speicher sowie die Fähigkeit, eine Vielzahl von Verbindungen stabil zu halten, selbst in Hochlastsituationen. Neben diesen rein technischen Aspekten spielte auch die Kubernetes Gateway API Standardisierung eine Rolle.

Dieser Standard verfolgt das Ziel, APIs synchron und effizient zu verwalten. Dennoch zeigt sich gerade in Multi-Tenant Public-Cloud-Szenarien eine Diskrepanz zwischen theoretischer Flexibilität und praktischer Umsetzbarkeit. Die zugrundeliegenden Designentscheidungen erlauben keine klare Trennung von Berechtigungen zwischen Cluster-Administratoren und den einzelnen Nutzern, was in großen gemeinschaftlich genutzten Clustern zu Sicherheits- und Verwaltungsproblemen führt. Sealos erkannte hier die Notwendigkeit, eine Lösung zu finden, die sowohl offene Standards berücksichtigt als auch Mehrmandantenfähigkeit und Isolation auf einem hohen Niveau gewährleistet. Vor diesem Hintergrund stieß das Team auf Higress, ein auf Envoy basierendes Gateway, das speziell Optimierungen für große Routing-Tabellen und stabile Controllerfunktionen mitbringt.

Higress zeichnete sich durch eine drastische Reduktion der Konfigurationslatenz aus – von vormals zwei Minuten auf nur noch drei Sekunden. Diese Verbesserung übertraf die Dauer, die Container benötigen, um startbereit zu sein, was bei der Bereitstellung und beim Rollout von Anwendungen entscheidend ist. Zudem bewies Higress eine erhebliche Robustheit gegenüber Controller-OOM-Situationen und eine insgesamt niedrige Ressourcenbeanspruchung selbst unter extremer Last. Ein entscheidender Vorteil bei der Einführung von Higress war dessen Kompatibilität mit den bestehenden Nginx Ingress Annotationen. Dadurch konnte Sealos einen nahezu nahtlosen Übergang sicherstellen, indem die vorhandenen Ingress-Ressourcen ohne aufwändige Neuentwicklungen weiterverwendet wurden.

Dies senkte die Migrationskosten erheblich und minimierte Betriebsunterbrechungen. Persönliche Beteiligungen durch Bug-Reports und Optimierungsvorschläge halfen darüber hinaus, Higress weiter zu stärken und die Plattform an die spezifischen Bedürfnisse von Sealos anzupassen. Im Hinblick auf Sicherheitsaspekte erwies sich die erhöhte Performance als entscheidender Schutzfaktor. Häufige Überlastungen durch Traffic-Spitzen hatten in der Vergangenheit zu Engpässen geführt, welche Angreifern womöglich als Angriffspunkte dienten. Das effiziente Ressourcenmanagement und die schnelle Reaktionszeit von Envoy und Higress verhinderten solche Flaschenhälse und verbesserten die Gesamtstabilität und Sicherheit des Systems.

Mit dem Wechsel zu Envoy hat Sealos nicht nur die unmittelbaren Performance-Probleme überwunden, sondern auch die Grundlage für zukünftige Skalierungen gelegt. Die flexible Architektur von Envoy ermöglicht die Integration fortschrittlicher Features wie Circuit Breaker, fortschrittliche Traffic-Steuerung und detailliertes Monitoring, die für den Betrieb einer Multi-Tenant-Cloud unerlässlich sind. Obwohl der Kubernetes Gateway API Standard weiterentwickelt wird, bietet die Kombination aus Envoy und Higress für Sealos aktuell die beste Mischung aus Stabilität, Performance und Anpassbarkeit. In der Praxis zeigt das Beispiel von Sealos, wie wichtig es ist, kritisch zu bewerten, welche Technologien den Anforderungen einer schnell wachsenden, anspruchsvollen Cloud-Umgebung gerecht werden. Eine bloße Übernahme bewährter Lösungen reicht oft nicht aus.

Stattdessen ist die sorgfältige Analyse, das intensive Testen und vor allem auch das aktive Mitwirken an Open-Source-Projekten entscheidend, um maßgeschneiderte, zukunftssichere Plattformen zu schaffen. Zusammenfassend lässt sich festhalten, dass Sealos durch den Umstieg von Nginx auf Envoy unter Verwendung von Higress seine Multi-Tenant-Cloud massiv skalierbar gemacht hat. Die gesamte Infrastruktur ist jetzt in der Lage, Millionen von Routing-Einträgen zu managen, tausende von gleichzeitigen Verbindungen stabil zu verarbeiten und dabei sowohl Performance als auch Sicherheit auf höchstem Niveau zu gewährleisten. Diese Erfolgsgeschichte unterstreicht die Bedeutung von innovativen, flexiblen API-Gateways für moderne Cloud-Umgebungen und bietet wertvolle Erkenntnisse für andere Anbieter, die ähnliche Herausforderungen meistern wollen.