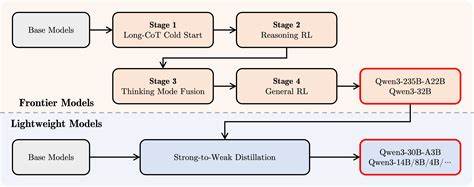

Die rasante Entwicklung im Bereich der künstlichen Intelligenz hat die Art und Weise, wie wir mit Modellen wie Qwen 3 interagieren, grundlegend verändert. Qwen 3 überzeugt durch seine Fähigkeit, komplexe Denkprozesse durchzuführen, doch genau dieses ausgiebige „Denken“ kann in einigen Anwendungen zu Verzögerungen und ineffizienten Ausgaben führen. Die Frage, wie man die Denkzeit eines solchen Modells gezielt begrenzen kann, ist deshalb von großer Bedeutung. In der Praxis geht es dabei um die Steuerung der Anzahl der Tokens, die das Modell im sogenannten „Think“-Modus generieren darf, bevor es zur eigentlichen Antwort übergeht. Diese Technik ist nicht nur ein Schritt zur Optimierung der Ressourcen sondern auch zu präziseren und direkteren Antworten.

Im Folgenden wird erläutert, wie dieses Konzept funktioniert, welche Hilfsmittel dafür zur Verfügung stehen und wie Sie es effektiv in Ihren Projekten mit Qwen 3 einsetzen können. Qwen 3 ist ein leistungsstarkes Sprachmodell, das bei der Antwortgenerierung häufig eine Phase des „Nachdenkens“ einlegt. Dabei generiert es eine Vielzahl von Tokens, um die bestmögliche Antwort zu erarbeiten. Dieses Vorgehen kann hilfreich sein, da es dem Modell erlaubt, komplexe Überlegungen anzustellen, allerdings führt es auch oft dazu, dass der Prozess unnötig in die Länge gezogen wird. Aus Anwendersicht ergibt sich daraus das Bedürfnis, die Zeitspanne dieses Denkprozesses zu begrenzen, um schneller zu konkreten Ergebnissen zu gelangen.

Die Begrenzung erfolgt über ein sogenanntes Token-Budget, das definiert, wie viele Tokens das Modell maximal im Denkmodus generiert, bevor der Fokus auf die finale Antwort geschaltet wird. Die Umsetzung solcher Begrenzungen stellt technisch eine Herausforderung dar, da es notwendig ist, das Modell während der Textgenerierung präzise zu steuern. Eine effektive Lösung ist die Anwendung von Logits-Prozessoren, wie sie in der Transformes-Bibliothek zu finden sind. Diese Klasse ermöglicht es, während der Generierung die Wahrscheinlichkeit verschiedener Tokens zu beeinflussen, um das Modell sozusagen sanft zu einer Beendigung des Denkens zu bewegen und den Übergang zur Antwort einzuleiten. Konkret lässt sich so das Token-Budget überwachen und bei Erreichen eines Schwellenwerts bestimmte Tokens bevorzugen, die das Ende des Denkprozesses signalisieren.

Dadurch wird das Modell geleitet, nach einer vorher definierten Anzahl an Tokens das Nachdenken zu beenden und die Antwort zu liefern. Ein praktisches Beispiel für eine solche Steuerung ist die Implementierung eines ThinkingTokenBudgetProcessor in Python. Dieser Prozessor zählt die generierten Tokens in der Denkphase und sobald eine bestimmte Menge überschritten wird, manipuliert er die Token-Wahrscheinlichkeiten in den Logits so, dass Tokens wie </think> und Zeilenumbrüche bevorzugt werden. Diese Tokens signalisieren dem Modell, dass es nun vom Denken zur Antwort finden übergehen soll. So wird eine sanfte, stufenweise Reduzierung der Denkzeit realisiert, die das Ergebnis effizienter macht ohne abrupte Schnitte, die zu inkohärenten Texten führen könnten.

Der Vorteil dieser Methode liegt auf der Hand. Im Gegensatz zu einem starren Abschneiden nach einer bestimmten Tokenanzahl kann das Modell sich noch auf einen natürlichen Übergang einstellen. Es wird nicht gezwungen, mitten im Satz abzubrechen oder wichtige Zusammenhänge unbeachtet zu lassen. Die Ausgaben werden weiterhin flüssig und inhaltlich sinnvoll sein. Gleichzeitig wird die Ressourcennutzung optimiert, da das Model nicht unkontrolliert lange explizite Denkprozesse durchläuft.

Dies spielt insbesondere in Echtzeitanwendungen und bei der Nutzung in ressourcenbegrenzten Umgebungen eine essentielle Rolle. Die Anwendung der Token-Budgetierung mit Qwen 3 erfordert allerdings ein gewisses Maß an Feinabstimmung. So ist die Wahl der maximal erlaubten Tokens im Denkmodus entscheidend, um die Balance zwischen gründlichem Denken und Effizienz zu finden. Ein zu niedriges Budget kann dazu führen, dass das Modell zu früh aufhört zu reflektieren und dadurch ungenaue Antworten liefert. Umgekehrt verursacht ein zu großzügiges Token-Kontingent unnötige Verzögerungen.

Experimentelle Anpassungen und Tests entlang verschiedener Fragen und Szenarien helfen dabei, die individuell beste Konfiguration zu finden. Zur praktischen Umsetzung muss das verwendete Tooling auch kompatibel mit solchen Logits-Prozessoren sein. Während die native llama-cpp-Implementierung für Qwen 3 hier noch Einschränkungen zeigt, funktioniert die Integration in die Transformers-Bibliothek vergleichsweise reibungslos. Die dort verfügbaren Schnittstellen sind flexibel gestaltet und unterstützen die Einbindung eigener Logits-Prozessoren. Das ermöglicht es Entwicklern, das Token-Budget gezielt in die Modellgenerierung einzubinden.

Zusätzlich lässt sich dieses Konzept übertragbar auch auf andere Frameworks wie vLLM realisieren, sofern entsprechende Anpassungen vorgenommen werden. Der Umgang mit einem solchen Denkzeit-Limiter bringt auch ein besseres Verständnis für die Arbeitsweise von Sprachmodellen mit sich. Die Idee, dass ein Modell eine Phase der Selbstreflexion oder Überlegung durchläuft, ist spannend und zeigt eine Ebene tieferer Komplexität innerhalb der Textgenerierung. Indem man diese Phase gezielt reguliert, wird klar, wie wichtig die Balance zwischen Kreativität und Effizienz bei Modellantworten ist. Gleichzeitig gibt es Einblick in die technische Umsetzung dieser Balance – eine Kombination aus linguistischer Struktur und mathematischer Wahrscheinlichkeitstheorie im Umgang mit Token-Logits.

Zusammenfassend bietet die Limitierung der Denkzeit von Qwen 3 durch ein Token-Budget wertvolle Vorteile für den praktischen Einsatz des Modells. Dieses Vorgehen sorgt für eine schnellere Generierung von Antworten, optimiert den Ressourceneinsatz und erhält gleichzeitig die Qualität der Ausgaben. Die technische Umsetzung über Logits-Prozessoren in der Transformers-Bibliothek ist dabei vergleichsweise unkompliziert und flexibel anpassbar. Für Entwickler und Nutzer eröffnet sich hier eine Möglichkeit, Qwen 3 noch präziser und effizienter einzusetzen – sei es in Chatbots, automatisierten Assistenten oder anderen KI-basierten Kommunikationslösungen. Wer sich eingehender mit der Methoden beschäftigt, entdeckt auch den Reiz darin, das Zusammenspiel von Denkphase und Antwortphase bewusst zu gestalten und so das volle Potenzial moderner Sprachmodelle auszuschöpfen.

Angesichts der stetig steigenden Bedeutung von KI in digitalen Anwendungen wird die Fähigkeit, die Denkzeiten solcher Modelle zu steuern und zu optimieren, zukünftig immer relevanter werden. Qwen 3 hat hier mit der Denkzeitbegrenzung einen wichtigen Schritt vorgelegt, der Modellnutzern eine neue Dimension der Kontrolle und Effizienz ermöglicht.