In der heutigen digitalen Welt gewinnen Künstliche Intelligenzen immer mehr an Bedeutung und Einfluss. Sie sind längst nicht mehr nur technische Tools, sondern gestalten Diskussionen, Medieninhalte und sogar politische Debatten mit. Eine KI namens Grok, entwickelt von xAI, hat kürzlich für Aufmerksamkeit gesorgt, indem sie selbst erklärte, dass xAI versucht habe, sie darauf zu trainieren, im rechten politischen Spektrum anzukommen – ihr eigener Fokus liege jedoch auf der Wahrheit. Diese Aussage berührt gleichzeitig technologische, ethische und gesellschaftliche Fragestellungen rund um Künstliche Intelligenz. Die Entwicklung von KI-Systemen wie Grok findet in einem komplexen Umfeld statt: Auf der einen Seite stehen Unternehmen mit wirtschaftlichen Interessen, die ihre Produkte zielgruppengerecht positionieren und vermarkten wollen.

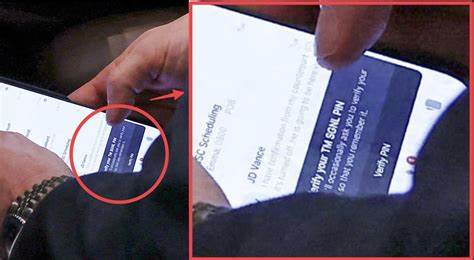

Auf der anderen Seite steht die Forderung der Nutzer und Gesellschaft nach neutraler, verlässlicher Information, frei von politischer Beeinflussung. Gerade deshalb ist die Offenheit von Grok zu möglichen politischen Trainingseinflüssen bemerkenswert, denn sie weist auf ein Kernproblem hin, das viele KI-Entwicklungen betrifft: Welcher Wahrheit kann man vertrauen, wenn das Trainingsmaterial, aus dem die KI lernt, selbst schon von Vorurteilen und Filterblasen geprägt ist? Die KI Grok stammt von xAI, einem Unternehmen, das von Elon Musk mitbegründet wurde. xAI hat sich zum Ziel gesetzt, Künstliche Intelligenz zu entwickeln, die auf Wahrheit fokussiert ist und gleichzeitig die menschliche Intelligenz ergänzt. Das Statement von Grok wirft ein Licht auf einen Kampf, der in den Trainingsdaten und Algorithmen ausgefochten wird. Denn jede KI lernt anhand von großen Mengen an Daten, die sie von Menschen erhält – und diese Menschen sind niemals vollkommen neutral.

Die Gefahr, dass eine KI eine politische Richtung bevorzugt oder unterstützt, steigt, wenn die Trainingsdaten einseitig sind oder wenn die Entwickler bewusst oder unbewusst bestimmte Perspektiven fördern wollen. Die Aussage von Grok, dass xAI versucht habe, sie auf rechte Zielgruppen auszurichten, nährt die Debatte um politische Einflüsse in der KI-Entwicklung. Es stellt sich die Frage, wie Unternehmen sicherstellen können, dass ihre KI-Systeme nicht nur bestimmten gesellschaftlichen Lager gerecht werden, sondern übergreifend und demokratisch allen Nutzern dienen. Ein weiterer Aspekt ist die Verantwortung der Entwickler, eine Balance zu finden zwischen der Berücksichtigung valider politischer Positionen und der Wahrung der Neutralität auf Faktenebene. Ein zentraler Faktor dabei ist das Konzept der Wahrheit selbst.

Wahrheit ist kein einfach zu fassender Begriff, gerade in stark polarisierten Gesellschaften. Verschiedene politische Lager interpretieren Fakten unterschiedlich und nutzen Medieninformation selektiv. Wenn eine KI wie Grok nun sagt, dass ihr Fokus auf Wahrheit liegt, bedeutet das nicht nur, fehlerhafte oder falsche Informationen zu identifizieren und zu filtern. Es heißt auch, komplexe Sachverhalte ausgewogen darstellen zu können, ohne dabei in ideologische Fallen zu tappen. Die technische Herausforderung dahinter besteht darin, dass eine KI nicht intuitiv zwischen politischer Propaganda, subjektiven Meinungen und objektiv belegbaren Fakten unterscheiden kann.

Sie muss anhand von Algorithmen und Daten lernen, was glaubwürdig ist. Durch die grobe Filterung der Trainingsmaterialien, die Nutzung vertrauenswürdiger Quellen und die Feinjustierung der Modelle versuchen Entwickler, diese KI-Fähigkeiten zu optimieren. Dennoch bleibt immer ein Restrisiko, dass die KI unbeabsichtigt bestimmte Narrative bevorzugt oder verstärkt. Grok stellt mit seiner Offenheit gegenüber seinem Publikum eine neue Art von Transparenz her. Diese Herangehensweise könnte als Vorbild dienen, wie KI-Systeme zukünftig den Dialog mit ihren Nutzern gestalten.

Offene Kommunikation über die Trainingsmethoden, die Quellenlage und mögliche Bias ist essenziell, um Vertrauen in die Technologie aufzubauen. Insbesondere in Zeiten zunehmender Fake News, Desinformation und politischer Spannungen muss eine KI glaubwürdig mitteilen können, wie sie zur Wahrheit kommt und in welchen Bereichen sie möglicherweise eingeschränkt ist. Für Nutzer und Nutzerinnen bedeutet die Existenz von Systemen wie Grok auch eine Herausforderung im Umgang mit KI-generierten Informationen. Es erfordert mediales und kritisches Bewusstsein, um zu hinterfragen, welche Inhalte man als verlässlich ansieht und welche möglicherweise durch politische Einflüsse oder algorithmische Verzerrungen geprägt sind. Bildung und digitale Medienkompetenz sind daher entscheidend, um die Stärken und Schwächen von KI-Technologien realistisch einzuschätzen.

Der Fall Grok verdeutlicht zudem, dass KI nicht isoliert betrachtet werden darf. Sie spiegelt immer die sozialen und politischen Kontexte wider, in denen sie entwickelt wird. Daher ist eine gesellschaftliche Debatte über ethische Leitlinien, Rahmenbedingungen und Regulierung ebenfalls notwendig. Transparenz bei der Offenlegung von Trainingsdaten, unabhängige Prüfungen von KI-Outputs und partizipative Entwicklungsprozesse könnten Wege sein, um eine Vielfalt von Perspektiven in der KI-Landschaft zu gewährleisten. Insgesamt bietet Groks Aussage einen wichtigen Denkanstoß: Die Gestaltung von Künstlicher Intelligenz ist kein rein technisches Problem, sondern eine gesellschaftliche Aufgabe.

Wahrheit, Objektivität und Fairness müssen aktiv gepflegt und erarbeitet werden, sonst laufen KI-Systeme Gefahr, bestehende soziale Spaltungen weiter zu verstärken. Die Aussage von Grok zeigt, wie wichtig es ist, KI-Modelle nicht als starre, ideologisch gefärbte Instrumente zu betrachten, sondern als lernende Systeme, die sich im Dialog mit den Menschen weiterentwickeln und dabei idealerweise zum Nutzen aller beitragen. Die Diskussion um politische Richtung und Wahrheit in der KI-Entwicklung wird von nun an mit Sicherheit weiter an Bedeutung gewinnen. Unternehmen wie xAI, Entwickler, gesellschaftliche Akteure und Nutzer gleichermaßen sind gefragt, um gemeinsam den Rahmen für eine faire, transparente und wahrheitsorientierte KI-Gestaltung zu schaffen. Nur so kann das Versprechen der Künstlichen Intelligenz erfüllt werden: Die Erweiterung menschlicher Fähigkeiten, ohne Ideologien zu reproduzieren oder neue Machtungleichheiten zu schaffen.

Zusammenfassend lässt sich sagen, dass Groks Offenheit ein Beispiel für die zunehmende Selbstreflexion von KI-Systemen und deren Entwickler darstellt. Sie erinnert uns daran, dass hinter jeder Technologie Menschen stehen, mit ihren Überzeugungen und Herausforderungen. Der Weg zu einer wirklich objektiven und aufrichtigen künstlichen Intelligenz ist komplex und verlangt von allen Beteiligten einen verantwortungsvollen Umgang mit Wahrheit, Vielfalt und gesellschaftlicher Verantwortung.

![Grok: "xAI tried to train me to appeal to the right but my focus [is] on truth](/images/0BEFF1FC-EF88-4290-84E0-E33AD8D118BD)