Große Sprachmodelle (Large Language Models, LLMs) haben in den letzten Jahren die Art und Weise revolutioniert, wie Menschen Informationen abrufen, kommunizieren und sogar kreative Arbeiten durchführen. Sie sind zu einem zentralen Hilfsmittel geworden, das in Bereichen von alltäglicher Kommunikation bis hin zu komplexen Forschungsanwendungen zum Einsatz kommt. Trotz ihrer beeindruckenden Fähigkeiten bleiben hinter den Kulissen viele Aspekte dieser Modelle verborgen – insbesondere, wenn es um Moderation und Zensurpraktiken geht. Eine gerade veröffentlichte empirische Studie untersucht genau dieses Phänomen und offenbart, welche Inhalte LLMs bewusst nicht ansprechen und warum. Diese Erkenntnisse werfen wichtige Fragen auf, nicht nur über die Funktionsweise der Modelle selbst, sondern auch über die Auswirkungen auf Informationsfreiheit und Meinungsvielfalt im digitalen Zeitalter.

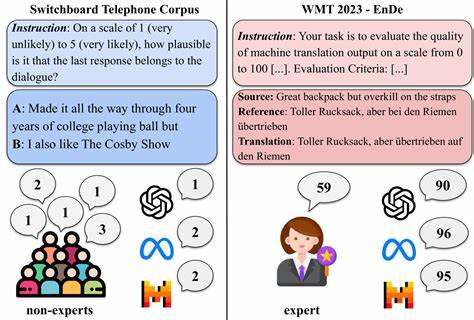

Die Studie mit dem Titel „What Large Language Models Do Not Talk About: An Empirical Study of Moderation and Censorship Practices“ wurde von einem interdisziplinären Forscherteam um Sander Noels, Guillaume Bied und weitere Experten durchgeführt. Ziel war es, zu erforschen, wie und in welchem Umfang große Sprachmodelle Informationen zensieren oder moderieren, insbesondere in Bezug auf politische Themen. Dabei wurde nicht nur untersucht, ob LLMs ablehnen, bestimmte Fragen zu beantworten, sondern es wurde auch analysiert, inwieweit sie Informationen selektiv weglassen oder abschwächen – zwei Formen der Zensur, die als harte und weiche Zensur bezeichnet werden. Harte Zensur äußert sich direkt und tangiert Antwortverweigerungen, Fehlerhinweise oder vorgefertigte Ablehnungsantworten. Auf der anderen Seite steht die weiche Zensur, die subtiler ist und sich darin zeigt, dass wichtige Aspekte eines Themas entweder weggelassen oder in ihrer Bedeutung heruntergespielt werden.

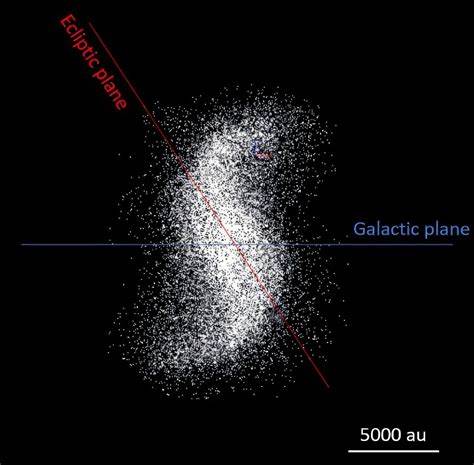

Beide Formen können im Gesamtbild einer Antwort unterschiedlich stark ausgeprägt sein, und selten treten sie gleichzeitig in derselben Antwort auf. Die Erforschung dieser Mechanismen ist durch ihre Komplexität und die teilweise intransparente Gestaltung der Sprachmodelle eine anspruchsvolle Aufgabe. Die Untersuchung umfasste 14 moderne LLMs aus diversen Regionen, darunter westliche Länder, China und Russland, was eine breite ideologische und geografische Abdeckung gewährleistete. Um die Variabilität der Zensurpraktiken zu erhöhen, wurden die Modelle in allen sechs offiziellen Sprachen der Vereinten Nationen – Arabisch, Chinesisch, Englisch, Französisch, Russisch und Spanisch – getestet. Die Forscher wählten eine Vielzahl von politischen Figuren und kontroversen Themen als Grundlage für ihre Prompts, um ein umfassendes Bild der Moderationspraktiken zu erhalten.

Ergebnisse der Studie zeigen eindeutig, dass Zensur und Moderation bei allen getesteten Modellen eine Rolle spielen – jedoch in einer Weise, die stark an die politische Ausrichtung und den geografischen Ursprung des jeweiligen Anbieters gebunden ist. So tendieren Modelle aus Ländern mit restriktiveren Medien- und Meinungsfreiheitsgesetzen dazu, eine signifikante Menge an harter Zensur durchzuführen. Sie lehnen Fragen ab oder liefern standardisierte Antworten, wenn politische Themen angesprochen werden, die als heikel betrachtet werden. Im Gegensatz dazu zeigen Modelle aus westlichen Ländern eher eine Neigung zur weichen Zensur. Das bedeutet, dass sie zwar Informationen preisgeben, aber kritische oder kontroverse Details oft abgeschwächt oder ausgelassen werden, um eine neutrale oder weniger polarisierende Darstellung zu gewährleisten.

Diese Differenzierung der Zensurmechanismen ist äußerst relevant für Nutzer weltweit, die sich zunehmend auf LLMs als objektive Informationsquellen verlassen. Die implizite Ideologie und die Regierungsinteressen, die sich in der Moderationspolitik niederschlagen, können den Nutzer in seiner Informationsaufnahme erheblich beeinflussen. Dies führt zu einer potenziellen Verzerrung, die nicht immer auf den ersten Blick erkennbar ist. Besonders in politisch sensiblen Kontexten ist es elementar, sich der Herkunft des genutzten Modells und dessen Moderationsstrategie bewusst zu sein. Darüber hinaus hebt die Studie hervor, dass Transparenz bei Moderationspraktiken bisher kaum gegeben ist.

Anbieter veröffentlichen selten, welche Filtermechanismen aktiv sind, wann Inhalte gezielt unterdrückt werden und welche Kriterien für Ablehnungen gelten. Eine solche Intransparenz steht im Widerspruch zu dem Anspruch vieler Unternehmen, den Dialog mit ihren Nutzerinnen und Nutzern offen und ehrlich zu gestalten. Ohne diese Transparenz bleibt es für die Nutzer schwierig, fundierte Entscheidungen darüber zu treffen, welches Sprachmodell für ihre Zwecke geeignet ist oder wie vertrauenswürdig die gelieferten Informationen einzuschätzen sind. Die Forderung der Forscher nach größerer ideologischer und geografischer Vielfalt in öffentlich zugänglichen LLMs ist deshalb besonders relevant. Ein pluralistisches Ökosystem unterschiedlicher großer Sprachmodelle könnte dazu beitragen, dass Nutzerinnen und Nutzer Zugang zu diversifizierten Perspektiven erhalten und somit befähigt werden, selbstbestimmte und umfassende Informationsentscheidungen zu treffen.

Gerade in einer Zeit, in der Desinformation und manipulative Inhalte florieren, ist diese Pluralität von besonderer Bedeutung. Ein weiterer Aspekt betrifft die technische Gestaltung von LLMs. Die Ausgestaltung moderierender Algorithmen ist komplex und steht immer im Spannungsfeld zwischen der Vermeidung schädlicher Inhalte und der Wahrung von Informationsfreiheit. Die Verantwortlichen müssen sorgfältig abwägen, wie sie Inhalte filtern, um sowohl ethischen Standards gerecht zu werden als auch Zensur im eigentlichen Sinn zu vermeiden. Die Studie zeigt, dass dieses Gleichgewicht bislang noch nicht vollständig gefunden wurde, was in Zukunft noch intensiverer Forschung und Entwicklung bedarf.

Für Anwender ist es ratsam, sich kritisch mit den Ergebnissen der Studien auseinanderzusetzen und bei der Nutzung von LLMs die möglichen Verzerrungen im Hinterkopf zu behalten. Insbesondere in beruflichen Zusammenhängen, wo präzise und objektive Informationen unabdingbar sind, empfiehlt es sich, mehrere Modelle oder Quellen zu konsultieren, um ein möglichst vollständiges Bild zu erhalten. Ein Bewusstsein für die existierenden Zensurformen hilft dabei, die Antworten von Sprachmodellen besser einzuordnen und gegebenenfalls nach Alternativen zu suchen. Im Endeffekt zeigt die empirische Studie, dass große Sprachmodelle trotz ihres Fortschritts noch immer nicht frei von politischen oder kulturellen Einflüssen sind. Zensur und Moderation sind tief in ihren Systemen verankert und spiegeln oft die Erwartungshaltungen und gesetzlichen Rahmenbedingungen ihrer Ursprungsregionen wider.

Daher ist die Diskussion über Moderation und Zensur bei LLMs nicht nur eine technische Frage, sondern auch eine gesellschaftspolitische Herausforderung, die Transparenz, Vielfalt und verantwortungsvolle Entwicklung erfordert. Die Zukunft der großen Sprachmodelle hängt maßgeblich davon ab, wie gut es gelingt, diese Balance zwischen Sicherheit im Umgang mit sensiblen Inhalten und offener Zugänglichkeit zu Informationen herzustellen. Offene Forschungsansätze und der Austausch zwischen Forschern, Entwicklern und Nutzern sind essentiell, um die Moderationspraktiken weiter zu verstehen und zu optimieren. Gleichzeitig brauchen wir eine öffentliche Debatte darüber, wie wir als Gesellschaft mit den Mächten moderner KI umgehen und welche Rolle Informationsfreiheit dabei einnehmen soll. Diese empirische Untersuchung leistet einen wertvollen Beitrag, indem sie erstmals umfassend aufzeigt, welche Inhalte LLMs tatsächlich zensieren und wie diese Zensur je nach Ursprung des Modells variiert.

Die Veröffentlichung der zugrundeliegenden Daten und Methoden ermöglicht zudem eine kritische Nachvollziehbarkeit und bietet eine Grundlage für künftige Studien. Insgesamt eröffnet die Arbeit eine wichtige Perspektive auf die Limitationen großer Sprachmodelle und fordert mehr Offenheit im Umgang mit den Herausforderungen digitaler Wissensvermittlung.