Die Wissenschaft, wie wir sie kennen, befindet sich an einem Wendepunkt. Mit dem Einzug digitaler Technologien und innovativer Kommunikationsplattformen öffnen sich traditionelle Forschungsprozesse, und eine neue Ära der Echtzeitforschung beginnt. Real Time Science beschreibt eine Herangehensweise, bei der wissenschaftliche Erkenntnisse nahezu unmittelbar im Entstehen festgehalten, geteilt und gemeinsam weiterentwickelt werden. Dieser Wandel hat nicht nur das Potenzial, den Fortschritt zu beschleunigen, sondern verändert auch grundlegend, wie Forscher, Institutionen und die Öffentlichkeit miteinander interagieren. Historisch gesehen verlief wissenschaftliche Forschung oft linear und verschlossen.

Erkenntnisse wurden in akribischen Experimenten gesammelt, die Resultate lange Zeit im Verborgenen gehalten und erst nach umfangreicher Prüfung in wissenschaftlichen Journalen veröffentlicht. Dieser klassische Ansatz – repräsentiert durch präzise formulierte Artikel – tendierte dazu, die komplexe und oft chaotische Wirklichkeit von Experimenten zu glätten. Die zahlreichen Zwischenstufen, gescheiterte Versuche und kleinen Umwege verschwanden meist im Schatten, und nur die „perfekten“ Ergebnisse fanden Eingang in die wissenschaftliche Literatur. Dabei ist gerade das, was in den Labornotizen, privaten Korrespondenzen oder informellen Austauschkanälen steht, von unschätzbarem Wert. Diese verborgenen Informationen enthalten Erkenntnisse aus Fehlschlägen, innovative Anpassungen von Methoden und viele kleine Verbesserungen, die den eigentlichen Fortschritt ermöglichen.

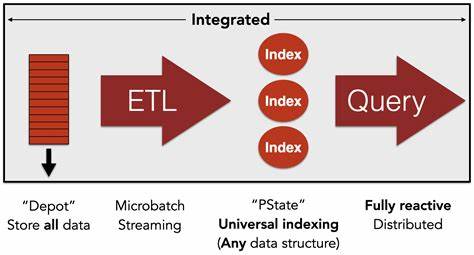

Ihre Dokumentation in Echtzeit und der offene Austausch machen Wissen nicht nur zugänglicher, sondern helfen auch, teure und zeitraubende Wiederholungen überflüssig zu machen. Ein historisches Beispiel veranschaulicht diese Problematik sehr gut: Friedrich Miescher, ein Pionier der Molekularbiologie, isolierte 1869 erstmals das, was wir heute als DNA kennen. Obwohl seine Entdeckung revolutionär war, wurden seine waghalsigen Hypothesen zur Rolle von „Nuclein“ in der Vererbung lange Zeit nicht beachtet, weil sie nur in privaten Notizen festgehalten wurden. Wäre seine Arbeit damals offener und zeitnaher geteilt worden, hätte die genetische Forschung wohl mehrere Jahrzehnte früher einen bedeutenden Sprung nach vorn gemacht. Die Entwicklung moderner Tools und Plattformen erlaubt heute erstmals eine nahtlose Dokumentation von Forschungsabläufen, die von einfachen Notizen bis hin zu komplexen Datenanalysen reicht.

Solche Echtzeitlabornotizen ermöglichen es Forschern, ihre Ideen, Methoden und Zwischenergebnisse zeitnah zu veröffentlichen. Dies schafft nicht nur Transparenz, sondern öffnet die Tür für unmittelbares Feedback und kollaborative Problemlösungen. Wenn beispielsweise ein Biologe an einer PCR-Optimierung arbeitet und seine experimentellen Einstellungen oder Probleme direkt dokumentiert, können andere Wissenschaftler weltweit von diesen Informationen profitieren und ähnliche Probleme schneller lösen. Der Ansatz der Real Time Science fördert außerdem das Zusammenwirken von „Mikro-Expertisen“. Diese konzentrierte, oft sehr spezielle Fachkenntnis einzelner Wissenschaftler lässt sich durch offene Online-Plattformen viel effektiver bündeln.

Das Phänomen wurde unter anderem durch das Polymath-Projekt illustriert, bei dem eine komplexe mathematische Fragestellung öffentlich und kollaborativ in einem Blog gelöst wurde. Innerhalb weniger Wochen konnten durch die vielen Ideen und Beiträge von Forschern aus aller Welt bedeutende Fortschritte erzielt werden. Derartige Gemeinschaftsprojekte kombinieren die Vorteile breiter Expertenteilnahme mit klarer Struktur und aktiver Moderation, was den Prozess sowohl produktiv als auch fokussiert macht. Trotz dieser Vorteile gibt es beim Konzept der Echtzeitforschung auch Herausforderungen. Nicht jede wissenschaftliche Frage lässt sich in wohldefinierte, parallel bearbeitbare Teilaufgaben zerlegen.

Manche Disziplinen oder Fragestellungen benötigen intensives, tiefgründiges Nachdenken, das unter Umständen nicht gut mit der Offenheit des kollaborativen Austausches harmoniert. Dennoch zeigt der Erfolg von Projekten wie Polymath, dass viele wissenschaftliche Probleme durch eine geeignete Infrastruktur der Zusammenarbeit beschleunigt und verbessert werden können. Im Bereich der Softwareentwicklung hat sich GitHub als Paradebeispiel für offene, vernetzte Kollaboration etabliert. Hier werden alle Schritte – von der Problemidentifikation über den Vorschlag von Lösungen bis zur Umsetzung – transparent dokumentiert. Dieses Modell bietet der Wissenschaft wertvolle Anregungen, denn es bewahrt eine ganze „Archäologie“ der Problemlösung, anstatt nur das fertige Endergebnis zu liefern.

Entsprechende Plattformen für wissenschaftliche Forschung könnten die gleichen Prinzipien übernehmen und damit die Expertensuche, die Diskussionsprozesse und die Weiterentwicklung von Ideen verbessern. Der Engpass wissenschaftlichen Fortschritts liegt oft nicht am Mangel an Ideen, sondern an der Verfügbarkeit von ExpertInnen, die ihre Aufmerksamkeit gezielt auf die passenden Probleme richten. Die Umstrukturierung der Zuweisung dieser „Expertenaufmerksamkeit“ könnte ein Schlüsselfaktor im Innovationsprozess sein. Indem Probleme und Lösungen öffentlich sichtbar sind, können Wissenschaftler gezielt jene Themen entdecken, bei denen ihre Expertise einen entscheidenden Unterschied macht. Neben der technischen Infrastruktur ist auch ein kultureller Wandel notwendig.

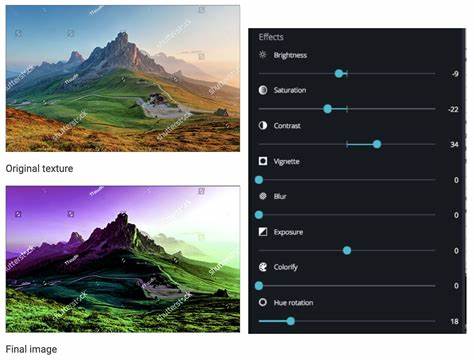

In klassischen Systemen wird wissenschaftliche Produktivität vor allem an der Anzahl und Qualität von Veröffentlichungen gemessen. Dieses Bewertungssystem überschätzt häufig nur „erfolgreiche“ Ergebnisse und ignoriert den Wert von gescheiterten Versuchen oder von methodischem Wissen. Die Einführung von offenen Labornotizsystemen, in denen auch negative Resultate dokumentiert und sichtbar gemacht werden, kann eine vollkommen neue Metrik quer durch Disziplinen etablieren: die „Fläche des geteilten Wissens“. Diese Kennzahl ergäbe sich aus der Summe aller geteilter Informationen, egal ob sie durch Erfolg oder Misserfolg entstanden sind. Ein solches System würde insbesondere junge Forschende enorm entlasten.

Der Einstieg in die wissenschaftliche Karriere ist oft geprägt von einem hohen Risiko, jahrelang an Projekten zu arbeiten, die nicht zum gewünschten Publikationserfolg führen. Die Angst vor dem Scheitern führt häufig zu zurückhaltenden Themenstellungen und einem Fokus auf sichere, inkrementelle Fortschritte. Offene Echtzeitforschung könnte diese Dynamik verändern, indem sie auch ambitionierte und risikoreiche Projekte als wertvoll erkennt und öffentlich sichtbar macht. Die Förderung von PhD-Studierenden und NachwuchswissenschaftlerInnen, die bereits bereit sind, transparent zu arbeiten und offen zu forschen, ist ein vielversprechender Ansatz. Spezielle Fellowships könnten diesen Forschenden flexible finanzielle und strukturelle Unterstützung bieten, ohne den Druck, ausschließlich „publizierbare“ Ergebnisse zu liefern.

So wird das Experimentieren im offenen Raum zur neuen Norm, und die Wissenschaft wird dynamischer und inklusiver. Die Zeit ist dafür reif: Das Internet ermöglicht mittlerweile schnelle und breite Vernetzung, Sprachmodelle helfen bei der semantischen Suche durch unüberschaubare Datenmengen, und eine wachsende Zahl von ForscherInnen verlangt nach mehr Transparenz und Zusammenarbeit. Die Krise traditioneller Förderstrukturen eröffnet außerdem einen nötigen Anreiz für neue Ansätze. Echtzeitforschung ist mehr als nur eine technische Innovation. Sie stellt das Bild von Wissenschaft als streng kontrolliertem, abgeschlossenen Prozess auf den Kopf und bringt den Menschen mit seinen Misserfolgen, Entdeckungen, Unsicherheiten und kreativen Impulsen wieder ins Zentrum.