Im Zeitalter der künstlichen Intelligenz gewinnt die Automatisierung von Software-Engineering-Prozessen zunehmend an Bedeutung. Insbesondere Software Engineering Agenten, die komplexe Aufgaben autonom lösen, stehen im Fokus moderner Forschung und Entwicklung. Ein entscheidender Faktor für die Leistungssteigerung dieser Agenten ist die Qualität der Suchstrategien, mit denen sie Lösungen generieren und bewerten. In diesem Kontext haben sich sogenannte Reasoning Critics als vielversprechende Methode herauskristallisiert, um parallele Suchalgorithmen effizienter und robuster zu gestalten. Traditionell basieren viele Software Engineering Agenten auf regressionsbasierten Kritiker-Modellen, die in einem einzigen Vorwärtsschritt ganze Lösungswege oder Trajektorien bewerten.

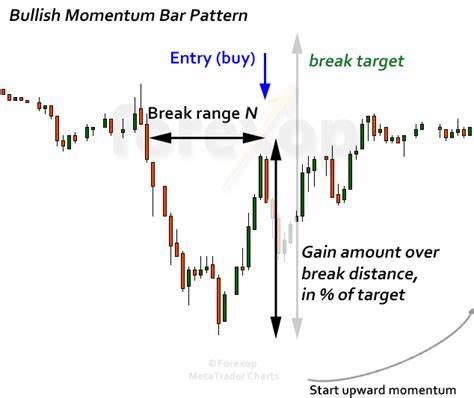

Diese Herangehensweise kann einer schnellen Einschätzung gleichkommen, so als ob jemand einen Lösungsweg nur oberflächlich betrachtet und ohne tiefere Analyse beurteilt. Obwohl diese Methode gewisse Fortschritte ermöglicht hat, stößt sie bei komplexeren Problemen an ihre Grenzen. Regression-basierte Kritiker sind anfällig für adversarielle Beispiele, die zu Fehlbewertungen führen können, was die Suche ineffizient macht und mit steigendem Suchumfang sogar die Qualitätsleistung senkt. Das Problem der adversariellen Beispiele zeigt sich besonders bei paralleler Suche und Lookahead-Suchverfahren. Wenn der Suchalgorithmus zahlreiche mögliche Lösungswege systematisch durchforstet, wird die Wahrscheinlichkeit größer, dass solche irreführenden Beispiele ausgewählt werden.

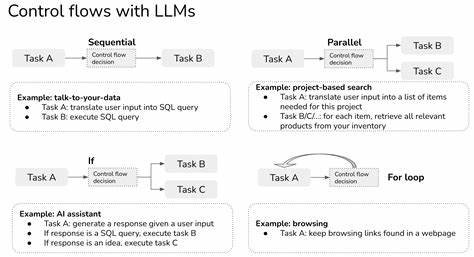

Das führt oft zu paradoxen Effekten, bei denen mehr Suchvorgänge die Qualität der Auswahl verschlechtern oder zu sogenannten Value-Hacking-Phänomenen führen, bei denen die vorhergesagten Qualitätswerte ohne tatsächliche Verbesserung der Ergebnisqualität steigen. Um diesen Einschränkungen zu begegnen, wurde das Konzept der Reasoning Critics entwickelt. Statt auf einfache Regression zu setzen, nutzen Reasoning Critics die Macht großer Sprachmodelle, um durch eine verkettete Gedankenführung (Chain of Thought) den Lösungsweg in seiner Gesamtheit zu hinterfragen, kritisch zu analysieren und zu bewerten. Die Idee dahinter ist, nicht nur ein schnelles Urteil zu fällen, sondern die einzelnen Zwischenschritte systematisch zu begründen und somit Fehler oder Schwächen in der Lösung transparent zu machen. Ein grundlegender Vorteil von Reasoning Critics liegt in ihrer Fähigkeit, konditionale und adaptive Überprüfungen vorzunehmen.

Das bedeutet, dass sie je nach Komplexität des Problems oder der vorliegenden Teilschritte den Bewertungsprozess anpassen können. Diese Flexibilität sorgt nicht nur für robustere Entscheidungen, sondern macht das Modell auch widerstandsfähiger gegen adversarielle Beispiele und allgemein gegen Out-of-Distribution-Daten, also gegen solche Instanzen, die im Training nicht vorkamen. Der Aufbau solcher Reasoning Critics erfolgt in mehreren Schritten. Zunächst werden vorhandene Agenten-Trajektorien mithilfe eines Promptings an leistungsfähige Sprachmodelle übergeben, die auf Chain-of-Thought-Logik trainiert wurden. Diese Modelle erzeugen für jede Lösung eine nachvollziehbare Argumentationskette, die anschließend als Grundlage für die Bewertung dient.

Allerdings hat sich gezeigt, dass allein das Prompting oft zu optimistisch ist, da das Modell eher geneigt ist, eine Lösung als korrekt einzustufen, ohne alle potenziellen Fehlerquellen zu erkennen. Um dieses Problem zu beheben, kommt verstärkendes Lernen (Reinforcement Learning) ins Spiel. Durch gezieltes Feinjustieren der Modelle mit einem belohnungsbasierten System kann die Balance zwischen Präzision und Recall besser eingestellt werden. Besonders effektiv sind dabei Trainingsstrategien, die Fehlalarme (fälschliche Akzeptanz fehlerhafter Lösungen) stärker bestrafen als False Negatives (bergaben falscher Ablehnung), um die Zuverlässigkeit der Entscheidungen zu verbessern. Die praktischen Auswirkungen dieser Ansätze sind beachtlich.

Reasoning Critics ermöglichen es, parallele Suchprozesse deutlich besser zu skalieren, indem sie aus einer Vielzahl von Agenten-Trajektorien die tatsächlich erfolgversprechenden Lösungen sicherer identifizieren. Dabei profitieren sie von der Möglichkeit, ihre Bewertungen durch mehrfaches Sampling von Chain-of-Thought-Antworten zu verfeinern. Studien zeigen, dass bereits bis zu zwanzig Bewertungsdurchläufe zu einem Sättigungseffekt bei der Genauigkeit führen – was ein flexibles Skalieren der Testzeit erlaubt. Darüber hinaus bietet die Verwendung von Reasoning Critics eine höhere Interpretierbarkeit und Nachvollziehbarkeit der Entscheidungen gegenüber rein regressionsbasierten Modellen. Für Entwickler und Forscher ist dies ein wertvoller Vorteil, da es erleichtert, warum ein bestimmter Lösungsweg bevorzugt oder verworfen wurde, und damit auch gezielte Verbesserungen an Agenten-Systemen fördert.

Ein weiterer Vorteil ist die verbesserte Robustheit gegenüber Szenarien außerhalb des Trainingsdatensatzes. Untersuchungen mit verschiedenartigen Agenten-Scaffoldings und Policies haben gezeigt, dass Reasoning Critics gerade bei Out-of-Distribution-Daten bessere Auswahlleistungen erzielen als klassische Regression-Kritiker. Diese Eigenschaft erhöht die Praktikabilität in realen Anwendungen, wo sich Umgebungen und Anforderungen stetig verändern. Nichtsdestowenig ist es wichtig zu erwähnen, dass auch Reasoning Critics keine Wunderwaffe sind. In vielen analysierten Fehlerfällen fehlt schlicht die notwendige Information in den Agenten-Trajektorien, damit der Kritiker eine korrekte Bewertung vornehmen kann.

Das bedeutet, dass in manchen Fällen erst erweiterte Verfahren wie Ausführungstests oder agentenseitige Validierungen entscheidende Verbesserungen ermöglichen können. Dennoch stellen Reasoning Critics einen bedeutenden Fortschritt dar, der mittelfristig die Entwicklung noch leistungsfähigerer Software Engineering Agenten beschleunigen wird. Auf technischer Ebene sind diese Fortschritte auch deshalb interessant, weil die zusätzlichen Rechenressourcen, die für Chain-of-Thought-Bewertungen benötigt werden, im Vergleich zu reinen Regressionsansätzen moderat sind. Der Großteil der Rechenzeit entfällt weiterhin auf das Einbetten und Analysieren der Trajektorie selbst. Dies macht den Einsatz von Reasoning Critics auch wirtschaftlich vertretbar und attraktiv für den praktischen Einsatz.

Zukunftsorientiert eröffnen sich mit Reasoning Critics spannende Perspektiven. Beispielsweise besteht die Möglichkeit, sie nicht nur zur Ergebnisbewertung, sondern auch zur Prozessüberwachung während der Lösungsfindung einzusetzen. Hierbei müssten geeignete Belohnungsmechanismen entwickelt werden, um gute Teilschritte und Aktionen zu identifizieren und zu fördern. Zudem kann die Kombination von Reasoning Critics mit anderen Prüfverfahren, etwa formalen Verifikationen oder Testausführungen, die Gesamtqualität der Agentensysteme weiter steigern. Zusammenfassend sind Reasoning Critics ein innovativer Meilenstein auf dem Weg zu autonomeren und leistungsfähigeren Software Engineering Agenten.

Sie bieten einen Ansatz, der durch strukturierte, interpretierbare Entscheidungsprozesse parallele Suchen signifikant verbessert und gleichzeitig resilienter gegen Fehlerquellen ist. Die dadurch erreichbare höhere Zuverlässigkeit und Qualität der automatisierten Lösungen ist ein wichtiger Beitrag zur Weiterentwicklung intelligenter Softwareentwicklungstools. Die Integration solcher fortschrittlichen Kritiker in zukünftige Agenten-Systeme wird entscheidend dafür sein, wie schnell und zuverlässig komplexe Softwareprobleme automatisiert gelöst werden können. Besonders angesichts wachsender Komplexität moderner Softwarelandschaften ist der Bedarf an solchen Technologien hoch. Reasoning Critics dienen somit als Schlüsseltechnologie, um in der Softwareentwicklung neue Effizienz- und Qualitätsstandards zu setzen.

Ihre Weiterentwicklung und Verbreitung wird einen nachhaltigen Einfluss darauf haben, wie Softwareagenten in der Praxis eingesetzt und weiterentwickelt werden.