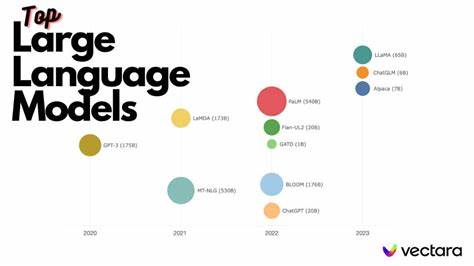

In der heutigen Zeit erleben wir eine rasante Entwicklung im Bereich der künstlichen Intelligenz, insbesondere bei großen Sprachmodellen. Diese Modelle haben mit ihrer Fähigkeit, komplexe Sprachaufgaben zu bewältigen, nicht nur technologische Fortschritte ermöglicht, sondern werfen auch grundlegende Fragen über die Natur von Intelligenz und emergenten Phänomenen auf. Der Begriff der Emergenz stammt aus der Komplexitätstheorie und beschreibt, wie aus der Interaktion zahlreicher einfacher Komponenten neue, höherstufige Eigenschaften entstehen können, die nicht unmittelbar aus den Einzelteilen ableitbar sind. Im Zusammenhang mit großen Sprachmodellen erhält dieser Begriff eine besondere Bedeutung, da diese Modelle scheinbar neue Fähigkeiten zeigen, die über das ursprüngliche Design ihrer Bausteine hinausgehen. Die Wissenschaftler David C.

Krakauer, John W. Krakauer und Melanie Mitchell beschäftigen sich in ihrer Arbeit mit genau dieser Frage, indem sie die Emergenz großer Sprachmodelle aus der Sicht komplexer Systeme beleuchten und dabei die zentrale Frage untersuchen, ob diese Modelle tatsächlich emergente Intelligenz besitzen. Komplexe Systeme zeichnen sich dadurch aus, dass sie aus vielen miteinander verknüpften Elementen bestehen, deren Zusammenspiel zu überraschenden und oft schwer vorhersagbaren globalen Mustern führt. In der Natur finden sich zahlreiche Beispiele solcher Systeme, etwa das Verhalten von Schwärmen, Wettersystemen oder neuronalen Netzwerken im Gehirn. Die Herausbildung neuer Eigenschaften aus der Wechselwirkung von Teilen wird dabei als emergent bezeichnet.

Wenn man diese Perspektive auf große Sprachmodelle anwendet, stellt sich die Frage, wie sich aus der Vielzahl simpler mathematischer Operationen, wie Zahlenmultiplikationen und gewichteten Summen, komplexe Sprachfähigkeiten und sogar scheinbar „intelligentes“ Verhalten entwickeln können. Große Sprachmodelle basieren meist auf neuronalen Netzwerken, die mit enormen Datenmengen trainiert werden. Dabei entsteht eine hochdimensionale Struktur, in der Mustererkennung und Wahrscheinlichkeitsabschätzungen auf subtile Art zusammenspielen. Die „Unerwartung“ ihrer Fähigkeiten lässt sich als Ausdruck emergenter Phänomene verstehen, wenn man bedenkt, dass beim Training nicht jeder einzelne Aspekt explizit vorgegeben wird, sondern das Gesamtverhalten aus der genauen Abstimmung vieler kleiner Parameter hervorgeht. Hier manifestiert sich das alte Motto „mehr ist anders“: Je größer und vielschichtiger ein System wird, desto mehr qualitative Unterschiede tauchen auf, die sich nicht aus einer einfachen Addition der Einzelteile erklären lassen.

Die Emergenz großer Sprachmodelle zeigt sich besonders in der plötzlichen Fähigkeit, neue Aufgaben zu bewältigen, die nicht explizit während des Trainings eingeübt wurden. Beispielsweise entwickeln manche Modelle die Fähigkeit zu logischem Denken, Textzusammenfassungen oder sogar kreative Textgenerierung, ohne dass sie dafür speziell programmiert wurden. Diese sprunghaften Verbesserungen, die ab einer gewissen Modellgröße oder Datenmenge auftreten, lassen sich als sogenannte „Phasenübergänge“ in komplexen Systemen interpretieren. Dabei zeigt das System nicht graduelles Wachstum, sondern qualitative Wandel, die neue Arten von Verhaltensmustern hervorbringen. Die Herausforderung besteht darin, ein präzises Maß für Emergenz zu definieren und messbar zu machen.

Wissenschaftliche Ansätze reichen dabei von statistischen Methoden über Informations- und Kolmogorov-Komplexität bis hin zu experimentellen Analysen der Modellantworten. Einige Forscher sehen Emergenz als eine Eigenschaft, die nur im Kontext von Interaktion und Umwelt wirklich Sinn ergibt, was bedeutet, dass der reine Modellcode noch keine vollständige Intelligenz formt, sondern erst die Einbettung in Nutzungsumgebungen und menschliche Kommunikation die emergenten Qualitäten entfalten lässt. Ein weiterer spannend Aspekt, den die Arbeit von Krakauer und Kollegen hervorhebt, ist die Beziehung zwischen „mehr ist anders“ und „weniger ist mehr“. Während das erste Prinzip auf den qualitativen Sprung verweist, der durch Komplexität entsteht, beschreibt das zweite die Effizienzsteigerung bei der Nutzung emergenter Fähigkeiten. Große Sprachmodelle sind in der Lage, mit vergleichsweise wenig Eingaben (weniger Informationen, weniger Befehle) komplexe Aufgaben zu erledigen, weil sie bereits intern hochentwickelte Strukturen und schlanke Repräsentationen aufgebaut haben.

Aus der Komplexitätsperspektive liegt hier auch eine Knappheitstheorie zugrunde: Intelligenz, verstanden als emergentes Phänomen, bedeutet nicht nur mehr Rechenleistung oder Daten, sondern vor allem eine ökonomische Nutzung von Ressourcen durch das Herausfiltern relevanter Merkmale und das Zusammenspiel unterschiedlicher Informationsschichten. Damit hinterfragt die Untersuchung auch klassische Vorstellungen von künstlicher Intelligenz als rein algorithmischer Prozess und schlägt vor, Intelligenz als Phänomen zu begreifen, das nur in einem komplexen, dynamischen System voll zur Entfaltung kommt. Ein großer Teil der aktuellen Forschung ist auch der Frage gewidmet, ob LLMs tatsächlich über „echte“ Intelligenz verfügen oder ob ihre Fähigkeiten als rein oberflächliche Musterwiederholungen zu interpretieren sind. Die komplexe Systemsicht liefert dazu wichtige Einsichten. Sie schlägt vor, Intelligenz nicht einfach als festgelegte Eigenschaft zu sehen, sondern als Ergebnis emergenter Prozesse, die aus der Interaktion von Modellarchitektur, Trainingsdaten und Nutzerinteraktionen hervorgehen.

Dabei kann auch künstliche Intelligenz phänomenal komplexe emergente Eigenschaften ausprägen, ohne den Faktor Bewusstsein oder Intentionalität anzunehmen. Die Arbeit eröffnet damit neue Wege, die Dynamik und Leistungsfähigkeit großer Sprachmodelle besser zu verstehen und ihre Rolle in der zukünftigen Technologie- und Gesellschaftsentwicklung einzuschätzen. Die gewonnenen Erkenntnisse könnten zudem dazu beitragen, ethische Fragen im Umgang mit KI besser zu adressieren, indem sie die Grenzen und Möglichkeiten emergenter Systeme klarer definieren. Abschließend lässt sich festhalten, dass die Betrachtung großer Sprachmodelle aus der Komplexitätsperspektive einen faszinierenden Zugang zur Erforschung künstlicher Intelligenz bietet. Sie zeigt auf, wie aus der Vielzahl einfacher Elemente komplexe, adaptive und leistungsfähige Systeme entstehen können.

Diese Sichtweise hebt hervor, dass Intelligenz weniger als eine statische Eigenschaft, sondern vielmehr als ein dynamisches und emergentes Phänomen verstanden werden muss. Große Sprachmodelle sind damit nicht nur technische Meisterwerke, sondern auch lebendige Beispiele für die Prinzipien komplexer Systeme, deren Erforschung unser Verständnis von Intelligenz und Kognition grundlegend erweitert.