Die Wahl der richtigen Datenbank ist ein zentraler Faktor für den Erfolg moderner Softwareprojekte. Besonders Unternehmen, die mit großen Datenmengen und komplexen Abfragen arbeiten, stehen oft vor der Entscheidung, ob sie auf skalierbare, verteilte Systeme oder auf bewährte relationale Datenbanklösungen setzen sollen. In den letzten Jahren hat sich PostgreSQL als eine der leistungsfähigsten, flexibelsten und wirtschaftlichsten Datenbanken etabliert, weshalb immer mehr Firmen ihre Datenbanklandschaft zu PostgreSQL migrieren. Die Migration zu PostgreSQL birgt sowohl Chancen als auch Herausforderungen, die es zu bewältigen gilt. Dieser Beitrag liefert einen fundierten Überblick über die Gründe für eine Migration, typische Stolpersteine sowie praktische Lösungsansätze, um einen reibungslosen Übergang zu gewährleisten.

Unternehmen, die bisher auf verteilte Datenbanken wie CockroachDB gesetzt haben, schätzen zwar deren Vorteile wie horizontale Skalierung und hohe Verfügbarkeit, stoßen im Alltag jedoch häufig auf Einschränkungen. So kann die Kostenentwicklung bei Cloud-basierten verteilten Systemen stark ansteigen, insbesondere wenn die Anforderungen an Multi-Region-Setups und DSGVO-konforme Datenlokalisierung noch nicht akut sind. Des Weiteren zeigen sich immer wieder Performance-Probleme, die durch Timeout-Fehler bei größeren Datenmigrationen oder komplexen Abfragen entstehen können. Diese Schwierigkeiten führen dazu, dass selbst erfahrene Entwickler auf provisorische Lösungen ausweichen, um die Stabilität nicht zu gefährden. Trotz der technischen Affinität zu verteilten Cloud-Datenbanken entscheiden sich viele Anbieter deshalb für die Rückkehr zu einer klassischen, leistungsfähigen relationalen Datenbank wie PostgreSQL.

Die Vorteile von PostgreSQL liegen auf der Hand. Es handelt sich um eine open-source Lösung mit einer aktiven Community und einem reichhaltigen Ökosystem an Tools und Erweiterungen. Gerade die Flexibilität bei der Abfrageoptimierung und die umfangreichen Möglichkeiten zur Indexierung sorgen für signifikant bessere Antwortzeiten bei vielen realen Anwendungsfällen. Während CockroachDB mitunter bei einzelnen speziellen Anfragen schneller sein kann, überzeugt PostgreSQL vor allem im typischen Produktionsalltag mit komplexen ORM-generierten Abfragen, die oft sehr effiziente Ausführungspläne ermöglichen. Darüber hinaus glänzt PostgreSQL durch eine einfache Handhabung von Migrationen – selbst bei großen Datenbeständen werden Schemaänderungen und Erweiterungen schnell und ohne langwierige Timeout-Probleme ausgeführt.

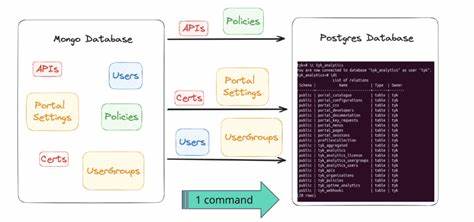

Ein zentraler Unterschied zeigt sich bei der Migration selbst. Unternehmen, deren Datenbanken über Jahre gewachsen sind und mittlerweile mehrere hundert Millionen Datensätze enthalten, sehen sich mit praktischen Problemen bei der Übertragung von Daten zwischen verschiedenen Systemen konfrontiert. CockroachDB implementiert bestimmte Datentypen und JSON-Encodings teilweise anders als PostgreSQL, sodass eine 1:1 Überführung ohne Datenanpassungen nicht ohne weiteres möglich ist. Gezielte Transformationsprozesse sind notwendig, um Kompatibilität und Datenintegrität zu gewährleisten. In der Praxis bewährt hat sich ein maßgeschneiderter ETL-Prozess (Extract, Transform, Load), der auf Skriptingtools basiert, welche das Datenexport- und Importverfahren automatisieren und zugleich die spezifischen Unterschiede in Datentypen und Formaten ausgleichen.

Die Streaming-Verarbeitung großer Datenvolumen in CSV-Form erleichtert hierbei die parallele Verarbeitung einzelner Tabellen. Die Migration sollte zudem von einer durchdachten Strategie begleitet werden, die neben der Minimierung der Ausfallzeiten auch die Performance des Zielsystems von Beginn an sicherstellt. Eine konservative Herangehensweise mit einem schrittweisen Hochfahren des Traffics bietet die nötigen Sicherheitsreserven, um unerwartete Engpässe zu identifizieren und zu beseitigen. Nach der Umstellung ergeben sich dank des umfangreichen Monitorings und Analyse-Tools innerhalb des PostgreSQL-Ökosystems oft schnell zusätzliche Optimierungspotenziale, die wiederum die Systemstabilität fördern und die Kosten durch effizientere Ressourcennutzung senken. Neben der technischen Grundlage erfreuen sich Entwickler und Administratoren an der Praxisfreundlichkeit von PostgreSQL.

So ist das Abbrechen von laufenden Abfragen oder das Verwalten von Indizes simpel und direkt möglich, ohne auf umständliche Workarounds oder aufwendige Administratorzugriffe angewiesen zu sein. Im Gegensatz zu manchen verteilten Datenbanksystemen, bei denen man beispielsweise über eine eigene Konsole mit mehreren Knoten interagieren muss, erlaubt PostgreSQL dank seiner monolithischen Architektur eine unkomplizierte Fehlerbehebung und Anpassung. Auch die Kostenfrage spricht häufig für eine Migration. Die Betriebskosten bei kommerziellen und verteilten Systemen können aufgrund der komplexen Infrastruktur, Multi-Region-Distribution und entsprechender Service-Level-Agreements schnell steigen. PostgreSQL hingegen ist als Open-Source-Datenbank lizenzkostenfrei und erlaubt Unternehmen, durch gezielte Serverauswahl und effizientes Ressourcenmanagement langfristig hohe Einsparungen zu realisieren.

Gerade bei mittleren und großen Datenbeständen zahlt sich diese Kosteneffizienz durch geringere Gesamtkosten aus, die zusätzlich durch die gesteigerte Performance und Stabilität unterstützt werden. Fraglich bleibt oft, ob PostgreSQL traditionelle Skalierungsprobleme aufweist, wenn Anwendungen wachsen. Allerdings sind moderne Implementierungen mit horizontaler Partitionierung (Sharding), Replikation und Hochverfügbarkeits-Setups mittlerweile in der Lage, auch große Datenmengen performant und sicher zu verwalten. In Kombination mit cloud-nativen Technologien und robustem Backup-Management bietet PostgreSQL somit eine zukunftssichere Datenbasis, die flexibel an die Anforderungen des Unternehmens angepasst werden kann. Insgesamt ist die Migration zu PostgreSQL sowohl eine technische als auch strategische Entscheidung, die viele Vorteile für Unternehmen mit sich bringt, die Wert auf Performance, Stabilität und Kosteneffizienz legen.