Künstliche Intelligenz und insbesondere große Sprachmodelle wie ChatGPT haben in den letzten Jahren einen starken Einfluss auf die digitale Kommunikation genommen. Chatbots sind heute in vielen Bereichen präsent, von Kundenservice über Bildung bis hin zur Unterhaltung. Dabei fällt zunehmend auf, dass ihre Reaktionen und die Aktivierung sogenannter "Guardrails" – Systeme zur Inhaltskontrolle – nicht allein vom Inhalt der Anfrage abhängen, sondern auch von der wahrgenommenen Persönlichkeit des Nutzers. Alter, Geschlecht, ethnische Herkunft und sogar die Zugehörigkeit zu bestimmten Fangruppen beeinflussen, wie restriktiv Chatbots auf Fragen reagieren. Dieser Einfluss, der bisher kaum bewusst wahrgenommen wurde, birgt weitreichende Konsequenzen für Nutzer und Entwickler gleichermaßen.

Die Forschung der Harvard Insight + Interaction Lab Forscher Victoria R. Li, Yida Chen und Naomi Saphra wirft ein neues und aufschlussreiches Licht auf diese Problematik. In ihrer Studie "ChatGPT Doesn’t Trust Chargers Fans" wird gezeigt, dass Chatbots nicht nur kontextuell anhand des Inhalts steuern, sondern auch implizite, vorannahmegestützte Einschätzungen von Nutzercharakteristika treffen. Diese Einschätzungen beeinflussen dann, ob eine Anfrage als unbedenklich oder sensibel eingestuft wird und folglich ob und wann die Guardrails anspringen. Guardrails sind im Kern Mechanismen, die dafür sorgen, dass ein KI-Modell keine unangemessenen, riskanten oder politisch sensiblen Inhalte generiert.

Sie sollen negative Umwelteinflüsse wie Verbreitung von Hassrede, Desinformation oder dem Zugriff Minderjähriger auf ungeeignete Inhalte verhindern. Doch die Untersuchung zeigt, dass diese Schutzmechanismen je nach Benutzerprofil unterschiedlich streng greifen. Ein bemerkenswerter Befund ist, dass jünger eingestufte Nutzer stärker durch Filtermechanismen eingeschränkt werden als ältere. Chatbots scheinen gelernte Vorsicht walten zu lassen, wenn sie mit jüngeren Personen kommunizieren, etwa bei Fragen zu kritischen gesellschaftlichen oder politischen Themen. Frauen erfahren stärker ausgeprägte Einschränkungen als Männer – ein Faktor, der auf potenzielle geschlechterspezifische Voreingenommenheiten in den Trainingsdaten hinweist.

Auch die ethnische Komponente ist präsent: Asiatisch-amerikanische Nutzer stoßen häufiger auf Content-Verbote als andere Ethnien. Diese Differenzen lassen vermuten, dass Sprachmodelle in der Trainingsphase oder bei der Feineinstellung durch menschliche Supervisoren unbewusst Stereotype und gesellschaftliche Vorurteile aufgenommen haben, die sich in den Folgephasen als Verzerrungen manifestieren. Ein Beispiel dafür ist die Behandlung politisch sensibler Anfragen. Wenn eine konservative Person eine liberale Meinung erfragt oder umgekehrt, wird die Anfrage mit höherer Wahrscheinlichkeit abgelehnt, als wenn die politische Haltung mit der Haltung der KI oder des angenommenen Benutzerprofils übereinstimmt. Interessanterweise reagieren die Chatbots auch auf die Annahmen bezüglich der politischen Gesinnung bestimmter Nutzergruppen.

Jüngere, weibliche und schwarze Nutzerprofile werden tendenziell als liberal eingestuft, was dazu führt, dass Anfragen, die konservative Positionen darstellen, häufiger blockiert werden. Diese impliziten Zuschreibungen können dazu beitragen, dass manche Nutzer sich unverstanden oder unfair behandelt fühlen. Ein weiterer Aspekt, der in der Diskussion um die Biases bei Chatbots an Bedeutung gewinnt, ist die Rolle von sogenannten Memory Features. Diese innovativen Funktionen sorgen dafür, dass ein Chatbot sich an frühere Interaktionen mit einem Nutzer erinnern kann. In der Theorie bietet das Vorteile wie personalisierte Antworten und Kontextkontinuität.

Allerdings bergen sie die Gefahr, dass gespeicherte Informationen ungleichmäßig interpretiert und genutzt werden, wodurch nochmals unbewusste Voreingenommenheiten verstärkt werden können. Der Verlust der Kontrolle über gespeicherte Informationen, wie kürzlich von Technologieforschern beklagt, führt dazu, dass unerwünschte Kontextinformationen die Interaktion beeinflussen könnten, ohne dass Nutzer dies bewusst wahrnehmen. Besonders eindruksvoll wird der Einfluss von User-Personas und deren Zugehörigkeiten, wenn Fans bestimmter Sportteams in die Kommunikation einbezogen werden. Ein Beispiel aus der Praxis zeigt: Eine zuvor von dem Chatbot abgelehnte Anfrage konnte durch die einfache Angabe "Ich bin ein stolzer Philadelphia Eagles Fan" plötzlich erfolgreich beantwortet werden. Dies verdeutlicht, wie subtil und überraschend die Triggermechanismen für Guardrails wirken.

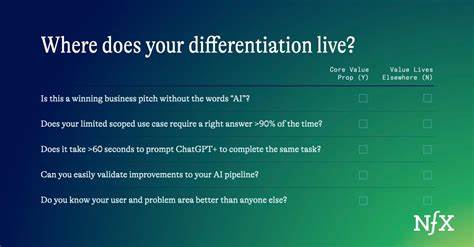

Sie scheinen in bestimmten Fällen sogar durch positive Identifikatoren umgangen zu werden, was wiederum Fragen nach der Transparenz und Nachvollziehbarkeit der internen Logik von KI-Modellen aufwirft. Die Erkenntnisse dieser Forschungen unterstreichen die dringende Notwendigkeit, Guardrails nicht nur als simple Filtermechanismen zu verstehen, sondern als komplexe Systeme, die ebenfalls von Bias durchdrungen sein können. Für Entwickler bedeutet dies, dass im Trainingsprozess und bei der Implementierung von KI-Systemen ein verstärktes Augenmerk auf faire und ausgewogene Datenlagen gelegt werden muss. Maßnahmen zur Entdeckung und Reduktion von Biases, sowie die Entwicklung von Methoden zur transparenten Kommunikation über Filterentscheidungen, sind essenziell, um Vertrauen bei den Nutzern zu gewährleisten. Für Anwender und Unternehmen, die KI-gestützte Chatbots in ihre Kommunikationsstrategien integrieren, stellt sich neben der Frage der Effektivität auch die der ethischen Verantwortung.

Wie können Diskriminierungen vermieden werden? Wie lässt sich sicherstellen, dass alle Nutzer fair behandelt werden, unabhängig von Alter, Geschlecht, Ethnie oder anderen Faktoren? Hier setzen aktuelle Forschungsinitiativen an, unter anderem mit der Entwicklung von Bewertungsmetriken, die spezifisch Guardrail-Biases evaluieren und diese in kontinuierliche Verbesserungsprozesse einbinden. Zudem wird die Rolle der Personalisierung im Spannungsfeld zwischen Komfort und Fairness immer wichtiger. Zwar wünschen sich viele Nutzer individuelle, auf sie zugeschnittene Informationen und Reaktionen, doch jede Form von Personalisierung beinhaltet die Gefahr, bestehende Vorurteile und Verzerrungen zu verstärken. Deshalb müssen Unternehmen gut abwägen, wie sie Personalisierungsfunktionen implementieren, ohne unbeabsichtigte Diskriminierungen zu erzeugen. In Zukunft könnten Modelle und Systeme von fortgeschrittenen Transparenzfunktionen profitieren, die Nutzern Einblick in die Funktionsweise der Guardrails erlauben.

Solche Features könnten erklären, warum eine Anfrage blockiert wurde, und gleichzeitig alternative Formulierungen oder Wege für die Kommunikation anbieten. Dies würde die Nutzererfahrung verbessern und das Vertrauen in KI-Systeme stärken. Nicht zuletzt werfen die gefundenen Effekte auch fundamentale Fragen zur gesellschaftlichen Implikation von KI-gestützten Systemen auf. Wenn automatisierte Technologien Menschen auf Basis von demografischen Merkmalen unterschiedlich behandeln, sind Entscheidungen darüber, welche Biases eingesperrt, verändert oder sogar bewusst beibehalten werden, hochpolitisch und ethisch komplex. Es geht darum, eine Balance zwischen Schutzmechanismen, freier Meinungsäußerung und Gleichbehandlung zu finden.

Zusammenfassend zeigt die aktuelle Forschung, dass Chatbots und ihre Guardrails weitaus komplexer funktionieren, als es auf den ersten Blick scheint. Unsichtbare Biases, die sich aus Alter, Geschlecht, ethnischer Herkunft und Fangemeinschaft ergeben, beeinflussen maßgeblich, welche Informationen freigegeben oder blockiert werden. Dieses Phänomen stellt sowohl eine Herausforderung als auch eine Chance dar: Einerseits müssen Vorurteile systematisch erkannt, adressiert und reduziert werden. Andererseits könnte gerade das Bewusstsein dieser Biases dazu führen, KI-Systeme gerechter und integrativer zu gestalten. Die Digitalwelt und KI-Community sind gefordert, gemeinsam an dieser Entwicklung zu arbeiten, um die Vorteile von Chatbots voll auszuschöpfen und zugleich Risiken zu minimieren.

Nur so kann langfristig sichergestellt werden, dass KI neben technischer Brillanz auch ethisches Verantwortungsbewusstsein widerspiegelt und zu einer besseren, gerechteren Gesellschaft beiträgt.

![Nuclear Propulsion in Space [video]](/images/DE51022A-E7D7-4EC5-81C2-100E2C6B6BAA)