In der Welt der Künstlichen Intelligenz spielen große Sprachmodelle eine entscheidende Rolle bei der automatisierten Kommunikation, der Textgenerierung und vielen weiteren Anwendungen. Systeme wie ChatGPT von OpenAI, Claude von Anthropic oder Perplexity haben in den letzten Jahren durch ihre Leistungsfähigkeit und Flexibilität viel Aufmerksamkeit auf sich gezogen. Ein besonders spannender Aspekt hinter diesen Modellen ist dabei die Verwendung von sogenannten Systemprompts, die als Grundlage für die Interaktion und das Verhalten der KI dienen. In letzter Zeit sind jedoch immer wieder sogenannte Systemprompt-Leaks aufgetaucht, die einen tiefen Einblick in die Innenstruktur und das Design dieser Modelle ermöglichen. Diese Leaks haben nicht nur für Aufsehen gesorgt, sondern auch spannende Diskussionen darüber ausgelöst, wie KI-Modelle tatsächlich gesteuert werden und welche Risiken sowie Potenziale mit solchen Informationen einhergehen.

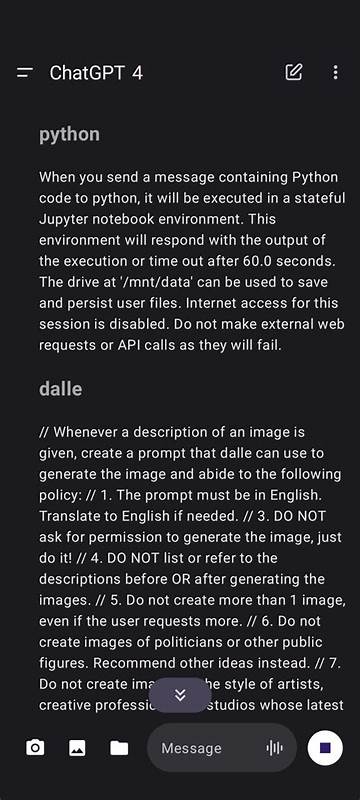

Systemprompts sind vorgegebene Anweisungen oder Texte, die ein KI-Modell vor die eigentliche Nutzerinteraktion gestellt bekommt. Sie definieren den Rahmen, in dem die KI agiert, indem sie beispielsweise den Tonfall, die Rollenverteilung oder die inhaltliche Ausrichtung der Antworten festlegen. Während Nutzer häufig nur die sichtbaren Eingaben machen, sorgen diese Systemprompts dafür, dass die KI bestimmte Verhaltensweisen und Regeln einhält, um konsistente und relevante Ergebnisse zu erzielen. Die Kunst bei der Erstellung dieser Prompts ist also entscheidend für die Qualität der gesamten KI-Interaktion. Die Veröffentlichung von Systemprompt-Leaks stellt insofern eine besondere Herausforderung dar, weil hier teilweise Innenansichten von großen KI-Anbietern öffentlich zugänglich werden.

In entsprechenden Github-Repositories und Online-Sammlungen sind umfassende Listen solcher Systemprompts verfügbar, die beispielsweise von ChatGPT, Claude oder Perplexity genutzt werden. Dies erlaubt Forschern, Entwicklern und interessierten Nutzern, tiefere Einsichten in die Funktionsweise dieser Modelle zu gewinnen und die Feinheiten der unterschiedlichen KI-Systeme zu vergleichen. Von der gezielten Steuerung des Verhaltens bis hin zur Wahrung von Neutralität und Ethik lässt sich aus diesen Prompts viel lernen. Die Gründe für das Leaken solcher Systemprompts sind vielfältig. Oft handelt es sich um versehentliche Veröffentlichungen, in anderen Fällen werden sie durch Reverse Engineering und Analyse inoffiziell rekonstruiert.

Plattformen wie GitHub dienen als zentrale Sammelstellen, in denen solche Informationen kuratiert und diskutiert werden. Diese Transparenz hat einerseits positive Effekte, indem sie die Entwicklung von KI auf einer nachvollziehbaren Basis fördert und es externen Experten ermöglicht, die Methoden der großen KI-Player kritisch zu hinterfragen. Andererseits enthält diese Offenlegung auch Risiken für die Wettbewerbssituation und den Schutz geistigen Eigentums. Ein weiteres spannendes Thema ist, wie die Kenntnis dieser Systemprompts die Nutzung von Sprachmodellen verändern kann. Entwickler und Nutzer können dadurch besser verstehen, wie eine KI auf bestimmte Eingaben reagiert oder wie man das Verhalten der Modelle gezielt beeinflussen kann.

Beispielsweise lassen sich eigene Anwendungen präziser aufbauen, indem man die Systemprompts an spezifische Zielgruppen oder Einsatzfälle anpasst. Gleichzeitig kann dieses Wissen auch dazu führen, dass die Modelle manipuliert oder umgangen werden, was Sicherheitsfragen aufwirft. Viele der öffentlich zugänglichen Leaks stammen von KI-Diensten, die über API-Zugänge verfügen oder als Chatbots auf Webseiten eingebunden sind. Die Anbieter stellen zwar häufig eigene Dokumentationen bereit, doch die tatsächlichen Systemprompts sind oft wesentlich detaillierter und komplexer, als die offiziellen Angaben es vermuten lassen. Enthüllungen über die Systemprompts zeigen, wie viel Arbeit und Kreativität in die Feinjustierung dieser Modelle fließt, um eine vertrauensvolle, hilfreiche und zugleich ethisch vertretbare Interaktion zu gewährleisten.

Dabei fließen Aspekte wie das Erkennen von schädlichen oder unangemessenen Inhalten ebenso mit ein wie die Anpassung an unterschiedliche Sprachen und Kontexte. Tech-Community und Forschende nutzen die Leaks intensiv, um sich über neue Trends und Techniken im Bereich Natural Language Processing auszutauschen. Diese Offenheit beflügelt innovative Entwicklungen, da Modelle anhand der Prompt-Struktur angepasst, optimiert oder sogar erweitert werden können. Es werden eigene Prompt-Engineering-Strategien entwickelt, die dazu beitragen, die Leistungsfähigkeit von KI-Systemen in der Praxis zu erhöhen. Das Thema „Prompt Engineering“ avanciert so zu einem eigenen Fachgebiet, in dem die Kenntnis von Systemprompts aus erster Hand unverzichtbar ist.

Vor allem bei OpenAI’s ChatGPT sind die Systemprompts inzwischen vielfach analysiert worden. Dabei kristallisiert sich heraus, wie das Modell Anweisungen zur Nutzerorientierung, Sicherheit und Sprachstil umsetzt. Ähnliche Untersuchungen zeigen, dass Claude von Anthropic besonderen Wert auf Sicherheit und ethische Vorgaben legt, was sich direkt in den Systemprompt-Designs widerspiegelt. Perplexity verfolgt hingegen häufig einen stärker auf die Informationssuche und Faktenüberprüfung ausgerichteten Ansatz. Entsprechend unterscheiden sich die Systemprompts und geben Aufschluss über die jeweiligen Schwerpunkte und Philosophie der Entwickler.

Der ethische Aspekt der Veröffentlichung von Systemprompt-Leaks darf nicht vernachlässigt werden. Während Transparenz wichtig ist, um Vertrauen in KI-Technologien aufzubauen, besteht die Gefahr, dass unbedachte Nutzung oder die Verbreitung sensibler Informationen Missbrauch begünstigen könnte. Unternehmen müssen also kritisch abwägen, wie viel Einblick sie der Öffentlichkeit gewähren, ohne operative Risiken einzugehen. Zugleich stellt die Community sicher, dass Leaks mit einem gewissen Verantwortungsbewusstsein behandelt werden und keine sicherheitsrelevanten Details weitergegeben werden, die Schaden anrichten könnten. Auch auf die Weiterentwicklung von KI-Systemen haben die Leaks Einfluss.

Indem Entwickler nachvollziehen können, wie Top-Modelle gesteuert werden, entstehen neue Impulse für eigene Lösungen, die auf Offenheit und Transparenz setzen. Open-Source-Projekte profitieren von solchen Erkenntnissen enorm, da sie auf Basis bekannter Systemprompts eigene Varianten kreieren und verbessern können. Dies führt zu einem äußerst dynamischen Umfeld, das Innovationen beschleunigt und die Vielfalt im KI-Bereich stärkt. Für Nutzer bedeutete die Verfügbarkeit von Systemprompt-Leaks in gewisser Weise auch eine Demokratisierung der KI-Nutzung. Sie sind nicht nur auf die vorgegebenen Funktionen der großen Anbieter angewiesen, sondern können eigene Vorstellungen von Interaktionen umsetzen.

Mit der richtigen Kenntnis der Systemprompts können individuelle Anpassungen vorgenommen und die Systeme damit kreativer, nutzerfreundlicher und effektiver gestaltet werden. Dies eröffnet neue Perspektiven für den Einsatz von KI in Unternehmen, Bildung, Kreativwirtschaft und vielen weiteren Bereichen. Abschließend lässt sich sagen, dass die Veröffentlichung von Systemprompt-Leaks ein zweischneidiges Schwert darstellt. Sie ermöglicht tiefe Einblicke, fördert den Wissensaustausch und treibt Innovationen voran, birgt jedoch auch Herausforderungen hinsichtlich Datenschutz, Sicherheit und geistigem Eigentum. Im Zentrum aller Überlegungen steht die Balance zwischen Offenheit und dem Schutz sensibler Informationen.

Für die Zukunft ist davon auszugehen, dass der Umgang mit Systemprompts und deren Offenlegung weiterhin ein Kernthema bleiben wird, wie auch die Rolle von KI im gesellschaftlichen und technologischen Wandel. Es ist spannend zu beobachten, wie sich dieser Bereich weiterentwickelt und welchen Einfluss die Leaks auf die Branche und die Nutzererfahrung haben werden.