In einer Welt, die von Daten geprägt ist, gewinnen Visualisierungen immer mehr an Bedeutung. Sie ermöglichen es, komplexe Informationen verständlich und anschaulich darzustellen, sodass Entscheidungsprozesse effizienter und fundierter gestaltet werden können. Dennoch ist die Qualität einer Visualisierung untrennbar mit der Vertrauenswürdigkeit der zugrunde liegenden Daten verbunden. Nur wenn die Daten verlässlich und gut geprüft sind, können die daraus resultierenden Erkenntnisse tatsächlich wertvoll sein. Das Vertrauen in Daten wird somit zum entscheidenden Faktor bei der Erstellung und Nutzung von Visualisierungen.

Datenvisualisierungen helfen dabei, große Mengen an Zahlen, Fakten und Trends auf leicht verständliche Weise zu kommunizieren. Von einfachen Diagrammen bis hin zu interaktiven Dashboards sind visuelle Darstellungen ein wichtiges Werkzeug in unterschiedlichsten Branchen – seien es Wirtschaft, Wissenschaft, Medien oder öffentliche Verwaltung. Doch wenn die Daten nicht auf soliden Grundlagen basieren, besteht die Gefahr, falsche Schlussfolgerungen zu ziehen oder gar Fehlinformationen zu verbreiten. Daher gewinnt das Thema vertrauenswürdige Datenquellen zunehmend an Bedeutung. Vertrauenswürdige Daten entstehen durch eine Kombination mehrerer Faktoren.

Zunächst steht die Herkunft der Daten im Fokus. Daten sollten idealerweise aus offiziellen, transparenten und überprüften Quellen stammen. Beispielsweise können statistische Ämter, wissenschaftliche Institutionen oder etablierte Unternehmen solche Quellen darstellen. Darüber hinaus sind klare Dokumentationen zu den Erhebungsmethoden ebenso wichtig wie eine kontinuierliche Aktualisierung und Qualitätssicherung der Datensätze. Moderne Technologien spielen ebenfalls eine bedeutende Rolle dabei, die Vertrauenswürdigkeit von Daten sicherzustellen.

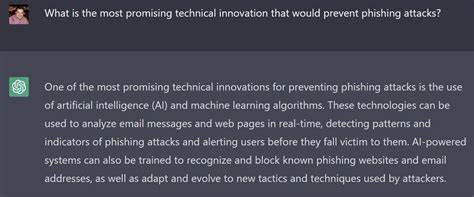

Automatisierte Prüfmechanismen erkennen frühzeitig Unstimmigkeiten, Anomalien oder Fehler in den Daten. Künstliche Intelligenz und Machine Learning können darüber hinaus Muster entdecken, die auf Manipulationen oder Verzerrungen hinweisen. Durch solche Tools wird gewährleistet, dass die Datenbasis, auf der Visualisierungen beruhen, präzise und nachvollziehbar bleibt. Die Wahl der richtigen Visualisierungsmethode hängt zudem von der Art und Komplexität der Daten ab. Während einige Sachverhalte durch einfache Balken- oder Liniendiagramme verständlich dargestellt werden können, erfordern große Datenmengen oder multivariate Zusammenhänge interaktive Dashboard-Lösungen oder Heatmaps.

Durch die Anpassung an die Datenstruktur wird nicht nur die Verständlichkeit erhöht, sondern auch die Aussagekraft der Visualisierungen gesteigert. Ein weiterer entscheidender Aspekt ist die Transparenz im Umgang mit den Daten. Nutzer von Visualisierungen sollten stets die Herkunft, den Aktualitätszeitraum und gegebenenfalls die Einschränkungen der Daten erkennen können. Das schafft zusätzliches Vertrauen und fördert eine kritische Auseinandersetzung mit den präsentierten Informationen. Anbieter von Visualisierungstools oder Datenplattformen sollten deshalb umfassende Metadaten und Erläuterungen bereitstellen.

In der Praxis zeigt sich, dass Unternehmen, die auf vertrauenswürdige Daten und hochwertige Visualisierungen setzen, strategische Vorteile erzielen. Datengetriebene Entscheidungen reduzieren Risiken und fördern innovative Geschäftsmodelle. Dabei ist es wichtig, dass alle beteiligten Akteure – von der Datenerfassung über die Datenanalyse bis zur Präsentation – eng zusammenarbeiten und klare Standards einhalten. Zudem eröffnen vertrauenswürdige Datenvisualisierungen Kommunikationsmöglichkeiten, die weit über interne Prozesse hinausgehen. Medien, Politik und Wissenschaft nutzen sie, um komplexe Sachverhalte verständlich aufzubereiten und einer breiten Öffentlichkeit zugänglich zu machen.

Dies trägt nicht zuletzt zur Stärkung eines datenkompetenten gesellschaftlichen Diskurses bei. Die Integration moderner APIs und Suchtechnologien unterstützt zudem die schnelle und effiziente Gewinnung relevanter Daten. Zum Beispiel bieten spezialisierte Schnittstellen die Möglichkeit, mittels natürlicher Sprachabfragen gezielt Informationen zu suchen und in Visualisierungen einzubinden. Durch diese Automatisierung wird der Prozess der Datenaufbereitung erheblich verbessert, und die Datenqualität kann besser überwacht werden. Insgesamt gilt: Visualisierungen sind nur so gut wie die Daten, die ihnen zugrunde liegen.

Vertrauen in die Daten ist somit der Grundpfeiler für aussagekräftige Analysen und fundierte Entscheidungen. Durch den bewussten Umgang mit Datenquellen, kontinuierliche Qualitätsprüfung und transparente Darstellung können Unternehmen und Organisationen das volle Potenzial von Datenvisualisierungen ausschöpfen und ihre Wirkung nachhaltig steigern.