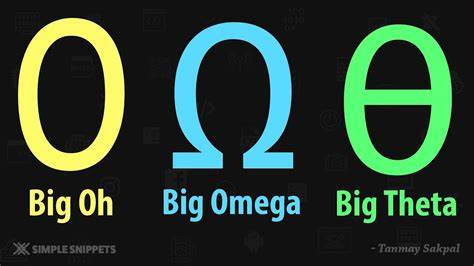

Die asymptotische Analyse von Algorithmen ist ein zentrales Thema in der Informatik. Dabei stellen Big O, Omega und Theta drei wichtige Notationen dar, die jeweils unterschiedliche Aspekte der Laufzeit- oder Speicherkomplexität ausdrücken. Big O beschreibt eine obere Schranke, Omega eine untere Schranke und Theta eine genaue Schranke. Trotz dieser klaren Definitionen wird in wissenschaftlichen Arbeiten, Vorlesungen und in der Praxis oft hauptsächlich Big O verwendet. Diese Dominanz von Big O wirft die Frage auf, warum diese Notation so stark im Vordergrund steht, obwohl Omega und Theta technisch gesehen oft besser geeignet wären, um das Verhalten von Algorithmen präzise zu beschreiben.

Um diese Frage zu beantworten, lohnt es sich, sowohl die theoretischen Hintergründe als auch die praktischen Gründe für die Popularität von Big O zu beleuchten. Zunächst einmal ist Big O als asymptotische obere Schranke besonders intuitiv und einfach zu verstehen. Es bietet eine Art Worst-Case-Szenario, das Entwicklern und Forschern erlaubt, die maximale Laufzeit einer Funktion oder Algorithmus zu bestimmen. In der Praxis ist oft das Interesse am schlechtesten Fall besonders hoch, da dieser die Leistungsfähigkeit und Zuverlässigkeit eines Systems maßgeblich beeinflussen kann. Big O fasst die Komplexität somit in einer Weise zusammen, die direkt aussagt: „Der Algorithmus wird nicht schlechter als .

..“. Dies macht die Notation besonders benutzerfreundlich für eine breite Zielgruppe – vom Studenten bis zum erfahrenen Entwickler. Weiterhin ist die Big O Notation weit verbreitet und hat sich als Standard etabliert, was die Kommunikation innerhalb der Community stark vereinfacht.

Die Verständlichkeit und der geringe Erklärungsaufwand spielen eine große Rolle. In Lehrbüchern, Online-Ressourcen, Vorlesungen und technischen Dokumentationen ist Big O fast immer der erste und oft auch der einzige Begriff, der eingeführt wird. Dies führt dazu, dass viele Informatikstudierende und Praktiker Omega und Theta entweder gar nicht erst kennenlernen oder deren Bedeutung nicht vollständig verinnerlichen. Ein weiterer Grund dafür, warum Omega häufig seltener genutzt wird, liegt in der Schwierigkeit, eine valide untere Schranke festzulegen. Während eine obere Schranke relativ einfach abgeschätzt oder bewiesen werden kann, ist eine untere Schranke deutlich schwerer zu bestimmen.

Um zu zeigen, dass ein Algorithmus mindestens eine bestimmte Komplexität hat, bedarf es oft strengere Beweise und komplexere Analyseverfahren. Dies gilt insbesondere in Bezug auf Laufzeitkomplexität, da viele Algorithmen speziell für den besten oder durchschnittlichen Fall optimiert werden, aber der schlechteste Fall dennoch für Big O aussagekräftig bleibt. Theta ist die Notation, die eine enge asymptotische Schranke angibt, also sowohl von oben als auch von unten begrenzt. Theoretisch stellt Theta somit die präziseste Beschreibung eines Algorithmus dar. Allerdings ist es in der Praxis oft schwierig und manchmal nicht einmal nötig, exakte Schranken zu bestimmen.

Eine exakte Analyse kann komplex und zeitaufwendig sein und erfordert ein tiefgreifendes Verständnis der zugrundeliegenden Probleme und Algorithmen. In vielen Fällen ist es ausreichend, eine obere Schranke zu kennen, um eine Aussage über die Skalierung des Algorithmus zu treffen und ihn mit anderen Algorithmen zu vergleichen. Daher wird Theta meist in wissenschaftlichen Arbeiten oder spezialisierten Kontexten genutzt und weniger in der alltäglichen Praxis. Darüber hinaus hat die informelle Sprache unter Entwicklern und Praktikern eine Rolle in der Dominanz von Big O gespielt. Häufig hört man Aussagen wie „Das ist ein Algorithmus mit Laufzeit O(n)“ oder „Die Komplexität ist O(n²)“.

Diese Art der vereinfachten Kommunikation ist griffig und reduziert Missverständnisse hinsichtlich der Leistungsfähigkeit von Algorithmen. Omega wird dagegen oft als akademisch und kompliziert wahrgenommen, was seine Verbreitung zusätzlich einschränkt. Die Verwendung von Big O spiegelt auch den Fokus der Informatik auf Skalierbarkeit und Worst-Case-Performance wider. In vielen realen Systemen ist es von entscheidender Bedeutung zu wissen, wie sich ein Algorithmus im schlechtesten Fall verhält, um Systemausfälle oder Verzögerungen zu vermeiden. Omega-Notationen hingegen beschreiben typischerweise das beste oder minimal notwendige Laufzeitverhalten, was in sicherheitskritischen oder performanzsensitiven Anwendungen weniger relevant ist.

Nicht zuletzt ist ein Mangel an standardisierter und konsistenter Anwendung von asymptotischer Notation ein Grund für die häufige Verwendung von Big O. Viele Einführungen in Algorithmen und Datenstrukturen erklären ausführlich Big O, während Omega und Theta bestenfalls als ergänzende Konzepte erwähnt werden. Praktisch gesehen sind Kenntnisse über Big O ausreichend, um die meisten Anforderungen zu erfüllen, so dass viele Entwickler bewusst oder unbewusst auf die umfassendere Betrachtung verzichten. Es lässt sich also festhalten, dass Big O durch seine einfache Interpretierbarkeit, die Fokussierung auf Worst-Case-Szenarien und die weite Verbreitung zum dominierenden Maßstab für asymptotische Analysen geworden ist. Omega und Theta sind technisch genauer und haben ihre Berechtigung, insbesondere in tiefgehenden theoretischen Untersuchungen, werden aber aus verschiedenen praktischen Gründen deutlich seltener verwendet.

Für ein ganzheitliches Verständnis der Algorithmusanalyse ist es jedoch wichtig, auch diese Konzepte zu kennen und anzuwenden, wann immer der Kontext es erfordert. Die Zukunft könnte eine größere Verbreitung von Omega und Theta bedeuten, wenn die Informatik sich stärker theoretisch ausrichtet oder wenn komplexere Algorithmenanalysen immer häufiger Bestandteil der Praxis werden. Gleichzeitig bleibt es aber wahrscheinlich, dass Big O aufgrund seiner Zugänglichkeit und etablierten Stellung weiterhin eine zentrale Rolle spielen wird. Für Entwickler, die sich über die grundlegenden Konzepte hinaus vertiefen möchten, ist es ratsam, alle drei Notationen zu verstehen und situationsgerecht einzusetzen, um präzise und aussagekräftige Aussagen über die Effizienz von Algorithmen treffen zu können. Zusammenfassend zeigt sich, dass die Dominanz von Big O in der Informatik weniger auf einer technischen Überlegenheit, sondern vielmehr auf einer Mischung aus historischem Gebrauch, Praktikabilität und Benutzerfreundlichkeit beruht.

Die bewusste und korrekte Verwendung von Omega und Theta kann zwar in bestimmten Fällen eine genauere Analyse ermöglichen, doch in den meisten Alltagsszenarien genügt Big O, um die wesentlichen Eigenschaften eines Algorithmus verständlich darzustellen. Für einen ausgewogenen Blick auf die Komplexität ist es dennoch unerlässlich, die Unterschiede und Anwendungsbereiche aller drei Notationen zu kennen.

![What Is Bitcoin, Exactly? [+ Is This Cryptocurrency The “New Gold”?]](/images/ADA43F12-19C7-49C6-88DB-BFE81CA717AC)