In der heutigen digitalen Welt steigt das Datenvolumen ständig an, was Unternehmen vor neue Herausforderungen in der Datenverwaltung und -analyse stellt. Klassische Data Warehouses stoßen vielerorts an ihre Grenzen, sei es bei der Flexibilität, den Kosten oder der Skalierbarkeit. Gleichzeitig gewinnen Data Lakes als günstige und flexible Speicherlösungen an Bedeutung. Doch beide Technologien haben Schwächen, die zunehmend durch eine innovative Architektur namens Datenlakehouse überwunden werden. Besonders spannend ist dabei das Konzept des Dual-Engine Serverless SQL Lakehouse, das die Stärken unterschiedlicher Systeme kombiniert, um eine leistungsfähige, skalierbare und kosteneffiziente Datenplattform bereitzustellen.

Im Zentrum stehen dabei die open-source Datenbank DuckDB, der serverlose Neon PostgreSQL-Dienst und die bewährte Google Cloud Storage als Datenspeicher. Die Kombination dieser Technologien eröffnet neue Möglichkeiten für Unternehmen, Daten einfach und sicher zu speichern, zu katalogisieren und performant zu analysieren. Das Dual-Engine Serverless SQL Lakehouse vereint die Vorteile von Data Lake und Data Warehouse in einem flexiblen System. Während Data Lakes einfach skalierbaren Speicher bieten, mangelt es ihnen häufig an robusten Datenmanagement- und Transaktionsmechanismen. Andererseits ermöglichen Data Warehouses durch strenge ACID-Transaktionen und Metadatenmanagement eine zuverlässige Datenorganisation, sind aber oft teuer und schwer skalierbar.

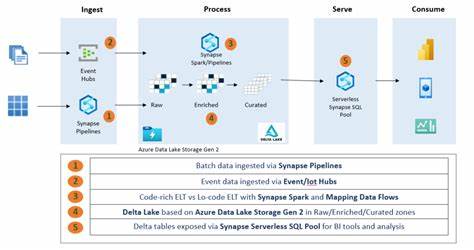

Die Lakehouse-Architektur schlägt die Brücke, indem sie einen zentralen Metadatenspeicher bietet, der die Daten in kostengünstigen, objektbasierten Cloud-Speichern organisiert und gleichzeitig die analytische Leistung und Konsistenz eines Data Warehouses ermöglicht. Das Herzstück dieses Systems ist DuckDB, eine moderne, in-process Analytics-Datenbank, die speziell für schnelle, relationale Analysen auf lokalen Dateien und in Speicherumgebungen entwickelt wurde. DuckDB bietet eine einfache Handhabung, außergewöhnliche Performance und eine wachsendes Ökosystem von Erweiterungen. Dank der DuckLake-Erweiterung kann DuckDB direkt auf große Mengen von Parquet-Daten zugreifen, die in Google Cloud Storage abgelegt sind, und so komplexe Abfragen ausführen, ohne die Daten erst laden zu müssen. Dies reduziert deutlich die Betriebskosten und vereinfacht die Architektur.

Google Cloud Storage fungiert als skalierbarer und sicherer Objektspeicher, in dem die Rohdaten in Form von Parquet-Dateien gespeichert werden. Diese Formate sind weit verbreitet und bieten exzellente Komprimierungs- und Abfrageeigenschaften für analytische Workloads. Durch die Trennung von Speicherung und Rechenleistung können Unternehmen die Kosten kontrollieren und je nach Bedarf skalieren, während gleichzeitig die Daten jederzeit zugänglich bleiben. Für das Management der Metadaten und die zentrale Steuerung des Lakehouses kommt Neon PostgreSQL zum Einsatz – ein vollverwalteter, serverloser PostgreSQL-Dienst, der sich ideal für das Metadata-Management eignet. Neon rundet das Setup ab, indem es als Katalogdienst mit ACID-konformen Transaktionen fungiert, ohne dass Nutzer sich um die Infrastruktur kümmern müssen.

Über eine einfache Schnittstelle können Nutzer Tabellen anlegen, Schemata verwalten und Versionen ihrer Daten nachverfolgen. Im Zusammenspiel mit DuckDB entsteht so ein hochflexibles, skalierbares und benutzerfreundliches Datenökosystem. Der Einstieg in das Dual-Engine Serverless SQL Lakehouse gestaltet sich überraschend unkompliziert. Zunächst wird DuckDB gestartet und wichtige Erweiterungen wie httpfs für den Zugriff auf Cloud Storage, postgres für die Verbindung zur Metadatenbank sowie die DuckLake-Erweiterung installiert. Anschließend werden Sicherheitsinformationen – sogenannte Secrets – für den Zugriff auf Google Cloud Storage und Neon PostgreSQL hinterlegt, um eine sichere Kommunikation zwischen den Komponenten zu gewährleisten.

Hierbei werden HMAC-Schlüssel für den Cloud Storage und Verbindungsdaten für den PostgreSQL-Server genutzt. Das Lakehouse selbst wird durch den ATTACH-Befehl in DuckDB mit einer spezifischen Datenpfadangabe zum Google Cloud Storage verbunden. Dies ermöglicht es, die Metadaten in der PostgreSQL-Datenbank zu speichern, während die eigentlichen Daten in Parquet-Dateien im Cloud Storage liegen. Die Daten können entweder über lokale Dateien oder durch Laden aus dem Internet als Tabellen definiert und weiterverarbeitet werden. Der duale Vorteil zeigt sich in der Analysefähigkeit: DuckDB ermöglicht schnelle und flexible SQL-Abfragen direkt auf den Parquet-Dateien.

Komplexe Aggregationen, Filterungen oder Joins können ausgeführt werden, ohne die Daten umkopieren zu müssen. Gleichzeitig verwaltet Neon PostgreSQL die dazugehörigen Metadaten, gewährleistet Transaktions-Sicherheit und ermöglicht durch Funktionen wie Zeitreisen, also das Abfragen historischer Versionen von Tabellen, eine erweiterte Datenverwaltung. Die Zeitreisefunktion ist besonders wertvoll für Audits, Datenqualitätsprüfungen oder einfaches Nachvollziehen von Datenänderungen im Zeitverlauf. Diese Entkopplung von Speicherung und Rechenleistung hat zahlreiche Vorteile. Zum einen sorgt sie für Kosteneffizienz, da Speicherplatz in Cloud Object Stores erheblich günstiger ist als klassische Data Warehouse Lösungen.

Zum anderen bleibt die Rechenleistung flexibel – DuckDB kann lokal auf einem Developer-Rechner oder in einer Cloud-Instanz betrieben werden, während Neon automatisch die Datenbankservices skaliert. Durch den Einsatz von offenen Standards und Formaten bleibt das System auch zukunftssicher und gut adaptierbar. Die Integration von DuckDB, Google Cloud Storage und Neon PostgreSQL bildet eine leistungsstarke Infrastruktur, die auch ohne großen Betriebsoverhead einfache und performante Datenprozesse ermöglicht. Anwender können ihre Rohdaten in einem Cloud Storage ablegen, sie mit DuckDB schnell und effizient abfragen und bearbeiten und dabei jederzeit auf eine robuste Metadatenverwaltung zurückgreifen. Diese Einfachheit ist ideal für Data Scientists, Analysten und Entwickler, die schnell und flexibel arbeiten wollen, ohne sich mit komplexen Infrastruktur-Details zu beschäftigen.

Darüber hinaus bietet das System eine benutzerfreundliche Oberfläche über DuckDBs UI-Erweiterung, mit der Daten und Metadaten bequem untersucht und verwaltet werden können. Dies unterstützt auch Teams bei der Zusammenarbeit, da jeder einfach auf dieselbe Datenbasis zugreifen und Veränderungen nachvollziehen kann. Das Dual-Engine Serverless SQL Lakehouse eröffnet Unternehmen neue Wege, um moderne Big Data Herausforderungen zu meistern. Es verbindet Skalierbarkeit und Kosteneffizienz des Cloud Storages mit der Performance und Flexibilität von DuckDB und der Robustheit eines vollverwalteten PostgreSQL-Services. Dadurch entsteht ein leistungsfähiges und zugleich wartungsarmes Ökosystem, das sowohl für kleine Teams als auch für große Unternehmen geeignet ist.

Die Möglichkeit, Daten in offenen Formaten zu speichern und durch ACID-konforme Metadatenverwaltung sichere, konsistente Datenansichten zu schaffen, bildet eine solide Grundlage für zukunftsorientierte Datenstrategien. Durch die Entkopplung von Speicher und Berechnung kann das Lakehouse nahtlos wachsen und sich an wechselnde Anforderungen anpassen. Zusammenfassend lässt sich sagen, dass das Dual-Engine Serverless SQL Lakehouse mit DuckDB, Neon PostgreSQL und Google Cloud Storage eine moderne, effiziente und flexible Lösung für die Datenplattform der Zukunft ist. Es bietet die Vorteile klassischer Data Warehouses und Data Lakes in einer einzigen Architektur, optimiert für Cloud-Umgebungen und für Anwender, die pragmatische, leistungsstarke Datenzugriffe benötigen. Wer sich mit Data Engineering, Business Intelligence oder Datenanalyse beschäftigt, sollte dieses Konzept unbedingt genauer betrachten.

Die Kombination aus offener Technologie, einfacher Handhabung und starker Performance macht das Dual-Engine Serverless SQL Lakehouse zu einem der vielversprechendsten Ansätze im Bereich moderner Dateninfrastrukturen.