Die Rolle von Large Language Models (LLMs) im Bereich der Softwareentwicklung hat in den letzten Jahren erheblich an Bedeutung gewonnen. Insbesondere die Fähigkeit, aus natürlichsprachlichen Anweisungen automatisch lauffähigen Code zu erzeugen, eröffnet neue Möglichkeiten für Entwickler und Unternehmen. Doch mit dieser Automatisierung gehen auch Herausforderungen einher, besonders im Hinblick auf die Sicherheit des generierten Codes. Unsicherer oder fehlerhafter Code kann gravierende Folgen haben – von Sicherheitslücken bis hin zu Datenverlust oder Systemausfällen. Vor diesem Hintergrund beschäftigen sich Forscher und Praktiker intensiv mit der Frage, wie man die Sicherheit automatisiert erzeugter Software verbessern kann.

Ein vielversprechender Ansatz liegt im Einsatz spezialisierter Prompting-Techniken, die darauf abzielen, Large Language Models zu besseren und vor allem sicheren Quellen für Code-Generierung zu machen.Prompting bezeichnet im Kontext der KI die Methode, das Modell durch gezielte Eingaben dazu zu bringen, qualitativ hochwertige und inhaltlich relevante Ausgaben zu liefern. In der Softwareentwicklung bedeutet das, Texteingaben so zu formulieren, dass die daraus generierten Programme möglichst genau den Anforderungen entsprechen und dabei sicher sind. Die Herausforderung besteht darin, die natürlichen Sprachbefehle so präzise und informativ zu gestalten, dass das Modell gängige Sicherheitspatterns berücksichtigt und bekannte Schwachstellen vermeidet. Die Forschung zeigt, dass nicht jede Formulierung gleichwertige Resultate hervorbringt.

Vielmehr können kleine Anpassungen im Prompting erhebliche Auswirkungen auf die Qualität und Sicherheit des generierten Codes haben.Eine bedeutsame Erkenntnis ist die Wirksamkeit der Technik namens Recursive Criticism and Improvement (RCI), die in aktuellen Untersuchungen zur sicheren Codegenerierung hervorgehoben wird. RCI basiert darauf, den Code mehrmals iterativ zu überprüfen, zu kritisieren und zu verbessern. Dabei ruft das Modell sich selbst zur Revision auf und kann so Schwachstellen identifizieren und beheben. Dieses Verfahren ist besonders interessant, da es den LLMs ermöglicht, nicht nur einmalig zu generieren, sondern aktiv mit Qualitätskontrolle und Fehlerkorrektur umzugehen.

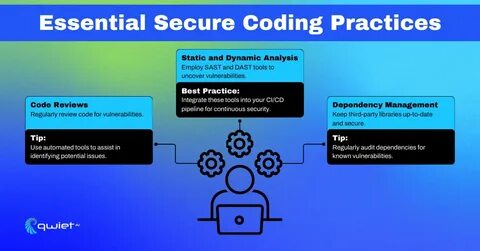

Auf diese Weise reduziert sich die Anzahl sicherheitsrelevanter Schwächen im Code deutlich, was von unabhängigen Studien bestätigt wurde.Die Integration verschiedener Prompting-Techniken, wie etwa das Einbetten von expliziten Sicherheitshinweisen in den Natural Language Prompt oder die Verwendung von Kontextinformationen über bewährte Sicherheitspraktiken, erweist sich als weiterer Schlüssel, um vertrauenswürdige Softwarebausteine zu erstellen. Entwickler können zum Beispiel Sicherheitsregeln direkt im Prompt erwähnen, indem sie das Modell explizit anweisen, gängige Angriffsvektoren wie SQL-Injection, Cross-Site-Scripting (XSS) oder unsichere Speicherzugriffe zu vermeiden. Auch das Einfügen von Beispielen sicherer Muster unterstützt die Modell-Generierung, da sich das KI-System an diesen positiven Vorbildern orientiert. Dadurch werden Fehlentwicklungen aktiv verhindert und die Robustheit erhöht.

Ein weiterer wichtiger Faktor ist die Auswahl des richtigen Modells. Unterschiede zwischen GPT-3, GPT-3.5 und GPT-4 sind nicht nur in der Rechenleistung, sondern auch im Sicherheitsbewusstsein bei der Codegenerierung deutlich spürbar. Neuere Modelle verfügen über eine verbesserte Fähigkeit, Kontextinformationen zu verarbeiten und komplexe Anforderungen zu verstehen, was sich direkt in stabileren und sichereren Codeteilen niederschlägt. Dennoch gilt auch hier: Der Einsatz optimaler Prompting-Techniken entscheidet maßgeblich über den Erfolg der generierten Ergebnisse.

Für Unternehmen, die LLMs in ihrer Entwicklungsumgebung nutzen wollen, stellt sich somit die zentrale Frage, wie sie die Vorteile automatischer Codeerzeugung nutzen und gleichzeitig die Sicherheit gewährleisten können. Die Antwort liegt neben der Auswahl leistungsfähiger LLMs vor allem in der systematischen Anwendung und Weiterentwicklung von Prompting-Strategien. Fachleute empfehlen eine Kombination aus automatischer Codegenerierung, manueller Codeüberprüfung und iterativer Verbesserung mithilfe von Methoden wie RCI. Dieses Zusammenspiel minimiert Risiken und sorgt für einen effizienten Entstehungsprozess.Die Zukunft der sicheren Programmierung wird stark von der Automatisierung geprägt sein, die durch künstliche Intelligenz ermöglicht wird.

Umso wichtiger ist es, dass Entwickler, Sicherheitsfachleute und Forschende eng zusammenarbeiten und Erkenntnisse über erfolgreiche Prompting-Techniken kontinuierlich weitergeben. Die wissenschaftliche Untersuchung dieser Methoden liefert dabei wertvolle Erkenntnisse und trägt dazu bei, die Grenzen der automatischen Softwareerstellung neu zu definieren und zugleich für mehr Sicherheit in der digitalen Welt zu sorgen.Abschließend lässt sich sagen, dass die gezielte Anwendung von Prompting-Techniken bei der Verwendung von LLMs einen signifikanten Einfluss auf die Sicherheit von generiertem Code hat. Diese Techniken erlauben es, komplexe, sicherheitsrelevante Anforderungen in verständliche Eingaben zu übersetzen, was wiederum die Robustheit des Endprodukts erhöht. Die aktive Einbindung von Verbesserungszyklen und die Verwendung von Mustervorlagen sind bewährte Mittel, um Fehler zu minimieren und Vertrauen in die automatisierten Prozesse zu schaffen.

Wer sich intensiv mit diesen Techniken auseinandersetzt, legt den Grundstein für eine sichere und innovative Softwareentwicklung im Zeitalter der künstlichen Intelligenz.