Die Menge an Daten, die jeder von uns auf dem eigenen Rechner speichert, wächst kontinuierlich. Dateien unterschiedlicher Formate, von PDFs über Excel-Tabellen bis hin zu abgelegten Bildern, stapeln sich und werden letztlich schwer auffindbar, wenn kein durchdachtes Ordnungssystem existiert. Klassische Suchmechanismen, die ausschließlich Dateinamen oder rudimentäre Metadaten durchsuchen, stoßen hierbei an ihre Grenzen. Gerade bei unübersichtlichen oder unstrukturierten Datenbeständen ist die Frage berechtigt: Kann ein Large Language Model (LLM), also ein großes KI-Sprachmodell, als intelligente Suchmaschine direkt auf dem lokalen Rechner eingesetzt werden, um die Suche zu verbessern? Große Sprachmodelle bieten die Fähigkeit, semantische Zusammenhänge und Bedeutungskontexte zu erkennen, selbst wenn beispielsweise Dateinamen kaum relevante Hinweise liefern. Das macht sie zu idealen Kandidaten für eine bessere lokale Suche, die sich nicht allein auf exakte Textübereinstimmungen beschränkt.

So lässt sich etwa nach Dokumenten mit bestimmten Inhalten oder Bedeutungen suchen, auch wenn diese nicht explizit durch Dateinamen oder Ordnerstrukturen erschlossen sind. Technisch gesehen ist es durchaus möglich, LLMs für eine solche Aufgabe zu nutzen. Grundsätzlich erfordert dies das 'Einspeisen' der vorhandenen Dokumente und Dateien in das Modell oder in eine begleitende Suchstruktur, die dann durch das Modell intelligent abgefragt werden kann. Dabei werden zunächst die Inhalte der Dateien analysiert, als Text extrahiert und anschließend durch sogenannte Embeddings in vektorielle Repräsentationen umgewandelt. Diese Vektoren bilden semantische Merkmale der Dokumente ab und geben dem Modell die Möglichkeit, inhaltlich ähnliche Dateien zu finden.

Ein bedeutender Vorteil dieser Methode ist die Fähigkeit des Systems, auch versteckte oder indirekte Zusammenhänge zu erkennen. Wenn zum Beispiel ein Nutzer nach Rechnungen aus dem Jahr 2023 sucht, kann das Modell die relevanten Dateien identifizieren, auch wenn sie nicht präzise so benannt sind. Um jedoch alle Inhalte lokal zugänglich zu machen, muss eine Vorverarbeitung erfolgen. Gerade bei Bilddateien oder Scans ist eine optische Zeichenerkennung (OCR) notwendig, um inhaltliche Informationen aus den Grafiken herauszuziehen. Mehrere Open-Source-Tools wie Tesseract können hierfür verwendet werden, allerdings ist die Integration dieser Schritte in eine vollautomatische Pipeline kein triviales Unterfangen.

Ein weiterer wichtiger Punkt ist die Performance und Hardware-Anforderungen. Viele moderne LLMs benötigen beträchtliche Rechenkapazitäten, darunter ausreichend Arbeitsspeicher und idealerweise GPUs, um auch flüssig und schnell Antworten liefern zu können. Für typische Laptops oder PCs ohne spezialisierte Hardware kann dies rasch zu einer Überforderung führen. Zudem wächst der Speicherbedarf mit der Anzahl der Dokumente und Dateien exponentiell, wenn diese umfangreich in Vektoren umgewandelt und indexiert werden. Die Suche mithilfe eines LLM kann also entweder auf kleinere Datenmengen oder auf effiziente Indexierungen begrenzt werden.

Trotzdem existieren bereits Ansätze und Projekte, die zeigen, dass diese Idee realisierbar ist. „AnythingLLM“ oder „Paperless-GPT“ sind Beispiele für Werkzeuge, die zumindest im Ansatz eine Kombination aus Dokumentenverarbeitung, OCR und KI-basierter semantischer Suche verfolgen. Sie sind zwar noch nicht voll ausgereift und oft noch nicht besonders benutzerfreundlich, demonstrieren aber das Potenzial künftiger Lösungen. Darüber hinaus wird von Entwicklern vorgeschlagen, große Mengen von Dateien vorab mit Methoden wie „FAISS“ oder „Milvus“ zu indexieren. Diese Systeme sind optimiert für die Suche in Vektorräumen und können somit den Abgleich mit den semantischen Embeddings der Dokumente massiv beschleunigen.

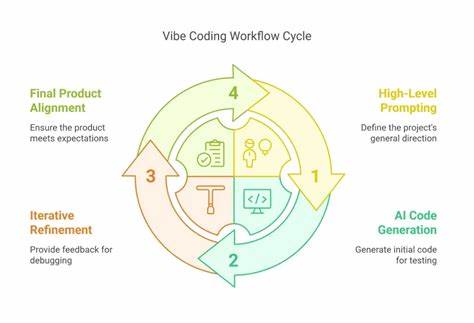

Auch der Einsatz kleinerer, quantisierter LLMs, die lokal ohne massive GPU-Ressourcen laufen können, wird zunehmend erforscht und verbessert. Eine weitere Perspektive liegt in der Kombination von klassischen Datei- und Metadatensuchen mit LLM-gestützter semantischer Suche. Während herkömmliche Suchsysteme blitzschnell exakte Treffer finden können, bringt das LLM Verständnis für Zusammenhänge und Synonyme mit ein, was die Treffergenauigkeit in komplexen Suchanfragen verbessert. Kurz gesagt: Die Vorstellung, ein Large Language Model auf dem eigenen PC als intelligente Suchlösung zu betreiben, ist technisch machbar, adressiert aber eine Reihe von Herausforderungen. Von der Umsetzung einer zuverlässigen und laufend aktualisierten Datenaufbereitung über OCR, der effizienten Erzeugung semantischer Embeddings bis hin zu Performance-Aspekten spielt vieles eine Rolle.

Aktuelle Systeme sind vor allem für Enthusiasten und Entwickler interessant, die bereit sind, Zeit und Ressourcen in den Aufbau solcher Lösungen zu investieren. Für den durchschnittlichen Nutzer fehlen bislang ausgereifte, einfache und ressourcenschonende Anwendungen. Die Technologie jedoch entwickelt sich rasant. Prognosen deuten darauf hin, dass mit steigender Hardware-Leistung und stetiger Optimierung der Modelle auch lokal nutzbare Systeme bald praktikabler werden. Apple, Microsoft und andere große Firmen zeigen bereits Interesse an Integration solcher Funktionen in ihre Betriebssysteme.

Hierdurch könnten komplexe Suchen nach Dokumenten, Bildern, Mails und anderen Dateien bald intuitiv per natürlicher Sprache durchgeführt werden, ohne die Grenzen klassischer Dateisuchsysteme. Während die Zukunft spannend bleibt, ist es für jeden Nutzer sinnvoll, schon heute seine Daten durchgängig zu strukturieren, Backup-Strategien zu verfolgen und mit einigen KI-gestützten Tools zu experimentieren, wenn der Wunsch nach einer besseren Suchfunktion besteht. Projekte wie LangChain, Tesseract oder Open-Source-Vektordatenbanken sind dabei erste Bausteine auf dem Weg zu einer neuen Ära der lokalen Dateisuche. So gesehen könnte ein großes Sprachmodell schon bald mehr sein als ein reiner Chatbot – es könnte zum persönlichen Assistenten für das eigene digitale Archiv avancieren und das Auffinden längst vergessener Dateien erheblich erleichtern.