Erinnerung ist eine der faszinierendsten und komplexesten Fähigkeiten des menschlichen Gehirns. Sie ermöglicht es uns, Informationen nicht nur zu speichern, sondern auch auf Abruf abzurufen und mit neuen Eindrücken zu verknüpfen. Die Art und Weise, wie unser Gehirn Erinnerungen verarbeitet und Energie dabei eine entscheidende Rolle spielt, ist Gegenstand intensiver wissenschaftlicher Forschung. Ein neuer Ansatz in der Erforschung neuronaler Netzwerke verändert das klassische Verständnis von Gedächtnis und signalisiert einen Paradigmenwechsel, der weitreichende Folgen für die Zukunft künstlicher Intelligenz haben könnte. Die Idee des assoziativen Gedächtnisses erklärt, wie ein kleiner Anhaltspunkt - wie die ersten Töne eines vertrauten Liedes - die Erinnerung an das komplette Lied auslösen kann.

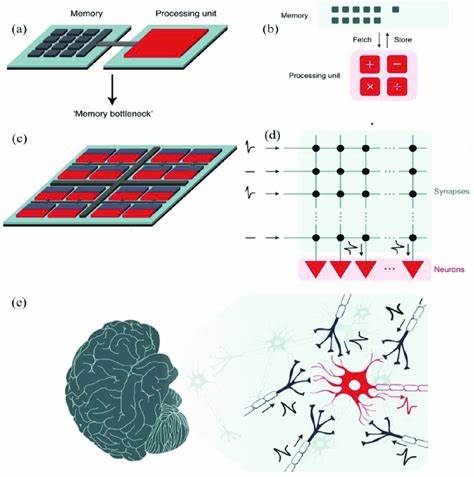

Dieses Konzept demonstriert, wie unsere Gehirnneuralnetzwerke funktionieren: Nicht eine einzelne Nervenzelle hält die Erinnerung, sondern ein dynamisches Netzwerk aus vielen miteinander verknüpften Neuronen ermöglicht Speichern und Abrufen. Diese wissenschaftliche Erkenntnis bildet die Basis vieler Entwicklungen im Bereich der künstlichen Intelligenz. Ein Meilenstein in der mathematischen Beschreibung dieses Phänomens war die Entwicklung des Hopfield-Netzwerks im Jahr 1982 durch den Physiker John Hopfield. Das Hopfield-Netzwerk ist ein rekurrentes künstliches neuronales Netzwerk, das dafür bekannt ist, vollständige Muster auch aus unvollständigen oder verrauschten Eingabedaten heraus abzurufen. Dieses Modell stellte einen quantitativen Rahmen dar, mit dem man die biophysikalischen Prozesse des Gedächtnisses besser verstehen konnte.

Für diese innovative Arbeit erhielt Hopfield 2024 den Nobelpreis, was dessen Bedeutung unterstreicht. Obgleich das klassische Hopfield-Modell mächtig ist, gibt es Bereiche, in denen es an Erklärungskraft fehlt. Insbesondere die Rolle externer Reize oder Inputs bei der Steuerung des Erinnerungsabrufs wurde bisher nur unzureichend erforscht. Die Dynamik, wie eingehende Informationen das neuronale Netzwerk beeinflussen und aktiv Veränderungen im Speicher- und Abrufprozess herbeiführen, war bislang kaum Gegenstand von theoretischen Modellen. Diesem Punkt sind Forscher der Universität Padua in Italien nachgegangen und haben mit dem Input-Driven Plasticity Modell (IDP) einen frischen, erklärungsstarken Ansatz präsentierte.

Das IDP-Modell rückt den Einfluss von externen Eindrücken auf die Energie-Landschaft des neuronalen Systems in den Fokus. Traditionell wurde die Erinnerung als eine Energie-Minimum-Landschaft vorgestellt, in der bekannte Erinnerungen stabile Täler darstellen, in die das System „hineinfällt“, wenn es sich dem gesuchten Gedächtnis nähert. Der Ausgangspunkt auf dieser Landschaft entspricht der aktuellen Reizsituation. Das Problem beim klassischen Modell ist jedoch, dass es nicht ausreichend erklärt, wie der Stimulus das System an den richtigen Startpunkt führt oder wie sich die Energie-Landschaft durch den Reiz selbst verändert. Das IDP-Modell schlägt vor, dass externe Reize das neuronale Energie-Landschaftsprofil während des Abrufs aktiv verändern.

Ein Beispiel: Wenn man nur den Schwanz einer Katze sieht, verändert dieser Stimulus gleichzeitig die neuronale Energie-Landschaft so, dass das System unabhängig vom bisherigen Ausgangspunkt immer zum vollständigen „Katzen“-Gedächtnis-Tal gleitet. Das Modell integriert dabei kontinuierlich neue Informationen mit bisherigen Erinnerungen und macht so den Abrufprozess dynamischer und realitätsnaher. Auch unter Bedingungen von verrauschten oder unvollständigen Daten bleibt das Modell robust und nutzt das Rauschen sogar, um weniger stabile Erinnerungen auszusortieren. Diese theoretische Umsetzung spiegelt den Prozess wider, wie unser Gehirn tatsächlich Erinnerungen schafft. Unsere Wahrnehmung der Welt ist kein statisches Bild, sondern ein kontinuierlicher Fluss, der von wechselnder Aufmerksamkeit und Fokus gelenkt wird.

Das Auswählen, auf welchen Reiz wir uns konzentrieren, stellt das zentrale Element unserer Erinnerung dar. Dies wird auch als Aufmerksamkeit oder Fokussierung bezeichnet, ein Prinzip, das gleichfalls die moderne Transformer-Architektur in der Computertechnik prägt. Transformer bilden das Rückgrat vieler großer Sprachmodelle, die in den letzten Jahren für Aufsehen gesorgt haben, darunter Systeme wie ChatGPT. Obwohl das IDP-Modell und transformerbasierte Systeme unterschiedliche Ursprünge und Zielsetzungen haben, besteht Hoffnung, dass diese Ansätze zukünftig miteinander verbunden werden können. Das IDP-Modell zeigt, dass eine dynamische Integration von externen Inputs und internen Gedächtnisstrukturen möglich ist und wie dadurch ein fließender, realitätsnäherer Gedächtnisprozess entsteht.

Dies könnte neue Wege eröffnen, um künstliche Systeme zu entwickeln, die menschlicheres Lernen und Erinnern simulieren. Ein weiterer interessanter Aspekt ist die Verbindung zwischen diesem Modell und den Prinzipien der Neuroplastizität, der Fähigkeit des Gehirns, sich durch Erfahrungen und Reize umzustrukturieren und zu verändern. Das IDP-Modell betont, wie das Zusammenspiel von neu eingeprägten Informationen mit gespeicherten Mustern das neuronale Netzwerk verformt und damit eine flexiblere und anpassungsfähigere Gedächtnisleistung ermöglicht. Diese Verknüpfung von Energie, Gedächtnis und plastischer Informationsverarbeitung ist ein spannendes Forschungsfeld, das viele interdisziplinäre Anwendungen verspricht. Im Kontext der Künstlichen Intelligenz eröffnet diese neue Perspektive zahlreiche Möglichkeiten.

Algorithmen, die bislang auf statischen Modellen basieren, könnten durch dynamische, input-getriebene Mechanismen ergänzt werden, um flexiblere, robustere und realitätsnähere Systeme zu schaffen. Machine-Learning-Modelle, die nicht nur starr auf vorgegebene Datenmuster reagieren, sondern kontinuierlich ihre interne Landschaft anpassen, könnten besser mit unvorhersehbaren oder verrauschten Daten umgehen und menschliche Gedächtnisprozesse authentischer nachahmen. Zusammenfassend markiert das Input-Driven Plasticity Modell einen bedeutenden Schritt in der Entwicklung von neuronalen Netzwerken, die sich an biologischen Prinzipien orientieren. Das Verständnis, wie externe Reize die neuronale Energie-Landschaft verändern und so den Gedächtnisabruf beeinflussen, fördert nicht nur das grundsätzliche Wissen über unser Gehirn, sondern gibt auch neue Impulse für die Gestaltung intelligenter Maschinen. Zukunftsweisende Forschungen werden sicherlich diese Verknüpfungen zwischen Energie, Erinnerung und Lernen weiter vertiefen und helfen, künstliche Intelligenz-Systeme zu entwickeln, die auf menschliche Denkprozesse noch stärker abgestimmt sind.

Die wissenschaftliche Gemeinschaft steht damit vor einer spannenden Herausforderung: Wie lassen sich diese neuen Erkenntnisse praktisch in Technologie übersetzen, um kognitive Maschinen zu schaffen, die erleben, erinnern und lernen – ähnlich wie wir Menschen? Die Antwort darauf wird vermutlich die nächste Generation intelligenter Systeme prägen und den Weg zu einer engeren Symbiose von menschlicher und künstlicher Intelligenz ebnen.