Die rasante Weiterentwicklung Künstlicher Intelligenz hat in den letzten Jahren viele neue Technologien hervorgebracht, die unsere Art der Informationsbeschaffung und -verarbeitung grundlegend verändern. Im Zentrum des Interesses stehen sogenannte Large Language Models (LLMs), die durch ihre Fähigkeit, natürliche Sprache zu verstehen und zu generieren, vielfältige Anwendungsbereiche revolutionieren. Eine der spannendsten Entwicklungen auf diesem Gebiet ist das Format llms.txt, das speziell darauf ausgelegt ist, Webinhalte für LLMs zugänglicher und verständlicher zu machen. Doch ist der Nutzen von llms.

txt wirklich so groß, wie viele behaupten, oder handelt es sich hier nur um einen weiteren kurzlebigen Trend im Bereich der KI? Um diese Frage zu beantworten, lohnt es sich, den Hintergrund, die technischen Grundlagen sowie die praktischen Erfahrungen aus der Branche genauer zu betrachten. Zunächst einmal ist es wichtig, die grundlegende Idee hinter llms.txt zu verstehen. Dieses einfache Textdateiformat zielt darauf ab, Webinhalte so aufzubereiten, dass LLMs deutlich effizienter und mit weniger Rechenaufwand darauf zugreifen und diese verarbeiten können. Herkömmliche Webseiten sind oft mit komplexem HTML, JavaScript und CSS gestaltet, was für traditionelle Suchmaschinenoptimierung (SEO) optimiert ist, jedoch nicht unbedingt ideal für KI-Modelle, die klare, strukturierte und vereinfacht dargestellte Informationen bevorzugen.

Hier setzt llms.txt an: Indem es Inhalte in einer reduzierten und gut strukturierten Form bereitstellt, kann es den Tokenverbrauch reduzieren, die Verarbeitungsgeschwindigkeit erhöhen und somit Kosten sparen. Ein häufiger Kritikpunkt an llms.txt ist, dass viele LLM-Anbieter bislang keine einheitliche Implementierung dieser Standards zeigen. Es wird argumentiert, dass allgemeine SEO-Praktiken wie die Pflege einer Sitemap bereits ausreichend für die Sichtbarkeit und Auffindbarkeit von Inhalten seien.

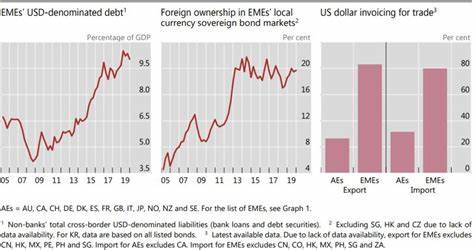

Jedoch belegen konkrete Daten aus dem Bereich der Generativen Engine Optimization (GEO), dass die Anforderungen von LLMs deutlich von denen traditioneller Suchmaschinen abweichen. Unternehmen wie Vercel verzeichnen beispielsweise einen bedeutenden Anteil von Anmeldungen, die direkt aus KI-generierten Suchanfragen resultieren, welche durch gezielte GEO-Maßnahmen – und nicht durch klassische SEO – erzielt wurden. Des Weiteren zeigt die Integration von llms.txt durch Technologiegiganten wie Google im Rahmen des Agents to Agents (A2A) Protokolls, dass auch Pioniere der digitalen Informationsverarbeitung die Notwendigkeit spezieller Optimierungen für KI erkennen und fördern. Das verdeutlicht, dass die Vorteile von llms.

txt nicht nur theoretisch sind, sondern bereits in der Praxis wertvolle Anwendungsfälle gefunden haben. Ein weiterer Durchbruch in der Entwicklung war die Einführung von llms-full.txt, einer erweiterten Variante, die nicht nur URLs zur Indexierung bereitstellt, sondern den gesamten reinen Textinhalt in einem einzigen Markdown-Dokument zusammenfasst. Diese Innovation wurde in Zusammenarbeit mit Anthropic entwickelt, einem führenden KI-Unternehmen, das mit seinem Modell Claude aktiv auf solche Standards setzt. Der Vorteil eines solchen Formats liegt darin, dass für die Verarbeitung durch LLMs kein mühsames Parsen von HTML-Strukturen mehr notwendig ist, was Zeit und Rechenressourcen spart.

Die wachsende Akzeptanz von llms-full.txt unterstreicht die Relevanz eines vereinfachten Zugangs zu Inhalten für moderne KI-Systeme. Doch wie wirken sich diese Entwicklungen auf Unternehmen und Webseitenbetreiber konkret aus? Wer heute seine Inhalte nicht nur für menschliche Leser, sondern auch für KI-Systeme zugänglich machen möchte, kann von llms.txt erheblich profitieren. KI wird immer mehr zu einem zentralen Kanal, über den Menschen Informationen abrufen und Entscheidungen treffen.

Das bedeutet, dass Unternehmen, die ihre Dokumentationen, Produktinformationen oder Blogs für LLMs optimieren, potenziell eine größere Reichweite und bessere Interaktionsraten erzielen können. Das ist ein deutlicher Wettbewerbsvorteil, der in naher Zukunft zur Norm werden dürfte. Diese Verschiebung hin zu KI-orientierter Inhaltsoptimierung erfordert allerdings auch ein Umdenken. Klassische SEO-Strategien sind nach wie vor wichtig, doch sie reichen allein nicht mehr aus. Die Inhalte müssen so gestaltet sein, dass sie aus Sicht von LLMs logisch strukturiert, klar formuliert und möglichst einfach zu extrahieren sind.

Dazu gehört häufig, Inhalte in Markdown oder anderen vereinfachten Textformaten bereitzustellen sowie technische Standards wie llms.txt oder llms-full.txt zu implementieren. Die Investition in solche Maßnahmen zahlt sich nicht nur durch eine bessere Auffindbarkeit in KI-gestützten Systemen aus, sondern fördert gleichzeitig auch die Usability für menschliche Nutzer durch klarere Strukturierung und bessere Übersichtlichkeit. Die Entwicklung von Effizienz- und Interaktionsstandards wie dem Model Context Protocol (MCP) zeigt bereits, dass die Zukunft der KI-Integration nicht nur beim passiven Lesen von Inhalten endet.

Vielmehr bewegt sich die Branche dahin, dass LLMs künftig direkt mit Produkten interagieren und Aufgaben im Namen der Nutzer erledigen können. llms.txt, llms-full.txt und ähnliche Formate bilden dabei die Grundlage, indem sie gewährleisten, dass die zugrundeliegenden Informationen klar, aktuell und einfach zugänglich sind. Zukunftsorientiert betrachtet bietet llms.

txt nicht nur eine momentane technische Lösung, sondern symbolisiert einen Paradigmenwechsel im Umgang mit digitalen Inhalten. Die Rücksichtnahme auf KI-Systeme als Teil der eigenen Zielgruppe wird immens an Bedeutung gewinnen. Unternehmen sind gut beraten, sich frühzeitig mit den Standards und Werkzeugen vertraut zu machen, um langfristig wettbewerbsfähig zu bleiben und die Chancen, die KI bietet, optimal zu nutzen. Zusammenfassend lässt sich sagen, dass die Einführung von llms.txt und verwandten Formaten kein Hype ohne Substanz ist.