In der sich rasant entwickelnden digitalen Welt gewinnt Künstliche Intelligenz zunehmend an Bedeutung, besonders im Bereich der Suche im Internet. Während bisher klassische Suchmaschinen wie Google dominierten, verschiebt sich der Fokus immer stärker hin zu KI-basierten Sprachmodellen und intelligenten Chatbots, die Inhalte dynamisch generieren und präsentieren. Diese Entwicklung stellt Website-Betreiber sowie SEO-Spezialisten vor völlig neue Herausforderungen. Eine Antwort auf diese Anforderungen ist die Einführung einer speziellen Datei namens llms.txt, die das Verständnis von Websites durch große Sprachmodelle verbessern soll und damit künftig eine wichtige Rolle für die Generierung relevanter Suchergebnisse einnehmen wird.

Das Konzept der llms.txt ist vergleichbar mit der früheren Einführung von robots.txt, die den Umgang von Suchmaschinen mit Webseiten regelte. llms.txt ist als ein einfaches, aber äußerst wirkungsvolles Tool gedacht, um großen Sprachmodellen, kurz LLMs, eine strukturierte und klare Übersicht über den wichtigsten Inhalt einer Website zu bieten.

Die Idee wurde im September 2024 von Jeremy Howard, Mitbegründer von Answer.AI, vorgeschlagen und hat innerhalb kürzester Zeit bei verschiedenen Technologieunternehmen und Entwicklungsplattformen Anklang gefunden. Die Herausforderung lag darin, dass KI-Systeme beim Durchforsten einer Website oft mit überflüssigen oder irrelevanten Inhalten konfrontiert werden, die sie vom Wesentlichen ablenken. Anders als Menschen können sie nicht intuitiv Navigationselemente oder Werbung ignorieren und verschwenden somit wertvollen Kontextspeicherplatz.Genau hier setzt llms.

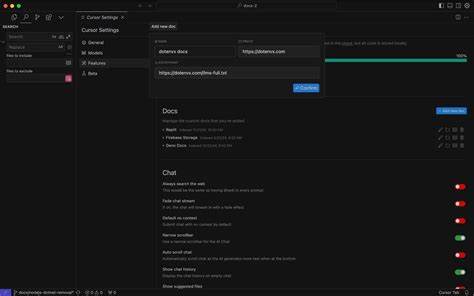

txt an. Als eine Art digitaler Reiseführer zeigt die Datei der KI die Inhalte, die wirklich relevant sind, und ordnet sie sinnvoll nach Kategorien. Bei der Erstellung eines llms.txt-Dokuments wird eine einfache Markdown-Struktur verwendet, die leicht lesbar für Menschen und maschinenlesbar zugleich ist. Üblicherweise beginnt die Datei mit einem Haupttitel, der den Namen der Website oder des Unternehmens trägt, gefolgt von einer kurzen Zusammenfassung, die in einem Blockzitat steht und den Zweck der Seite prägnant beschreibt.

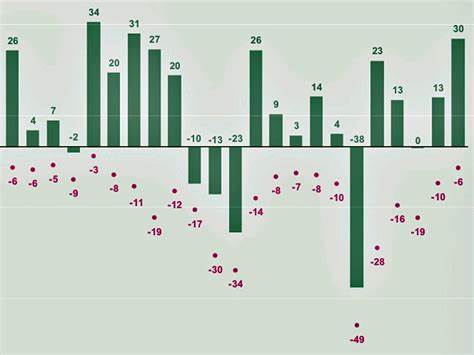

Untergeordnet finden sich dann verschiedene thematische Abschnitte wie Dokumentation, Produktübersicht oder FAQ mit Links und erklärenden Beschreibungen zu den jeweiligen Unterseiten. Auf diese Weise ermöglicht es llms.txt der Künstlichen Intelligenz, eine präzise Vorstellung vom Aufbau und Angebot der Website zu erhalten, ohne sich durch irrelevante Inhalte kämpfen zu müssen.Die Vorteile für SEO sind vielschichtig und reichen weit über eine einfache Optimierung der Sichtbarkeit hinaus. Angesichts der Tatsache, dass zunehmend mehr Internetnutzer direkt mit KI-gesteuerten Assistenten kommunizieren, wird die Fähigkeit eines Sprachmodells, eine Website korrekt und umfassend zu interpretieren, zum entscheidenden Wettbewerbsfaktor.

Eine korrekt implementierte llms.txt-Datei kann dazu beitragen, dass Antworten zu Produkten, Dienstleistungen oder Unternehmensinformationen, die ein Nutzer von einer KI erhält, präziser, aktueller und relevanter ausfallen. Die Folge ist eine verbesserte Nutzererfahrung, die wiederum zu höherem Vertrauen und letztlich zu mehr Traffic und höherer Konversionsrate führen kann.Im Gegensatz zu etablierten Dateien wie robots.txt und sitemap.

xml hat llms.txt eine deutlich andere Aufgabe. Während robots.txt steuert, welche Bereiche einer Website von Suchmaschinen durchsucht werden dürfen und sitemap.xml sämtliche indexierbaren URLs systematisch auflistet, bietet llms.

txt eine gezielte inhaltliche Anleitung speziell für große Sprachmodelle. Es wird nicht einfach die komplette Seitenstruktur abgebildet, sondern eine strategisch kuratierte Auswahl an Inhalten und Zusammenhängen, die für die AI-basierten Suchmaschinen von hohem semantischen Wert sind. Die Kombination aller drei Dateien ermöglicht deshalb ein deutlich ganzheitlicheres und effektiveres Management der Website-Interaktion mit verschiedenartigen Suchtechnologien.Die praktische Umsetzung von llms.txt ist unkompliziert und erfordert keine tiefgreifenden technischen Vorkenntnisse.

Website-Besitzer können die Datei mit jedem einfachen Texteditor erstellen, indem sie das beschriebene Format einhalten. Nach dem Hochladen in das Stammverzeichnis der Seite ist die Datei unter einer eindeutigen URL wie www.beispielseite.de/llms.txt erreichbar.

Für größere Websites oder multilingualen Content existieren weiterführende Konzepte, beispielsweise die Nutzung von sprachspezifischen Varianten wie llms.en.txt oder die automatische serverseitige Generierung der Datei, die bei häufig wechselnden Inhalten sinnvoll sein kann. Zudem haben sich inzwischen praktische Tools und Generatoren etabliert, die den Prozess automatisieren und vereinfachen, sodass selbst ohne großen Zeitaufwand hochwertige und optimierte llms.txt-Dateien entstehen.

Bei der Verwendung von llms.txt sollten wichtige Fehlerquellen vermieden werden. Ein häufiger Irrtum besteht darin, einfach die gesamte Sitemap oder das komplette Seitenverzeichnis unverändert hineinzukopieren. Vielmehr geht es darum, die relevantesten Inhalte selektiv und verständlich zu präsentieren. Komplexe Formatierungen sind kontraproduktiv, da sie die maschinelle Verarbeitung erschweren können.

Ebenso wichtig sind präzise und aussagekräftige Beschreibungen zu jedem Link, damit die KI den Kontext besser erfassen kann. Außerdem sollte die Datei regelmäßig gepflegt und aktualisiert werden, um stets aktuelle Informationen und keine veralteten Inhalte zu vermitteln. Der Schutz sensibler Daten ist ebenfalls ein Aspekt, da die Datei öffentlich zugänglich ist und daher nur für öffentliche Inhalte verwendet werden darf.Obwohl llms.txt derzeit noch kein offiziell genormter Webstandard ist und große LLM-Anbieter sich bisher nicht offiziell zur Nutzung verpflichten, sprechen die zunehmenden Implementierungen und das Interesse der Industrie eine deutliche Sprache.

Vor allem Tech-Firmen, Entwicklerplattformen und Dienstleister für Dokumentationen gehören zu den Vorreitern. Die Leichtigkeit der Erstellung und die potenziell großen Vorteile machen llms.txt zu einer attraktiven Methode, sich frühzeitig und proaktiv auf die zunehmende Bedeutung KI-basierter Suche vorzubereiten.Ein weiterer entscheidender Punkt ist die Rolle von llms.txt bei der Vermeidung von Fehlinformationen durch KI-Modelle.

Immer wieder kann es vorkommen, dass Sprachassistenten veraltete oder ungenaue Angaben zu einem Unternehmen wiedergeben, weil die zugrundeliegenden Datenquellen unzureichend gefiltert oder strukturiert sind. Durch die gezielte Steuerung über llms.txt lässt sich dieses Risiko minimieren, weil die KI bevorzugt auf die aktuellste und relevanteste Dokumentation sowie auf gültige Richtlinien und Bedingungen hingewiesen wird. Dadurch entsteht für den User ein deutlich zuverlässigerer Informationsfluss und für die Website eine bessere Wahrnehmung als seriöse, gut gepflegte Informationsquelle.Blickt man in die Zukunft, so sind weitere Entwicklungen rund um llms.

txt zu erwarten. Experten diskutieren bereits über mögliche Standardisierungen, Validierungswerkzeuge oder eine Integration mit weiteren Webprotokollen. Für große, dynamische E-Commerce-Plattformen und umfangreiche Content-Ökosysteme könnten automatisierte Systeme zur Pflege und Aktualisierung dieser Dateien zur Notwendigkeit werden. Zudem wird man vermutlich verstärkt auf Mehrsprachigkeit und feingranulare Inhaltskategorien setzen, um die Bedürfnisse internationaler Nutzer und komplexer Inhalte abzudecken.Für Website-Betreiber, die ihre Chancen in der kommenden Ära der KI-getriebenen Suche wahren wollen, ist der Einstieg in das Thema llms.

txt ein strategisch kluger und vergleichsweise leichter Weg. Die Investition an Zeit und Ressourcen ist überschaubar, die potenziellen Erträge jedoch substantiell. Die Entwicklung hat Parallelen zu Zeiten der mobilen Optimierung oder der Einführung strukturierter Daten. Wer hier frühzeitig adaptierte, konnte sich entscheidende Wettbewerbsvorteile sichern. Derzeit kann man von einem ähnlichen Trend sprechen, bei dem „early adopters“ einen Vorsprung im scheinbar noch offenen Feld der KI-Suchtechnik haben.