Die Entscheidung für die richtige Datenbanktechnologie ist eine der zentralen Herausforderungen für wachsende Unternehmen. Während verteilte Systeme wie CockroachDB mit ihren innovativen Ansätzen zur horizontalen Skalierung punkten, zeigen sich im Praxisalltag oft unerwartete Schwierigkeiten. Viele Teams stehen gut skalierenden Lösungen gegenüber, die jedoch mit wachsendem Datenvolumen und komplexeren Anforderungen teurer werden und an ihre Grenzen stoßen. Ein überzeugendes Beispiel dafür ist die Migration von CockroachDB zu PostgreSQL, wie sie bei Motion, einem innovativen Unternehmen im Bereich KI-gestützter Workflow-Lösungen, stattfand. Die Hintergründe, Erfahrungen und Erkenntnisse dieser Migration bieten wertvolle Anhaltspunkte für Entwickler und Entscheider, die vor einer ähnlichen Herausforderung stehen.

Zu Beginn der Nutzung von CockroachDB im Jahr 2022 standen die Vorteile klar im Vordergrund. Das System bot eine problemlose horizontale Skalierung speziell für Multi-Region-Szenarien, was in Zeiten zunehmender Datenschutzauflagen wie der DSGVO besonders wichtig erscheint. Gleichzeitig glänzte CockroachDB mit hervorragender Verfügbarkeit und einer SQL-kompatiblen Oberfläche, die den Einstieg erleichterte. Dennoch blieben zunächst Zweifel, ob diese Eigenschaften für alle erwarteten Nutzungsszenarien wirklich notwendig waren. Gerade in Phasen mit überschaubarem Datenaufkommen und einfachen Transaktionsanforderungen erschien die Komplexität eines verteilten Datenbankclusters unnötig.

Mit dem Wachstum des Unternehmens stiegen jedoch nicht nur die Anforderungen, sondern auch die Kosten dramatisch an. Bis 2024 multiplizierten sich die Ausgaben für CockroachDB auf ein mittleres sechsstellige Niveau. Zu diesem Preis kamen teils gravierende technische Grenzen hinzu, die den alltäglichen Betrieb beeinflussten. Insbesondere bei Migrationen stellte sich die Instabilität als kritisch heraus. Das Team von Motion nutzte das Object-Relational Mapping-Tool Prisma, welches wiederholt Zeitüberschreitungen beim Ausführen von Migrationen erlebte.

Dies führte dazu, dass DBA-gestützte manuelle Eingriffe notwendig wurden, was den Deployment-Prozess über Stunden lähmte und eine Blockade des Systems bedeutete. Der Umstieg auf PostgreSQL veränderte diese Situation dramatisch. Während bei CockroachDB einfache Schemaänderungen Minuten bis Stunden mit manuellen Maßnahmen erforderten, konnten vergleichbare Migrationen unter PostgreSQL innerhalb von Sekunden ausgeführt werden – selbst bei identischer Datenmenge. Dieses schnelle Feedback führte zu deutlich mehr Sicherheit und einem stabileren Entwicklungsworkflow. Entwickler konnten sich wieder auf die Datenbank verlassen und mussten keine operativen Kompromisse mehr eingehen, um das Risiko von Systemausfällen zu umgehen.

Die zeitlichen Engpässe beschränkten sich nicht nur auf Migrationen. Auch der Betrieb von ETL-Prozessen litt erheblich unter den Limitierungen von CockroachDB. Das Team verzeichnete häufige Abbrüche und Speicherlecks bei Airbyte, einem der wenigen verfügbaren Connectoren zur Cockroach-Replikation. Da diese Probleme sich nicht zufriedenstellend lösen ließen, entschloss man sich, maßgeschneiderte ETL-Pipelines zu entwickeln, basierend auf einem Streaming-Ansatz mit CSV-Daten. Dieses pragmatische Vorgehen trug maßgeblich dazu bei, dass der Datenumzug schließlich trotz der technologischen Hürden in einem überschaubaren Zeitrahmen möglich wurde.

Im direkten Leistungsvergleich von Abfragen zeigte CockroachDB seine Stärken insbesondere bei bestimmten komplexen Aggregationen, bei denen sein Optimierer schnellere Pläne erstellte als PostgreSQL. Jedoch überwog die Zahl der Fälle, in denen Cockroach aufgrund der Umständlichkeit der von Prisma generierten SQL-Abfragen nachteilhaft agierte. Die Abfragen zeichneten sich durch zahlreiche Joins und verschachtelte Bedingungen aus, die Cockroach zu Volltabellenscans zwangen. PostgreSQL hingegen bewältigte dieselben Anfragen oft mit deutlich besseren Zugriffspfaden. So konnten Ladezeiten um das bis zu Zwanzigfache reduziert werden, was sich unmittelbar auf die User Experience auswirkte.

Nachteilig wirkte sich bei CockroachDB die Verwaltung von Indizes und laufenden Abfragen aus. So zeigte das Cockroach UI teils verwirrende Empfehlungen, ungeachtet des faktischen Indexgebrauchs. Zudem erforderten das Abbrechen kostspieliger Abfragen oder die Lösung von Problemen teilweise den direkten Zugriff auf das Cockroach-Admin-Interface, was im Vergleich zu PostgreSQL mit seiner einfachen Abbruchmöglichkeit über Clients wie TablePlus umständlicher war. Solche operativen Hürden beanspruchten unnötig Zeit und Aufmerksamkeit der Entwickler. Ein weiterer subtiler, aber belastender Faktor waren die wiederkehrenden VPC-Konnektivitätsprobleme.

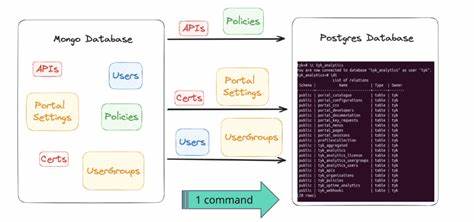

Tailscale-Verbindungen zum Cockroach Cluster brachen unerwartet ab und kompromittierten dabei verschiedene Umgebungen – einschließlich Entwicklungs- und CI-Systemen. Trotz intensiver Fehlersuche konnte das Team keine dauerhafte Lösung finden. Mit PostgreSQL traten derartige Probleme nicht mehr auf, was die Stabilität und Zuverlässigkeit der Infrastruktur spürbar verbesserte. Die eigentliche Migration wurde von einer einzigen Person verantwortet, die mithilfe moderner Tools und eines schlanken ETL-Skripts – entwickelt mit dem vielversprechenden JavaScript-Framework Bun – sämtliche Daten in Strömen von CockroachDB nach PostgreSQL transferierte. Dabei musste speziell auf die unterschiedlichen Datentypkodierungen zwischen den Systemen, etwa bei JSON oder Array-Spalten, Rücksicht genommen werden.

Die Nachbearbeitung der Datenformate erforderte zusätzliche Entwicklungsarbeit, konnte aber automatisiert abgebildet werden. Dank sorgfältiger Tests und der Wahl einer großen VM für den finalen Umzug konnte die Unterbrechungszeit auf weniger als eine Stunde begrenzt werden, ohne dass Daten verloren gingen oder die Verfügbarkeit langfristig eingeschränkt wurde. Im Anschluss an die Migration verbesserte sich die Performance der gesamten Anwendung zügig. Bereits erste Optimierungen der SQL-Abfragen mittels PostgreSQL-spezifischer Tools zeigten, dass noch erhebliches Potenzial bestand, um die Abfragen weiter zu beschleunigen und damit die Nutzerzufriedenheit weiter zu erhöhen. Gleichzeitig führte der Wechsel zu einer Kosteneinsparung von über 100.

000 US-Dollar jährlich, was besonders angesichts des erwarteten weiteren Wachstums der Plattform von großer Bedeutung ist. Zusammenfassend zeigt die Erfahrung von Motion, dass eine Migration von einer verteilten Datenbank zu einem bewährten relationalen System wie PostgreSQL unter bestimmten Rahmenbedingungen nicht nur technisch möglich, sondern auch wirtschaftlich sinnvoll sein kann. Die Einfachheit im Betrieb, die robuste Performance bei typischerweise verwendeten ORM-Generierten Abfragen und die deutlich geringeren Betriebskosten stellen starke Argumente dar. Dennoch sollten Entscheider auch die Grenzen und Herausforderungen im Blick behalten, die mit großen Datenbeständen und verteilten Systemen einhergehen. Wer als Entwickler oder Unternehmen vor der Wahl steht, welche Datenbanktechnologie am besten zu den eigenen Anforderungen passt, kann aus den geschilderten Erfahrungen lernen.

Insbesondere in Szenarien ohne zwingende Multi-Region-Anforderungen bietet PostgreSQL eine leistungsfähige und kosteneffiziente Alternative zu modernen verteilten Lösungen. Gleichzeitig unterstreicht das Beispiel, wie wichtig es ist, die eigene Infrastruktur regelmäßig zu überprüfen und technische Entscheidungen nicht aus der Angst vor zukünftigen Anforderungen zu treffen, sondern pragmatisch anhand aktueller Gegebenheiten und Benchmarks. Die Migration selbst ist ohne passende Tools und vorbereitende Tests kaum vorstellbar. Daher raten Experten dazu, ETL-Prozesse individuell zu gestalten und bei der Nutzung von ORMs auf die generierten Abfragen zu achten, um Performance-Fallen zu vermeiden. Ebenso empfiehlt es sich, nach einem Umzug unmittelbar systematische Optimierungen vorzunehmen, um von den vollen Vorteilen der neuen Datenbankplattform zu profitieren und nachhaltig Kosten zu sparen.

Noch wichtiger als die rein technischen Aspekte ist jedoch die Erkenntnis, dass solche Migrationen auch ein Prozess der kontinuierlichen Verbesserung und Anpassung sind. Unternehmen, die diesen Weg mit bedachter Planung und technischem Know-how beschreiten, können langfristig von stabileren Systemen, besseren Kostenstrukturen und zufriedeneren Nutzern profitieren. Die Erfahrungen von Motion dienen daher als praxisnahes Beispiel dafür, wie eine wohlüberlegte Migration den Grundstein für zukünftiges Wachstum legt und zugleich technische Schulden reduziert.