Die Geschichte der Datenkompression ist eine Geschichte stetiger Innovation, die seit mehr als acht Jahrzehnten die Grundlage für effiziente Informationsübertragung und Datenspeicherung bildet. Von den ersten Algorithmen über klassische Verfahren bis hin zu modernen Ansätzen hat sich die Kompression kontinuierlich weiterentwickelt. Doch die Fortschritte der letzten Jahre zeigen, dass traditionelle Methoden langsam an ihre Grenzen stoßen. Gleichzeitig wächst der Bedarf an immer schnelleren und effektiveren Kompressionstechniken, insbesondere im Licht der aufkommenden 6G-Kommunikation, die enorme Datenmengen in Bruchteilen von Sekunden übertragen soll. Eine bemerkenswerte Entwicklung in diesem Bereich ist das Verständnis, dass Verstehen und Lernen gleichbedeutend mit Kompression sind.

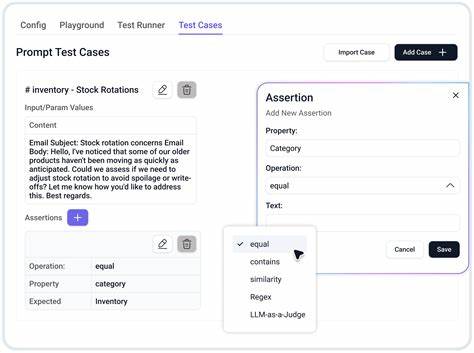

Diese Erkenntnis öffnet neue Türen für Ansätze, die große Modelle, wie sogenannte Large Language Models (LLMs), zur Datenkompression einsetzen. Die Grundidee dahinter ist, dass die Fähigkeit eines Modells, Muster zu erkennen und Informationen zu verstehen, direkt mit seiner Fähigkeit korreliert, Daten effizient zu komprimieren. Je besser das Modell die Struktur und den Inhalt der zu komprimierenden Daten erkennt, desto präziser und effektiver kann es die redundanten oder überflüssigen Informationen eliminieren. Die kürzlich veröffentlichte Forschung mit dem Projekt LMCompress hebt dieses Prinzip auf ein neues Level. LMCompress ist ein Kompressionsalgorithmus, der auf den Fähigkeiten großer Modelle basiert und zeigt, dass diese Modelle in der Lage sind, die herkömmlichen verlustfreien Kompressionsverfahren deutlich zu übertreffen.

In zahlreichen Tests konnte LMCompress die Kompressionsrate klassischer Formate erheblich verbessern. Bei Bildern übertraf es den Standard JPEG-XL, bei Audiodaten zeigte es bessere Ergebnisse als FLAC, und bei Videos setzte es sich sogar gegenüber H.264 durch, während es bei Textdaten die Kompressionsrate des bewährten bz2-Algorithmus vervierfachte. Dieser Durchbruch basiert auf einem neuen Paradigma, das das theoretisch unberechenbare Solomonoff-Induktionsmodell annähert. Solomonoff-Induktion beschreibt eine Methode, bei der alle möglichen Hypothesen über eine Datenquelle bewertet werden, um die wahrscheinlichste und somit optimalste Kompression zu erreichen.

Da Solomonoff-Induktion rein theoretisch nicht berechenbar ist, dienen große Modelle als praktikable Annäherung. Ihre Fähigkeit, komplexe Strukturen und Muster in Daten zu erfassen, erlaubt es ihnen, Daten mit einer Präzision zu kodieren, die bisherigen Algorithmen nicht möglich war. Der Erfolg von LMCompress illustriert auch den direkten Zusammenhang zwischen dem Verständnis eines Modells und seiner Kompressionsfähigkeit. Während traditionelle Algorithmen auf fest definierten Regeln und einfachen statistischen Modellen basieren, lernen große Modelle aus riesigen Datensätzen und entwickeln komplexe Repräsentationen der Daten. Dieses tiefgreifende Wissen ermöglicht es ihnen, wesentlich effizienter zu arbeiten, indem sie unwichtige Informationen ausfiltern und nur die relevanten Inhalte kodieren.

Eine wichtige Voraussetzung für die Leistungsfähigkeit großer Modelle ist die Verfügbarkeit von leistungsstarken Rechenressourcen und umfangreichen Trainingsdaten. Die Entwicklung und das Training dieser Modelle sind rechenintensiv und erfordern erheblichen Aufwand. Dennoch zeigt der Fortschritt, dass sich diese Investitionen lohnen, da die daraus resultierende Kompression nicht nur bessere Ergebnisse liefert, sondern auch neue Anwendungen ermöglicht, die bisher durch technische Beschränkungen limitiert waren. Die Auswirkungen dieser Innovationen sind weitreichend. In einer zunehmend digitalisierten Welt, in der täglich unglaubliche Datenmengen produziert, übertragen und gespeichert werden, sind effiziente Kompressionsverfahren entscheidend.

Die verbesserte Kompression durch große Modelle kann die Infrastruktur entlasten, die Kosten senken und die Geschwindigkeit von Datenübertragungen erheblich erhöhen. Besonders in Bereichen wie Video-Streaming, Cloud-Speicherung, mobilen Netzwerken und IoT-Anwendungen eröffnen sich enorme Vorteile. Darüber hinaus wird der steigende Bedarf an Kommunikationsgeschwindigkeiten durch die Einführung der 6G-Technologie eine verstärkte Nachfrage nach revolutionären Kompressionsmethoden generieren. Die 6G-Ära verspricht Datentransferraten, die bis zu hundertmal schneller sind als der aktuelle 5G-Standard. Solche Geschwindigkeiten erzeugen enorme Datenvolumina, die mit herkömmlichen Methoden kaum noch beherrschbar sind.

Hier kann der innovative Ansatz von LMCompress eine Schlüsselrolle spielen, um den Anforderungen gerecht zu werden und die Kommunikationsnetze zukunftsfähig zu machen. Neben den technischen Vorteilen wirft die Integration von großen Modellen in die Datenkompression auch ethische und sicherheitstechnische Fragen auf. Algorithmen, die auf maschinellem Lernen basieren, können unvorhersehbare Verhaltensweisen zeigen und erfordern eine sorgfältige Prüfung, um Datenschutz und Datensicherheit zu gewährleisten. Zudem ist sicherzustellen, dass die Modelle keine Vorurteile oder Verzerrungen aus den Trainingsdaten übernehmen, die zu unerwünschten Ergebnissen führen könnten. Trotz dieser Herausforderungen steht fest, dass der Schritt hin zu intelligenteren, modellbasierten Kompressionsmethoden ein Meilenstein ist.

Forscher und Entwickler arbeiten kontinuierlich daran, die Grenzen des Machbaren zu verschieben und praktische Implementierungen zu schaffen, die in realen Anwendungen eingesetzt werden können. Die Veröffentlichung der Forschungsergebnisse rund um LMCompress markiert einen Wendepunkt, der in den kommenden Jahren die Landschaft der Datenkompression grundlegend verändern wird. Zusammenfassend lässt sich sagen, dass das Verständnis von Daten der Schlüssel zu deren effizienter Kompression ist. Große Modelle, die durch komplexes Lernen ein immer besseres Verständnis entwickeln, können traditionelle Kompressionsalgorithmen hinter sich lassen und die Art und Weise, wie wir Daten speichern und übertragen, revolutionieren. Diese Entwicklung ist nicht nur ein technologischer Fortschritt, sondern bildet die Grundlage für eine neue Generation von Anwendungen und Netzwerken, die schneller, effizienter und intelligenter sind.

In der Ära der exponentiell wachsenden Datenmengen ist die Verschmelzung von Verständnis und Kompression der Weg in eine nachhaltige digitale Zukunft.

![Jeff Dean's talk at ETH Zurich in April 2025 on important trends in AI [video]](/images/76440C87-CE42-4647-B376-71F3D537DA19)