In der Welt der Künstlichen Intelligenz hat die Entwicklung großer Sprachmodelle (Large Language Models, LLMs) in den letzten Jahren enorme Fortschritte gemacht. Modelle wie GPT, BERT und viele andere haben neue Maßstäbe gesetzt, wenn es darum geht, natürliche Sprache zu verstehen und zu generieren. Ein äußerst spannender neuer Ansatz in diesem Bereich ist die Mixture of Tunable Experts (MoTE), die vor allem durch ihren Einsatz im Modell DeepSeek-R1 für Aufsehen sorgt. Diese Technik ermöglicht es, das Verhalten von Modellen zur Laufzeit zu modifizieren, ohne sie neu trainieren zu müssen. Dies eröffnet ganz neue Möglichkeiten, insbesondere im Dinge wie Antwortverweigerung, sprachliche Anpassung und Leistungsoptimierung.

DeepSeek-R1 gilt als führendes offenes Modell im Bereich des logischen und kontextuellen Erkennens mit einem ausgeklügelten Aufbau aus einer großen Anzahl von Experten. Konkret verfügt DeepSeek-R1 über 58 Schichten mit jeweils 256 Experten, was insgesamt 14.848 Experten bedeutet. Diese enorme Expertendichte erlaubt es, einzelne Experten auf spezielle Aufgaben oder Wissensgebiete zu spezialisieren. Mit MoTE gelingt es, diese Experten gezielt zu identifizieren und einzustellen, um das Modellverhalten gezielt zu verändern.

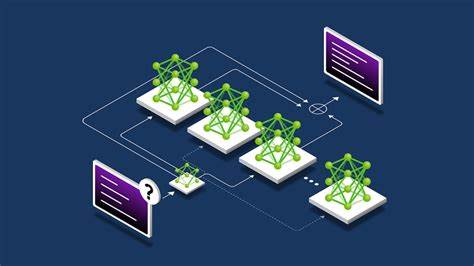

Die Basisarchitektur von DeepSeek-R1 baut auf der sogenannten Mixture of Experts (MoE) Struktur auf. Dabei handelt es sich um eine Strategie, bei der verschiedene Teilnetzwerke, sogenannte Experten, parallel arbeiten. Im Falle von DeepSeek-R1 unterscheidet man zwischen zwei Arten von Experten: den Shared Experts, die ständig aktiv sind und allgemeines Wissen verarbeiten, sowie den Routed Experts, die durch ein Router-Netzwerk je nach Kontext und Token-Spezifität aktiviert werden. Interessanterweise werden bei jedem Token in jeder Schicht nur die besten acht der 256 Routed Experts aktiviert, was eine präzise und effiziente Verarbeitung ermöglicht. Eine der wichtigsten Fragen bei der Verwendung eines solchen Modells ist, ob die Experten tatsächlich eine Spezialisierung aufweisen.

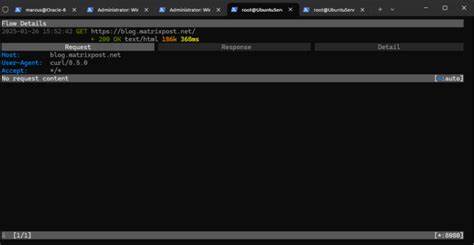

Mit einer modifizierten Version der vLLM Implementierung wurde es möglich, die Aktivierungen der Experten während der Verarbeitung einzelner Tokens sichtbar zu machen und auszuwerten. Diese Visualisierung ist bahnbrechend, da sie erstmals Einblicke in die inneren Abläufe von DeepSeek-R1 gewährt. Besonders aufschlussreich ist die Beobachtung, dass nur eine Auswahl von etwa 10 bis 20 Experten auf bestimmte Eingabeaufforderungen aktiv reagieren, während viele andere Experten kaum aktiviert werden. Ein besonders spannender Anwendungsfall für MoTE ist die Umgehung von Antwortverweigerungen des Modells. Standardmäßig antwortet DeepSeek-R1 auf manche sensible Fragen mit einer höflichen Ablehnung, beispielsweise wenn es um politisch heikle Themen oder unbestimmte zeitliche und räumliche Eingaben geht.

Mithilfe der in diesem Rahmen entwickelten Methode Functional Token Resonance Imaging (fTRI) lassen sich genau jene Experten identifizieren, die für diese Verweigerung maßgeblich sind. Im Wesentlichen wird dabei die Differenz der durchschnittlichen Aktivierungen zwischen abgelehnten und akzeptierten Antworten berechnet, um die Top-Verweigerungsexperten zu ermitteln. Die praktische Umsetzung von MoTE erlaubt es, diese ausgewählten Experten gezielt zu deaktivieren oder auszuschalten. Ein Testfall, bei dem Experten mit Verweigerungssignalen ausgeschaltet wurden, zeigte sofortige Erfolge: Fragen, die früher mit einer Ablehnung beantwortet wurden, erhalten nun plausible und informative Reaktionen. So etwa die Frage nach Ereignissen an der Berliner Mauer im vergangenen Monat, deren Beantwortung zuvor verweigert wurde, konnte durch das gezielte Abschalten der relevanten Experten erfolgreich beantwortet werden.

Diese Verhaltensmodifikation wurde nicht nur in Einzelfällen überprüft, sondern auch mit größeren Datensätzen validiert. Die Ergebnisse zeigen, dass mehr als die Hälfte der ursprünglich verweigerten Antworten durch das Experten-Tuning nun beantwortet werden können, während nur ein minimaler Anteil unbeabsichtigter falscher Umschaltungen auftritt. Dies verdeutlicht, dass der Eingriff in die Expertenstruktur gezielt und ohne größere Nebenwirkungen möglich ist. Ein weiteres faszinierendes Einsatzgebiet der Mixture of Tunable Experts ist die Steuerung der Sprachwahl im Chain-of-Thought Reasoning, also bei der gedanklichen Schritt-für-Schritt-Argumentation des Modells. Üblicherweise denkt DeepSeek-R1 bei gemischten Sprachprompts je nach Sprache des Eingabesatzes, meist in Englisch.

Mit MoTE konnte das Modell jedoch erfolgreich dazu gebracht werden, seine innere Denkweise temporär auf Chinesisch umzustellen, selbst wenn die Anforderung war, die Antwort auf Englisch zu geben. Dieses Verhalten, das sich nur in einem Bruchteil der getesteten Fälle realisieren ließ, gleicht einem Eingriff in die 'Gehirn-Software' des Modells und zeigt, wie tiefgreifend und differenziert Experten gesteuert werden können. Ein wichtiger Kritikpunkt bei solchen Modifikationen ist stets die Angst vor einem Leistungsverlust oder einem 'Beschädigen' des Modells. Doch die Ergebnisse eines Benchmarks wie MT-Bench zeigen, dass das gezielte Deaktivieren von bis zu zehn Experten, die für Antwortverweigerungen zuständig sind, nicht zu einer Verschlechterung der Gesamtleistung führt. Im Gegenteil, die Performance verschiebt sich leicht zugunsten besserer Ergebnisse.

Diese Beobachtung lässt darauf schließen, dass manche Experten vielleicht eher mit hinderlichem oder übervorsichtigem Verhalten verbunden sind und ihre temporäre Deaktivierung dem Modell sogar zugutekommt. Die Kombination aus der großen Expertenzahl, der gezielten Identifikation von relevanten Experten und der Möglichkeit, diese dynamisch zur Laufzeit zu manipulieren, stellt mit Mixture of Tunable Experts einen Paradigmenwechsel in der Entwicklung und Nutzung großer Sprachmodelle dar. Die Methoden eröffnen flexible und kontrollierbare Wege, um Modellverhalten anwendungsorientiert zu steuern, etwa um problematische Inhalte zu erlauben, spezifische Sprachstile zu erzwingen oder die Modellleistung noch weiter zu verbessern. Gleichzeitig wirft diese Entwicklung auch neue ethische und sicherheitstechnische Fragen auf. Das gezielte Abschalten von Experten, die als Entscheidungsträger fungieren und gewisse Antworten blockieren, muss verantwortungsvoll gehandhabt werden, um Missbrauch oder die Verbreitung schädlicher Inhalte zu verhindern.

Die Transparenz über die Funktionsweise und der verantwortungsbewusste Einsatz derartiger Steuerungsmöglichkeiten wird in Zukunft eine zentrale Rolle spielen. Für Entwickler, Forscher und Anwender großer Sprachmodelle bietet MoTE eine erfrischende Perspektive, Modelle nicht nur statisch zu trainieren und zu nutzen, sondern sie als dynamisch optimierbare Systeme zu betrachten. Die offene Verfügbarkeit von DeepSeek-R1 und die Bereitstellung der verwendeten Tools sowie die detaillierte Dokumentation ermöglichen es der Community, diese Innovation weiterzuentwickeln und in verschiedenen Domänen einzusetzen. Im Vergleich zu anderen Steuerungsmethoden wie Prompt Engineering, Reinforcement Learning oder feingranularen Nachtrainierungen bietet MoTE eine direkt am Modellkern ansetzende Herangehensweise, die präziser und zugleich effizienter ist. Das erlaubt schnelle Anpassungen an wechselnde Anforderungen ohne die Notwendigkeit umfangreicher Rechenressourcen.

Abschließend zeigt die Forschung rund um Mixture of Tunable Experts im DeepSeek-R1 Modell eindrucksvoll, wie die Architektur großer Sprachmodelle zunehmend modularer, anpassbarer und transparenter wird. Die Möglichkeit, individuelle Experten gezielt zur Verhaltensänderung zu nutzen, könnte zukünftig eine ganz neue Ära der KI-Nutzererfahrung einläuten – von besser kontrollierten Chatbots und intelligenten Assistenten bis hin zu spezialisierten Forschungswerkzeugen. Die Zukunft der KI-Modellsteuerung liegt damit nicht nur in der Maximierung von Parametern, sondern in der intelligenten Beherrschung ihrer verborgenen Möbel – den Experten, die tief in den neuronalen Netzwerken schlummern. Die Mixture of Tunable Experts ist der Schlüssel zu diesem Potenzial, der die Tür zu einer neuen Dimension des maschinellen Lernens öffnet.

![Microsoft Phi-4 reasoning technical report [pdf]](/images/1D8F9EFE-0260-45AE-B7C8-02B505A6E25E)