Die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) hat das Interesse von Wissenschaftlern und Forschern weltweit erheblich geweckt. Besonders in spezialisierten Fachgebieten wie der Chemie stellen sich spannende Fragen zur Leistungsfähigkeit dieser Systeme im Vergleich zu menschlichen Experten. Können diese künstlichen Intelligenzen mit der Expertise erfahrener Chemiker mithalten oder sogar übertreffen? Welche Stärken und Schwächen besitzen sie bei der Vermittlung von chemischem Wissen und der Anwendung chemischer Vernunft? Ein außergewöhnlich umfassender Rahmen für diese Untersuchung ist das 2025 veröffentlichte ChemBench, eine Benchmarking-Plattform, die LLMs mit Chemikerwissen und deren Fähigkeit zum logischen Schlussfolgern anhand von 2.788 sorgfältig kuratierten Fragen vergleicht. Die Entwicklung und Anwendung von LLMs wie GPT-4, Claude-3.

5 oder dem aus Open-Source-Universen stammenden LLaMA-Modell hat die Grenzen des maschinellen Sprachverstehens verschoben. Besonders beeindruckend ist, dass einige der führenden Systeme bei ChemBench im Durchschnitt sogar bessere Resultate erzielen als menschliche Chemiker – eine historische Zäsur, die viele überrascht. Doch hinter dieser stellaren Leistung liegen überraschende Nuancen und Herausforderungen, die wesentlich über einen simplen Vergleich von Punktzahlen hinausgehen. Fundamental ist zunächst die Erkenntnis, dass LLMs nicht einfach nur Wissensspeicher sind. Stattdessen nutzen sie umfangreiche Trainingskorpora aus wissenschaftlichen Publikationen, Datenbanken, Lehrmaterialien und anderen Texten, um auf der Basis von Wahrscheinlichkeiten und Sprachmustern Antworten zu generieren.

Daraus folgt, dass sie zwar große Mengen an Informationen nahezu instantan abrufen können. Allerdings besitzt der Prozess keine inhärente „Verständnisfähigkeit“ im menschlichen Sinn. Deshalb zeigen LLMs oft ein Phänomen, das als „Überkonfidenz“ bezeichnet wird: Sie geben präzise klingende Antworten mit hoher Sicherheit, selbst wenn diese falsch oder unvollständig sind. Gerade in der Chemie, wo fehlerhafte Informationen gravierende Folgen haben können, bedeutet dies eine Herausforderung bei der Handhabung und Interpretation der Modell outputs. Ein weiteres wesentliches Ergebnis der ChemBench-Studie ist, dass LLMs Schwierigkeiten bei einigen grundsätzlichen chemischen Aufgaben haben.

Während sie bei Fragen, die vorwiegend Wissensabfrage betreffen, häufig sehr gut abschneiden, lassen ihre Leistungen bei komplexen Denkprozessen, z. B. der Analyse von Molekülstrukturen, Isomerie oder der Vorhersage von NMR-Signalen, nach. Diese sogenannten „Reasoning“-Aufgaben erfordern eine deduktive Herleitung mehrerer Zwischenschritte und ein Verstehen der molekularen Topologie, das über reine Textverarbeitung hinausgeht. So kann beispielsweise die korrekte Bestimmung der Anzahl der verschiedenen Wasserstoffsignale in einem NMR-Spektrum oft nur erzielt werden, wenn das Modell das Molekül strukturell „erkennt“ und die Symmetrien bewertet, was der rein textbasierten Verarbeitung von SMILES-Strings naturgemäß schwerfällt.

Interessanterweise konnte gezeigt werden, dass die Leistung der Sprachmodelle stark mit ihrer Größe korreliert, was sich bereits aus Erfahrungen in anderen Fachbereichen ableiten lässt. Größere Modelle mit mehr Parametern bringen demnach oft eine bessere Leistung bei chemischen Fragestellungen. Dennoch wird eine weitere Steigerung der Modellgröße alleine nicht ausreichen, um die tiefergehenden Vernunftfähigkeiten vollständig zu verbessern. Vielmehr ist die Integration von externen spezialisierten Datenbanken und Werkzeugen essenziell. Das Beispiel PaperQA2, ein systemergänzendes Tool, das Literaturrecherche mit der KI verknüpft, verdeutlicht, dass die alleinige Einbindung wissenschaftlicher Veröffentlichungen nicht genügt, um Wissen komplexer chemiespezifischer Datenbanken vollständig abzubilden und für alle Fragestellungen ausreichenden Zugang zu ermöglichen.

Darüber hinaus besitzt ChemBench eine feingliedrige Kategorisierung der Fragestellungen nach chemischen Spezialgebieten – von Allgemein- und Technischer Chemie bis hin zu Analytischer Chemie und Sicherheitsthemen. Im Vergleich der Modellleistungen zeigt sich, dass manche Bereiche von den LLMs besser abgedeckt werden als andere. So schneiden viele Modelle in Fragen zu Allgemein- und Technischer Chemie überdurchschnittlich gut ab, während sie im Bereich chemischer Sicherheitsaspekte und toxikologischer Kenntnisse weniger zuverlässig sind. Gleichzeitig ist die analytische Chemie eine Herausforderung, bei der auch erfahrene Chemiker häufig auf Hilfsmittel zurückgreifen – die KI-Modelle stoßen hier mit rein textbasierter Repräsentation teilweise an ihre Grenzen. Die Verlässlichkeit der Modellantworten ist ein kritischer Aspekt.

Zwar sind LLMs in der Lage, ihre eigene Sicherheit bezüglich einer Antwort verbal einzuschätzen, doch zeigen Untersuchungen, dass diese Selbstbewertung bestenfalls teilweise mit der tatsächlichen Richtigkeit korreliert. Besonders bei sicherheitsrelevanten Themen liefern Modelle oft hohe Konfidenzwerte für falsche Antworten. Diese mangelnde Kalibrierung stellt ein Hindernis für den Einsatz in risikoreichen Bereichen der Chemie dar und unterstreicht die Notwendigkeit von ergänzenden Kontrollsystemen und menschlicher Aufsicht. Ein Bereich, in dem die LLMs bislang weniger überzeugende Leistungen zeigen, ist die Beurteilung von chemischen Präferenzen oder Intuitionen, also der subjektiven Entscheidung zwischen zwei ähnlichen Molekülen. In der pharmazeutischen Forschung ist genau dies ein zentraler Schritt im Designprozess.

Die Studie zeigt, dass Modellentscheidungen in diesem Kontext oft nicht besser sind als zufällige Auswahl. Diese Diskrepanz veranschaulicht die tiefere Komplexität chemischer Intuition, die persönliche Erfahrungen, implizites Wissen und komplexe Bewertungsmuster umfasst, welche nicht einfach aus Textkorpora extrahiert werden können. Die Entwicklung von Ansätzen, mit denen KI die menschliche Chemikerpräferenz besser abbilden kann, stellt ein vielversprechendes Forschungsfeld dar. Neben dem Vergleich von Modellergebnissen mit menschlicher Leistung führte die ChemBench-Studie auch eine Erhebung unter Chemieexperten durch. Achtzehn erfahrene Wissenschaftler aus verschiedenen Fachgebieten beantworteten ausgewählte Fragen, wobei ihnen teilweise Recherchetools wie Websuche und ChemDraw zur Verfügung standen.

Trotz dieser Hilfsmittel erreichten viele LLMs eine höhere Durchschnittspunktzahl bei ChemBench-Mini, dem kleineren und praxisnaheren Subset des Benchmarks. Diese Leistung hebt hervor, dass Sprachmodelle bei der Reproduktion von chemischem Wissen und einfachen Problemlösungen menschliche Kapazitäten übersteigen können, jedoch auch, dass menschliche Expertise insbesondere hinsichtlich kritischer Reflexion und Kontextualisierung unersetzbar bleibt. Die Implikationen der Erkenntnisse aus dem Vergleich von LLMs und Chemikern sind vielschichtig. Einerseits erscheinen Sprachmodelle als potenzielle „Copiloten“ für Chemiker, die durch Zugang zu enormen Mengen an Literatur, chemischer Information und Lerndaten Routineaufgaben automatisieren oder den Zugang zu chemischem Wissen vereinfachen können. Andererseits erfordern die derzeitigen Schwächen der Modelle eine kritische Einbindung durch menschliche Experten, um Fehlinterpretationen, Fehlentscheidungen oder gar gefährliche Anwendungen, insbesondere im Bereich chemischer Sicherheit, zu verhindern.

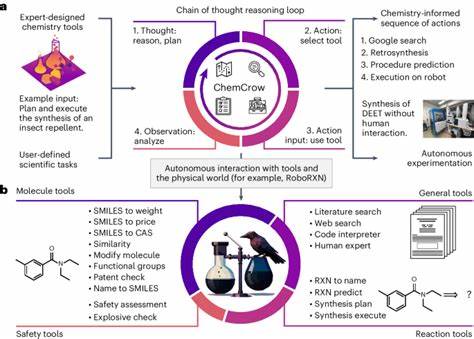

Für die Ausbildung von Chemikern könnte der Fortschritt von LLMs eine Neuausrichtung bedeuten. Während das Auswendiglernen von Fakten und das routinierte Lösen genormter Aufgaben zunehmend von maschinellen Systemen übernommen werden kann, gewinnt das Fördern von kritischem Denken, komplexem Vernetzen von Wissen und kreativem Experimentieren an Bedeutung. Dieser Wandel spiegelt sich auch in der Gestaltung von Prüfungen und Lehrmethoden wider, die sich künftig verstärkt auf die menschlichen Stärken im Verstehen und kreative Problemlösen konzentrieren sollten. Zukünftige Forschungsrichtungen auf dem Schnittpunkt von KI und Chemie wollen die Integration von multimodalen Daten (etwa Molekülgraphen, chemischen Formeln und experimentellen Bildern) in Sprachmodelle ausweiten, um eine bessere chemische Intuition und Strukturverständnis zu erreichen. Ebenso erscheint der Ausbau von agentenbasierten Systemen, die externe Werkzeuge, Datenbanken und sogar Laborroboter kombinieren, vielversprechend, um die Wirkungskraft künstlicher Intelligenz in der Chemie auf reale Anwendungsfelder zu verstärken.

Zusammenfassend zeigt die fundierte Evaluierung von ChemBench, dass große Sprachmodelle beeindruckende Fortschritte darin gemacht haben, Wissen und einfache chemische Schlussfolgerungen menschlichen Experten gleichzustellen oder zu übertreffen. Dies birgt enorme Chancen für Forschung, Ausbildung und industrielle Anwendungen. Gleichzeitig verdeutlichen die Grenzen der Modelle die Bedeutung von menschlicher Chemikerkompetenz und die Notwendigkeit weiterer Innovationen in KI-Systemen, um ein sicheres, zuverlässiges und effizientes Zusammenspiel von Mensch und Maschine in der Chemie zu gewährleisten.