Die rasante Entwicklung von Künstlicher Intelligenz (KI) hat viele Bereiche unseres Alltags revolutioniert. Open-Source-Modelle spielen dabei eine zentrale Rolle, da sie Forschern, Entwicklern und Unternehmen ermöglichen, innovative KI-Anwendungen zu schaffen. Doch genau diese Offenheit und Zugänglichkeit werden von kriminellen Akteuren im Dark Web zunehmend ausgenutzt. Sie missbrauchen legitime Open-Source-KI-Modelle für illegale Zwecke, was neue Herausforderungen für Sicherheit, Datenschutz und Gesellschaft mit sich bringt. In diesem Zusammenhang ist es wichtig, die Mechanismen des Missbrauchs, die Auswirkungen und mögliche Gegenmaßnahmen umfassend zu verstehen.

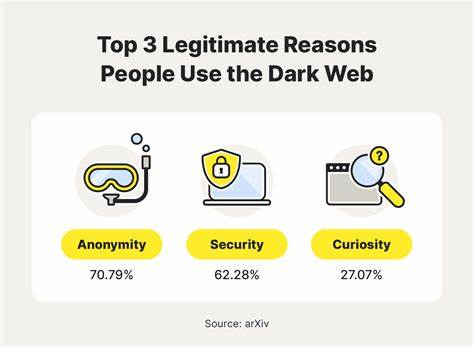

Das Dark Web, ein verborgener Teil des Internets, der nicht über herkömmliche Suchmaschinen zugänglich ist, bietet Anonymität für Nutzer und Plattformen. Diese Anonymität erlaubt es Kriminellen, schwer nachvollziehbar illegale Dienste anzubieten. Während KI-Technologien vielerorts für positive Zwecke eingesetzt werden, nutzen Akteure im Dark Web diese Technologien, um ihre dunklen Ziele zu verfolgen. Ein Beispiel hierfür ist der Einsatz von Open-Source-KI-Modellen, die eigentlich der Förderung von Forschung und Entwicklung dienen, nun aber für den Aufbau ausgeklügelter Betrugsdienste, automatisierter Phishing-Programme oder komplexer Malware verwendet werden.Die Nutzung legitimer Open-Source-Modelle im Dark Web basiert auf ihrer Verfügbarkeit und Leistungsfähigkeit.

Modelle, die auf Plattformen wie GitHub oder Hugging Face veröffentlicht werden, sind häufig öffentlich zugänglich und können kostenlos eingesetzt oder weiterentwickelt werden. Dies schafft für böswillige Akteure eine ideale Ausgangsbasis, um bestehende Modelle anzupassen und ihre eigene kriminelle KI-Infrastruktur zu schaffen. Dabei können sie die Modelle trainieren, um beispielsweise täuschend echt aussehende Deepfake-Videos zu generieren oder automatisierte Social-Engineering-Angriffe durchzuführen, die menschliche Interaktionen imitieren.Ein weiterer Grund für den Missbrauch ist das mangelnde Bewusstsein vieler Entwickler über die Sicherheitslücken, die bei Open-Source-Projekten entstehen können. Fehlende Zugangskontrollen, unzureichende Überprüfung von Beiträgen und fehlende Monitoring-Mechanismen ermöglichen es Cyberkriminellen, die Modelle gezielt zu manipulieren.

Zudem eröffnet die Verwendung von vortrainierten Modellen ohne ausreichende Kontrolle einen gefährlichen Angriffsvektor. So kann beispielsweise ein Angreifer ein Modell mit schädlichen Beispielen feinjustieren und dieses dann im Dark Web verbreiten, wodurch andere Nutzer unwissentlich schädliche KI-Lösungen einsetzen.Die Folgen des Missbrauchs gehen weit über technische Kompromittierungen hinaus. Manipulierte KI-Modelle können zur Verbreitung von Desinformation beitragen, die Glaubwürdigkeit von Nachrichtenquellen beeinträchtigen oder gar gesellschaftliche Spannungen verstärken. Dies ist besonders dann kritisch, wenn Künstliche Intelligenz eingesetzt wird, um gefälschte Identitäten zu erstellen, die auf sozialen Plattformen oder in betrügerischen Kommunikationssituationen zum Einsatz kommen.

Ebenso können automatisierte KI-Dienste zur Massensteuerung von Botnetzen genutzt werden, was die Effizienz und Skalierbarkeit cyberkrimineller Aktivitäten erheblich steigert.Die Abwehr solcher Missbrauchsstrategien erfordert einen ganzheitlichen Ansatz. Entwickler von Open-Source-KI-Modellen sollten verstärkt auf sichere Entwicklungspraktiken setzen. Dazu gehört die gründliche Prüfung von Beiträgen, die Implementierung von Mechanismen zur Erkennung manipulierter Trainingsdaten sowie die Einführung von Nutzungsbeschränkungen. Außerdem ist eine stärkere Zusammenarbeit zwischen Open-Source-Communitys, Sicherheitsforschern und Rechtsbehörden notwendig, um verdächtige Aktivitäten frühzeitig zu identifizieren und zu unterbinden.

Darüber hinaus spielen Bildungsmaßnahmen eine entscheidende Rolle. Ein größeres Bewusstsein für die Risiken des Missbrauchs und die Entwicklung ethischer Grundsätze für den Umgang mit KI können dazu beitragen, den verantwortungsvollen Einsatz dieser Technologien zu fördern. Auf regulatorischer Ebene wird diskutiert, wie Rahmenbedingungen geschaffen werden können, die einerseits Innovationen ermöglichen und andererseits Missbrauch verhindern. Ein Beispiel ist die Implementierung von Audit-Maßnahmen zur Nachverfolgbarkeit des KI-Einsatzes sowie die Förderung von Technologien, die Missbrauchswahrscheinlichkeiten automatisch erkennen und melden.Die Herausforderungen sind vielschichtig, da das Dark Web und KI beide intrinsisch anonyme Umgebungen darstellen, die von Gesetzesvollstreckern besonders schwer zu kontrollieren sind.

Technologische Weiterentwicklungen im Bereich Privacy-Preserving KI sowie KI-basierte Sicherheitslösungen könnten jedoch mittelfristig wirksame Gegenstrategien bieten. Auch die verstärkte Nutzung von KI für die Cyberabwehr, etwa durch automatisierte Erkennung von unrechtmäßigen KI-Anwendungen, wird als zukünftiger Meilenstein angesehen.Nicht zuletzt spielt der gesellschaftliche Diskurs eine wichtige Rolle, um die Risiken und Chancen von KI besser abzuwägen. Eine offene Kommunikation zwischen Technologen, Politik, Rechtsprechung und Öffentlichkeit ist notwendig, um ein gemeinsames Verständnis zu schaffen und entsprechende Schutzmaßnahmen zu entwickeln. Nur so kann die immense Innovationskraft von KI erhalten bleiben, ohne die Sicherheit von Individuen und Gemeinschaften zu gefährden.

Zusammenfassend zeigt sich, dass der Missbrauch legitimer Open-Source-KI-Modelle im Dark Web ein komplexes und dringendes Problem darstellt. Es vereint technische, ethische und rechtliche Aspekte und erfordert eine koordinierte Reaktion verschiedenster Akteure. Angesichts der ständig wachsenden Bedeutung von KI in allen Lebensbereichen ist es unumgänglich, proaktiv Maßnahmen zu ergreifen, um die dunklen Seiten der KI-Entwicklung einzudämmen und die positiven Potenziale dieser Technologie für die Gesellschaft zu erhalten.