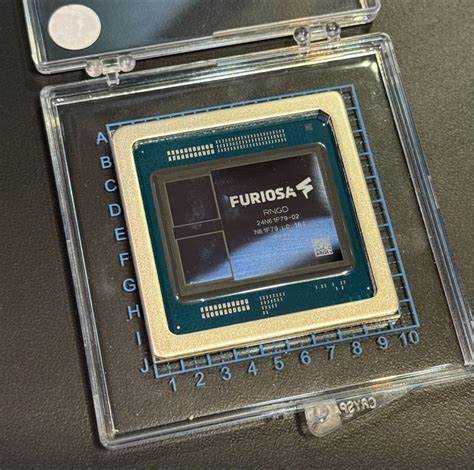

Die Entwicklung künstlicher Intelligenz (KI) schreitet unaufhaltsam voran, und mit ihr wachsen die Anforderungen an spezialisierte Hardwarelösungen, die leistungsstark, energieeffizient und vielseitig einsetzbar sind. FuriosaAI hat mit ihrem RNGD-Chip einen revolutionären Schritt gesetzt, der auf der Tensor Contraction Processor (TCP) Architektur basiert und speziell für die Herausforderungen moderner Deep-Learning-Inferenz entwickelt wurde. Dieser Beitrag beleuchtet die technischen Besonderheiten und die Bedeutung des FuriosaAI RNGD für die Zukunft der KI-Hardware. Im Zentrum des RNGD-Chips steht die TCP-Architektur, eine zukunftsweisende Herangehensweise an die Verarbeitung tensorbasierter Datenströme, die typisch für neuronale Netzwerke sind. Im Gegensatz zu traditionellen GPU- oder CPU-Architekturen optimiert der Tensor Contraction Processor die Rechenvorgänge auf tiefster Ebene, indem er den Schwerpunkt auf das effiziente Zusammenziehen von Tensoren legt.

Das Ergebnis sind massiv gesteigerte Rechenleistungen bei gleichzeitig optimiertem Energieverbrauch, was sich besonders bei der Ausführung großer Sprachmodelle und multimodaler KI-Anwendungen auszahlt. Die Fertigung des RNGD basiert auf TSMCs 5-Nanometer-Prozess, einer der modernsten Halbleitertechnologien weltweit. Diese ermöglicht es, eine extrem hohe Dichte an Transistoren auf kleinstem Raum zu integrieren, was zu einer gesteigerten Rechenkapazität bei geringem Stromverbrauch führt. Zusätzlich taktet der Chip mit einer Frequenz von 1,0 GHz, was in Kombination mit der Architektur und Prozessortechnologie eine beeindruckende Rechenleistung generiert. Leistungsdaten verdeutlichen die Überlegenheit des RNGD.

Mit einer Rechenleistung von bis zu 512 TOPS (Tera Operationen pro Sekunde) bei INT8-Berechnungen und sogar bis zu 1024 TOPS bei INT4 ist die Chiplösung prädestiniert für KI-Inferenzaufgaben, die eine enorme Anzahl paralleler Operationen erfordern. Für Fließkommazahlen im BF16-Format steht eine Leistung von 256 TFLOPS (Tera Floating Point Operations Per Second) zur Verfügung, während FP8-basiertes Rechnen mit bis zu 512 TFLOPS unterstützt wird. Diese breite Unterstützung verschiedener Datentypen macht den RNGD-Chip vielseitig einsetzbar und auf die unterschiedlichsten Anforderungen moderner KI-Modelle anpassbar. Ein entscheidender Faktor für die Leistungsfähigkeit von KI-Hardware ist neben der Rechenleistung die Geschwindigkeit und Kapazität des Speichersystems. RNGD ist mit zwei HBM3-Modulen ausgestattet, die eine kombinierte Speicherbandbreite von 1,5 Terabyte pro Sekunde (TB/s) bieten und dabei 48 GB Speicherkapazität bereitstellen.

Damit können große Modelle und Datenmengen effizient verarbeitet werden, ohne dass Engpässe durch langsamen Speicherzugriff entstehen. Ergänzend dazu steht ein 256 MB großer On-Chip SRAM-Speicher zur Verfügung, der schnelle Zwischenspeicherungen ermöglicht und so die Gesamtperformance weiter steigert. Die Schnittstelle des RNGD-Chips zum Host-System erfolgt über PCIe Gen5 mit 16 Lanes. PCIe Gen5 bietet eine verdoppelte Bandbreite im Vergleich zu früheren Generationen, was für eine verzögerungsarme Kommunikation zwischen Chip und Hauptsystem sorgt. Diese hohe Bandbreite ist insbesondere bei der Verarbeitung großer Datenmengen und Modelle von kritischer Bedeutung, um Datentransfers nicht zum Flaschenhals werden zu lassen.

Ein weiteres zukunftsweisendes Feature des FuriosaAI RNGD ist seine native Unterstützung von Multi-Tenant-Umgebungen, die in modernen Cloud- und Rechenzentrumsumgebungen immer wichtiger werden. Der Chip kann in bis zu acht isolierte NPU-Instanzen aufgeteilt werden, wobei jede Instanz über eigene Rechenkerne und angemessene Speicherressourcen verfügt. Diese Eigenschaft ermöglicht eine flexible Ressourcenzuteilung, eine verbesserte Auslastung der Hardware und verschafft Cloud-Anbietern oder Unternehmen, die Container-Technologien wie Kubernetes einsetzen, eine effektive Möglichkeit der Virtualisierung. Die Virtualisierung innerhalb des Chips wird durch Single Root I/O Virtualization (SR-IOV) unterstützt. SR-IOV ermöglicht es, eine physische Hardware-Ressource so aufzuteilen, dass sie mehrfach und gleichzeitig von verschiedenen virtuellen Maschinen oder Containern genutzt werden kann, ohne dass es zu Leistungseinbußen kommt.

Dies trägt zur besseren Ressourcennutzung bei und reduziert Kosten durch gemeinsame Hardware für verschiedene Workloads, ohne Kompromisse bei Sicherheit und Performance einzugehen. Im Bereich der Sicherheit setzt der RNGD auf einen Secure Boot mit Root of Trust, um sicherzustellen, dass nur authentifizierte und geprüfte Software gestartet werden kann. Diese Maßnahme ist essenziell, um Manipulationen am System zu vermeiden und eine vertrauenswürdige Basis für kritische KI-Anwendungen zu schaffen. Ergänzt wird dies durch Unterstützung für fehlererkennenden und -korrigierenden ECC-Speicher, der Speicherfehler erkennt und korrigiert und so die Zuverlässigkeit des Systems auch in hochverfügbaren Produktionsumgebungen erhöht. Auch das thermische Management wurde bei der Entwicklung nicht vernachlässigt.

Der RNGD-Chip verfügt über eine passive Kühlungslösung bei einem Thermal Design Power (TDP) von 150 Watt. Diese Kombination verspricht eine geräuscharme und energieeffiziente Arbeitsweise, was besonders in Rechenzentren mit hohen Anforderungen an Kühlung und Energieverbrauch von Vorteil ist. Zudem passt sich der Formfaktor des RNGD-Chips an bestehende Standards an und belegt einen PCIe-Dual-Slot in Full-Height sowie 3/4 Length-Dimensionen, wodurch die Integration in vorhandene Serverlösungen unkompliziert möglich ist. Die Bedeutung von FuriosaAI RNGD liegt nicht nur in seinen technischen Spezifikationen, sondern auch darin, wie die Architektur die Herausforderungen moderner AI-Anwendungen aufgreift und zukünftigen Anforderungen Rechnung trägt. Große Sprachmodelle und multimodale Anwendungen sind aufgrund ihrer Größe und Komplexität eine immense Herausforderung für herkömmliche Hardware.

Der Fokus auf effiziente Tensor-Operationen, hohe Speicherbandbreite sowie Virtualisierung und Mehrfachinstanzen zeigt, dass FuriosaAI eine Plattform bietet, die skalierbar, flexible und für produktive KI-Systeme geeignet ist. Zusätzlich wird der flexible Software-Stack von FuriosaAI, der unter anderem eine OpenAI-kompatible Serverumgebung namens Furiosa-LLM umfasst, die Nutzung des RNGD-Chips noch attraktiver. Entwickler und Unternehmen können so moderne KI-Modelle ohne umfassende Anpassungen in eine performante und skalierbare Infrastruktur integrieren. Die Kombination aus Hardwareleistung und Softwareunterstützung vereinfacht zudem das Deployment in Cloud- und Kubernetes-Umgebungen erheblich. FuriosaAI RNGD ist mehr als nur ein Chip – er ist ein Gesamtpaket aus Innovation, Leistung und Zukunftsfähigkeit.

Seine Tensor Contraction Processor Architektur setzt neue Maßstäbe in der KI-Hardware und adressiert die wachsenden Anforderungen an Effizienz und Flexibilität. Während die KI-Community weltweit nach nachhaltigen und leistungsstarken Lösungen sucht, positioniert sich FuriosaAI mit RNGD als eine der vielversprechendsten Technologien in der kommenden Generation von KI-Beschleunigerchips. Für Unternehmen, Cloud-Anbieter und Forschungseinrichtungen, die komplexe KI-Modelle betreiben, bietet der RNGD nicht nur beeindruckende Leistungsreserven, sondern auch eine Plattform, die mit modernen Virtualisierungs- und Sicherheitsmechanismen für die anspruchsvollen Anforderungen heutiger und zukünftiger KI-Anwendungen gerüstet ist. Sein Memory-Engineering und die Unterstützung neuester Schnittstellenstandards machen ihn zu einer zukunftssicheren Investition im Bereich KI-Hardware. Abschließend lässt sich sagen, dass FuriosaAI RNGD dank seiner innovativen TCP-Architektur, der hochwertigen Fertigung und des umfassenden Feature-Sets die nächste Ära von KI-Beschleunigern einläutet.

Er unterstützt die Community dabei, KI-Modelle effizienter, schneller und sicherer als je zuvor zu betreiben, und fördert damit nachhaltige und skalierbare KI-Lösungen für verschiedenste Branchen und Anwendungen.