In der heutigen digitalen Ära sind wir zunehmend mit Bedrohungen konfrontiert, die unsere Geräte und Daten gefährden. Malware, Viren und Cyberangriffe gehören längst zum Alltag. Doch während wir fortschrittliche Schutzmechanismen für unsere Computer und Smartphones besitzen, stellt sich die Frage: Warum existiert keine vergleichbare Malware-Erkennungssoftware für die reale Welt? Die Vorstellung, dass etwa AR-Brillen uns vor irreführenden Werbeanzeigen oder falschen medizinischen Behauptungen warnen könnten, klingt verlockend und zukunftsweisend. Dennoch gibt es tiefere Gründe, warum eine solche Technologie bislang nicht Wirklichkeit geworden ist und welche Hürden bei ihrer Umsetzung bestehen. Zunächst muss man verstehen, dass die digitale Malware-Erkennung auf klar definierten technischen Parametern basiert.

Algorithmen können Dateien, Programme oder Webseiten nach verdächtigen Mustern scannen, die typischerweise bei schädlicher Software auftreten. Diese Prozesse sind datengetrieben, repetitiv und basieren auf einer Vielzahl von Signaturen und Verhaltensanalysen. In der physischen Welt jedoch ist das Problem viel komplexer. Die Realität ist nicht in klaren Binärdaten kodiert, sondern enthält eine enorme Vielfalt an Informationen, Kontexten und Interpretationsspielräumen. Warnungen vor falschen Aussagen oder Betrug erfordern ein tiefes Verständnis von Sprache, Kontext, Wahrheit und Täuschung – alles Bereiche, in denen die Künstliche Intelligenz und maschinelles Lernen noch immer vor großen Herausforderungen stehen.

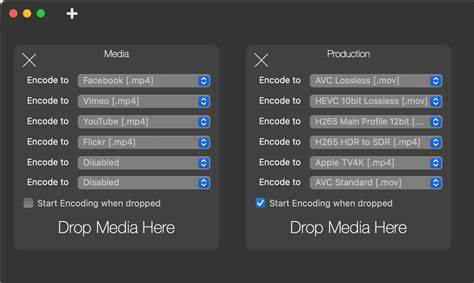

Augmented Reality (AR) Brillen, die imstande sind, uns direkt vor Ort in der physischen Welt zu informieren und zu schützen, wären zweifellos eine enorme technologische Erweiterung. Die Idee dahinter ist, dass die Brille mittels Kamera, Sensoren und KI sofort erkennt, ob eine Werbung irreführend ist oder ob ein Angebot Betrug sein könnte. Dies könnte das Leben der Menschen sicherer machen, indem es die schnellen, oft voreiligen Entscheidungen im Alltag unterstützt. Doch wie einige Experten bereits anmerken, bringt dieses Szenario weitreichende Probleme mit sich. Eine der größten Sorgen ist die Abhängigkeit: Wenn wir uns zu sehr auf externe Geräte verlassen, verlieren wir womöglich zunehmend die Fähigkeit, selbst kritisch zu denken und Gefahren zu erkennen.

Der Prozess des Lernens und der eigenen Verifikation wird so verkürzt oder ganz ersetzt. Darüber hinaus birgt die Abhängigkeit von einer AR-Erkennungssoftware technische und sicherheitsrelevante Risiken. Ein Gerät kann kaputtgehen, die Internetverbindung kann unterbrochen werden oder – besonders gravierend – die Software selbst könnte Opfer von Angriffen werden. Sollte ein Hacker die Software manipulieren, ließe sich die Wahrnehmung der Nutzer gezielt steuern, sie können falschen Informationen folgen, ohne es zu merken. Dies könnte zu einer neuen Dimension der digitalen Manipulation überlagert mit physischen Erlebnissen führen.

Neben diesen psychologischen und sicherheitstechnischen Aspekten gibt es auch eine tiefere gesellschaftliche Herausforderung. Das Erkennen von „Malware“ oder irreführenden Informationen in der realen Welt erfordert oft eine komplexe ethische Bewertung. Was genau als irreführend gilt, kann subjektiv sein und stark von kulturellen sowie individuellen Überzeugungen abhängen. Eine Software, die über die Bewertung von Richtigkeit und Wahrheit entscheidet, könnte unbewusst oder bewusst Vorurteile verstärken, Zensur ausüben oder politische Agenden fördern. Somit stellt sich die Frage, wer die Kriterien und Algorithmen dieser Erkennung bestimmt und wie Transparenz und Fairness gewährleistet werden können.

Ein weiterer Faktor ist die technische Machbarkeit. Während computergestützte Erkennung von Schadsoftware mit klar definierten Programmiermustern funktioniert, müsste eine pauschale Erkennung von betrügerischen oder falschen Inhalten in der echten Welt auf extrem komplexen, multimodalen Daten beruhen, darunter Text, Bild, Ton und situative Kontexte. Maschinelles Lernen und KI sind zwar heute bereits in der Lage, einige dieser Aufgaben zu übernehmen, aber die Genauigkeit und Robustheit sind für den Alltag oft noch nicht ausreichend. Beispielsweise können KI-Modelle Schwierigkeiten haben, Ironie, Humor oder kulturelle Anspielungen korrekt zu interpretieren, was zu Fehlalarmen oder unbeabsichtigter Zensur führen kann. Auch die Datenschutzproblematik darf nicht unterschätzt werden.

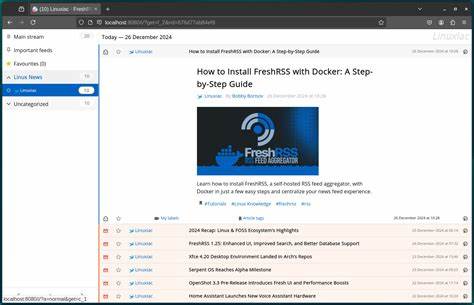

Für eine zuverlässige Erkennung müssten AR-Geräte ständig Umweltdaten sammeln und analysieren, was eine beinahe permanente Überwachung der Umgebung bedeutet. Dies kann zu erheblichen Eingriffen in die Privatsphäre sowohl des Trägers als auch der Personen in dessen Nähe führen. Gesellschaftliche Akzeptanz und rechtliche Rahmenbedingungen sind entscheidend, um solche Technologien verantwortungsvoll einzusetzen. Es existieren bereits Ansätze und Technologien, die in diese Richtung gehen. KI-basierte Filter oder Adblocker auf digitalen Plattformen können etwa dazu beitragen, irreführende Inhalte zu reduzieren.

Doch die Übertragbarkeit solcher Lösungen auf die physische, reale Welt bleibt eine Herausforderung. Die Grenzen zwischen öffentlichem und privatem Raum verschwimmen, und die Dynamik realer interaktiver Situationen erfordert weit mehr Flexibilität und Anpassung als digitale Systeme heute leisten können. Zudem darf man nicht vergessen, dass selbst im digitalen Raum die Identifikation von „Malware“ oder betrügerischen Informationen oft fehlerbehaftet ist. Es gibt zahlreiche Beispiele, bei denen falsche Positivmeldungen Nutzer frustrieren oder falsche Negativmeldungen reale Schäden verursachen. Die hohen Anforderungen an Genauigkeit und Verlässlichkeit in der physischen Welt erfordern eine technische Reife, die derzeit nur in Ansätzen vorhanden ist.

Letztlich wird deutlich, dass es sich bei der Frage nach einer Malware-Erkennungssoftware für die reale Welt um ein interdisziplinäres Thema handelt, das Technologie, Psychologie, Ethik sowie Gesellschaftspolitik miteinander verbindet. Fortschritte in der Künstlichen Intelligenz, insbesondere im Bereich natürlicher Sprachverarbeitung und Computer Vision, werden zweifellos dazu beitragen, näher an diese Vision heranzukommen. Doch die Realisierung erfordert mehr als nur technische Innovation – es braucht ebenso ein Bewusstsein für die gesellschaftlichen Implikationen und einen verantwortlichen Umgang mit Macht und Einfluss dieser Technologien. Abschließend lässt sich sagen, dass die Idee einer Malware-Erkennungssoftware für die reale Welt faszinierend und potenziell revolutionär ist. Die damit verbundenen Chancen im Kampf gegen Desinformation, Betrug und Manipulation sind enorm.

Gleichzeitig verlangt diese Entwicklung eine sorgfältige Abwägung von Risiken und Nebenwirkungen, die über die rein technische Betrachtung hinausgehen. Die Zukunft könnte solche Lösungen bringen, doch bis dahin bleibt die menschliche Fähigkeit zur kritischen Reflexion, Skepsis und gegenseitigem Austausch unverzichtbar, um in einer komplexen Welt wachsam und sicher zu bleiben.