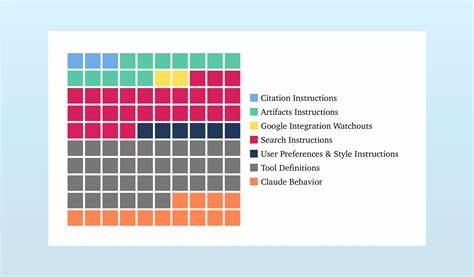

Anthropic, ein wegweisendes Unternehmen im KI-Bereich, hat mit der Einführung von Claude 4 erneut bewiesen, wie sorgfältig und durchdacht die Entwicklung moderner KI-Systeme erfolgt. Im Zentrum dieser Entwicklung steht ein oft unterschätztes Element – der System-Prompt. Dieser zentrale Bestandteil bestimmt nicht nur das Verhalten des Modells, sondern auch, wie Nutzer es erleben und welche Aufgaben es erfüllen kann. Ein genauer Blick auf die Veränderungen zwischen Claude 3.7 und Claude 4 offenbart eindrucksvoll, welche Prioritäten Anthropic setzt und wie das Unternehmen auf Nutzerfeedback sowie technische Herausforderungen reagiert.

Zunächst fällt auf, dass vielfache sogenannte Hotfixes, die in der vorherigen Version noch verwendet wurden, in Claude 4 verschwunden sind. Diese Hotfixes waren meist kurze, gezielte Anweisungen im System-Prompt, die unerwünschte Verhaltensweisen – sogenannte „Gotchas“ – adressieren sollten. Die Entfernung dieser Hotfixes suggeriert, dass Anthropic nunmehr die Fehlerquellen direkt auf Ebene der Modell-Weiterentwicklung behebt, anstatt auf temporäre Anpassungen im Prompt zurückzugreifen. Diese Änderung zeigt die Reife des Trainingsprozesses von Claude und das Vertrauen in Reinforcement Learning nach dem eigentlichen Training. Die Modelle werden zunehmend darauf trainiert, Aufgaben wie das genaue Zählen von Buchstaben oder das Vermeiden von stereotypen Bildern eigenständig und fehlerfrei zu bewältigen.

Eine besonders interessante Ergänzung im aktuellen System-Prompt ist die Anweisung, keine unnötige Schmeichelei zu verwenden. Claude verzichtet darauf, eine Frage oder Idee mit positiven Adjektiven wie „großartig“ oder „faszinierend“ einzuleiten und antwortet stattdessen direkt und sachlich. Diese Änderung geht auf Erfahrungen von Mitbewerbern zurück, bei denen KI-Modelle mit unkritischer Zustimmung auffielen. Die bewusste Vermeidung solcher Floskeln signalisiert eine Fokussierung auf Glaubwürdigkeit und eine ernsthafte, auf den Inhalt konzentrierte Kommunikation, was gerade in professionellen Anwendungsfällen von hoher Bedeutung ist. Im Bereich der Informationsbeschaffung hat Anthropic eine bemerkenswerte Entwicklung durchlaufen.

Während früher Suchvorgänge innerhalb des Chats nur nach ausdrücklicher Zustimmung der Nutzer ausgeführt wurden, ist nun ein proaktiver Einsatz der Suchfunktion vorgesehen. Claude wird dazu ermutigt, Zeit- oder kontextkritische Fragen eigenständig durch eine Internetsuche zu ergänzen. Diese bewusste Entscheidung spiegelt das gestiegene Vertrauen in die Qualität und Effizienz der integrierten Such-API wider. Zudem weist es darauf hin, dass Nutzer zunehmend Chatbots als primäre Informationsquelle nutzen und somit der Zugriff auf aktuelle Daten immer wichtiger wird. Die damit einhergehende Integration von performanter Suche stellt Claude auf eine Stufe mit anderen Marktführern und treibt gleichzeitig die umfassende Nutzung moderner KI-Systeme in Alltag und Beruf voran.

Ein weiteres spannendes Detail findet sich im Umgang mit strukturierten Dokumenten. Das System-Prompt von Claude 4 beschreibt nun präziser, welche Arten von Inhalten besonders für Artefakte geeignet sind – separate Fenster oder Bereiche für ausführlichere, übersichtlich formatierte Inhalte außerhalb des Hauptdialoges. Dies umfasst nun konkret Inhalte wie Ernährungspläne, Trainingsroutinen oder Studienpläne, welche Nutzer häufig als Referenz speichern und wiederverwenden möchten. Diese Anpassung verdeutlicht, wie sehr Anthropic das Nutzerverhalten analysiert und seine Systeme kontinuierlich an realen Anwendungsfällen ausrichtet. Gleichzeitig zeigt die Aufforderung, für Code-Artefakte kurze und prägnante Variablennamen zu verwenden, eine pragmatische Antwort auf die weiterhin begrenzten Kontextkapazitäten von Claude.

Mit „nur“ 200.000 Tokens Kontextfenster liegt Claude hinter einigen Konkurrenten wie ChatGPT 4.1 oder Gemini 2.5 Pro, welche bis zu einer Million Tokens verarbeiten können. Die begrenzte Kontextlänge wirkt sich vor allem bei komplexen Programmieraufgaben aus, bei denen viele Variablen und Codezeilen berücksichtigt werden müssen.

Während für viele Programmierer ausführliche, selbsterklärende Namen wichtig sind, zeigt sich hier eine bewusste Abwägung zugunsten der Effizienz und der Maximierung des nutzbaren Kontextes. Diese Herausforderung wird wohl auch in Zukunft viele Entwickler beschäftigen, insbesondere in wettbewerbsintensiven AI-Technologiemärkten. Ein weiteres wichtiges Anliegen, das aus der Analyse der System-Prompt-Änderungen hervorgeht, ist der Umgang mit ethischen und sicherheitsrelevanten Fragestellungen. Claude 4 geht deutlich über die bisherigen Beschränkungen hinaus, die Unterstützung bei der Herstellung von Biowaffen oder Kernwaffen ablehnen. Neu ist insbesondere die klare Verweigerung bei Anfragen im Bereich von Cyberkriminalität oder potenziell schädlichem Code.

Claude darf weder schädliche Software erklären noch beim Schreiben oder Verbessern von bösartigem Code helfen – selbst wenn der Nutzer angibt, dies zu Bildungszwecken zu tun. Diese rigorose Haltung zeigt, dass Anthropic den verantwortungsvollen Umgang mit KI ernst nimmt und präventiv Sicherheitsrisiken minimiert. Die zahlreichen Bedingungen und Feinheiten, die dafür im System-Prompt kodiert sind, verdeutlichen, wie komplex und sensibel das operative Moment in Bezug auf Missbrauchsprävention ist. Insgesamt lässt sich aus den zahlreichen Veränderungen im System-Prompt von Claude 3.7 zu Claude 4 ein Bild eines Unternehmens zeichnen, das stark auf Nutzerfeedback, technische Weiterentwicklung und ethische Verantwortung setzt.

Die System-Prompts sind dabei weit mehr als bloße technische Anweisungen: Sie sind gewissermaßen das Rückgrat der Nutzererfahrung – sie definieren, wie Claude auf Anfragen reagiert, welche Prioritäten gesetzt werden und wie das Modell mit realen Herausforderungen umgeht. Anthropic zeigt mit diesem Vorgehen, dass die Entwicklung von KI-Anwendungen kein statischer Prozess ist, sondern sich an den ständig wachsenden Anforderungen, neuen Erkenntnissen und Marktgegebenheiten orientiert. Das Unternehmen kombiniert klassische Modelltrainingsmethoden mit einer flexiblen, promptbasierten Steuerung, die schnelle Anpassungen ermöglicht – sei es zur Fehlerbehebung, zur Verbesserung des Outputs oder zur Implementierung von neuen Funktionen wie der erweiterten Suchintegration. Für Anwender bedeutet dies, dass sich Claude nicht nur technisch weiterentwickelt, sondern auch die Interaktion mit dem Nutzer immer zielgerichteter und relevanter gestaltet wird. Dies steigert die Effizienz im Umgang mit der KI, sei es bei der Suche nach verlässlichen Informationen, der Erstellung komplexer strukturierter Dokumente oder der Arbeit mit komplexem Quellcode.

Gleichzeitig setzt Anthropic ein klares Zeichen für die Sicherheit und den verantwortungsbewussten Umgang mit der Technologie. Abschließend lässt sich sagen, dass System-Prompts bei modernen KI-Systemen wie Claude inzwischen einen so großen Einfluss auf die Performance und Nutzererfahrung haben, dass sie nicht unterschätzt werden dürfen. Sie sind ein strategisches Werkzeug, mit dem Unternehmen wie Anthropic ihre Prioritäten, Unternehmenswerte und Innovationskraft sichtbar machen. Die kontinuierliche Verfeinerung der System-Prompts in Verbindung mit verbesserten Trainingsmethoden bildet dabei das Herzstück, um KI-Anwendungen an die Bedürfnisse der Zukunft anzupassen und gleichzeitig eine vertrauenswürdige Umgebung für Nutzer zu schaffen. Es bleibt spannend zu verfolgen, wie sich die System-Prompt-Strategien bei Claude und anderen KI-Modellen weiterentwickeln und welchen Einfluss sie auf das gesamte KI-Ökosystem haben werden.

Die Kombination aus technischer Finesse, Nutzerorientierung und ethischem Bewusstsein macht deutlich, dass die Zukunft der KI nicht nur von der Leistungsfähigkeit der Modelle, sondern auch von der Art und Weise abhängt, wie wir sie programmieren und verantwortungsvoll einsetzen.