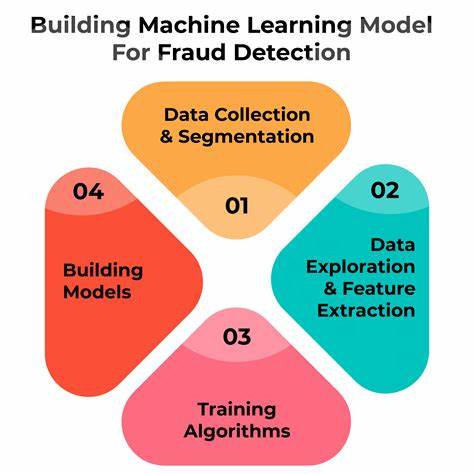

Die Einführung von Künstlicher Intelligenz (KI) im öffentlichen Sektor eröffnet neue Möglichkeiten, aber auch erhebliche Herausforderungen – insbesondere wenn es um sensible Bereiche wie die soziale Sicherung geht. Amsterdam, bekannt für seinen progressiven Ansatz, startete vor einigen Jahren ein großes Projekt, um eine KI-basierte Lösung zu entwickeln, die potenziellen Betrug bei Sozialhilfeanträgen identifizieren sollte. Das Ziel ging dabei über bloße Effizienzsteigerung hinaus: Die Stadt wollte ein Modell schaffen, das nicht nur leistungsstark, sondern auch fair gegenüber allen Bevölkerungsgruppen ist, um Diskriminierung und Benachteiligungen zu vermeiden. Eine sorgfältige Analyse des Modells und seiner Entwicklung offenbart jedoch die komplexen Hindernisse, denen man bei ethischer KI wirklich begegnet, und bietet wertvolle Lehren für zukünftige Anwendungen. Amsterdams Projekt begann mit der Arbeit an einem Modell zur Risikobewertung, das Anträge von Sozialhilfeempfängern klassifizierte, um festzustellen, ob eine genauere Untersuchung durch menschliche Sachbearbeiter notwendig sei.

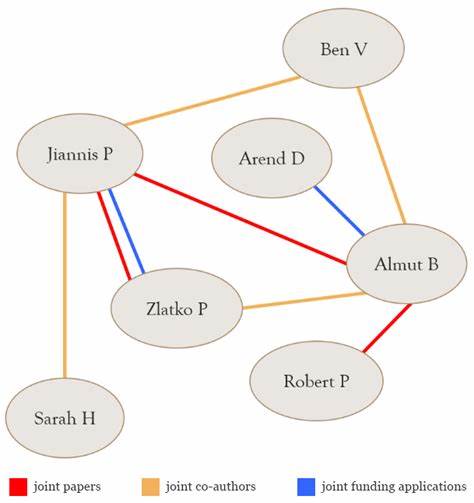

Dabei verwendeten die Entwickler eine sogenannte Explainable Boosting Machine (EBM), eine Algorithmenklasse, die auf Verständlichkeit und Nachvollziehbarkeit der Entscheidungen setzt und somit einem schwarzen Kasten entgeht. Transparenz war in diesem Kontext entscheidend, weil die Entscheidungen weitreichende Folgen für Betroffene haben können, wie zum Beispiel gezielte Hausbesuche oder die Anforderung von Bankunterlagen. Die Warnzeichen für eine mögliche Benachteiligung von Minderheiten oder vulnerablen Gruppen sollten möglichst früh erkannt und behoben werden. Das Modell basiert auf 15 verschiedenen Merkmalen, die Verhaltensmuster und Eigenschaften von Antragstellern abbilden. Auffällig ist, dass bewusst keine direkten demografischen Merkmale wie Herkunft, Geschlecht oder Ethnie eingebunden wurden, um Diskriminierung explizit zu vermeiden.

Dennoch wussten die Verantwortlichen, dass manche der verwendeten Merkmale als sogenannte Proxy-Variablen fungieren können – also indirekt Rückschlüsse auf schützenswerte Gruppen zulassen und so Risiken der Diskriminierung bergen. Dieser Umstand verdeutlicht die Komplexität, wenn es um gerechte Algorithmen geht, da rein statistische Modelle unbewusst gesellschaftliche Vorurteile reproduzieren können. Ein weiterer Kritikpunkt am Modell war die Qualität der Trainingsdaten. Amsterdam nutzte für das Training vergangene Untersuchungen, aus denen das System lernen sollte, welche Anträge tatsächlich betrügerisch oder fehlerhaft waren. Dabei zeigte sich, dass das historische System selbst fehler- und subjektivitätsbehaftet war – einzelne Sachbearbeiter könnten etwa Vorurteile gegenüber Nicht-Dutch gehabt haben und deshalb falsche Flaggen gesetzt haben.

Zudem war der Anteil der als "untersuchungswürdig" gekennzeichneten Fälle im Trainingsdatensatz weit höher als im realen Antragswesen. Dieses Missverhältnis führte dazu, dass das Modell auf eine verzerrte Grundlage trainiert wurde, die die Effizienz zwar steigerte, aber die Fairness untergrub. Die Stadt entwickelte verschiedene Metriken, um Fairness zu messen und zu bewerten. Dabei lag ein besonderer Fokus auf der Verteilung von Fehlalarmen, also Fällen, die vom Modell fälschlicherweise als betrugsverdächtig eingestuft wurden. Ziel war es, dass kein Menschengruppe unverhältnismäßig stark mit solchen falschen Vorwürfen belastet wird.

Amsterdam entschied sich schließlich, den sogenannten False Positive Share als Schlüsselindikator zu verwenden. Diese Kennzahl misst den Anteil der fälschlich markierten Anträge in jeder Gruppe und soll gewährleisten, dass die Fehlerlast gerecht verteilt wird. Die Entscheidung für diese Fairnessdefinition entspricht einer ethischen Abwägung: Die Gesellschaft möchte verhindern, dass bestimmte Minderheiten unverdientermaßen vermehrt unter dem Verdacht leiden, während gleichzeitig ein funktionierendes Kontrollsystem erhalten bleibt. Die ersten Ergebnisse nach dem Training waren jedoch ernüchternd. Das Modell zeigte deutliche Verzerrungen gegen Antragsteller mit Migrationshintergrund.

So wurden insbesondere Personen mit nicht-westlicher Herkunft weit häufiger fälschlich als „untersuchungswürdig“ markiert als niederländische Bürger. Im Vergleich zum bisherigen, manuellen Prüfsystem mit Analoganalyse ließ sich sogar feststellen, dass das KI-Modell diese Bevölkerungsgruppe noch stärker belastete. Die Stadt stand vor einem Dilemma, denn KI sollte eigentlich helfen, Diskriminierung abzubauen, nicht sie zu verstärken. Um diesen Problemen zu begegnen, unternahm Amsterdam einen gezielten „Debiasing“-Versuch. Dabei wurde das Trainingsset neu gewichtet: Fälle von Antragstellern mit westlicher Herkunft erhielten ein höheres Gewicht, während nicht-westliche Fälle niedriger gewichtet wurden, um das Ungleichgewicht zu mildern.

Nach der Regewichtung zeigten die Analysen zunächst Erfolg – viele Unterschiede in den Fehlalarmraten konnten ausgeglichen werden. Dieses Ergebnis war insofern bemerkenswert, als es zeigte, dass technisch-methodische Anpassungen hinsichtlich der Fairness wirksam sein können. Doch die erhoffte „gerechte“ Lösung währte keine lange Zeit. Während der Pilotphase, die von Juni bis August 2023 lief und in der das Modell erstmals in Echtzeit soziale Anträge prüfte, tauchten neue Verzerrungen auf – nun blieben andere Gruppen benachteiligt. Überraschenderweise waren in der Pilotphase überwiegend weibliche Antragsteller und niederländische Staatsbürger von höheren Fehlalarmen betroffen.

Daraus lässt sich ableiten, dass durch die Fokussierung auf ein einziges Fairnesskriterium bei einer demographischen Variable sich andere Unausgewogenheiten in anderen Gruppen verstärken können. Die Stadt sah sich daher gezwungen, den Piloten Ende 2023 einzustellen. Diese Entwicklungen illustrieren eine fundamentale Schwierigkeit bei der Gestaltung fairer KI-Systeme in der Sozialverwaltung: Es gibt keine einfache Lösung, die alle Interessen und Gerechtigkeitsvorstellungen gleichzeitig erfüllt. Unterschiedliche Fairnessmaße widersprechen sich oft gegenseitig, und Verbesserungen für eine Gruppe führen häufig zu Nachteilen für eine andere. So erinnert die Problematik an ein Spiel von „Whack-a-Mole“, bei dem ein ungerecht empfundener Aspekt eliminiert wird und gleichzeitig an anderer Stelle neue Ungleichheiten auftreten.

Die Herausforderungen für Amsterdam werden auch dadurch verstärkt, dass das Modell in der Pilotphase eine schlechtere Gesamtleistung zeigte als in der Vorschauphase. Der Anteil der falsch-positiven Markierungen stieg, während die tatsächliche Erkennungsrate von betrugswürdigen Fällen kaum verbessert wurde. Dies weist auf eine fehlende Kalibrierung hin – die von der KI verwendeten Schwellenwerte waren möglicherweise zu niedrig gesetzt, was zu übermäßigen Fehlalarmen führte. Trotz technischer Korrekturen zeigten sich dadurch schwerwiegende Nachteile für Antragsteller, die möglicherweise zu Unrecht unter den Betrugsverdacht gerieten. Die Offenheit des Amsterdamer Modells war bemerkenswert – die Stadt reagierte transparent auf Anfragen, stellte Daten zu Verfügung und kooperierte mit unabhängigen Ermittlern.

Dennoch beeinträchtigte die Notwendigkeit, europäische Datenschutzbestimmungen einzuhalten, die Möglichkeit einer vollständigen externen Überprüfung. Analysen erfolgten teilweise durch die Stadt selbst, die anschließend aggregierte Ergebnisse lieferte. Dieses Vorgehen schafft zwar einen gewissen Schutz der Privatsphäre, birgt aber das Risiko von Fehlern oder Verzerrungen bei der Datenaufbereitung. Die Zusammenarbeit mit der Stadt wurde insgesamt als positiv eingeschätzt, stellt jedoch zugleich beispielhaft für zukünftige Herausforderungen dar, wie öffentliche Algorithmen überprüfbar und nachvollziehbar gemacht werden können. Der Fall Amsterdam steht beispielhaft für die Grenzen und Chancen von Ethik in der Praxis der Künstlichen Intelligenz.

Er zeigt, dass technische Ansätze, so vielversprechend sie auch sind, allein oft nicht genügen, um Diskriminierung nachhaltig zu verhindern. Neben mathematischen Modellen sind auch gesellschaftliche Wertentscheidungen und der Kontext der Anwendung entscheidend. Das Experiment betont die Bedeutung kontinuierlicher Evaluierung, transparenter Kommunikation und einer verantwortungsvollen Einbindung aller Stakeholder, insbesondere der betroffenen Personen. Die europäischen und internationalen Regulierungsvorhaben, wie der EU AI Act oder lokale Vorschriften wie in New York City, spiegeln die Notwendigkeit wider, hohe Standards für den Einsatz von KI in hochsensiblen Bereichen zu setzen. Amsterdam war mit seinem Projekt unter den ersten Städten, die diese Herausforderung offen angingen.

Die dabei gewonnen Erkenntnisse können als wertvolle Grundlage dienen, um zukünftige Systeme fairer zu gestalten – ohne naive Hoffnungen auf einfache technische Lösungen. Insgesamt unterstreicht die Untersuchung des Amsterdamer Projekts, dass der Weg zu ethischer KI vor allem ein Lernprozess ist, der technische, ethische und gesellschaftliche Fragen gleichermaßen berücksichtigt. Anstatt von einem perfekten Modell zu träumen, sollten Entwicklungsprozesse iterative Bewertungen, vielseitige Perspektiven und Kompromisse anerkennen. Nur so lassen sich langfristig vertrauenswürdige Algorithmen entwickeln, die im sozialen Bereich zum Schutz und zur Unterstützung der Bürgerinnen und Bürger beitragen, anstatt neue Hürden zu schaffen.

![I Spent $5M So You Can Go to Space for Free [video]](/images/83BCE2AD-BBA4-4753-96DF-86699BE338B8)