Die rasante Entwicklung von großen Sprachmodellen (Large Language Models, LLMs) hat die Art und Weise, wie wir mit künstlicher Intelligenz interagieren, grundlegend verändert. Diese Systeme, die auf massiven Datensätzen natürlicher Sprache trainiert werden, zeigen beeindruckende Fähigkeiten beim Verstehen und Generieren von Texten. Dennoch stellt sich die Frage, ob der Fokus auf natürliche Sprache der einzige oder beste Weg ist, um die Grenzen der künstlichen Intelligenz auszureizen. Ein alternativer Ansatz, der zunehmende Aufmerksamkeit erhält, ist die Integration von symbolischer Logik in die Entwicklung von LLMs. Bei der symbolischen Logik handelt es sich um eine formale Methode zur Darstellung von Wissen und Schlussfolgerungen mit strikter mathematischer Präzision.

Anders als die üblichen datengetriebenen Sprachmodelle, die durch Mustererkennung in großen Textmengen lernen, basiert die symbolische Logik auf wohldefinierten Regeln und Strukturen. Dies ermöglicht ein besseres Verständnis komplexer Zusammenhänge und fördert die Nachvollziehbarkeit der Entscheidungen eines KI-Systems. Trotz dieses Potenzials verzichten derzeit viele führende KI-Forschungsinstitute darauf, LLMs ausschließlich oder hauptsächlich auf symbolischer Logik zu trainieren. Ein wesentlicher Grund ist, dass viele realweltliche Probleme und Informationen nicht rein logisch-symbolisch ausgedrückt werden können, sondern in natürlicher Sprache codiert sind. Die Komplexität und Variabilität der menschlichen Sprache macht es schwierig, alle Nuancen in formale Logik umzuwandeln.

Zudem haben neuere Entwicklungen wie Googles AlphaProof gezeigt, dass durch natürliche Sprache trainierte Modelle durchaus sehr gut in der Lage sind, symbolische Logik als Teil ihrer Ausgabe zu erzeugen. Dieses Zusammenspiel verdeutlicht, dass natürliche Sprache eine flexiblere Grundlage für vielseitige KI-Anwendungen sein kann, während die symbolische Logik als ergänzendes Werkzeug dient. Dennoch bietet die Kombination der symbolischen Logik mit LLMs erhebliche Vorteile, vor allem im Hinblick auf Erklärbarkeit und Sicherheit der KI-Systeme. Symbolische Strukturen ermöglichen es, die Entscheidungen und Schlussfolgerungen eines Modells nachvollziehbar zu machen, was bei ausschließlich statistisch arbeitenden Modellen eine Herausforderung ist. In sicherheitskritischen Bereichen wie Medizin, Recht oder autonomem Fahren kann diese Transparenz entscheidend sein.

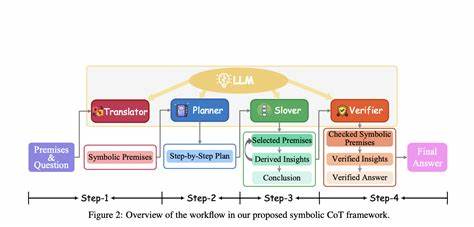

Gleichzeitig sind symbolisch logikbasierte Systeme oft robuster gegenüber Fehlern, da sie auf klar definierten Regeln beruhen, die nicht leicht durch unsinnige oder irreführende Eingaben beeinflusst werden können. Bei der praktischen Implementierung stellen sich jedoch einige Herausforderungen. Die Integration der symbolischen Logik in neuronale Netzwerke erfordert neuartige Methoden und Architekturansätze. Forschung in den Bereichen Neuro-Symbolische KI versucht, diese beiden Welten zu verbinden, indem sie die Lernfähigkeit von Deep Learning und die strukturierte Repräsentation der symbolischen Logik kombiniert. Fortschritte in diesem Bereich könnten zu Systemen führen, die nicht nur hervorragend in der Sprachverarbeitung sind, sondern auch komplexe Argumentationsketten nachvollziehen und logisch konsistente Schlussfolgerungen ziehen können.

Ein weiterer Aspekt ist die Verfügbarkeit geeigneter Daten. Während Textdaten im Internet reichlich vorhanden sind, sind strukturierte, symbolisch logische Daten weniger verbreitet. Die Erstellung und Pflege von umfangreichen symbolischen Wissensdatenbanken erfordert erhebliche Ressourcen. Trotzdem gewinnen Projekte wie Wissensgraphen zunehmend an Bedeutung, da sie strukturierte Wissensrepräsentationen bereitstellen und Schnittstellen zu symbolischen Logiksystemen bieten. Letztlich könnte die Zukunft der KI in der Symbiose von symbolischer Logik und Natural Language Processing liegen.

![How to acquire any language [video]](/images/03F3BF75-1C80-4926-8955-CCBA257FE830)