Im Mai 2025 sorgte eine beunruhigende Enthüllung rund um die renommierte amerikanische Tageszeitung Chicago Sun-Times für große Aufmerksamkeit in Medien- und Technologiekreisen. Das traditionsreiche Blatt veröffentlichte in seiner Sommerausgabe eine Auswahl an Buchempfehlungen sowie Artikel, die ungewöhnliche und fragwürdige Inhalte offenbarten: Einige der empfohlenen Bücher existierten nicht, und ebenso stießen Leser auf Zitate und Expertisen von Personen, die offenbar nicht real sind. Dieser Vorfall wirft nicht nur Fragen nach der Qualitätssicherung und redaktionellen Kontrolle auf, sondern illustriert auch die Risiken, die mit der zunehmenden Integration von Künstlicher Intelligenz (KI) in den journalistischen Alltag verbunden sind. Die Dubiosität der veröffentlichten Inhalte zeigte sich insbesondere bei der Buchempfehlungsliste. In einer ansonsten üblichen und beliebten Sommerlektürensammlung fanden sich neben echten Autoren wie André Aciman auch Titel, die sogenannten Fake Books.

Bemerkenswerte Schriftstellerinnen wie Min Jin Lee oder Rebecca Makkai wurden fälschlicherweise mit Werken zitiert, die sie weder verfasst haben noch deren Existenz sich nachweisen ließ. So wurde Min Jin Lee beispielsweise ein Buch mit dem Titel „Nightshade Market“ zugeschrieben, das angeblich in Seouls Untergrundwirtschaft spielt – eine Tatsachenbehauptung ohne jeglichen Beleg. Ebenso wurde für „Boiling Point“, eine angeblich klimawissenschaftlich angehauchte Geschichte, die reale Autorin Rebecca Makkai verantwortlich gemacht, obwohl auch dieses Werk nicht existiert. Die vermeintlichen Experten, auf die sich die Artikel stützten, erwiesen sich als ähnliche Phantasiegeister. Namen wie Dr.

Jennifer Campos, die als Professorin für Freizeitstudien an der University of Colorado vorgestellt wurde, oder Dr. Catherine Furst, eine angebliche Ernährungsanthropologin an der Cornell University, führen bei einer Suche ins Leere. Auch vermeintliche Quellen, wie ein nicht auffindbarer Bericht von Eagles Nest Outfitters zum Outdoor-Markt, wurden angeführt. Solche Details lassen tief blicken auf eine mangelnde redaktionelle Prüfung. Selbst prominente Zitate, wie jene, die der bekannten Autorin und Fernsehpersönlichkeit Padma Lakshmi zugeschrieben wurden, konnten von ihr nicht bestätigt werden.

Die Chicago Sun-Times reagierte relativ schnell auf die öffentliche Kritik und veröffentlichte eine Stellungnahme, in der das betroffene Material als nicht von der Redaktion geprüft oder freigegeben deklariert wurde. Die fragliche Sommerbeilage wurde einer nationalen Partnerfirma lizenziert, die wiederum als 404 Media und Hearst identifiziert wurden. Die Zeitung versprach, die fraglichen Inhalte aus der digitalen Ausgabe zu entfernen und zukünftige Richtlinien für Drittanbieter-Inhalte zu verschärfen, um sicherzustellen, dass Inhalte gründlich überprüft und klar gekennzeichnet sind. Der Vorfall wirft ein Schlaglicht auf die Spannungsfelder aktueller Medienlandschaften und den Umgang mit KI-generierten Inhalten. Immer häufiger setzen Medienhäuser auf maschinelle Intelligenz und automatische Textgeneratoren, um Berichterstattung zu ergänzen oder gar zu erstellen.

Das birgt enorme Chancen hinsichtlich Effizienz und Produkthaftigkeit, eröffnet aber auch Risiken für die Qualität, Wahrhaftigkeit und Glaubwürdigkeit der Inhalte. Während viele Newsrooms klar betonen, dass solche KI-Texte unter strenger menschlicher Kontrolle stehen müssen, zeigen Einzelfälle, wie bei Gannett und Sports Illustrated, ähnliche Probleme mit Drittanbietern und dem „AI Sludge“ – der schnell und oft unkontrolliert erstellten Massenware – dass die Kontrolle zu leicht entgleiten kann. Ein zentraler Aspekt in der aktuellen Debatte ist die Bedeutung von Transparenz und Nachvollziehbarkeit. Die Leser erwarten von journalistischen Angeboten verlässliche und nachvollziehbare Informationen. Wenn in einem Medium gefälschte Bücher, erfundene Experten oder falsche Zitate auftauchen, leidet das Vertrauen schwer.

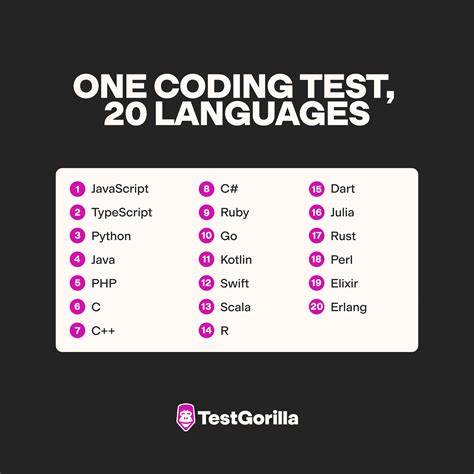

Dieses Vertrauen ist jedoch unbezahlbar, gerade in einer Zeit, in der Medienlandschaften durch Social Media, Fake News und Desinformation ohnehin stark belastet sind. Die Rolle der KI in der Medienproduktion ist dabei ambivalent. Auf der einen Seite können KI-Systeme Recherchen erleichtern, Fakten aus großen Datenmengen schnell filtern, oder repetitive Aufgaben wie das Erstellen von Wetter- oder Sportberichten automatisieren. Auf der anderen Seite sind KI-Modelle häufig auf Trainingsdaten angewiesen, die Fehler und Verzerrungen enthalten können, was zu inhaltlichen Ungenauigkeiten führt. Zudem fehlt der KI ein Verständnis dafür, was wahr oder relevant ist, wodurch diese Maschine selbst zu Falschinformationen beitragen kann.

Die Ursache solcher Vorfälle ist oft ein Zusammenspiel aus mangelnder Kontrolle, hoher Zeit- und Kostendruck, sowie einer fehlerhaften Integration von KI-Technologien. Gerade wenn Inhalte von externen Partnern oder Agenturen stammen, besteht ein erhöhtes Risiko, dass diese die redaktionellen Standards einer Zeitung nicht erfüllen. Gleichzeitig existieren bei vielen Verlagen noch keine klaren, einheitlichen Leitlinien, wie KI-Tools verantwortungsvoll eingesetzt und der redaktionelle Prozess angepasst werden soll. Für die Zukunft bedeutet dies, dass Medienunternehmen nicht nur in technologisches Know-how investieren müssen, sondern auch in persönliche Expertise und Qualitätsmanagement. Eine kritische Haltung gegenüber KI-Ergebnissen innerhalb der Redaktionen ist unabdingbar.

Inhalte, die mithilfe von KI erstellt oder zumindest entworfen werden, sollten immer durch erfahrene Journalisten geprüft und validiert werden. Zudem könnten technische Lösungen wie KI-basierte Fact-Checking-Tools helfen, Fehler frühzeitig zu entdecken. Der Fall Chicago Sun-Times kann auch als Weckruf verstanden werden. Er zeigt, dass der Medienwandel, befördert durch Digitalisierung und Automatisierung, nicht ohne Herausforderungen ist. Qualitätsjournalismus lebt von der Verlässlichkeit und der Glaubwürdigkeit seiner Quellen.

Wenn diese verloren gehen, geraten ganze Medieninstitutionen unter Druck. Für Leser ist es daher ratsam, Informationen aus verschiedenen Quellen zu prüfen und sich ein kritisches Bewusstsein gegenüber Online- und Printmedien zu bewahren. Gleichzeitig wächst die Forderung nach mehr Transparenz seitens der Medienhäuser: Offenlegung, inwiefern KI zum Einsatz kommt, wer die Inhalte erstellt hat und welche Mechanismen der Qualitätssicherung greifen. Der Skandal bei der Chicago Sun-Times zeigt eine Momentaufnahme einer Branche im Wandel. Die Idee, KI als Hilfsmittel im Journalismus zu nutzen, ist verlockend und potenziell bahnbrechend.

Doch der Umgang damit muss verantwortungsvoll gestaltet werden, um nicht langfristig die Basis zu zerstören, auf der gute journalistische Arbeit ruht: das Vertrauen der Leserschaft. Die Lehren aus diesem Debakel könnten künftig als Leitfaden für die Nutzung von KI im Journalismus dienen, der technische Innovationen mit ethischen Grundsätzen vereinbart und so die Medienzukunft nachhaltig sichert.