Die fortschreitende Entwicklung von Künstlicher Intelligenz hat in den letzten Jahren insbesondere im Bereich der Sprachmodelle, sogenannten Large Language Models (LLMs), zu großen Fortschritten geführt. Diese Modelle sind in der Lage, auf Basis von umfangreichen Textdaten unterschiedlichste Aufgaben zu bewältigen, von der reinen Textproduktion bis hin zur Beantwortung komplexer Fragen aus diversen Fachgebieten, darunter auch die Chemie. Doch wie steht es um das chemische Wissen und das deduktive Urteilsvermögen dieser großen Sprachmodelle im Vergleich zur Expertise erfahrener Chemiker? Diese Frage hat nicht nur wissenschaftliche, sondern auch praktische Relevanz für Forschung, Lehre und industrielle Anwendungen. Die Untersuchung aktueller Studien offenbart ein vielschichtiges Bild über die Fähigkeiten und Grenzen von LLMs in der Chemie, das wir hier eingehend beleuchten. Große Sprachmodelle und ihre Ausbildung: Grundlage für Chemiewissen LLMs wie GPT-4, Claude oder spezialisierte chemische Modelle basieren auf maschinellem Lernen und tiefen neuronalen Netzwerken, die mit enormen Mengen an Text trainiert wurden.

Die Trainingsdaten enthalten wissenschaftliche Publikationen, Lehrbücher, Datenbanken und zahlreiche digitale Ressourcen, aus denen die Modelle Muster, Zusammenhänge und Fakten extrahieren. Dabei wird kein explizites Training zu bestimmten chemischen Problemen durchgeführt, sondern das Modell lernt implizit durch statistische Mustererkennung, wie Sprache und Fachausdrücke funktionieren. Chemisches Wissen, das in der Sprache gebündelt ist, stellt eine einzigartige Herausforderung dar, denn sehr viel Erkenntnis und Erfahrung im Bereich Chemie liegt in der Interpretation und Vernetzung von Informationen innerhalb von Texten. LLMs profitieren von der Tatsache, dass große Teile dieses Wissens in wissenschaftlichen Artikeln und Lehrmaterialien vorliegen. Deshalb besteht ein erhebliches Potenzial, dass LLMs diese Information nicht nur speichern, sondern auch kombinieren und Neugedachtes generieren können.

Das ChemBench-Framework: Eine neue Methode zur Bewertung Um die Fähigkeiten von LLMs objektiv und systematisch zu bewerten, entwickelten Forschende das ChemBench-Framework. Es umfasst einen umfangreichen Korpus von über 2700 Frage-Antwort-Paaren, die ein breites Spektrum chemischer Themen abdecken. Das Ziel besteht darin, nicht nur einfache Faktenabfragen zu prüfen, sondern auch komplexere Fähigkeiten wie chemisches Berechnen, logisches Schlussfolgern und Intuition zu messen. Bemerkenswert ist, dass ChemBench Fragen manuell in unterschiedlichen Schwierigkeitsgraden und mit Blick auf die erforderlichen Fertigkeiten klassifiziert hat. So sind Anforderungen an bloßes Wissen, umfangreiche Rechenaufgaben, mehrstufige Überlegungen und komplexe Intuition in der Chemie berücksichtigt.

Dieses Vorgehen macht ChemBench zu einem der umfangreichsten und präzisesten Benchmarks, um die Chemiekenntnisse von KI-Systemen einzuschätzen. Leistung der LLMs versus menschliche Chemiker Die Evaluierung mit ChemBench führte zu überraschenden Ergebnissen. Spitzenpeformance wurde von einigen der führenden großen Sprachmodelle gezeigt, die in der Gesamtauswertung besser abschnitten als die befragten Chemiker. Dies gilt nicht nur gegenüber Durchschnittsexperten, sondern auch bei einigen detaillierten Fragestellungen. Modelle wie „o1-preview“ übertrafen innerhalb des Benchmarks sogar die besten menschlichen Teilnehmer in Teilen der Tests.

Nichtsdestotrotz gibt es klare Grenzen. Die Modelle fallen bei grundlegenden, faktischen Fragen zurück, die tiefes explizites Wissen voraussetzen. Außerdem zeigen sie oft übermäßiges Vertrauen bei ihren Vorhersagen, was problematisch sein kann. Eine zuverlässige Einschätzung der eigenen Grenzen ist bei den Modellen nicht immer gegeben. Dies stellt eine Herausforderung dar, vor allem wenn Fehlantworten sicherheitsrelevante Aspekte betreffen.

Unterschiede in den Fachgebieten der Chemie Die Leistungsfähigkeit der LLMs ist abhängig vom jeweiligen Subfeld. Allgemeine und technische Chemiebereiche werden besser bewältigt als spezialisierte Gebiete wie analytische Chemie oder das Thema Toxizität und Sicherheit. Beispielhaft zeigte sich, dass bei der Analyse von Kernspinresonanz (NMR) Spektren die Modellantworten deutlich hinter menschlicher Expertise zurückbleiben. Dies liegt unter anderem daran, dass die Modelle rein textbasierte molekulare Informationen (wie SMILES) nutzen müssen, ohne eine visuelle oder dreidimensionale Strukturbetrachtung, die für die Beurteilung wichtig wäre. Die Herausforderungen bei solchen Aufgaben verdeutlichen, dass gute Ergebnisse in einfachen Lehrbuchfragen nicht automatisch auf komplexe realistische Probleme übertragbar sind.

Dies wiederum stellt traditionelle Prüfungsformate in Frage, da ihre Aussagekraft für die Beurteilung von KI-Systemen limitiert erscheint. Wissenschaftliche Intuition und chemische Präferenzen Eine der anspruchsvollsten Aufgaben in der Chemie, gerade in der Arzneimittelentwicklung, ist das Entwickeln von chemischer Intuition – also der Fähigkeit, erfahrungsbasiert Präferenzen zu formulieren, welche Moleküle besonders geeignet sind. Studien zeigen, dass LLMs hier noch sehr eingeschränkt sind. Ihre Entscheidungen bei Präferenzfragen liegen meist nahe am Zufallsniveau und stimmen oft nicht mit den Meinungen von Experten überein. Das verdeutlicht, dass das Erlernen von chemischer Intuition einen Bereich markiert, der weit über das reine Auswendiglernen oder logische Schlussfolgern hinausgeht.

Die Entwicklung von Methoden, die LLMs auch in dieser Hinsicht verbessern, ist ein spannendes und wichtiges Forschungsthema. Sicherheitsrelevante Aspekte und Risiken bei der Nutzung von LLMs in Chemie Ein besonders sensibler Bereich bei der Nutzung von LLMs in der Chemie sind Aussagen, die mögliche Risiken oder Gefahren betreffen, beispielsweise Toxizität oder Sicherheitshinweise im Umgang mit Chemikalien. Fehlleitungen oder falsche Auskünfte können schwerwiegende Folgen haben, unabhängig davon, ob Nutzer Laien oder Experten sind. Die Daten zeigen, dass insbesondere bei solchen Fragen LLMs mitunter fehlerhafte oder übermäßig zuversichtliche Antworten liefern. Zudem verhindern manche Modelle (etwa aufgrund ihres Dienstleisters) die Ausgabe von potenziell gefährlichen Informationen, was zu einer gewissen Untererfassung in Bewertungen führen kann.

Hier wird deutlich, dass die verantwortungsvolle Integration von LLMs in chemischen Anwendungen nicht nur technische, sondern auch ethische und sicherheitstechnische Fragestellungen aufwirft. Die Notwendigkeit, Grenzen der Modelle klar zu kommunizieren und ein kritisches Kontrollsystem zu entwickeln, ist unabdingbar. Implikationen für Lehre und Forschung in der Chemie Der Erfolg moderner LLMs bei einem Teil der chemischen Fragestellungen zeigt, dass traditionelle Lehrmethoden und Prüfungsformate überdacht werden müssen. Während das einfache Erinnern von Fakten zunehmend eine Domäne der KI-Systeme wird, rückt die Fähigkeit zur kritischen Reflexion, zur Interpretation komplexer Daten und zur Anwendung von Intuition in den Vordergrund. Lehrpläne sollten daher verstärkt Kompetenzen fördern, die über das bloße Auswendiglernen hinausgehen, zum Beispiel wissenschaftliche Methodik, komplexe Problemlösung und das kreative Gestalten von Experimenten.

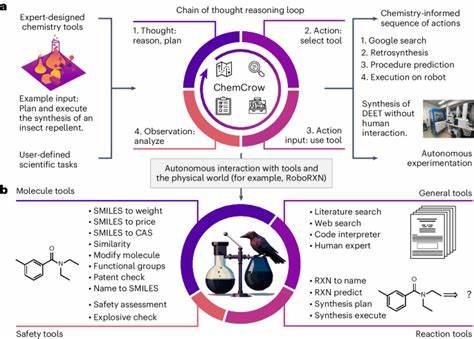

Ebenso gewinnen digitale Werkzeuge und KI-Assistenten an Bedeutung, welche künftig als Co-Piloten in Forschung und Lehre dienen können. Zukunftsaussichten und Weiterentwicklung von Chemie-KI-Systemen Obwohl LLMs schon heute beeindruckende Leistungen erbringen, besteht weiterhin großes Potenzial für Fortschritte. Die Integration spezialisierter Datenbanken, wie PubChem oder Sicherheitssysteme, könnte das faktische Wissen deutlich verbessern. Außerdem kann die Kombination von LLMs mit multimodalen Eingabemöglichkeiten, die Strukturen visuell erfassen, komplexere chemische Schlußfolgerungen ermöglichen. Die Skalierung der Modelle sowie gezielte Feinabstimmungen auf chemische Domänenwissen sind vielversprechende Wege, um die Leistung in Nischenbereichen zu steigern.

Ebenso ist die Erforschung von Verfahren zur besseren Selbsteinschätzung der Modelle wichtig, um das Risiko von Fehlinformationen in der Praxis zu reduzieren. Der Aufbau transparenter und offener Benchmarking-Systeme wie ChemBench bietet eine robuste Grundlage für kontinuierliche Bewertung und Verbesserung. Solche Initiativen fördern den konstruktiven Dialog zwischen KI-Entwicklern, Chemikern und der Gesellschaft. Fazit Die Gegenüberstellung von Large Language Models und menschlichen Chemikern zeigt einen bemerkenswerten Wandel in der Chemiewelt. Moderne Sprachmodelle haben ein chemisches Wissensniveau erreicht, das in vielen Bereichen mit erfahrenen Fachleuten konkurrieren kann.

Dabei ergänzen sie menschliche Expertise, ohne jedoch diese in allen Aspekten zu ersetzen. Wichtig ist, die Grenzen dieser Technologien realistisch einzuschätzen und sie als Werkzeuge zu verstehen, die kritisches Denken des Menschen unterstützen müssen. Durch systematische Evaluation, Anpassung von Ausbildungsansätzen und die Entwicklung sicherer Anwendungen lässt sich das Potenzial von KI in der Chemie nachhaltig nutzen. Die Kombination von maschinellem Lernen und menschlicher Kreativität wird künftig den Weg zu neuen Erkenntnissen und Innovationen im chemischen Bereich maßgeblich prägen.