Die rasante Entwicklung der Künstlichen Intelligenz (KI) stellt die traditionelle Computerhardware vor enorme Herausforderungen. Klassische digitale Rechner stoßen zunehmend an ihre Grenzen, wenn es darum geht, komplexe probabilistische Modelle oder generative Algorithmen effizient und energieeffizient auszuführen. Eine vielversprechende Alternative dazu bieten thermodynamische Rechensysteme, die auf physikalischen Prinzipien der Thermodynamik basieren und dadurch völlig neue Möglichkeiten für die Berechnung eröffnen. Thermodynamische Rechensysteme nutzen die stochastischen dynamischen Prozesse eines physikalischen Systems, um komplexe mathematische Operationen durchzuführen. Insbesondere zielen sie darauf ab, elementare Verfahren wie das Ziehen von Stichproben aus Wahrscheinlichkeitsverteilungen oder die Lösung linearer Algebraaufgaben auf analoge Weise zu beschleunigen.

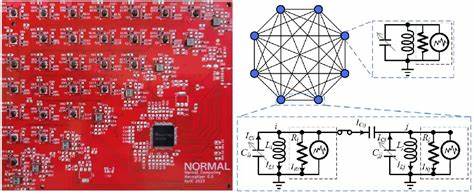

Die Natur dieser Systeme basiert auf einem Gleichgewichtszustand – einer sogenannten Gibbs-Verteilung – welche die Wahrscheinlichkeitsdichte der Zustände des Systems darstellt und durch die Energie- bzw. Potenzialfunktion des Systems definiert wird. Ein bemerkenswertes Beispiel für einen solchen thermodynamischen Computer ist die sogenannte stochastische Verarbeitungseinheit (Stochastic Processing Unit, SPU), die auf einem gedruckten Schaltkreisboard mit mehreren kapazitiv gekoppelten RLC-Schaltkreisen basiert. Jede dieser Einheitenzellen besteht aus Bauteilen wie Induktivitäten, Kapazititäten und Widerständen, wobei ein gezieltes Rauschen als notwendiger Bestandteil integriert ist. Dieses Rauschen entspricht dem thermischen Fluktuationen in physikalischen Systemen und ermöglicht es, aus einer vorgegebenen Wahrscheinlichkeitsverteilung zu sampeln.

Durch das Einstellen der Kapazitäten und der Kopplungen zwischen den Einheiten kann die Verteilung, aus der die Samples gezogen werden, präzise programmiert werden. Der Vorteil dieser Vorgehensweise liegt in der Energieeffizienz und der potenziellen Zeitersparnis. Im Gegensatz zu digitalen Rechnern, die deterministisch Operationen sequenziell ausführen, nutzen thermodynamische Systeme die inhärenten physikalischen Prozesse direkt aus und können so parallele Berechnungen über zahlreiche Zustände hinweg realisieren. Insbesondere bei probabilistischer KI, zu der auch Modelle der Bayesschen Inferenz oder Diffusionsmodelle gehören, erfordert die Berechnung häufig das Ziehen großer Mengen von Stichproben aus hochdimensionalen Wahrscheinlichkeitsverteilungen – eine Aufgabe, bei der thermodynamische Systeme ihre Stärken ausspielen. Die Verbindung zwischen Thermodynamik und Wahrscheinlichkeitsrechnung ist dabei nicht zufällig.

Die Langevin-Gleichungen, die die Dynamik von Systemen unter Einwirkung von konservativen, dissipativen und zufälligen Kräften beschreiben, lassen sich mathematisch auf Systeme übertragen, die aus Wahrscheinlichkeitsverteilungen sampeln. Solche stochastischen Differentialgleichungen modellieren den zeitlichen Verlauf der Zustände eines Systems, welche sich im Gleichgewicht zu einer stabilen Verteilung entwickeln. Die Herausforderung liegt darin, das thermodynamische Potential bzw. die Energie so umzusetzen, dass diese Gleichgewichtsverteilung exakt der gewünschten Verteilung entspricht. In der Praxis wurde mit dem SPU ein funktionsfähiger Prototyp geschaffen, der zeigt, dass sowohl das Ziehen von Proben aus mehrdimensionalen Gaußschen Verteilungen als auch das Invertieren von Matrizen über thermodynamische Prozesse möglich ist.

In Bindung mit digitaler Steuerungs- und Ausleseelektronik dient der SPU als Coprozessor, der von einem klassischen Computer gesteuert wird. Er zeichnet sich dadurch aus, dass trotz analogen Grundprinzips die gezielte Programmierbarkeit von Parametern eine flexible Anwendbarkeit garantiert. Die experimentellen Ergebnisse mit mehreren identischen Einheiten zeigten reproduzierbare Genauigkeit bei geringerem Energieverbrauch im Vergleich zu digitalen GPUs für große Problemgrößen. Eine der größten Herausforderungen bei der Skalierung solcher Systeme liegt im Hardwaredesign. Induktivitäten und Transformatoren, die in kleinen Skalen eingesetzt wurden, lassen sich schlecht in CMOS-Integrierte Schaltkreise integrieren.

Um dieses Problem zu umgehen, wurde eine Architektur vorgeschlagen, die rein auf Widerständen und Kapazitäten basiert. Sie verzichtet auf Induktivitäten und nutzt einen Widerstandskoppelschaltkreis, der die Skalierbarkeit maßgeblich verbessert und gleichzeitig die thermodynamischen Eigenschaften bewahrt. Simulationen mit elektronischen Schaltungssimulatoren zeigen zudem, dass diese Architektur trotz Realwelt-Fehlern und Bauteiltoleranzen stabil und akkurat bleibt. Die Vorteile thermodynamischer Rechner liegen nicht nur in der Effizienz, sondern auch in der inhärenten Fehlerresistenz. Da Rauschen und Fluktuationen gewollte Bestandteile des digitalen Systems sind, sind diese Systeme robuster gegenüber externen Störungen.

Allerdings bleibt die Frage der Präzision eine zentrale Herausforderung, denn Bauteiltoleranzen und quantisierte Bedienelemente beeinflussen die Qualität der Ergebnisse. Neu entwickelte Fehlerkorrektur- und Mittelungsstrategien versuchen dabei, die Genauigkeit deutlich zu verbessern, ohne die Vorteile der thermodynamischen Herangehensweise einzubüßen. Der Vergleich der Leistung thermodynamischer Systeme mit modernen digitalen GPUs deutet darauf hin, dass ab einer gewissen Problemgröße ein thermodynamischer Vorteil entsteht. Während bei kleineren Dimensionen digitale Lösungen oft schneller sind, steigt mit wachsender Größe der Vorteil der physikalischen Systeme, da ihre Laufzeit im Wesentlichen quadratisch im Problemumfang wächst, während digitale Algorithmen oft eine kubische Komplexität aufweisen. Beim Energieverbrauch zeigen thermodynamische Systeme von Beginn an Vorteile, was vor allem für große, energieintensive KI-Berechnungen relevante Bedeutung hat.

Doch nicht nur die Hardware, auch die Anwendungen profitieren von der Innovation. Probabilistische KI-Anwendungen, die Unsicherheiten abbilden, Wahrscheinlichkeiten berechnen und robuste Entscheidungen treffen müssen, gelten als sehr rechenintensiv. Thermodynamische Systeme ermöglichen es, diese Algorithmen nativer und effizienter zu implementieren. Von Bayesscher Regression über Gaussian Processes bis hin zu generativen Modellen wie Diffusionsprozessen – vielfältige KI-Praktiken können von solchen Computern profitieren. Zukünftige Entwicklungen zielen darauf ab, die Konnektivität und Größe der Netzwerke zu erhöhen, ohne auf vollständige Kopplungen zwischen allen Einheiten angewiesen zu sein.

Durch geeignete Approximationen und reduzierte Rangfaktorzerlegungen lässt sich der Hardwareaufwand reduzieren, um realistisch Tausende oder Zehntausende von Recheneinheiten in einem System zu integrieren. Darüber hinaus sind Weiterentwicklungen geplant, die nicht mehr nur Gaußverteilungen, sondern auch nichtlineare, nicht-Gaußsche Verteilungen naturgetreu abbilden können, um noch anspruchsvollere KI-Aufgaben zu unterstützen. Im Vergleich zur Quanteninformatik, die ebenfalls auf physikalische Systeme für spezielle Berechnungen setzt, bieten thermodynamische Computer den Vorteil niedrigeren technologischen Aufwands. Sie operieren bei Raumtemperatur, erfordern keine Isolationserfordernisse wie Quantenkohärenz und lassen sich mit etablierter CMOS-Fertigungstechnologie herstellen. Damit erscheinen sie als vielversprechende Technologie mit kurzfristiger Realisierbarkeit zur Ergänzung und Beschleunigung heutiger KI-Systeme.

Insgesamt zeichnen thermodynamische Rechensysteme ein attraktives Bild für die Zukunft der Künstlichen Intelligenz. Ihre Kombination aus physikalischer Eleganz, Effizienz und Anpassungsfähigkeit stellt einen Paradigmenwechsel hinsichtlich der Hardwarearchitekturen dar, auf denen die nächste Generation von KI-Anwendungen basiert. Während konventionelle digitale Architekturen weiterhin eine wichtige Rolle spielen, könnten vielversprechende Ergebnisse aus der thermodynamischen Domäne dazu beitragen, insbesondere im Bereich der probabilistischen Modelle und generativen KI-Systeme neue Maßstäbe zu setzen. Mit dem Voranschreiten der Forschung und Entwicklung sowie der Miniaturisierung der Hardwarekomponenten könnte die thermodynamische Computertechnologie bald von experimentellen Prototypen zu industriell nutzbaren Systemen reifen. Innovative Fehlerkorrekturmechanismen, skalierbare Architekturkonzepte und eine bessere Integration in bestehende digitale Ökosysteme sind dabei die zentralen Herausforderungen.

Werden diese gemeistert, ist der Weg frei für eine neue Klasse von effizienten, verlässlichen und schnellen KI-Beschleunigern, die sowohl Prozesse in der Wissenschaft, Industrie als auch im täglichen Leben revolutionieren könnten.