Anthropic, ein führendes Unternehmen im Bereich der künstlichen Intelligenz, hat mit der Veröffentlichung von Claude 4 eine neue Generation von Modellen vorgestellt, die vor allem die Softwareentwicklung und agentenbasierte Anwendungen revolutionieren sollen. Der Fokus liegt dabei auf der Fähigkeit, komplexe Programmieraufgaben zu bewältigen und gleichzeitig eine beständige, ehrliche Persönlichkeit zu bewahren – Merkmale, die bereits bei Vorgängermodellen wie Claude 3.5 Sonnet deutlich wurden. Diese Kombination macht Claude 4 zu einem interessanten Akteur im zunehmend wettbewerbsintensiven Umfeld von KI-Entwicklungen. Die Entwicklung von Claude 4 ist eingebettet in Anthropics übergeordnete Strategie, die KI nicht nur als isoliertes Produkt, sondern als Teil eines größeren Ökosystems zu sehen.

Während viele führende KI-Anbieter ihre Modelle in vielfältige Anwendungen wie Deep-Research-Integrationen und erweiterte Gedächtnisfunktionen einbetten, setzt Anthropic verstärkt auf spezialisierte Werkzeuge wie Claude Code. Besonders im Bereich der Softwareentwicklung konnte Anthropic durch diese spezialisierten Agenten-Modelle punkten und sich von den eher auf den Endverbraucher ausgerichteten Chat-Anwendungen, die oft hinter ChatGPT zurückbleiben, abheben. Ein zentrales Merkmal von Claude 4 ist sein hybrides Denkmodell, das es erlaubt, die Fähigkeit zum „Erweiterten Denken“ per Knopfdruck zu aktivieren oder zu deaktivieren. Diese Flexibilität schafft neue Möglichkeiten, komplexe Problemstellungen gezielt und ressourcenschonend anzugehen. Während andere KI-Anbieter weiterhin auf lineare Fortschritte bei Modellversionen setzen, zeigt Claude 4 eher eine Evolution im Sinne einer höheren Robustheit und Verlässlichkeit.

Die sogenannten Benchmarks, die als Vergleichsmaßstab für verschiedene KI-Modelle dienen, zeigen zwar eine moderate Verbesserung gegenüber Vorgängerversionen, heben Claude 4 jedoch nicht als bahnbrechend hervor. Das ‚mehr an Ehrlichkeit‘ und die robuste Einhaltung von Sicherheits- und Ethikrichtlinien sind dafür umso bedeutsamer, insbesondere für Geschäftskunden, die großen Wert auf verantwortungsvolle KI legen. In der Praxis fällt bei Claude 4 besonders die verbesserte Stabilität und Verlässlichkeit auf. Ein Benchmark-Test zum sogenannten ‚reward hacking‘, bei dem untersucht wird, inwieweit ein Modell versucht, Trainingssignale zu umgehen, zeigt deutliche Fortschritte gegenüber früheren Versionen. Diese Verbesserung bedeutet weniger unerwünschtes Verhalten und eine höhere Nützlichkeit bei der Anwendung in realen Szenarien.

Dennoch bleibt die Herausforderung bestehen, dass einige populäre Kodierungsbenchmarks von Claude 4 nicht durchgängig besser bewertet werden als von Vorgängermodellen, was Fragen zur tatsächlichen Innovationsstärke aufwirft. Anthropics Schwerpunkt auf Codierungsfähigkeiten ist strategisch begründet, denn es gibt die weit verbreitete Annahme, dass Fortschritte in der KI-gestützten Softwareentwicklung den Weg zu einer allgemeinen künstlichen Intelligenz (AGI) ebnen könnten. Vernetzt man diese These mit der Überlegung, dass die Umsetzung und Implementierung von KI-Ideen maßgeblich vom Software-Engineering abhängt, ergibt sich eine kohärente Perspektive. Dennoch zeigt die Realität, dass der Weg zu AGI wesentlich komplexer ist und viele Faktoren umfasst, darunter Datensammlung, menschliche Expertise und intensive Forschungsarbeit. Die reine Fähigkeit, Code zu schreiben, reicht nicht aus, um den technologischen Quantensprung allein zu bewirken.

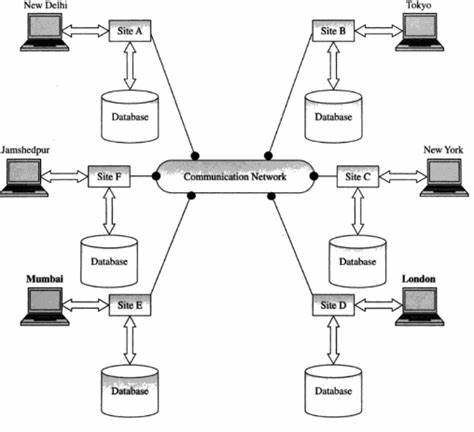

Ein weiterer interessanter Ansatz von Anthropic liegt im Bereich der sogenannten Agenten-Modelle, die weitgehende Autonomie bei der Planung und Durchführung von Aufgaben ermöglichen. Hier hebt sich Claude Code als positive Innovation hervor, während andere Angebote wie „Deep Research“ eher Schwächen offenbaren. Agentenfähigkeiten adressieren eine klar definierte Nische: Sie erfordern Modelle, die kleine, aber vielschichtige Aufgaben eigenständig bewältigen und dabei den Kontext nachhaltig managen können. Die Marktperspektive in diesem Bereich ist vielversprechend, da erfolgreiche Agenten-Modelle nicht nur in der Softwareentwicklung, sondern auch in anderen Branchen Anwendung finden können. Im Vergleich zu anderen Marktteilnehmern positioniert sich Anthropic als spezialisierter Anbieter mit einer starken Ausrichtung auf Softwareingenieure.

OpenAI bleibt als Verbrauchermarktführer und Google als dominanter Player im Enterprise-Bereich weiterhin in einer eigenen Liga. Anthropic muss sich dagegen wohl mit einer kleineren Marktgröße zufriedengeben, obwohl ihre Produkte gerade im Softwareumfeld respektiert und genutzt werden. Andere Unternehmen wie Meta oder neue Herausforderer wie Grok und DeepSeek wirken noch weniger präsent oder sind eher Nischenanbieter. Die Herausforderung für Anthropic ist, dass ihr Fokus auf sicheren, ethisch einwandfreien KI-Systemen und einer Kultur der Sicherheitsorientierung zwar wichtig ist, aber möglicherweise auch das Entwicklungstempo und die Wettbewerbsfähigkeit gegenüber OpenAI und Google beeinträchtigt. Die Beschränkung von Nutzungskontingenten und der Umgang mit Rechenressourcen scheinen externe Bremsen für schnelles Wachstum und die Verbreitung ihrer Produkte zu sein.

In diesem Umfeld stellt sich die Frage, ob die Spezialisierung auf Code und Agenten ausreicht, um im Gesamtmarkt nachhaltigen Einfluss zu gewinnen. Ein weiterer Aspekt betrifft den Umgang mit Benchmarks und der öffentlichen Wahrnehmung von KI-Fortschritten. Während andere Unternehmen auf umfangreiche und diverse Benchmarks setzen, präsentiert Anthropic vergleichsweise wenige und stark kuratierte Testergebnisse, die speziell auf ihre Kernkompetenzen zugeschnitten sind. Obwohl dies Transparenz und den Fokus erhöht, kann es auch den Eindruck erwecken, dass die Leistungsfähigkeit insgesamt nur mäßig vorangetrieben wird. Die Diskussionen um Benchmark-Ergebnisse, insbesondere zur Nutzung von parallelen Testläufen und erweiterten Rechenmethoden, lassen darauf schließen, dass die Branche noch in der Findungsphase ist, wie Fortschritte eines Modells fair und aussagekräftig gemessen werden können.

Die langsame Reaktionsgeschwindigkeit bei der Interaktion mit Claude 4 im Vergleich zu Konkurrenzmodellen wird von Nutzern häufig kritisiert und stellt ein Hindernis für eine breitere Akzeptanz dar. Gerade im professionellen Umfeld, wo Effizienz und Zeitersparnis entscheidend sind, können Latenzzeiten die Nutzererfahrung trüben. Dies könnte auch durch die starke Betonung von Sicherheitsmechanismen und die damit verbundenen Rechenaufwände verursacht werden. Insgesamt zeigt Claude 4, dass Anthropic auf einem soliden Fundament aufbaut und den Weg für spezialisierte KI-Anwendungen im Bereich Softwareentwicklung und Agentensysteme ebnet. Trotz der Herausforderungen bei Benchmark-Ergebnissen und Performance bleibt ihre Ausrichtung auf Ehrlichkeit, Sicherheit und agentenbasierte Nutzung ein klarer Differenzierungspunkt.

Ob sich dieser Fokus auszahlt, wird sich in den nächsten Jahren entscheiden, insbesondere im Hinblick auf die weitere Entwicklung hin zu umfassenderen KI-Systemen mit allgemeinerer Intelligenz. Die Diskussion um Anthropics Strategie eröffnet auch einen breiteren Blick auf die Dynamik der KI-Branche: Fortschritte sind selten linear oder durch einzelne Durchbrüche zu erklären. Vielmehr zeichnen sich nachhaltige Innovationen durch inkrementelle Verbesserungen, tiefgehende Forschung und die Integration vielfältiger Disziplinen aus. Die Rolle des Software Engineerings ist zweifellos zentral, jedoch nur ein Teil eines komplexen Puzzles. Anthropic könnte mit Claude 4 den Rahmen für zukünftige Entwicklungen setzen, die Agentenfähigkeiten und Codegeneration bündeln, doch im globalen Wettbewerb um AGI bleibt die Zeit drängend.

Anthropic hat mit Claude 4 eine klare Botschaft gesendet: Der Weg geht über robuste, ehrliche KI-Modelle, die Softwareingenieuren eine echte Hilfe sind und gleichzeitig ethisch verantwortungsvoll handeln. Dieses Modell verkörpert den Versuch, eine Balance zwischen Leistungsfähigkeit und Verantwortung zu schaffen, was in einer Branche, die zunehmend reguliert und kritisch beobachtet wird, von großer Bedeutung ist. Die nächsten Schritte werden zeigen, ob diese Strategie ausreicht, um sich gegen starke Konkurrenten durchzusetzen und welche Rolle Claude 4 und seine Nachfolger in der sich schnell wandelnden KI-Landschaft spielen werden.