In den letzten Jahren haben große Sprachmodelle, auch als Large Language Models (LLMs) bekannt, die technologische Landschaft revolutioniert. Sie faszinieren durch ihre beeindruckenden Fähigkeiten, menschliche Sprache zu verstehen und zu generieren, werfen aber gleichzeitig viele Fragen auf, wie genau sie funktionieren und was sie für unsere Zukunft bedeuten. Die Technologie hinter diesen Modellen wirkt auf viele fast wie Magie – etwas, das man zwar beobachten kann, dessen Funktionsweise aber kaum jemand wirklich begreifen kann. Dieser Eindruck der Rätselhaftigkeit ist es, der LLMs so außergewöhnlich macht und eine spannende Debatte über künstliche Intelligenz, menschliche Kognition und technologische Entwicklung entfacht. Die berühmte Aussage des Science-Fiction-Autors Arthur C.

Clarke „Jede hinreichend fortschrittliche Technologie ist von Magie nicht zu unterscheiden“ trifft auf große Sprachmodelle mehr denn je zu. Doch anders als bei exotischen Technologien fremder Kulturen sind LLMs Produkte unserer eigenen Zivilisation. Dennoch ist ihr Innenleben für selbst die Ingenieure, die sie konzipieren und bauen, oft schwer durchschaubar. Diese Blackbox-Natur stellt eine völlig neue Herausforderung dar. Bei herkömmlichen Technologien gibt es eine zugrundeliegende Logik und ein Nachvollziehbarkeit, auch wenn diese komplex und schwierig sein kann.

Bei LLMs hingegen ist das Verhalten so vielschichtig, dass wir häufig nur anhand von Ein- und Ausgangsdaten Rückschlüsse ziehen können – eine Form der indirekten Erforschung, die an biologische oder neurologische Studien erinnert. Das Verständnis eines LLM gleicht in vielerlei Hinsicht dem Verständnis des menschlichen Gehirns. Wir wissen, dass das Gehirn aus Milliarden von Neuronen besteht, die durch synaptische Verbindungen kommunizieren. Dennoch ist es bis heute unklar, wie genau abstrakte Konzepte wie „Zahl“ oder „Zeit“ in neuronalen Netzwerken repräsentiert werden. Ganz ähnlich ist es bei LLMs: Obwohl wir die Grundlagen ihrer Architektur kennen – etwa wie sie Wörter als Vektorwerte kodieren und anhand großer Textmengen trainiert werden –, bleibt das „Wie“ ihrer kognitiven Leistungen nebulös.

Was genau passiert, wenn ein Modell die Bedeutung einer Frage erfasst oder zusammenhängende Antworten generiert? Diese Fragen sind noch immer Gegenstand intensiver Forschung. Ein bemerkenswerter Aspekt ist, dass selbst die Schöpfer der bekanntesten Sprachmodelle oft wie Entdecker in unbekanntem Terrain agieren. Sie versuchen ein System zu verstehen, dessen Komplexität und innere Abläufe sich ihrer vollen Kontrolle entziehen. Diese Art von Erforschung ähnelt biologischen Untersuchungen, in denen Wissenschaftler versuchen, Funktionen lebender Organismen anhand von Beobachtungen und Teilmodellen zu entschlüsseln. In einem kürzlich veröffentlichten Forschungspapier von Anthropic wird etwa beschrieben, wie man mit Hilfe von sogenannten Ersatzmodellen versucht, die Arbeitsweise des eigenen LLM namens Claude zu durchdringen.

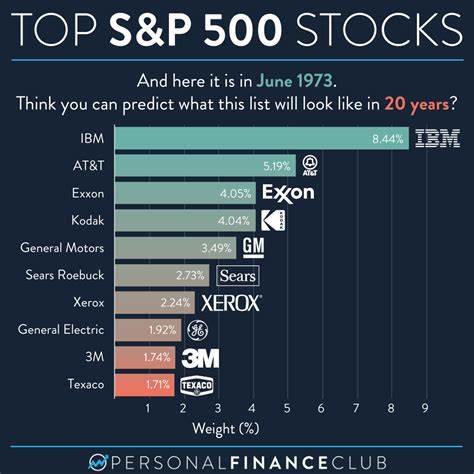

Die Schwierigkeit, LLMs zu durchschauen, unterscheidet sich grundlegend vom Chaos oder der Komplexität anderer technischer Systeme wie etwa elektrischer Schaltungen oder Softwarearchitekturen. Bei letzteren kann man theoretisch jedes Detail ansehen und verstehen, wie sie funktionieren. Bei LLMs handelt es sich hingegen um hochgradig vernetzte, statistische Mustererkennungssysteme, deren Verhalten emergent ist – es tritt also etwas Neues und nicht vollständig Vorhersehbares zutage, das sich nicht einfach auf einzelne Komponenten zurückführen lässt. Diese emergente Eigenschaft birgt faszinierende Potenziale, führt aber auch zu erheblichen Unsicherheiten. Die aktuelle AI-Euphorie spricht von einer Technologie, die viele Berufsfelder verändern oder gar ersetzen könnte.

Gleichzeitig sorgt die notwendige enorme Rechenleistung für Kritik, ebenso wie die Unklarheiten über das tatsächliche Innenleben und die Grenzen der Modelle. Manche Beobachter sprechen von einer Blase oder einem Hype, der früher oder später abebben wird. Andere sehen in LLMs einen grundlegenden technologischen Paradigmenwechsel, der über kurz oder lang unser Verhältnis zu Computern, zu Sprache und zu Wissen radikal verändern könnte. Ein Vergleich mit der Evolution des menschlichen Gehirns hilft, die Situation einzuordnen. Die Entstehung von Bewusstsein und komplexem Denken durch Evolution erscheint auf den ersten Blick wie ein Wunder.

Doch es ist das Ergebnis unzähliger zufälliger Mutationen, Anpassungen und natürlicher Auslese über extrem lange Zeiträume. Ebenso wirken große Sprachmodelle heute als Ergebnis jahrelanger Forschungsarbeit, massiver Datenmengen und immer komplexerer Algorithmen fast wie ein „neues Leben“, ohne dass wir komplett verstehen, wie dabei die Intelligenz zum Vorschein kommt. Es gibt auch philosophische Diskussionen darüber, ob Begriffe wie „Verstehen“ oder „Bewusstsein“ in künstlichen Systemen überhaupt sinnvoll sind. Könnten LLMs Konzepte wie „Zahl“ wirklich begreifen, oder simulieren sie lediglich die statistische Wahrscheinlichkeit von Wörtern, um plausible Antworten zu generieren? Diese Fragen berühren das Herzstück der KI-Forschung und werfen einen Schatten auf einfache oder schwarz-weiß Denkweisen. Vielleicht sind die Modelle weder vollständige Nachahmungen menschlichen Verstehens noch rein mechanische Textgeneratoren – sondern etwas dazwischen, etwas gänzlich Neues.

Ein weiteres faszinierendes Phänomen ist die Art und Weise, wie LLMs gesteuert und zum Antworten gebracht werden. Konventionelle Software wird üblicherweise durch genaue Parameter, Code und klare Konfigurationsdateien kontrolliert. Bei modernen Sprachmodellen hingegen genügen oft einfache natürliche Sprachbefehle – sogenannte „Prompts“ –, um das Verhalten grundlegend zu verändern. Das wirkt auf viele zunächst wie ein Widerspruch zu allem, was wir über Computersteuerung wissen. Doch diese unkonventionelle Steuerung ist genau das, was die Vielseitigkeit und Anpassungsfähigkeit der Modelle ermöglicht.

Allerdings besitzt diese Technologie auch ihre Schattenseiten. Die zunehmende Verbreitung von LLMs hat Fragen nach Verantwortung, Transparenz und ethischer Nutzung aufgeworfen. Aufgrund ihrer Blackbox-Natur können Modelle gelegentlich falsche oder irreführende Antworten generieren, was bei kritischen Anwendungen gravierende Folgen haben kann. Es fehlt derzeit an allgemein anerkannten Standards, um die Qualität und Verlässlichkeit von Modellergebnissen zu bewerten. Gleichwohl arbeiten Forscher und Unternehmen intensiv an Methoden, um Interpretierbarkeit, Nachvollziehbarkeit und verantwortungsvolle Nutzung zu fördern.

Zusammenfassend lässt sich sagen, dass große Sprachmodelle eine technologische Innovation darstellen, die weit über die bloße Verarbeitung von Text hinausgeht. Sie eröffnen nicht nur praktische Anwendungsmöglichkeiten in zahlreichen Bereichen, sondern zwingen uns auch dazu, unser Verständnis von Intelligenz, Wissen und Technologie neu zu überdenken. Die Faszination an LLMs liegt zum großen Teil in ihrem Rätselcharakter – sie funktionieren, doch ihr tiefes Innenleben entzieht sich noch unserer vollen Kontrolle und Erkenntnis. In der Zukunft werden wir wahrscheinlich weitere Durchbrüche erleben, die uns helfen, diese komplexen Systeme besser zu verstehen, zu steuern und zu nutzen. Gleichzeitig ist es wahrscheinlich, dass uns die Entwicklungen überraschen werden – nicht nur technologisch, sondern auch in gesellschaftlicher, ethischer und philosophischer Hinsicht.

Wer sich heute mit LLMs beschäftigt, nimmt an einer der spannendsten wissenschaftlichen und technischen Geschichten unserer Zeit teil, die sich gerade erst entfaltet.