In den letzten Jahren hat die Entwicklung von Künstlicher Intelligenz (KI), insbesondere von großen Sprachmodellen (LLMs), wie GPT, Deep Learning und verwandten Technologien, die Art und Weise revolutioniert, wie wir mit Daten und Wissen umgehen. Parallel dazu entstand vor mehr als zwei Jahrzehnten die Idee des Semantic Webs, eine Vision, die darauf abzielte, Informationen im Internet so zu strukturieren und zu annotieren, dass sie von Maschinen besser interpretiert werden können. Nun stellt sich die Frage, ob die modernen KI-Anwendungen der Semantic-Web-Technologie neues Leben eingehaucht haben oder sie vielmehr überflüssig machen. Die Debatte um diese Fragestellung ist vielschichtig und spiegelt verschiedene Perspektiven wider. Im Folgenden wird beleuchtet, wie sich diese beiden Technologien ergänzen, konfligieren und gemeinsam die Zukunft des digitalen Wissens formen können.

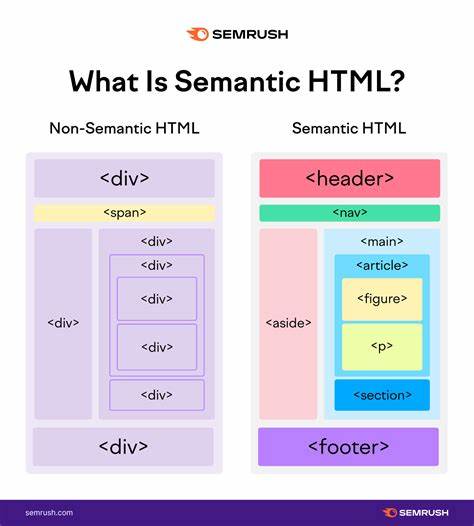

Das ursprüngliche Ziel des Semantic Webs war es, die enorme Menge an Online-Informationen durch maschinenlesbare Metadaten besser nutzbar zu machen. Dabei spielen Ontologien, die Definition von Beziehungstypen zwischen Datenpunkten, und formale Sprachen wie RDF, OWL oder SPARQL eine zentrale Rolle. Diese Technologien ermöglichen es Systemen, nicht nur Daten zu sammeln, sondern sie auch inhaltlich zu verstehen, Zusammenhänge herzustellen und sinnvoll zu verknüpfen. Trotzdem konnte sich das Semantic Web nie wirklich auf globaler Ebene durchsetzen. Der Grund dafür liegt unter anderem in der aufwändigen manuellen Annotation der Daten sowie in der Komplexität der Werkzeuge und Standards.

Mit dem Aufstieg moderner KI-Modelle, die auf riesigen Textkorpora trainiert werden, scheint das Semantic Web an Bedeutung zu verlieren. Modelle wie GPT erzeugen beeindruckende Ergebnisse, indem sie Texte ohne explizite semantische Markup-Elemente analysieren, verstehen und generieren können. Einige Kommentatoren argumentieren, dass KI die Notwendigkeit für formale Markierungen überflüssig macht, weil die Algorithmen aus ihrer Trainingsbasis Bedeutung und Zusammenhänge implizit ableiten. Tatsächlich tokenisiert ein LLM jede Eingabe in gewichtete Zahlenwerte und nutzt Mustererkennung, um Antworten zu generieren, ohne dass spezielle Deklarationen benötigt werden. Dies ermöglicht Flexibilität und eine vereinfachte Handhabung großer Datenmengen, jedoch auf Kosten der expliziten und nachvollziehbaren Strukturierung von Wissen.

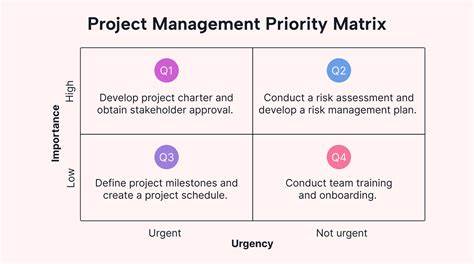

Trotzdem gibt es auch gegenteilige Stimmen, welche die Relevanz semantischer Technologien gerade im Kontext von KI betonen. Besonders bei der Organisation, Organisation und Interpretation von Wissen sind graphbasierte Strukturen wie Knowledge Graphs weiterhin unerlässlich. Diese erlauben es, Datenquellen zu verbinden, komplexe Beziehungen darzustellen und semantische Inferenz durchzuführen. So unterstützen Knowledge Graphs etwa den Prozess des Retrieval Augmented Generation (RAG), bei dem ein KI-Modell gezielt auf eine externe Datenbasis zugreift, um fundierte und überprüfbare Antworten zu liefern. Derartige Hybrid-Lösungen sind heute besonders gefragt, um der bekannten Problematik von Halluzinationen bei KI-Modellen entgegenzuwirken.

Darüber hinaus wird das Semantic Web heutzutage nicht mehr als monolithische Vision verfolgt, bei der der gesamte Webinhalt standardisiert annotiert wird. Stattdessen entstehen zunehmend domänenspezifische Knowledge Graphs und Ontologien, die ideal auf die jeweiligen Anforderungen einer Branche oder Organisation zugeschnitten sind. So hat sich die Erwartungshaltung gewandelt: Semantic Web Technologien werden pragmatisch dazu eingesetzt, AI-Anwendungen zu verbessern und validierbare Wissensbestände bereitzustellen, anstatt die gesamte Weltinformation in semantische Formate zu pressen. Auch in der Praxis gibt es bereits zahlreiche interessante Projekte, die semantische Webtechnologien mit KI verbinden. Ein Beispiel sind Forschungsarbeiten, die KI nutzen, um bestehende Ontologien zu erweitern oder automatisch aus großen Textbeständen semantische Daten zu generieren.

Ein solcher Vorgehensweise könnte effizienter sein, als für jede neue Domäne ein spezialisiertes KI-Modell zu trainieren. Stattdessen wird ein generalistisches Modell verwendet, um strukturierte, maschinenverständliche Daten zu erzeugen, welche dann gezielt für spezifische Anwendungen eingesetzt werden. Zudem setzen Unternehmen wie Palantir Ontologien als eine Art Kontrollmechanismus ein, um Halluzinationen von KI-Systemen zu reduzieren, indem die Antworten anhand definierter semantischer Regeln eingeschränkt werden. Dies zeigt, dass die Kombination aus KI und Semantic Web Technologien nicht nur möglich ist, sondern auch einen praktischen Mehrwert bietet. Auf technischer Ebene unterstützen Formate wie JSON-LD, OWL oder Datenbankabfragesprachen wie SPARQL die Darstellung und Nutzung semantischer Daten.

Die Verwendung solcher standardisierter Markups erleichtert die Interoperabilität und ermöglicht die Anwendung von KI in komplexen Wissensdomänen, in denen einfache Textverarbeitung an Grenzen stößt. Zusammenfassend lässt sich sagen, dass Künstliche Intelligenz und semantische Webtechnologien nicht in Konkurrenz stehen, sondern sich eher ergänzen. Während KI moderne Methoden bietet, um große unstrukturierte Datenbestände zu verarbeiten und menschliche Sprache zu verstehen, liefern semantische Technologien ein Gerüst zur Organisation und Verknüpfung von Wissen. Insbesondere in spezialisierten Anwendungsfällen oder bei der Gewährleistung von Datenqualität und Transparenz spielen semantische Strukturen weiterhin eine bedeutende Rolle. Die Herausforderung der Zukunft wird darin bestehen, die jeweiligen Stärken beider Technologien optimal zu verbinden.