Die Debatte, ob „KI“-Systeme echte Werkzeuge sind, gewinnt immer mehr an Relevanz, besonders in Zeiten, in denen der Begriff künstliche Intelligenz in nahezu jedem Bereich diskutiert wird. Von großen Tech-Firmen bis hin zu Fachkreisen und der breiten Öffentlichkeit wird häufig die Aussage getroffen, KI sei „nur ein Werkzeug“ – ein Objekt, das uns hilft, bestimmte Probleme zu lösen. Doch entspricht diese Vorstellung tatsächlich der Realität der heutigen KI-Systeme, oder steckt hinter diesem Anspruch mehr als nur eine bloße Vereinfachung? Zunächst einmal gilt es zu verstehen, was ein Werkzeug im klassischen Sinne eigentlich bedeutet. Ein Werkzeug ist nicht einfach irgendein Gegenstand, der zweckentfremdet verwendet wird. Es ist ein Objekt, das mit einer klaren Absicht, einem definierten Zweck und einem spezifischen Problem im Kopf gestaltet wurde.

Die Designsprache eines Werkzeugs etwa eines Schraubendrehers, einer Säge oder eines Hammers legt klar fest, wie das Werkzeug benutzt wird. Es kommuniziert seine Funktion durch Form, Gewicht, Material und Handhabung. Man kann sogar sagen, Werkzeuge konservieren Wissen – sie tragen in sich die Erfahrungen und Ideen zahlreicher Menschen, die dazu geführt haben, dass diese Lösung für ein bestimmtes Problem funktioniert. Ein Schraubendreher beispielsweise setzt voraus, dass man versteht, wie eine Schraube funktioniert und wie Kraft ausgeübt werden muss, um sie einzudrehen. Wenn man dieses Verständnis von Werkzeugen ansetzt, gerät die Bezeichnung von heutigen KI-Systemen, besonders generativen Modellen wie ChatGPT, ins Wanken.

Diese Systeme wurden nicht für ein eng umrissenes Problem oder einen klar definierten Zweck entworfen. Vielmehr folgen sie dem Prinzip der Vielseitigkeit, der Anpassungsfähigkeit und oft genug auch der Unschärfe. Sie sind eher ein „Spielplatz“ oder eine „Fundgrube“ für Möglichkeiten, ohne eine intrinsisch eindeutig vorgestellte Nutzung zu haben. Im Gegensatz zu einem Schraubendreher, der sofort eine zweckgerichtete Tätigkeit nahelegt, offenbaren LLMs (Large Language Models) durch ihr Interface und ihre Antworten eine enorme Offenheit, die nicht automatisch auf eine klare Problemlösung zielt. Das führt zu der Frage, ob man solche KI-Systeme als Werkzeuge bezeichnen kann, die uns tatsächlich bei konkreten Problemen unterstützen, oder ob sie eher improvisierte Hilfsmittel darstellen, die Nutzer selbst erst erproben, ausprobieren und zielgerichtet verwenden müssen, um wertvolle Ergebnisse zu erzielen.

In diesem Sinne spiegeln viele heutige KI-Erfahrungen eher das Bild eines „makeshift“-Werkzeugs wider, also eines provisorischen Hilfsmittels, das weder vollständig ausgeprägt noch optimal angepasst ist. Es gibt allerdings spezialisierte KI-Anwendungen, die unserer traditionellen Vorstellung von Werkzeugen näher kommen. So etwa visuelle Modelle, die explizit für Gesichtserkennung oder medizinische Diagnosen trainiert wurden. Hier liegt eine klare Zielsetzung und eine eindeutige Zuordnung der Funktion vor. In solchen Fällen ist die KI ein Hilfsmittel mit klar umrissener Aufgabe, in deren Design Fachwissen, Intentionen und Nutzungsmodelle eingebettet sind.

Solche Systeme erfüllen weit eher das Kriterium eines konventionellen Werkzeugs als allgemeine Chatbots, die für viele Anwendungsfälle offen, unspezifisch und oft auch unzuverlässig bleiben. Ein weiterer Aspekt, der bei der Werkzeuggattung entscheidend ist, ist die soziale Entstehung und Weiterentwicklung. Werkzeuge sind kein Produkt isolierter Entwicklung, sondern entstehen durch nachhaltigen sozialen Austausch innerhalb von Gemeinschaften. Sie sind das Ergebnis jahrhundertelanger Verbesserung, Teilhabe und Kritik – sie sind gewissermaßen das kollektive Gedächtnis und der Fortschritt einer Gesellschaft. Sie vermitteln nicht nur eine funktionale Lösung, sondern auch kulturelles Wissen, Praktiken und Normen.

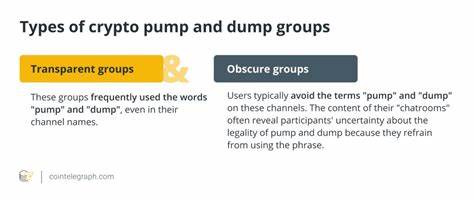

Aktuelle KI-Systeme hingegen sind häufig Produkte großer Technologieunternehmen, die hinter geschlossenen Türen mit hochkomplexen Modellen experimentieren. Diese Systeme wurden bisher kaum als soziale Werkzeuge entwickelt, die von Gemeinschaften auf transparente und iterative Weise mitgestaltet und verbessert werden. Stattdessen werden sie meist als Produkte vermarktet, die auf den Nutzer „losgelassen“ werden, ohne dass gesellschaftliche Lernprozesse umfassend eingebunden wären. Die Erwartung, dass Nutzerinnen und Nutzer sofort verstehen, wie sie solche KI-Systeme sicher, produktiv und verantwortungsvoll einsetzen sollen, ist daher mit Vorsicht zu betrachten. Die Systeme überfordern oft mit ihrer Vielseitigkeit und der nicht eindeutigen Zweckbestimmung.

Sie stellen vielmehr sogenannte leere Eingabefelder bereit, an denen man wenig Anleitung hat und die eigene Kreativität oder Problemlösekompetenz gefragt ist. Das ist eine ganz andere Rolle als die eines klassischen Werkzeugs, das seine Nutzbarkeit unmittelbar und eindeutig kommuniziert. Gleichzeitig birgt die Zuschreibung „es sind nur Werkzeuge“ auch eine ideologische Komponente. Sie suggeriert, dass der Einsatz von KI-Systemen per se neutral, harmlos oder sogar zwingend sinnvoll sei. Das aber unterschätzt die sozialen, ethischen und ökologischen Auswirkungen.

Manche Anwendungen von KI können gesellschaftliche Schäden verursachen – sei es durch Verzerrungen in Trainingsdaten, Umweltbelastungen durch hohe Energieverbräuche oder durch die Veränderung von Arbeitsprozessen und Machtverhältnissen. Die Forderung, KI-Systeme seien „nur Werkzeuge“, impliziert auch eine Verpflichtung oder Erwartung, diese Werkzeuge produktiv zu nutzen. Doch ist es angemessen, eine breite Nutzung solcher Systeme zu fordern, ohne deren Implikationen und Nebenwirkungen sorgfältig zu bedenken? Nicht jedes Werkzeug ist unproblematisch – manche Werkzeuge können auch selbstschädigend oder schädigend für die Gesellschaft sein. Dieses Bewusstsein geht über die bloße Bezeichnung als Werkzeug hinaus und verlangt eine differenzierte Betrachtung. Festzuhalten bleibt, dass es sinnvoll ist, den Begriff „Werkzeug“ weiter differenziert zu betrachten, besonders im Kontext von „KI“.

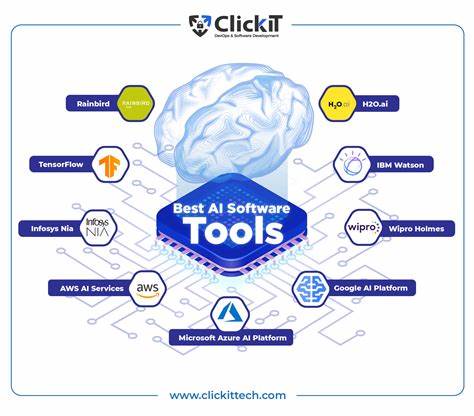

Werkzeuge zeichnen sich durch klare Intention, Kenntnisse, Gebrauchsanweisungen und eine eingängige Gestaltung aus. Viele heutige KI-Systeme erfüllen diese Kriterien nicht umfassend. Sie sind eher experimentelle Plattformen als fertige, gut designte Hilfsmittel. Dennoch kann man KI-Systeme als Werkzeuge bezeichnen, wenn man diesen Begriff im umgangssprachlichen Sinne versteht – als Mittel oder Instrumente, mit denen Menschen etwas erreichen wollen. Doch gerade weil sie mehr sind als nur neutrale Hilfsmittel, weil sie aktiv gesellschaftliche Prozesse beeinflussen und neue Fragestellungen aufwerfen, sollten wir uns bewusst sein, dass „einfach nur Werkzeuge“ eine unzureichende Beschreibung bleibt.

Schlussendlich müssten wir also den Diskurs über die Rolle von KI-Systemen vertiefen und über den Begriff „Werkzeug“ hinausdenken. Statt KI-Systeme als bloße Instrumente zu sehen, sollten wir ihre gesellschaftliche Dimension und die damit verbundenen Herausforderungen in den Fokus rücken. Nur so können wir verantwortungsvolles und kritisches Handeln im Umgang mit KI fördern und den Entwicklungen eine Richtung geben, die Mensch und Gesellschaft langfristig dienen. Die Zukunft der KI hängt nicht allein davon ab, wie ausgeklügelt die Algorithmen sind, sondern auch davon, wie wir diese Systeme in den sozialen und historischen Kontext einbetten, wie wir sie gestalten, nutzen und regulieren. Dabei lohnt es sich, Werkzeuge neu zu denken – nicht als starre Objekte mit vorgegebener Bedeutung, sondern als dynamische Praktiken, die gemeinsam mit den Menschen wachsen und sich weiterentwickeln.

KI-Systeme stehen noch am Anfang dieses Prozesses und es bleibt spannend zu beobachten, wie sich ihr Status und ihr Nutzen in den kommenden Jahren weiterentwickeln werden.

![Gemini Pretraining [slides] [pdf]](/images/72408054-40EA-4CCC-9160-DA57A8312094)