In der heutigen Welt verändert sich die Softwareentwicklung rasant durch den Einsatz von Künstlicher Intelligenz, insbesondere durch Large Language Models (LLMs) wie GPT. Entwickler nutzen diese mächtigen Werkzeuge, um Programmcode zu generieren, Probleme zu lösen oder kreative Ansätze zu finden. Doch im Kontext dieser neuen Arbeitsweise stellt sich eine entscheidende Frage: Wie viel Anerkennung und Verantwortung kann jemand für den Code beanspruchen, der durch ein LLM erstellt wurde? Diese Diskussion um Urheberschaft, ethische Praktiken und rechtliche Aspekte gewinnt zunehmend an Bedeutung, da die Technologie tief in den Entwicklungsprozess integriert wird. Zunächst ist es wichtig zu verstehen, was es bedeutet, Code mit einem LLM zu schreiben. Ein LLM erzeugt Code auf Basis von umfangreichen Trainingsdatensätzen und Eingaben, die von Menschen definiert werden, sogenannter Prompts.

Der Entwickler formuliert eine Aufgabenstellung oder beschreibt einen gewünschten Funktionsumfang, und das Modell liefert daraufhin passende Code-Snippets. Der Grad der beteiligten menschlichen Arbeitsleistung variiert dabei stark: Manchmal wird der Code fast unverändert übernommen, in anderen Fällen wird der Vorschlag nur als Grundlage genutzt und durch eigene Anpassungen erweitert oder komplett neu gedacht. Die Frage nach der Anerkennung sollte daher stets im Kontext von Verantwortung und Kontrolle betrachtet werden. Es ist üblich, dass Entwickler den gesamten Entwicklungszyklus verstehen, den Code testen, debuggen und soweit anpassen, dass er den Anforderungen entspricht. In solchen Fällen ist es nachvollziehbar, dass sie sich als „Autor“ oder „Schöpfer“ des Codes sehen.

Dennoch sollte man den Beitrag eines LLM nicht ignorieren, vor allem aus ethischen und rechtlichen Gründen. Ein zentraler Punkt in der Praxis ist das Thema Transparenz. Einige Experten empfehlen ausdrücklich, dass alle durch KI generierten Codebestandteile mit entsprechenden Quellenangaben oder Verweisen versehen werden sollten. Das entspricht dem Prinzip „work shown“ beziehungsweise „Quellenangabe“. Solche Angaben schaffen Nachvollziehbarkeit und verbessern die spätere Wartbarkeit und Auditierbarkeit, insbesondere in einem Team oder einer Unternehmensumgebung.

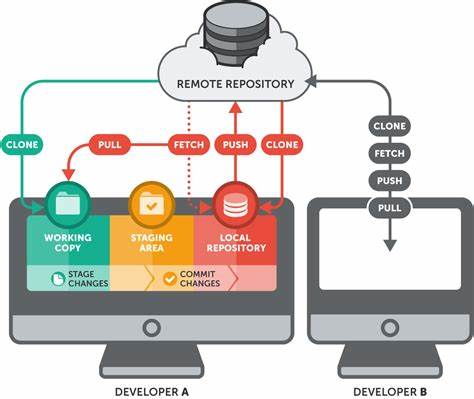

Beispielsweise kann es sinnvoll sein, in einem Commit-Text zu notieren, dass bestimmte Teile des Codes durch ein LLM erstellt oder unterstützt wurden, inklusive eventueller genutzter Prompts oder externer Quellen. Allerdings ist dies in der Praxis nicht immer einfach oder üblich. Viele Entwickler vergleichen die Verwendung von LLM-generiertem Code mit dem Kopieren von Snippets aus Online-Foren wie Stack Overflow oder Tutorials. In diesen Fällen wird der Code oft übernommen und bearbeitet, ohne ausdrücklich auf die Herkunft hinzuweisen. Dennoch gibt es Unterschiede: Während etwa ein Stack Overflow-Post meist eine konkrete Urheberquelle mit Lizenzinformationen bietet, sind die genauen Quellen der von LLMs erzeugten Inhalte oft schwer nachvollziehbar.

Das kann rechtliche Unsicherheiten verstärken, vor allem im Hinblick auf mögliche Urheberrechtsverletzungen oder Lizenzkonflikte. Rechtlich betrachtet sind LLMs derzeit keine juristischen Personen und verfügen auch nicht über eine eigene Urheberschaft an Code. Demnach liegt die Verantwortung für den resultierenden Code stets beim Nutzer. Dies bedeutet, dass Entwickler auch dann die Haftung übernehmen müssen, wenn der Code aus einem KI-gestützten Generator stammt. Fehler und Sicherheitslücken, die im generierten Code vorhanden sind, können demnach nicht einfach auf die KI abgewälzt werden.

Unternehmen müssen sich darüber bewusst sein, dass die Einbindung von KI in den Entwicklungsprozess auch eine Verpflichtung zu gründlicher Prüfung und Qualitätssicherung bedeutet. Aus Sicht der Innovationskultur verändert die Integration von LLMs den Begriff des „Autors“ oder „Schöpfers“ von Software grundlegend. Der Entwickler wird zunehmend zum Kurator und Leiter eines Prozesses, bei dem kreative Inputs von einer KI als Hilfsmittel genutzt werden, um schneller und effizienter Lösungen zu finden. Dieser neue Rollenbegriff anerkennt sowohl menschliches Urteilsvermögen als auch technologische Unterstützung. Viele mittlerweile bestehende Teams gehen ohnehin von der Annahme aus, dass jeder Entwickler moderne KI-Tools im Alltag einsetzt, ähnlich wie sie früher IDEs, Frameworks oder Code-Snippets nutzten.

Ein interessanter Aspekt ist auch der Umgang mit den Prompts, also den Eingaben, die das LLM steuern. Sollten diese ebenfalls dokumentiert und in der Versionskontrolle abgelegt werden? Manche Fachleute argumentieren, dass die Prompts, sofern sie reproduzierbar und essentiell für die Codegenerierung sind, als Teil des Entwicklungsprozesses transparent gemacht werden sollten. Das hat mehrere Vorteile: Es erleichtert die Nachverfolgung, ermöglicht eine bessere Fehleranalyse und erhöht die Nachvollziehbarkeit der Entscheidungen. Andererseits entstehen praktische Herausforderungen in Bezug auf Speicherplatz, Datenschutz und Unternehmensrichtlinien. Unternehmenspolitisch gesehen gibt es keine Einheitslösung.

Die Richtlinien hängen stark von der jeweiligen Unternehmenskultur und den rechtlichen Rahmenbedingungen des Landes ab. Manche Organisationen fördern offene Transparenz bezüglich KI-unterstütztem Coding, während andere versuchen, mögliche Haftungsrisiken durch restriktivere Vorgaben zu minimieren. Schwerwiegende Ereignisse wie Ausfälle oder Sicherheitslücken können Einfluss auf solche Policies haben und zu deutlich strikteren Prüfverfahren und Dokumentationspflichten führen. Der ethische Umgang mit KI-generiertem Code sollte auch die Frage nach geistigem Eigentum und Innovation berücksichtigen. Wenn ein Entwickler mehr Zeit und Ideen in die Gestaltung eines Prompts sowie in die Überprüfung und Erweiterung des generierten Codes investiert als in die eigentliche Programmierung, könnte man argumentieren, dass der kreative Input des Menschen maßgeblich ist.

Dennoch sollte man nicht vergessen, dass das Training und die Datenbasis des LLM von einer Vielzahl anderer Entwickler stammt, deren Arbeit indirekt in die erzeugten Snippets einfließt. Dies macht das Feld komplex und fordert neue Denkansätze im Bereich der Urheberrechtsgestaltung. Ein praktischer Umgangstipp für Entwickler ist daher, stets sorgfältig mit den Ergebnissen von LLMs umzugehen, weder blind zu vertrauen noch deren Beitrag zu unterschätzen. Das bedeutet, der generierte Code sollte umfassend geprüft, getestet und gegebenenfalls angepasst werden, bevor er produktiv eingesetzt wird. Gleichzeitig ist es ratsam, Dokumentationen, Kommentare sowie Commit-Nachrichten zu nutzen, um klar zu machen, welche Teile des Codes aus welchen Quellen stammen und wie sie erstellt wurden.

Die Entwicklercommunity auf Plattformen wie Hacker News hat eine lebhafte Debatte darüber geführt, wie Anerkennung und Verantwortung für LLM-generierten Code verteilt werden sollten. Die Meinungen reichen von uneingeschränkter Anerkennung als Eigentum des Entwicklers, der den Prozess steuert und finalisiert, bis hin zu der Forderung nach umfassender Transparenz und Kennzeichnung von KI-Einsatz. Insbesondere bei Teamarbeit und größeren Projekten gewinnt die Nachvollziehbarkeit an Bedeutung, um mögliche Rechtsstreitigkeiten oder Haftungsprobleme zu vermeiden. Zusammenfassend lässt sich sagen, dass die Fragen rund um Urheberschaft, Credit und Haftung bei der Nutzung von LLMs in der Softwareentwicklung noch nicht abschließend geklärt sind. Sie erfordern ein Bewusstsein für technische, rechtliche und ethische Aspekte gleichermaßen.

Entwickler und Unternehmen sollten den Einsatz von KI-Tools nicht nur als technische Bereicherung sehen, sondern zugleich eine verantwortungsvolle Nutzung fördern, die Transparenz, Prüfungen und gegebenenfalls Quellenangaben beinhaltet. Nur so kann eine nachhaltige und rechtssichere Integration von KI in die Praxis gelingen und das volle Potenzial dieser Technologie erschlossen werden.