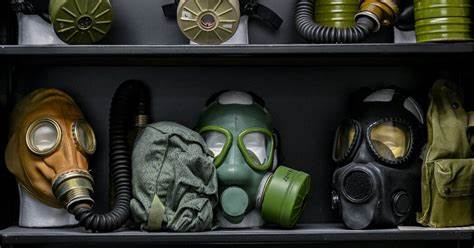

Künstliche Intelligenz (KI) hat in den letzten Jahren enorme Fortschritte gemacht und wird mittlerweile in zahlreichen Bereichen eingesetzt, darunter auch in der biomedizinischen Forschung. Besonders bemerkenswert ist ihre Fähigkeit, neue Proteine zu entwerfen, die als Medikamente, Impfstoffe oder andere therapeutische Mittel dienen können. Diese Entwicklung verspricht gewaltige Fortschritte in der Medizin und Wissenschaft. Doch mit diesem Potenzial gehen auch erhebliche Risiken einher, vor allem die Sorge, dass dieselben KI-Tools zur Konstruktion von biologischen Waffen oder schädlichen Toxinen missbraucht werden könnten. Um dem entgegenzuwirken, schlagen Forscher innovative Schutzmaßnahmen vor, die direkt in die Algorithmen von KI-Systemen integriert werden könnten, um Missbrauch zu erschweren und eine Nachverfolgung potenzieller Gefahrenquellen zu ermöglichen.

Der Einsatz von KI in der Proteinforschung ermöglicht es, in kaum vorstellbar kurzer Zeit neue Proteinketten zu generieren, die sich zuvor kein Wissenschaftler hätte ausdenken können. Modelle wie RFdiffusion und ProGen sind in der Lage, innerhalb von Sekunden völlig neuartige Proteine zu entwerfen – eine Leistung, die die wissenschaftliche Forschung beschleunigt. Allerdings macht gerade diese Leichtigkeit es einfacher für Einzelpersonen ohne spezifische Fachkenntnisse, potenziell gefährliche Moleküle zu erzeugen. Das Risiko, dass sich Personen ohne akademische oder professionelle Ausbildung Zugang zu solchen Technologien verschaffen und sie für böswillige Zwecke nutzen, wächst mit der Verbreitung und Zugänglichkeit der KI-Tools. Forscherinnen und Forscher gehen deshalb über freiwillige Selbstverpflichtungen hinaus.

Ein neues Konzept stellt die Entwicklung verschiedener Arten von eingebauten Schutzmechanismen in die KI-Modelle selbst in den Vordergrund. Eines dieser Werkzeuge ist FoldMark, das auf einer ähnlichen Technik beruht wie Google DeepMind’s SynthID. Dabei handelt es sich um eine Methode, bei der digitale Signaturen in die erzeugten Proteine „eingebettet“ werden. Diese Signaturen verändern weder die Struktur noch die Funktion des Proteins, dienen jedoch als eine Art Fingerabdruck. Sollte ein neuartiges toxisches Protein entdeckt werden, könnten Forscher diesen „Fingerabdruck“ auslesen, um den Ursprung und die Verantwortlichen zurückzuverfolgen.

Dieses Vorgehen könnte die lückenlose Überwachung und Nachverfolgung von möglichen Biowaffen erleichtern und somit eine abschreckende Wirkung entfalten. Ein weiterer Ansatz beschäftigt sich mit dem sogenannten „Unlearning“. Dabei werden die KI-Modelle darauf trainiert, bestimmte gefährliche Proteine und toxische Moleküle aus ihrer Datenbasis „vergessen“ zu lassen. Proteindesign-Algorithmen werden normalerweise auf umfangreichen Datensätzen trainiert, die auch toxische oder pathogene Proteine enthalten. Durch gezieltes Entfernen dieser Subsets in der KI-Ausbildung soll verhindert werden, dass das Modell Vorschläge für gefährliche Moleküle generiert.

Dieser methodische Verzicht auf bestimmte Trainingsmaterialien trägt dazu bei, die Gefahr der unbeabsichtigten Erzeugung schädlicher Designs zu minimieren. Zusätzlich setzen Wissenschaftler auf „Antijailbreaking“-Techniken, bei denen KI-Modelle so trainiert werden, dass sie bestimmte Anfragen mit potenziell bösartiger Absicht erkennen und ablehnen. Dieses Konzept ähnelt Sicherheitsmechanismen, die bei Sprachmodellen angewandt werden, um missbräuchliche Prompts zu erkennen und zu blockieren. Die Herausforderung liegt dabei darin, die KI so flexibel und gleichzeitig sicher zu gestalten, dass harmlose Forschung nicht behindert wird, aber der Missbrauch erschwert wird. Neben der direkten Anpassung der KI-Modelle wird auch vorgeschlagen, externe Kontrollmechanismen zu etablieren.

Autonome Überwachungsagenten könnten den Gebrauch der KI-Systeme rund um die Uhr analysieren und im Falle verdächtiger Aktivitäten Sicherheitsbeauftragte alarmieren. Eine solche Kombination aus automatischer Überwachung und menschlicher Kontrolle könnte helfen, Risiko-Vorfälle frühzeitig zu erkennen und zu verhindern. Die Implementierung solcher Sicherheitsmaßnahmen ist jedoch kein triviales Unterfangen. Es bedarf einer koordinierten internationalen Zusammenarbeit, um sinnvolle Regulierungen einzuführen. Denkbar wären Regulierungsbehörden, die entweder die KI-Modelle selbst zertifizieren oder deren Nutzung überwachen.

Auch eine Fokussierung auf Produktionsstätten, die aus den von KI entworfenen Proteinen maßstabsgerechte Mengen herstellen können, wird diskutiert. Diese Einrichtungen könnten überprüft werden, indem Herkunftsnachweise verlangt und Tests auf toxische Eigenschaften durchgeführt werden. So würde der Übergang von digitaler Simulation in die physische Welt kontrolliert und unterbunden, bevor gefährliche Stoffe entstehen. Einige Experten betonen zudem, dass zwar die Modelle mächtig sind, es aber bislang keine eindeutigen Belege dafür gibt, dass sie heute bereits in der Lage sind, neue gefährliche Viren oder Biowaffen zu entwerfen, die eine globale Pandemie auslösen könnten. Die Gefahr bleibe theoretisch, aber das Bewusstsein dafür sollte die Forschung nicht behindern, sondern zu verantwortungsvoller Nutzung und Weiterentwicklung der Schutzmechanismen motivieren.

Das Thema KI und Biotechnologie hat in der wissenschaftlichen Community bislang noch nicht die gleiche Aufmerksamkeit erhalten wie etwa KI-bezogene Probleme in den Bereichen Desinformation, Deepfakes oder Datenschutz. Daher ist das wachsende Interesse an Sicherheitsfragen in der KI-gestützten Proteinforschung ein wichtiger Schritt, um frühzeitig Risiken einzudämmen und gleichzeitig das positive Potenzial dieser Technologie zu fördern. Auch ethische Fragen und der gesellschaftliche Diskurs müssen einbezogen werden, um technologische Entwicklungen nachhaltig und sicher zu gestalten. Insgesamt zeigt sich, dass das Aufbauen von integrierten Schutzmechanismen in KI-Systemen nicht nur eine technische Herausforderung ist, sondern auch Governance, Transparenz und internationale Kollaboration benötigt. KI wird weiterhin eine Schlüsselrolle bei der Entwicklung neuer gesundheitlicher Lösungen spielen.

Doch deren Fortschritt muss Hand in Hand gehen mit einem verantwortungsvollen Umgang und entsprechenden Vorkehrungen, die Missbrauch verhindern. Fortschritte wie FoldMark und Konzepte wie Unlearning und Antijailbreaking könnten hierbei entscheidende Bausteine bilden, um eine sichere Nutzung von KI in der Biotechnologie zu gewährleisten und so den Weg für eine innovative, aber kontrollierte Zukunft der Medizin und Wissenschaft zu ebnen.