CSV-Dateien gehören seit Jahrzehnten zu den gängigen Formaten für den Datenaustausch in Unternehmen und sind allgegenwärtig in Datenpipelines und Analysen. Gerade für Data Engineers stellen sie oft jedoch eine Dauerbaustelle dar – scheinbar einfache Dateien erweisen sich als wahre Tücken mit inkonsistenten Delimitern, unregelmäßigen Anführungszeichen oder wechselnden Spalten. Viele kennen das frustrierende Szenario: Beim Laden mit einem Tool oder SQL-System schlägt der Import fehl wegen nicht konformer Daten, heterogener Formate oder fehlender Werte. DuckDB, die moderne in-proc Analytics-Datenbank, bringt mit seinen spezialisierten CSV-Techniken Licht ins Dunkel und bietet einen sanften, aber kraftvollen Weg, um vermeintlich wilde CSVs zu zähmen und problemlos zu verarbeiten. Im Folgenden entdecken Data Engineers, wie sie ihre Datenimporte mit DuckDB effizienter gestalten, Fehlerquellen frühzeitig erkennen und umgehen, verschiedene CSV-Varianten harmonisieren und so Zeit- sowie Ressourcen sparen können.

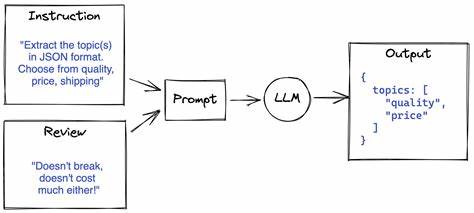

Wer lernt, DuckDBs Fähigkeiten richtig zu nutzen, vermeidet die altbekannten Scripte zur Datenbereinigung und bringt saubere Prozesse ins Dorf der wilden CSVs. Der erste Schritt auf dem Weg zur souveränen CSV-Beherrschung ist ein genauer Blick hinter die Kulissen. DuckDB bringt mit der Funktion sniff_csv ein mächtiges Werkzeug mit, das vor dem eigentlichen Import Hinweise darüber gibt, wie die CSV-Datei tatsächlich strukturiert ist. Dies ist eine Art Späher, der die Datei anhand einer Stichprobe analysiert und Auskunft über das verwendete Trennzeichen, Anführungszeichen, Fluchtzeichen, Zeilenumbrüche und natürlich die erkannten Spaltennamen sowie deren vermutete Datentypen gibt. So lässt sich frühzeitig erkennen, ob die automatische Erkennung von DuckDB korrekt arbeitet oder ob man gezielt Optionen überschreiben muss, um Fehler zu vermeiden.

Anstatt blind eine read_csv-Funktion aufzurufen und auf Fehler zu stoßen, erlaubt sniff_csv den Data Engineers, die Datei proaktiv zu verstehen. Dabei kann außerdem die Stichprobengröße flexibel angepasst werden, etwa um kleine Dateien komplett zu prüfen oder nur einen repräsentativen Ausschnitt für große Datenbestände zu analysieren. Die Stärke des Sniffers liegt in mehreren Erkennungsstufen. Anfangs testet er eine Reihe möglicher Dialekt-Kombinationen – also verschiedene Trennzeichen, Anführungszeichen und Escape-Zeichen – und bewertet, welche diese eine möglichst konstante Anzahl von Spalten über die Zeilen aufweist. Anschließend überprüft er die Typen der einzelnen Spalten anhand definierter Reihenfolgen wie NULL, BOOLEAN, INTEGER, DOUBLE bis hin zu TEXT.

Zusätzlich findet eine Erkennung statt, ob eine Datei eine Kopfzeile enthält oder nicht. Diese mehrstufige Auswertung liefert eine fundierte Grundlage, um zu entscheiden, wie das CSV idealerweise eingelesen wird. Für Data Engineers ist wichtig zu wissen, dass man auch eigene Typenangaben sogar in der Erkennung überschreiben kann, um spezifische Anforderungen abzubilden. Mit diesen Kenntnissen ausgestattet, lässt sich der CSV-Import zielgerichtet konfigurieren, was einen erheblichen Mehrwert gegenüber standardisierten Import-Methoden bringt. Doch auch wenn man genau weiß, wie die Datei aufgebaut ist, läuft der Umgang mit problematischen Daten meist nicht ganz ohne Stolperfallen ab.

In der Praxis kommt es häufig vor, dass einzelne Zeilen durch fehlerhafte Werte, Tippfehler oder unvollständige Einträge eine ganze Datenverarbeitung zum Erliegen bringen. DuckDB hilft hier mit mehreren cleveren Mechanismen. So kann mittels ignore_errors gesteuert werden, dass fehlerhafte Zeilen einfach übersprungen werden und nur die sauberen Daten übernommen werden. Damit wird der Import robuster und der Data Engineer verliert nicht den Überblick bei großen Datenmengen, in denen viele Daten korrekt sind – ein ganz entscheidender Vorteil für produktive Workflows. Für viele Anwendungsfälle reicht das reine Überspringen nicht aus, weil man später noch wissen möchte, welche Datensätze Probleme machen und wie genau diese Fehler aussehen.

Hier kommt die Option store_rejects ins Spiel. Sie speichert die abgelehnten Zeilen mitsamt Fehlerinformationen in speziellen temporären Tabellen, die innerhalb von DuckDB einsehbar sind. Data Engineers erhalten so eine transparente Übersicht über defekte Daten, können deren Ursachen analysieren und bei Bedarf gezielte Korrekturen vornehmen – alles im selben System ohne den Umweg über zusätzliche Tools oder Skripte. Diese Kombination aus Fehlerignorieren mit begleitender Fehlerprotokollierung ist ein mächtiges Konzept, das die Datenqualität in Echtzeit verbessert und die Datenpipeline resilienter macht. Ist die CSV-Datei besonders „wild“ und enthält beispielsweise unerwartet viele Spalten mehr oder weniger, unescaped Anführungszeichen oder diverse Zeilenumbruch-Formate, erlaubt DuckDB mit weiteren Parametern eine noch großzügigere Fehlerverzeihung.

strict_mode = false entspannt die Prüfung des Dateiformats und akzeptiert auch nicht konforme Zeichenfolgen, während null_padding fehlende Werte einfach mit NULL auffüllt. So lässt sich bestmöglich auch aus schiefen oder inkonsistenten CSVs ein vollständiger Datenimport erstellen und im Anschluss gezielt bereinigen. Dieses pragmatische Vorgehen kann gerade bei Quellendaten mit unterschiedlicher Herkunft und Qualität helfen, ohne den gesamten Workflow durch Kleinigkeiten zu blockieren. Neben dem Umgang mit Fehlern sind variierende Schemata eine häufige Hürde. Gerade bei der Verarbeitung vieler CSV-Dateien, etwa monatlicher Berichte, zeigen sich häufig kleine Abweichungen: Spalten werden hinzugefügt, entfernt oder anders angeordnet.

Die einfache Kombination dieser Dateien scheitert schnell an festgelegten Schemas oder Reihenfolgen. DuckDB meistert dieses Henne-Ei-Problem elegant durch die Option union_by_name. Dabei liest DuckDB die CSV-Dateien nicht stur spaltenweise nach Position ein, sondern ordnet die Daten anhand der Spaltenüberschriften zusammen. Fehlende Spalten in einzelnen Dateien werden mit NULL aufgefüllt. So entsteht ein harmonisiertes Gesamtbild über mehrere Dateien hinweg, das zuverlässig integrierbar ist und Nachbearbeitung wesentlich vereinfacht.

Für Data Engineers ist diese Funktion besonders wertvoll, um heterogene Quellen zu verarbeiten, ohne mühsam manuell Schema-Mappings pflegen zu müssen. Die automatische Erkennung der Spaltenformate funktioniert meist schon sehr gut, doch es gibt Situationen, bei denen der Typ nicht optimal ermittelt wird. Beispielsweise wird eine Spalte mit überwiegend ganzzahligen Werten gemeinhin als INTEGER erkannt. Enthält die Spalte später aber Fließkommazahlen, kann dies zu Fehlern führen oder zu ungewollter Typkonvertierung. Um dem vorzubeugen, bietet DuckDB etliche Möglichkeiten zur Feineinstellung.

Man kann etwa die Probengröße erhöhen, um mehr Zeilen für die Typbestimmung einzubeziehen und dadurch ausreißerbedingte Fehlbewertungen zu reduzieren. Alternativ lassen sich spezifische Spalten mit vordefinierten Datentypen versehen oder die Kopfzeile explizit ein- bzw. ausschalten. Ebenfalls möglich sind Einstellungen zur Formatierung von Datums- und Zeitspalten, so dass selbst nicht standardkonforme Formate sauber erkannt werden können. Darüber hinaus unterstützt DuckDB weitere praktische Einstellungen wie all_varchar, um alle Spalten zunächst als Text einzulesen und die Typkonvertierung später durchzuführen oder force_not_null, um bestimmte Felder trotz Leereinträgen als nicht NULL zu interpretieren.

Namen von Spalten lassen sich automatisch normalisieren, etwa indem Leerzeichen oder Sonderzeichen durch Unterstriche ersetzt werden, was zu saubereren und konformen Spaltenbezeichnungen führt. Diese Fülle an flexiblen Parametern gibt Data Engineers volle Kontrolle über den Datenimport und vereinfacht auch die Integration unterschiedlicher Datenquellen. Ein spannendes Highlight auf dem Gebiet der CSV-Verarbeitung ist der Pollock-Benchmark, der die Robustheit von CSV-Parsern anhand von echten, äußerst vielfältigen und fehlerbehafteten Dateien misst. Dabei erreichte DuckDB unter konfigurierten Umständen mit einem Leseerfolg von über 99 % den Spitzenplatz. Selbst im standardmäßigen Auto-Erkennungsmodus wurden mehr als 90 % der Daten fehlerfrei eingelesen.

Dieses beeindruckende Ergebnis bestätigt DuckDBs Anspruch, selbst in anspruchsvollen Szenarien das Werkzeug der ersten Wahl zu sein. Für Data Engineers bedeutet dies weniger Frust bei der Datenvorbereitung und mehr Fokus auf wertschöpfende Tätigkeiten. Die Kombination aller vorgestellten Techniken ermöglicht eine datenzentrierte und automatisierte CSV-Verarbeitung, bei der kaum noch manuelle Vorbereitungs- oder Bereinigungsschritte erforderlich sind. DuckDBs SQL-basierte Schnittstelle erlaubt die Verankerung der Datenaufbereitung in bestehenden ETL- oder ELT-Prozessen und eröffnet neue Möglichkeiten zur flexiblen Datenintegration mit geringstem Overhead. Gerade Teams, die mit wechselnden CSV-Datenquellen umgehen müssen, finden hier eine nachhaltige Lösung, um den weißem Rauschen zu begegnen.

Wer die hier vorgestellten Methoden und Optionen beherrscht, arbeitet nicht nur effizienter, sondern verbessert auch die Stabilität der gesamten Data Pipeline. DuckDB wird in der Folge nicht lediglich zum simplen CSV-Loader, sondern entwickelt sich zum zuverlässigen Partner, der die unvorhersehbaren Herausforderungen realer Datenwelten mit Gelassenheit und Präzision meistert. In einer Welt, in der Datenqualität und verlässliche Analysen ständig an Bedeutung gewinnen, ebnet die sichere Handhabung von wilder CSV-Daten den Grundstein für Erfolg in jedem datengetriebenen Unternehmen. Abschließend lässt sich sagen: Das Zähmen wilder CSV-Dateien ist für Data Engineers keine allzu große Hürde mehr, wenn sie DuckDBs ausgefeilte und dennoch intuitive Techniken nutzen. Durch vorausschauende Erkennung, flexible Fehlerbehandlung, Schema-Harmonisierung und zahlreiche Feinjustierungen lässt sich der Datenimport nahezu mühelos gestalten.

So kehrt die Freude zurück, wenn die CSV-Datei spurlos in eine saubere, nutzbare Datenbasis übergeht – und die Nacht am Bildschirm einem produktiven Arbeitstag weicht.