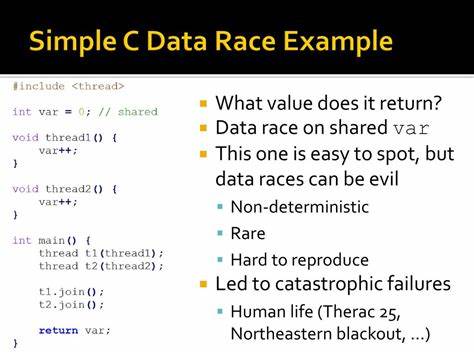

Datenrennen stellen eine der komplexesten Herausforderungen in der parallelen und nebenläufigen Programmierung dar. Besonders in C-Programmen, die häufig in sicherheitskritischen Systemen eingesetzt werden, können unerkannte Datenrennen zu schwerwiegenden Fehlern führen, die sowohl die Funktionsfähigkeit als auch die Sicherheit der Software gefährden. Die Frage, ob eine zuverlässige, also sound und automatisierte statische Verifikation von Datenrennen für reale C-Programme möglich ist, gewinnt in der Forschung und Praxis zunehmend an Bedeutung. Eine aktuelle Untersuchung, präsentiert auf der renommierten PLDI 2025 Konferenz, widmet sich exakt diesem Thema, um den Status quo und die verbleibenden Hindernisse bei der statischen Datenrennen-Überprüfung zu erforschen. Statische Datenrennen-Analyse bedeutet, dass das Programm vor seiner Ausführung untersucht wird, um potenzielle konkurrierende Zugriffe auf gemeinsame Speicherbereiche insbesondere ohne geeignete Synchronisationen zu erkennen.

Dieser Ansatz verspricht eine frühzeitige Fehlererkennung auf Quellcodeebene, was für große Softwareprojekte von erheblichem Vorteil sein kann. Dennoch ist die Realisierung einer sound, also fehlerfrei-überprüfenden Analyse schon seit Langem eine große Herausforderung. Während vor einem Jahrzehnt das Forschungsinteresse groß war, haben sich viele praktische Werkzeuge von der Soundness verabschiedet, um bessere Skalierbarkeit und Benutzerfreundlichkeit zu erzielen. Die Autoren der Studie haben eine Reihe von realweltlichen C-Programmen analysiert und dabei typische Programmiermuster extrahiert, die als fundamentale Barrieren für automatische Verifikationsmethoden gelten. Diese sogenannten Coding Idioms wurden zu Mikrobenschmarks weiterentwickelt und im Rahmen des internationalen Verifikationswettbewerbes SV-COMP als Bewertungstasks eingereicht.

Die Ergebnisse zeigen, dass für einen Teil dieser Idiome tatsächlich automatisierte, sounde Verifikatoren existieren, die korrekte Analysen liefern können. Doch acht von zwanzig untersuchten Idiomen konnten von mindestens einem der Werkzeuge korrekt verifiziert werden – das lässt hoffen. Gleichzeitig enthüllte die Studie große Unsicherheiten und Fehler in führenden Verifikationswerkzeugen wie Goblint und Deagle, die durchaus weit verbreitet in der Forschung genutzt werden. Vor allem bei den realen Programmen sieht die Situation noch problematischer aus: Die Mehrheit der dabei getesteten Werkzeuge konnte innerhalb der festgelegten Ressourcen keine aussagekräftigen Ergebnisse liefern. Einige scheiterten sogar daran, überhaupt eine Analyse abzuschließen.

Nur zwei der sieben getesteten Tools konnten auf zwei der achtzehn realen Programmbeispiele Datenrennenfreiheit verifizieren – doch auch hier gab es Abstürze oder unklare Resultate bei den anderen Fällen. Diese Ergebnisse verdeutlichen, dass die aktuellen state-of-the-art Verifikatoren an sowohl oberflächlichen als auch tieferliegenden Problemen leiden. Dabei reichen einfache technische Verbesserungen allein nicht aus, um echte Fortschritte zu erzielen. Vielmehr müssen die fundamentalen Hindernisse, die sich durch dynamische Datenstrukturen, komplexe Speicherzugriffsmuster und die Vielfalt von Synchronisationsmechanismen ergeben, adressiert werden. Die Arbeit unterstreicht damit wichtige Forschungsfragen: Wie können statische Analysen robuster gestaltet werden, um mit den anspruchsvollen Programmierparadigmen der C-Welt Schritt zu halten? Welche neuen theoretischen Ansätze sind nötig, um Soundness nicht zum Nachteil der Praktikabilität aufzugeben? Und wie können Werkzeuge verbessert werden, um in realen Entwicklungsumgebungen zuverlässig und ressourceneffizient eingesetzt zu werden? Aus Sicht der Softwareentwicklung und Qualitätssicherung ist das Erreichen einer verlässlichen statischen Datenrennen-Überprüfung in C ein wichtiger Schritt, um schwer detektierbare Nebenläufigkeitsfehler früh zu erkennen und zu beseitigen.

Die Vermeidung solcher Fehler verbessert nicht nur die Stabilität, sondern auch die Sicherheit bei Multiplayer-Systemen, Betriebssystemerneuerung oder Embedded-Anwendungen. Unter Gesichtspunkten der Programmiersprachenforschung trägt diese Herausforderung dazu bei, die Grenzen automatischer Verifikation auszuloten und neu zu definieren. Vorangegangene Versuche, Soundness und Praktikabilität zu vereinbaren, haben mit endlichen Ressourcen oft Kompromisse erfordert, die die Zuverlässigkeit beeinträchtigen. Neue Konzepte wie feingranulare Modellierung von Synchronisationen, adaptive Analysealgorithmen oder verbesserte Heuristiken könnten daher künftig eine Rolle spielen. Die Veröffentlichung auf der PLDI 2025 Konferenz – einer der wichtigsten Veranstaltungen für Programmierwerkzeuge und Programmanalyse – betont die Relevanz und Aktualität dieses Forschungsthemas.

Besonders bemerkenswert ist, dass die Studienautoren neben der theoretischen Untersuchung auch praktische Werkzeuge und Benchmark-Sets beigesteuert haben, die Entwicklern und Wissenschaftlern als Basis für weitere Arbeiten dienen können. Das offene Verfügbarmachen dieser Benchmark-Mikroprogramme fördert zugleich die Transparenz und Vergleichbarkeit aktueller und zukünftiger Verifikatoren. Zusammenfassend lässt sich feststellen, dass das Thema statische, sounde Datenrennen-Überprüfung für C keineswegs „verloren“ ist, sondern vielmehr eine anspruchsvolle und lohnende Forschungsaufgabe bleibt, die große Fortschritte ermöglicht – wenn auch mit signifikanten Herausforderungen. Die Kombination aus Realitätsnähe der Benchmarks und kritischer Analyse aktueller Tools bildet eine wichtige Grundlage, um gezielter an den Schwachstellen zu arbeiten. Die mit den Ergebnissen verbundenen Erkenntnisse können Programmierern helfen, die Grenzen heutiger Analysewerkzeuge besser einzuschätzen und entsprechend konservativ bei paralleler Programmierung vorzugehen.

Gleichzeitig eröffnen sie neue Forschungsfelder, um innovative Ansätze zur Datenrennen-Verifikation zu entwickeln, die Soundness und Skalierbarkeit vereinen. Die Bedeutung dieser Arbeit liegt auch darin, dass sie die gesamte Community dazu aufruft, bewährte Verfahren im Umgang mit Nebenläufigkeit zu überdenken und robuste Werkzeugketten zu fördern, die beim Entwickeln von Software für sicherheitskritische und hochperformante Systeme unerlässlich sind. Nur durch konsequente Weiterentwicklung von theoretischem Fundament und praktischen Analyseverfahren wird es möglich sein, die „Rennen“ um zuverlässige Datenrennenüberprüfung langfristig zu gewinnen und so sichere, stabile Software im Zeitalter nebenläufiger Systeme sicherzustellen.