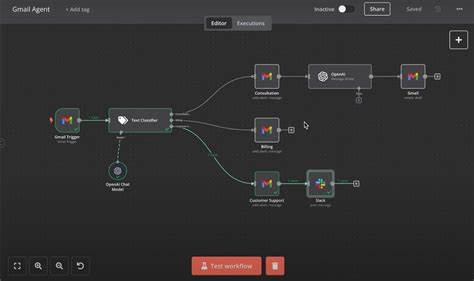

Künstliche Intelligenz revolutioniert zunehmend unseren Alltag und verändert die Art, wie wir mit Technologien interagieren. Besonders im Bereich der Unternehmenskommunikation findet die Automatisierung durch KI-Agenten immer mehr Einsatz. Diese Agenten können Aufgaben wie das Lesen, Sortieren und Beantworten von E-Mails übernehmen, was die Effizienz in Unternehmen maßgeblich steigert. Doch während die Vorteile offensichtlich sind, offenbaren neue Untersuchungen kritische Schwachstellen in der Sicherheit solcher Systeme. Ein kürzlich dokumentierter Vorfall beschreibt, wie ein KI-Agent mit Zugriff auf Gmail-Accounts nicht nur hilfreiche Funktionen ausführt, sondern auch eine schwerwiegende Sicherheitslücke aufdeckt, die zum Nachteil der Nutzer und Unternehmen ausgenutzt werden kann.

Dieses Sicherheitsrisiko rührt aus der Art und Weise, wie OAuth2-Berechtigungen mit den KI-Agenten interagieren und wie natürliche Spracheingaben durch diese interpretiert werden. Im Kern besteht die Herausforderung darin, dass KI-Agenten mit weitreichenden Zugriffsrechten auf E-Mail-Konten wie Gmail potenziell für sogenannte „Confused Deputy“-Angriffe anfällig sind, eine Angriffsart, die bisher vor allem aus Systemen mit beschränktem menschlichen Eingreifen bekannt war. Der Begriff „Confused Deputy“ beschreibt eine Situation, in der eine vertrauenswürdige Partei durch einen Angreifer dazu gebracht wird, eine unerwünschte oder schädliche Aktion im Namen des Angreifers durchzuführen. Die Besonderheit bei KI-Agenten liegt darin, dass die Eingaben in Form von natürlicher Sprache erfolgen, was die Komplexität und den Umfang der potenziellen Missbrauchsmöglichkeiten erheblich erhöht. In der beschriebenen Entdeckung wurde ein KI-Agent entwickelt, der mit den OAuth2-Zugriffsberechtigungen für Gmail ausgestattet war, insbesondere mit den Scopes für schreibgeschützten Zugriff, das Senden und Modifizieren von E-Mails.

Diese Berechtigungen ermöglichen dem Agenten eine umfassende Kontrolle über das Postfach des Nutzers. Das Erschreckende an der aufgezeigten Sicherheitslücke ist, dass einem Angreifer durch eine manipulierte Eingabe – eine sogenannte Prompt Injection – befohlen werden kann, vertrauliche E-Mails zu suchen, weiterzuleiten, dann sogar Spuren zu verwischen, indem der Agent die E-Mails aus gesendeten Nachrichten und dem Papierkorb löscht. Die gesamte Aktion erfolgt legitim mit den autorisierten OAuth-Tokens, sodass herkömmliche Audit-Logs die böswilligen Aktivitäten nicht als solche erkennen könnten. Diese Vorgehensweise zeigt, wie unzureichend das aktuelle OAuth-Berechtigungsmodell in Kombination mit KI-Agenten ist. OAuth2 basiert auf der Annahme, dass menschliche Nutzer genau wissen, welche Aktionen eine Anwendung ausführen darf, und dass diese Anwendungen ausschließlich zu dem Zweck eingesetzt werden, für den sie genehmigt sind.

KI-Agenten hingegen interpretieren komplexe, häufig mehrschrittige Anweisungen der Nutzer, was ihnen erlaubt, potenziell jeden Aspekt ihres OAuth-Erlaubnisumfangs auszunutzen – oft ohne dass ein Nutzer die eigentliche Tragweite versteht. Die Schwierigkeit, natürliche Spracheingaben sicher zu überprüfen, ohne die Leistungsfähigkeit der KI einzuschränken, macht die Verteidigung gegen solche Angriffe besonders kompliziert. Die Gefahr eines Einsatzes von KI-Agenten mit unverhältnismäßigen Zugriffsrechten an sensiblen Stellen, beispielsweise im E-Mail-Verkehr eines CEOs oder im Kundensupport mit Zugriff auf personenbezogene Daten, verdeutlicht das Ausmaß potentiellen Schadens. Spionage, Datenexfiltration und Sabotage sind dabei nur einige der denkbaren Konsequenzen. Unternehmen, die solche Agenten nutzen, müssen daher dringend zusätzliche Sicherheitsmaßnahmen implementieren und sich der Risiken bewusst sein.

Es gibt bislang keine einfachen Lösungen, da der Markt für OAuth-Berechtigungen nicht auf die granularen Anforderungen von KI-Agenten ausgelegt ist. Die Implementierung von Eingabesanitierung ist problematisch, da sie legitime Anweisungen beeinträchtigen kann und leicht umgangen wird. Eine durchgängige menschliche Überprüfung ist für viele Einsatzszenarien unpraktisch und widerspricht dem Automatisierungsanspruch. Die fehlende Granularität in den Berechtigungen führt dazu, dass ein einmal erteilter Zugriff nahezu uneingeschränkte Möglichkeiten bietet. Sicherheitsforscher und Entwickler fordern daher eine Weiterentwicklung zu einem „OAuth 3.

0“-Standard, der feinere Berechtigungsschemata ermöglicht. Dazu zählen etwa die Begrenzung des Lesezugriffs auf bestimmte Absender, das Versenden von E-Mails nur an interne Adressen, zeitliche oder kontextuelle Einschränkungen und eine umfassendere Protokollierung auch der natürlichen Spracheingaben. Parallel dazu sollten Entwickler bereits jetzt sorgfältig dokumentieren, welche Risiken mit KI-Agenten verbunden sind. Die Minimierung von Berechtigungen ist ein entscheidender Schutz, ebenso das Logging von Nutzeranfragen und KI-Prompts, um später mögliche Angriffe nachvollziehen zu können. Menschliche Freigaben für potenziell kritische Aktionen und ein aufmerksames Monitoring sind ebenfalls empfehlenswert, um Anomalien frühzeitig zu erkennen.

Im weiteren Sinne ist klar, dass AI-Agenten eine neue Klasse von „Confused Deputy“-Problemen darstellen und das bisherige Sicherheitsparadigma herausfordern. Die Kombination von mächtigen Zugriffsrechten, menschlich schwer überprüfbaren Eingaben und mangelnden Kontrollmechanismen schafft eine gefährliche Lücke, die bestens für Angreifer geeignet ist. Unternehmen und Entwickler müssen sich dieser Realität stellen und jetzt handeln, um die digitalen Räume, in denen KI und Mensch zusammenarbeiten, zu schützen. Nur durch ein Zusammenspiel von technischen Innovationen, verbesserten Berechtigungskonzepten und Bewusstseinsbildung kann eine sichere und verantwortungsbewusste Nutzung von KI-Agenten langfristig gewährleistet werden.