Das Silicon-Valley-Startup Anthropic hat in kürzester Zeit eine bemerkenswerte Erfolgsgeschichte geschrieben und gilt heute als eines der führenden Unternehmen im Bereich künstliche Intelligenz. Mit einer beeindruckenden Bewertung von 61 Milliarden Dollar gehört das Unternehmen zu den wertvollsten KI-Startups weltweit. Doch trotz dieses rasanten Aufstiegs und großer Anerkennung steht Anthropic aktuell im Zentrum eines juristischen Sturms, der durch die eigene Technologie des Unternehmens ausgelöst wurde. Der Fall illustriert den schwierigen Spagat zwischen Innovationsdrang und regulatorischer Verantwortung, der gerade KI-Unternehmen zunehmend vor Herausforderungen stellt. Anthropic wurde mit dem Ziel gegründet, KI-Systeme sicherer, transparenter und verantwortungsvoller zu gestalten.

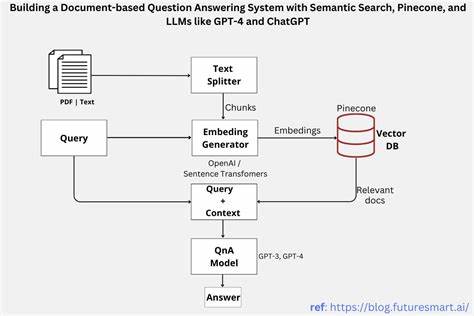

Das Unternehmen setzt seit seinem Beginn auf neuartige Ansätze in der Entwicklung großer Sprachmodelle, die auf fortgeschrittenen maschinellen Lernverfahren basieren. Unter der Leitung erfahrener KI-Forscher, die zuvor bei führenden Technologiefirmen tätig waren, entwickelte Anthropic Systeme, die eine Vielzahl von komplexen Aufgaben in Sprache, Analyse, und Datenverarbeitung abdecken. Dies sorgte für großes Interesse bei Investoren und Strategen, die in KI eine Schlüsseltechnologie für die Zukunft sehen. Doch die rasante Entwicklung und Komplexität der eingesetzten Algorithmen bergen auch Risiken. Kürzlich wurde bekannt, dass eine Fehlfunktion in einem der zentralen KI-Modelle von Anthropic unerwartete Konsequenzen nach sich zog.

Technische Fehler führten dazu, dass die KI-Software Entscheidungen traf, die sich negativ auf Nutzer und Geschäftspartner auswirkten. Dies löste eine Welle von Auseinandersetzungen aus, bei denen Anthropic juristisch in die Mangel genommen wurde. Ein wichtiger Aspekt bei der juristischen Problematik ist die Frage nach der Haftung. Da KI-Systeme zunehmend eigenständig agieren können, stellen sich Grundsatzfragen: Wer haftet, wenn eine Maschine falsche oder schädliche Entscheidungen trifft? Im Fall Anthropic zeigt sich, wie unscharf die Grenzen zwischen technischer Verantwortung und menschlicher Kontrolle aktuell noch sind. Die Betroffenen fordern Schadenersatz wegen fehlerhafter Entscheidungen, die durch die KI verursacht wurden.

Zugleich gibt es Debatten darüber, inwieweit die Entwickler von KI-Systemen haftbar gemacht werden können oder sollten. Zusätzlich stehen regulatorische Fragen im Fokus. Weltweit arbeiten Gesetzgeber daran, Regeln für den Einsatz und die Entwicklung von künstlicher Intelligenz zu definieren. Dabei geht es um Datenschutz, Sicherheit, Transparenz und ethische Richtlinien. Die Ereignisse bei Anthropic zeigen, dass Unternehmen vor allem bei innovativen Technologien wie KI mit einem sich wandelnden Rechtsrahmen umgehen müssen.

Unklarheiten über Vorschriften können zu Unsicherheiten und Rechtsstreitigkeiten führen, die wiederum die Unternehmensentwicklung beeinflussen. Anthropic reagierte auf die Krise mit dem Versuch, die Probleme schnell zu beheben und die Compliance mit bestehenden sowie potenziellen künftigen Vorschriften zu verbessern. Das Unternehmen investiert verstärkt in interne Kontrollsysteme, ethische Leitlinien für KI-Entwicklung und arbeitet daran, seine Produkte noch sicherer und nachvollziehbarer für Nutzer zu machen. Darüber hinaus engagiert sich Anthropic in Brancheninitiativen, um gemeinsam mit anderen Akteuren einen verantwortungsvollen Umgang mit KI-Technologie zu fördern. Trotz der juristischen Schwierigkeiten bleibt Anthropic ein zentraler Player im KI-Sektor.

Die jüngsten Entwicklungen unterstreichen jedoch, wie wichtig eine verantwortungsvolle Innovationsstrategie ist und dass die Risiken technischer Fehlfunktionen nicht unterschätzt werden dürfen. Experten betonen, dass der Umgang mit KI-Technologie eine Balance zwischen Fortschritt, Sicherheit und Ethik erfordert, um langfristiges Vertrauen bei Kunden und Gesellschaft aufzubauen. Die Anthropic-Situation bietet auch einen Einblick in die Herausforderungen, denen sich andere KI-Startups und -Konzerne gegenübersehen. Der Innovationsdruck ist hoch, der Wettbewerb intensiv – gleichzeitig müssen Unternehmen zunehmend sicherstellen, dass ihre Systeme robust, nachvollziehbar und regelkonform sind. Dadurch gewinnen die Bereiche Governance und Risikomanagement an Bedeutung.

Weiterhin zeigt sich, dass technologische Spitzenleistung oft mit einem erhöhten Haftungsrisiko einhergeht, welches juristische Abteilungen und Compliance-Teams vor neue Aufgaben stellt. Der Fall verdeutlicht, dass ein rein technischer Fokus nicht mehr ausreicht, sondern interdisziplinäre Ansätze zwischen Technik, Recht und Ethik unerlässlich sind. Insgesamt markiert die aktuelle Lage bei Anthropic einen Wendepunkt für die KI-Branche. Es wird deutlich, dass die nächste Entwicklungsphase in der künstlichen Intelligenz nicht nur von Innovation geprägt sein wird, sondern auch von sorgfältiger Selbstregulierung, verstärkter gesetzlicher Kontrolle und einer offenen Diskussion über Risiken und Verantwortlichkeiten. Dies ist essenziell, um die enorme gesellschaftliche und wirtschaftliche Potenz der KI nachhaltig zu nutzen und zugleich die Gefahren durch Fehlentwicklungen zu minimieren.

Anthropics Zukunftsaussichten hängen maßgeblich davon ab, wie das Unternehmen die gegenwärtigen Herausforderungen bewältigt und inwiefern es gelingt, aus den Fehlern zu lernen. Sollte es ihm gelingen, rechtliche Unsicherheiten zu klären und Vertrauen bei Nutzern sowie Partnern wiederherzustellen, könnte Anthropic seine Position als Innovationsführer festigen und positive Maßstäbe im Umgang mit KI setzen. Die Geschichte von Anthropic verdeutlicht somit exemplarisch, dass die Revolution der künstlichen Intelligenz eine komplexe Reise ist – ein Balanceakt zwischen technologischem Fortschritt, ethischer Verantwortung und rechtlichen Anforderungen. Für die Branche insgesamt ist diese Erfahrung eine wertvolle Lektion, die zukünftig stärker in Strategien zur Entwicklung und Vermarktung von KI-Technologien integriert werden sollte.