Die steigende Beliebtheit großer Sprachmodelle (LLMs) und Foundation-Modelle hat die Debatte um Zero-Shot- und Few-Shot-Lernen neu entflammt. Zero-Shot-Lernen beschreibt dabei den Prozess, bei dem ein Modell Aufgaben bewältigen soll, ohne zuvor explizit mit spezifischen Trainingsdaten für diese Aufgaben konfrontiert worden zu sein. Dieses Konzept klingt verheißungsvoll: Keine aufwendige Datenaufbereitung, kein langwieriges Training - einfach eine Eingabe und direkt ein als brauchbar empfundenes Ergebnis. Doch hinter diesem vermeintlichen Vorteil verbirgt sich kein kostenloses Mittagessen. Wer sich zu sehr auf Zero-Shot-Methoden verlässt, läuft Gefahr, sowohl Effizienzverluste als auch Qualitätsprobleme in Kauf zu nehmen.

Es ist wichtig, den pragmatischen Blick auf die tatsächlichen Stärken und Grenzen dieser Technik zu behalten. Ein signifikanter Vorteil von Zero-Shot-Techniken liegt in der umfangreichen Weltkenntnis, die Foundation-Modelle durch ihre gigantischen Trainingsdaten erlangen. Ein großer Sprachmodell besitzt ein breites Allgemeinwissen, das es ihm ermöglicht, ohne spezifisches Training auf neue Aufgaben zu reagieren. Dabei entsteht eine Art Defensibilität: Das Modell trifft Annahmen auf Basis allgemeiner Informationen und erreicht so oft eine beachtliche Erfolgsquote, die bei einfachen bis mittelschweren Aufgaben durchaus bei etwa 80 Prozent liegen kann. Dies ist vergleichbar mit einem “Mann von der Straße”, der auch ohne Spezialwissen in vielen alltäglichen Situationen brauchbare Lösungen findet.

Diese Eigenschaft macht Zero-Shot-Ansätze besonders attraktiv für Teams, die schnell erste Ergebnisse sehen möchten, ohne viel Aufwand in Trainingsdatengenerierung oder Modelltraining zu investieren. Dieser schnelle Start mit Zero-Shot-Methoden verführt viele dazu, das klassische Machine Learning und die damit verbundenen fundierten Evaluationsprozesse zu überspringen. Es entsteht das Gefühl, dass man durch lediglich überschaubare Anpassungen der Prompts sehr weit kommen kann. Doch gerade hier lauern die Herausforderungen: Das Modell besitzt zwar beeindruckendes Weltwissen, doch es versteht die Feinheiten spezieller Domänen womöglich nicht ausreichend. Ein Beispiel verdeutlicht das: In einem Möbeldatensatz erkannte selbst GPT-4 nicht, dass ein Bistro-Tisch typischerweise im Außenbereich steht, was mit der Bedeutung von „Bistro“ als Lokal wenig zu tun hat.

Solche Fehlinterpretationen zeigen schnell, dass Zero-Shot ohne Domänenanpassung durchaus an Grenzen stößt. Eine häufige Reaktion darauf ist, die Prompts immer weiter zu verfeinern und Beispiele hinzuzufügen – das sogenannte Few-Shot-Lernen. Dabei wird jedoch schnell klar, dass diese Lösung nicht ohne Kompromisse ist. Je komplexer und detaillierter die Prompts werden, desto anfälliger werden die Systeme für Fehler und Inkonsistenzen. Diese Prompts werden „brittle“ – das heißt, schon kleine Änderungen führen zu unerwarteten Antworten.

Der Aufwand, alle denkbaren Ausnahmen und Sonderfälle abzudecken, erinnert dabei an ein Spiel von „Whack-a-Mole“. Jede zusätzliche Feinjustierung beseitigt einen Fehler, öffnet aber möglicherweise neue Problemfelder. Zudem wächst zwangsläufig die Anzahl der Testfälle, die benötigt werden, um das Modell zuverlässig abzusichern. Aus der Praxis vieler Teams zeigt sich, dass die Entwicklung robuster Evaluationssets mit der Zeit unausweichlich wird. Sobald diese basierend auf realen Testfällen entstehen, stellt sich die Frage, warum man diese Daten nicht direkt für traditionelles Training nutzt.

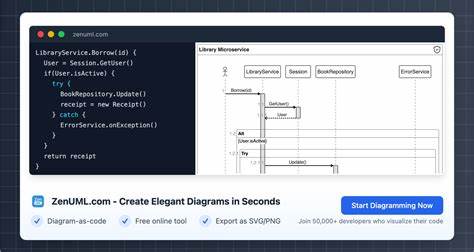

Es gewinnt an Relevanz, das Modell systematisch zu trainieren, zu validieren und mit Methoden wie Cross-Validation eine statistische Aussagekraft über die Leistung zu erzielen. Dies sind zentrale Säulen der klassischen Machine-Learning-Praxis, die Zero-Shot-Prompts oft umgehen wollen, aber letztlich nicht ersetzen können. Modellarchitektur, Feature-Auswahl und ein strukturierter Evaluierungsansatz bleiben entscheidend, um komplexe Aufgaben zuverlässig lösen zu können. Langfristig kann ein hybrider Ansatz sinnvoll sein, bei dem Zero-Shot-Techniken LLMs eher als Werkzeug zur Merkmalsgenerierung dienen, die dann in einem klassischen Machine-Learning-Modell weiterverarbeitet werden. Solche Features können beispielsweise Wahrscheinlichkeiten bestimmter Themenkategorien sein oder das Ergebnis einfacher Ja/Nein-Fragen zu einem Textabschnitt.

Der Vorteil ist, dass diese kleineren, spezifischeren Aufgaben oft mit weniger Prompts gearbeitet werden kann, die zudem weniger anfällig für ungewollte Ablenkungen im Modelloutput sind. Ein weiterer Pluspunkt dieses Feature-basierten Vorgehens besteht darin, dass die erzeugten Merkmale standardisiert evaluiert und mit anderen, externen Features kombiniert werden können. So lässt sich eine größere Flexibilität und Robustheit erreichen. Im Gegensatz zu einem komplexen Einzelprompt, bei dem jede Antwort in einer freien Textform erfolgen kann, ermöglicht dieser Ansatz eine klare Bewertung der einzelnen Komponenten, was sich positiv auf die Nachvollziehbarkeit und Wartbarkeit auswirkt. Darüber hinaus bieten Embeddings, also Vektor-Darstellungen von Text, Bildern oder anderen Entitäten, eine weitere Möglichkeit, LLMs effektiv als Feature-Generator zu nutzen.

Die so gewonnenen Merkmalsraume können als Input für verschiedenste Modelle dienen und eröffnen interessante Hybridansätze zwischen klassischem Machine Learning und modernen Foundation-Modellen. Besonders in Such- und Informationsretrieval-Anwendungen zeigt sich dieses Vorgehen inzwischen als sehr effektiv. Die Entwicklung der KI, speziell im Bereich der natürlichen Sprachverarbeitung, sollte sich daher nicht allein auf das Verfeinern von Prompting-Strategien konzentrieren. Zwar hat das Prompting durchaus seine Berechtigung in spezifischen Szenarien und kann schnelle Prototypen ermöglichen, aber langfristige und robuste Lösungen setzen auf eine Kombination aus fundiertem Training, sorgfältiger Evaluation und Hybriden von Deep Learning mit klassischen Techniken. Die Aufforderung, die Grundlagen des Machine Learnings nicht zu vernachlässigen, ist entscheidend, um die Vorteile von Foundation Modellen sinnvoll zu nutzen.