In der Welt der Softwareentwicklung gelten Unit Tests oft als der heilige Gral der Qualitätssicherung. Sie sind schnell, effizient und erlauben Entwicklern, einzelne Funktionen isoliert zu überprüfen. Doch was passiert, wenn ein Großteil der Anwendung aus Datenbankabfragen und -operationen besteht? Sind Unit Tests dann noch das geeignete Mittel, um sicherzustellen, dass die Software wie gewünscht funktioniert? Die Antwort darauf ist komplex und verdient eine differenzierte Betrachtung, insbesondere für datenbankintensive Webanwendungen, die einen wesentlichen Teil der Unternehmenslogik abbilden. Viele moderne Webanwendungen sind zu einem großen Teil von der Datenbank geprägt. Stellen Sie sich eine Anwendung vor, die bis zu 80 Prozent aus Datenbanklogik besteht – sei es durch SQL-Statements, ORM-Operationen oder MongoDB-Abfragen.

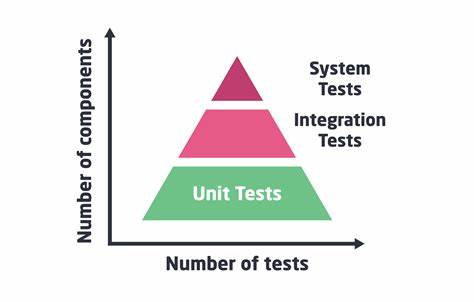

Die übliche Empfehlung in solchen Szenarien lautet oft: Schreibe Unit Tests unter der Prämisse, dass diese möglichst die Datenbank nicht berühren sollten, da Integrationstests mit Datenbankkontakt als zu langsam gelten. Das wirkt auf den ersten Blick einleuchtend, führt aber in der Praxis oft zu absurden Situationen, in denen mehr als die Hälfte der Testabdeckung jeglichen realistischen Bezug zur tatsächlichen Anwendung verliert. Denn was ist ein Unit Test wert, wenn er nicht das Herzstück – die Datenbankinteraktionen – berührt? Unit Tests zeichnen sich dadurch aus, dass sie einzelne Komponenten isoliert prüfen. Sie sind ideal für kleine Abschnitte wie Utility-Funktionen, Parsing von HTTP-Bodies oder die Verarbeitung einfacher Daten, bei denen der Zustand klar definiert ist. In diesen Fällen sind Unit Tests enorm wertvoll: Sie liefern schnelles Feedback, sind ressourcenschonend und helfen dabei, den Code sauber und verständlich zu halten.

Entwickelnde können so sicherstellen, dass ihre Funktionen das tun, was sie sollen – und nur das. Allerdings endet dieser Vorteil schnell, wenn es darum geht, komplexe Datenbankoperationen zu prüfen. Datenbanken sind komplexe Systeme mit eigenen Regeln, Transaktionen, Sperren und Zuständen. Das Verhalten einer SQL-Abfrage oder einer ORM-Operation kann sich aufgrund von Datenabhängigkeiten, Indizes, Likes, Joins oder Triggern unterscheiden. Ein Unit Test, der „nur“ den generierten SQL-String prüft oder die ORM-Methoden mit Mocking simuliert, deckt nicht das tatsächliche Verhalten in der realen Welt ab.

Solche Tests sind oft wenig aussagekräftig und können ein trügerisches Sicherheitsgefühl vermitteln. Es ist vergleichbar mit dem Testen eines Additionsprogramms, bei dem die Funktion lediglich den Quellcode des Addierers auf Übereinstimmung mit einer Zeichenkette prüft statt das Ergebnis zu evaluieren. Das hat wenig mit realem Testen zu tun. Integrationstests hingegen nehmen die Anwendung in einem realitätsnäheren Kontext unter die Lupe. Sie prüfen, ob einzelne Komponenten zusammenspielen – insbesondere die oft kritischen Datenbankschichten.

Der Nachteil dieser Tests liegt unbestritten in ihrer Geschwindigkeit. Datenbankzugriffe sind naturgemäß langsamer und das Bereitstellen eines konsistenten Test-Datenstandes für jeden einzelnen Test ist aufwendig. Technologien wie TestContainers, In-Memory-Datenbanken oder das Zurücksetzen der Datenbanken mittels Snapshots helfen zwar, dieses Problem zu mildern, können es aber nicht vollständig lösen. Selbst wenn die Wiederherstellung der Datenbank innerhalb einer Sekunde gelingt, sind die Tests wesentlich langsamer als klassisches Unit Testing und limitieren daher die Anzahl und Frequenz der Testläufe. Aus diesem Dilemma heraus entsteht die paradoxe Situation, dass Entwickler entweder auf langsame Integrationstests setzen müssen oder Unit Tests schreiben, die reale Fehler in der Datenbanklogik übersehen.

Die Konsequenz sind oft weniger stabile Releases, da Fehler in komplexen Datenbankoperationen erst spät oder im schlimmsten Fall in der Produktion entdeckt werden. Der dringende Wunsch vieler Entwickler ist also ein Testparadigma, das die Geschwindigkeit von Unit Tests mit der realitätsgetreuen Abdeckung von Integrationstests vereint – im Idealfall bei starker Isolation, sodass Tests keine Seiteneffekte verursachen. Der Diskurs um „Unit Tests sind keine echten Tests“ fordert uns dazu heraus, unsere Teststrategien neu zu durchdenken. Es geht nicht darum, Unit Tests grundsätzlich zu verteufeln, sondern realistisch einzuschätzen, wo sie ihre Grenzen haben. Sie sind großartig für kleine, isolierte Funktionseinheiten und verbessern den Entwicklungsfluss erheblich.

Für Anwendungen, deren Businesslogik überwiegend in der Datenbank stattfindet, müssen jedoch andere Ansätze her. Eine Möglichkeit besteht darin, die Anwendung so zu gestalten, dass die kritischen Datenbankoperationen klar abgegrenzt und so minimal wie möglich gehalten werden. Eine entkoppelte Architektur, bei der nur einige wenige Komponenten direkte DB-Interaktionen durchführen, kann Integrationstests überschaubar und damit performanter machen. Weiterhin kann das Testen durch Mocking allein nicht ersetzt werden, es sollte ein abgestimmter Mix aus Unit- und Integrationstests implementiert werden. Dabei helfen praxisorientierte Testdatenmanagement-Strategien und Werkzeuge, die es erlauben, Testdaten schnell bereitzustellen und wieder zu säubern.

Darüber hinaus kann die Nutzung von modernen Technologien wie Containerisierung (beispielsweise mittels Docker-Containern) eine Rolle spielen, um isolierte und reproduzierbare Testumgebungen aufzubauen. Auch die Implementierung von sogenannten Contract Tests, die sicherstellen, dass die Schnittstellen zwischen der Anwendung und der Datenbank korrekt und stabil bleiben, bietet einen zusätzlichen Schutzmechanismus. Abschließend lässt sich sagen, dass die Testlandschaft für datenbankintensive Webanwendungen eine Herausforderung bleibt. Die Forderung nach 50-90 Prozent Unit Tests, die keine Verbindung zur Datenbank haben, entbehrt vor allem in solchen Kontexten der praktischen Relevanz. Einheitliche Rezepte funktionieren hier nicht.

Vielmehr ist ein differenzierter, auf das Anwendungsprofil zugeschnittener Testmix notwendig, der sowohl Geschwindigkeit als auch Realitätsnähe vereint. Es gilt, das Niveau des Testens für datenbanklastige Anwendungen weiterzuentwickeln: Schnell, isoliert und dennoch realitätsnah. Nur so gelingt es, die Qualität von Softwareprodukten zu erhöhen, die Produktivität der Entwickler zu steigern und gleichzeitig die Betriebssicherheit zu gewährleisten. Die Diskussion über die Grenzen und Möglichkeiten von Unit Tests ist somit wichtiger denn je – und ein Anstoß für die Community, innovative und pragmatische Lösungen zu finden.